このスライドは 2017 年 1 月 17 日 (火)、ベルサール高田馬場で開催された「NVIDIA Deep Learning Institute 2017」の最初のセッション、「これから始める人の為のディープラーニング基礎講座」にて、エヌビディア合同会社 ディープラーニング部 村上 真奈が講演しました。

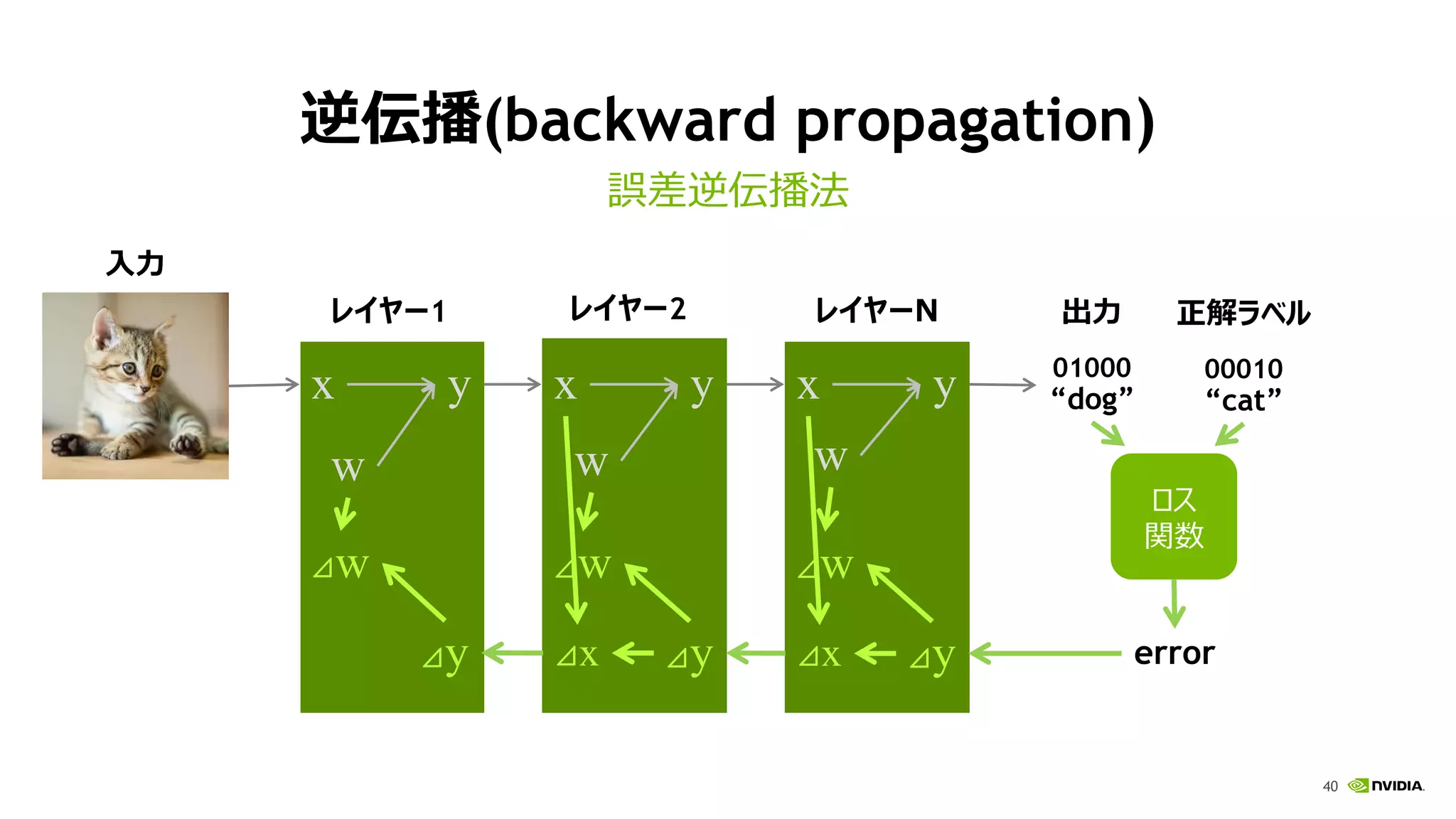

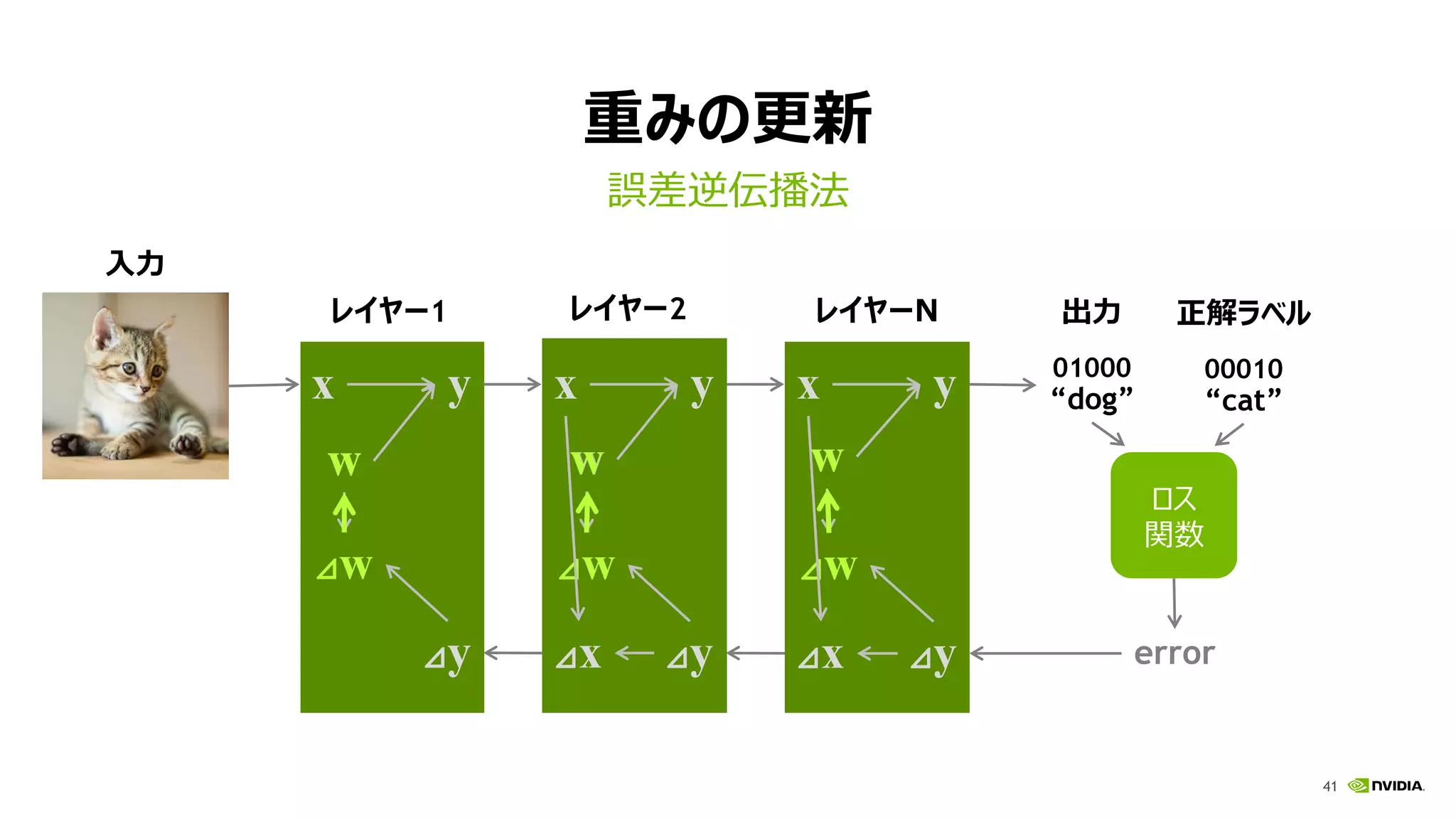

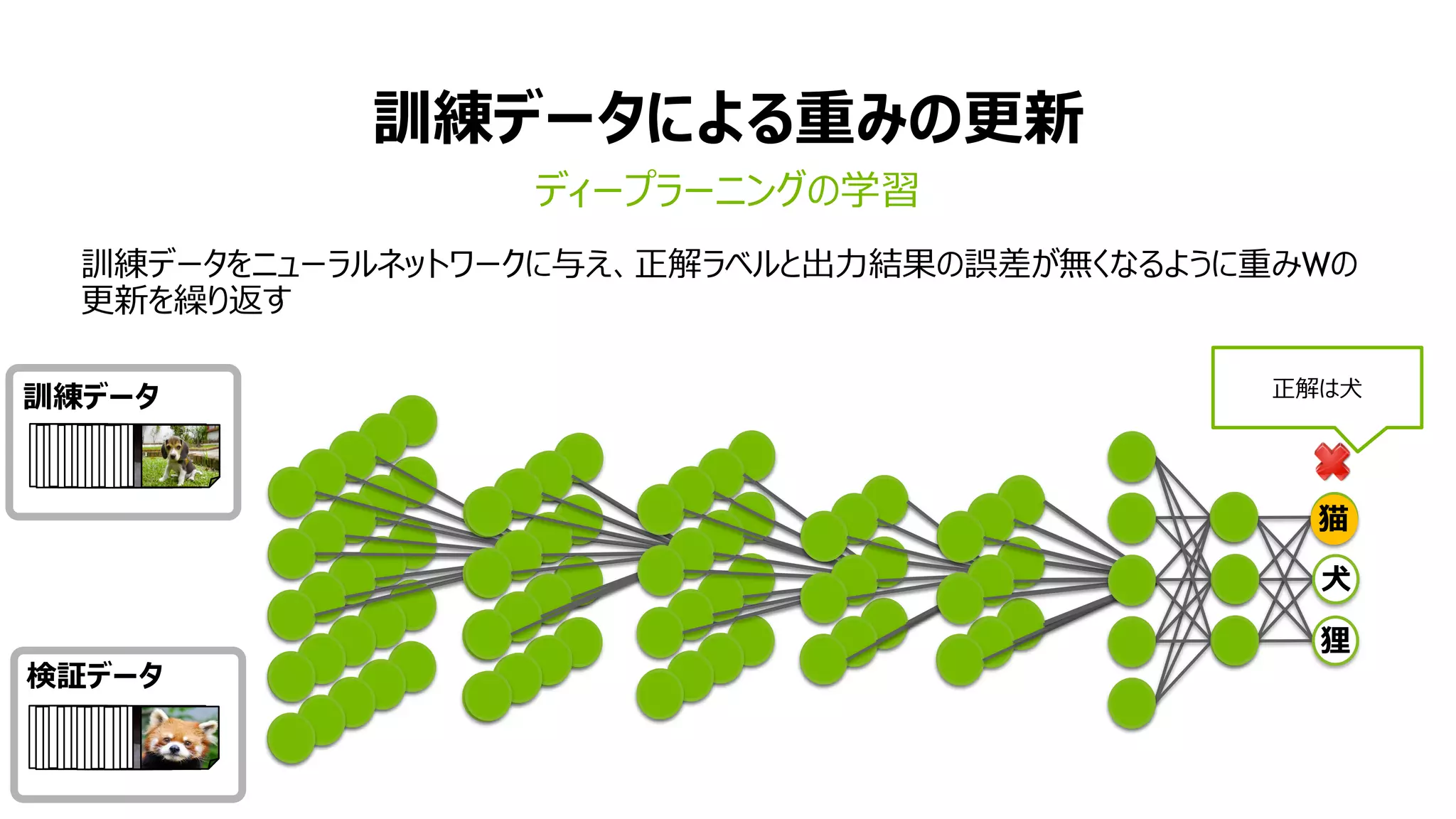

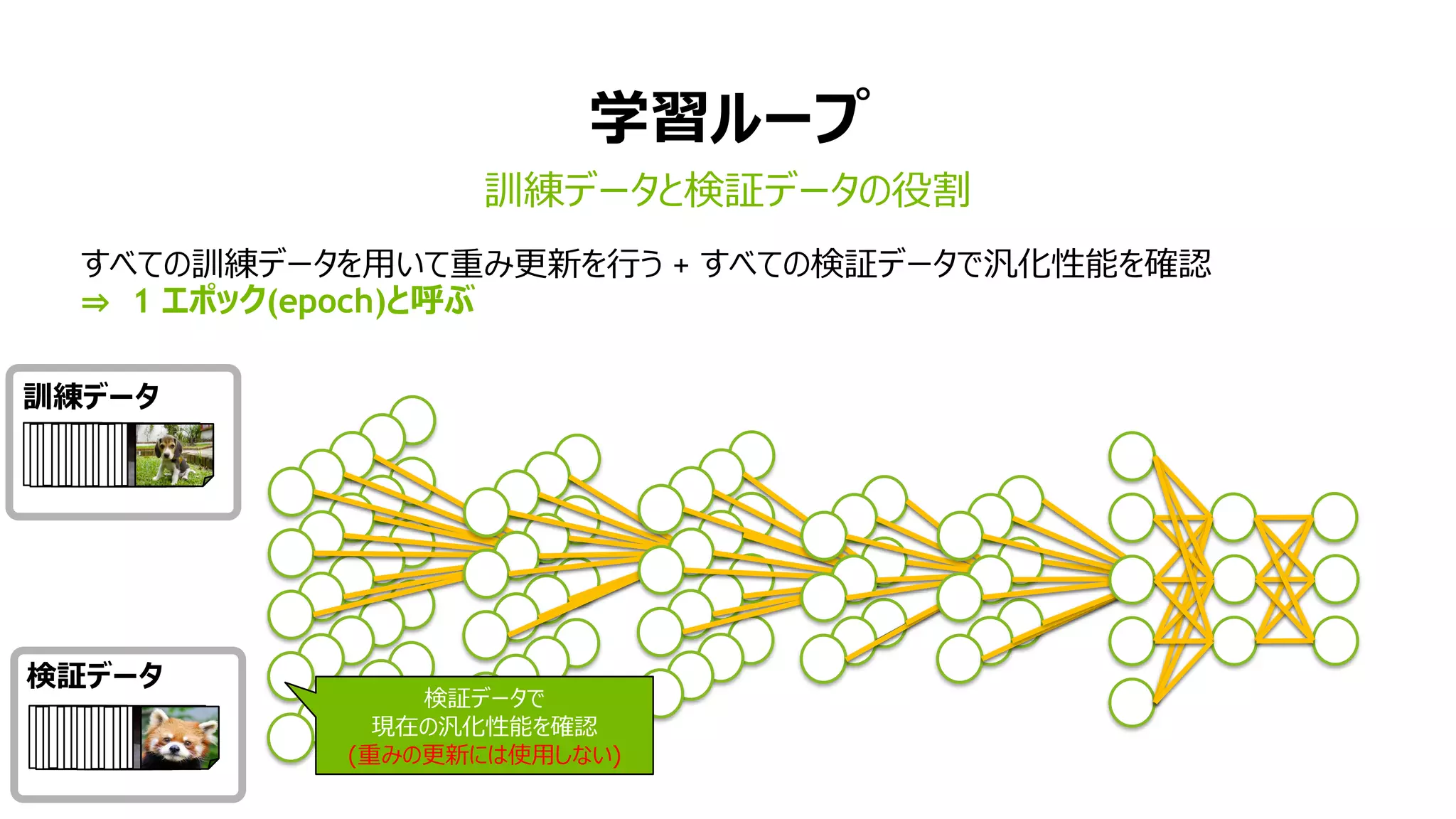

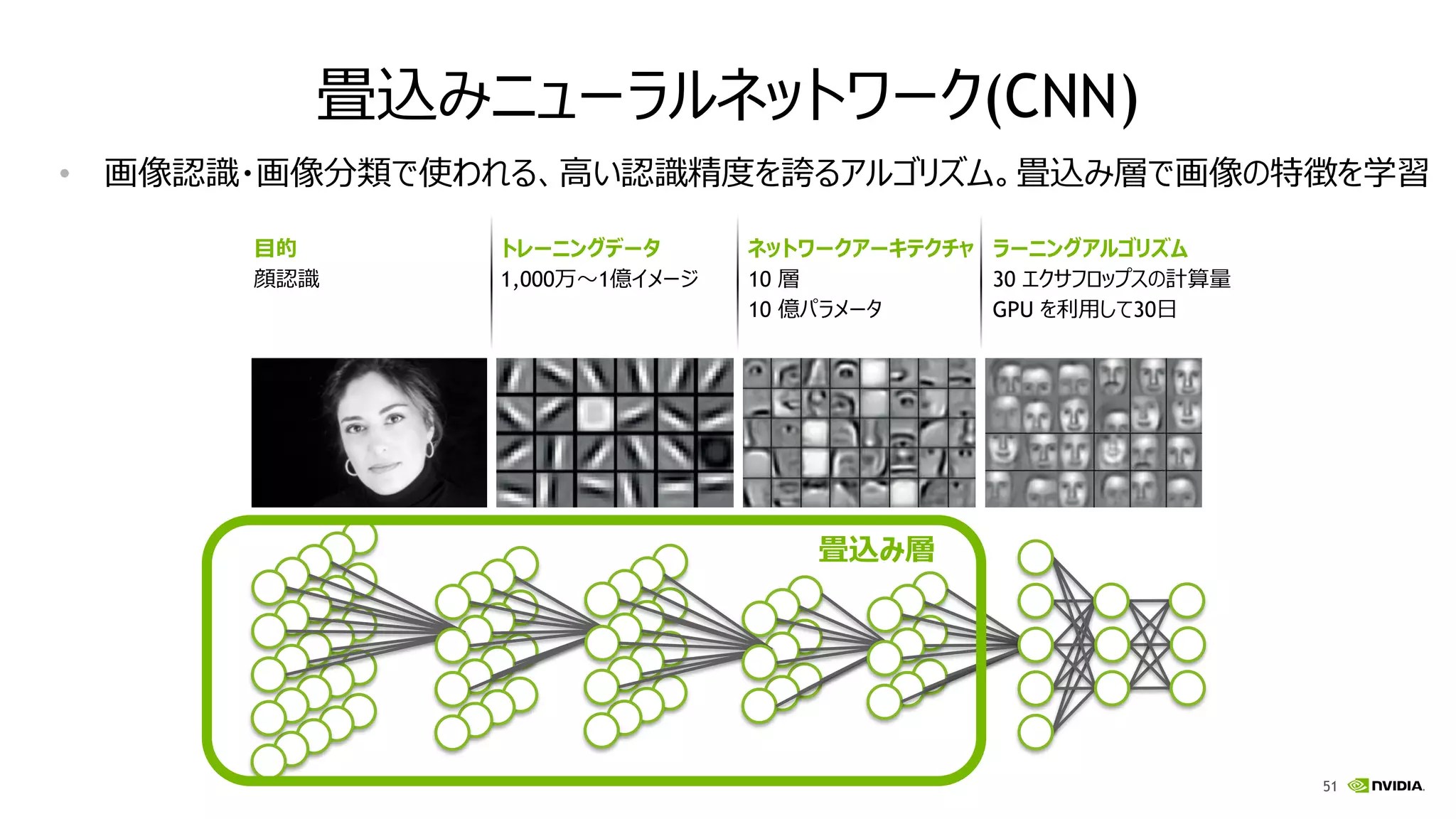

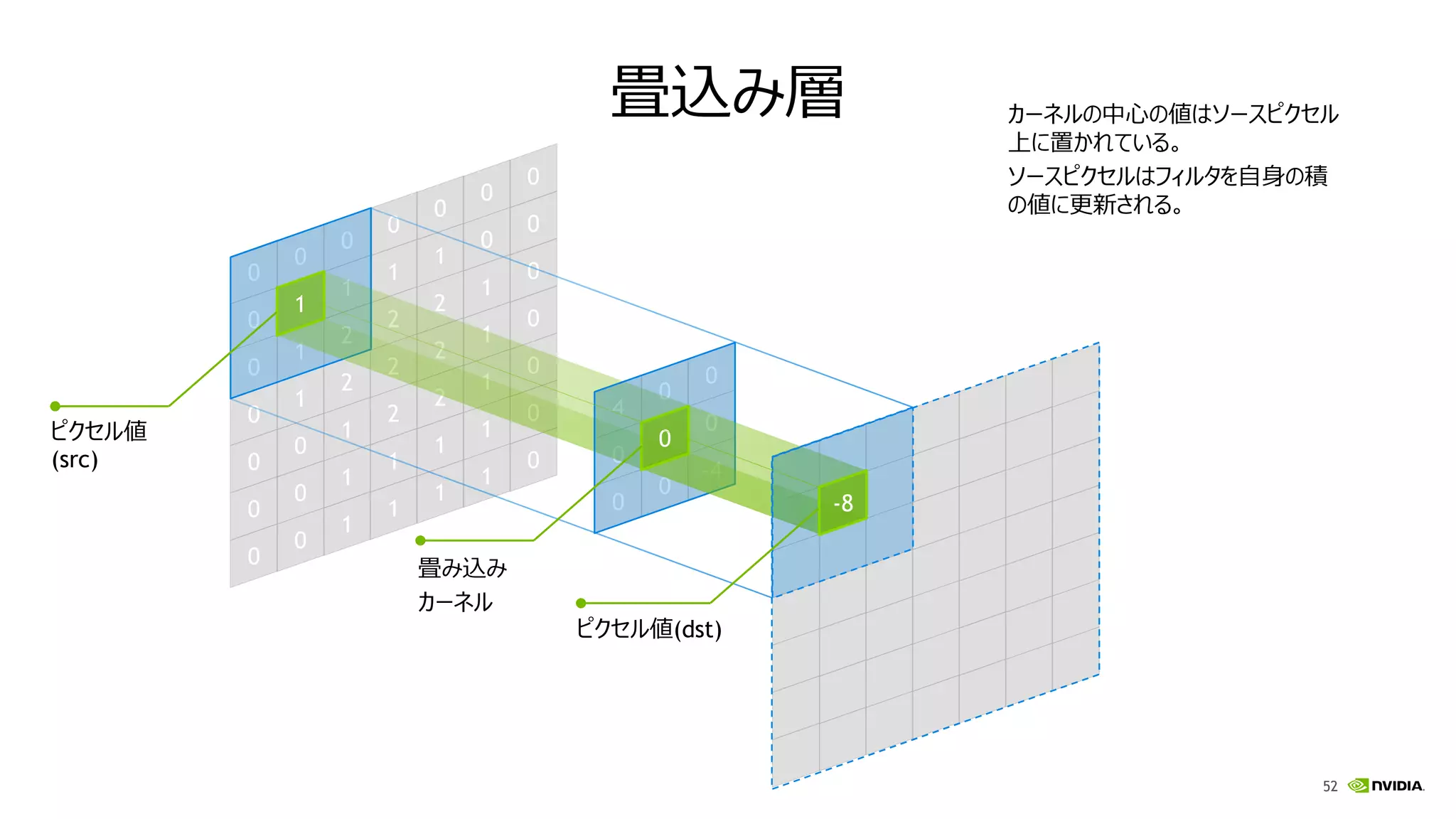

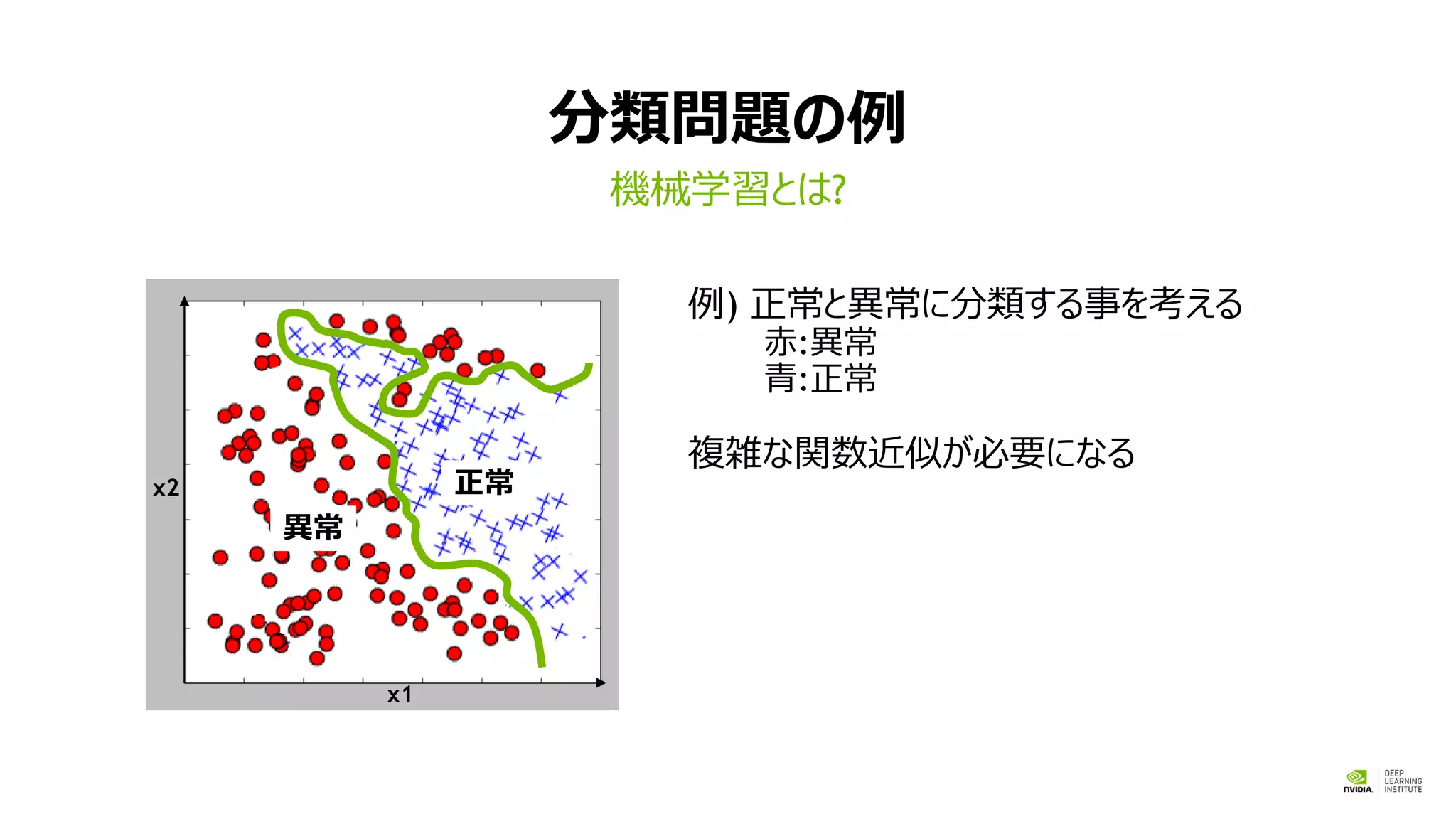

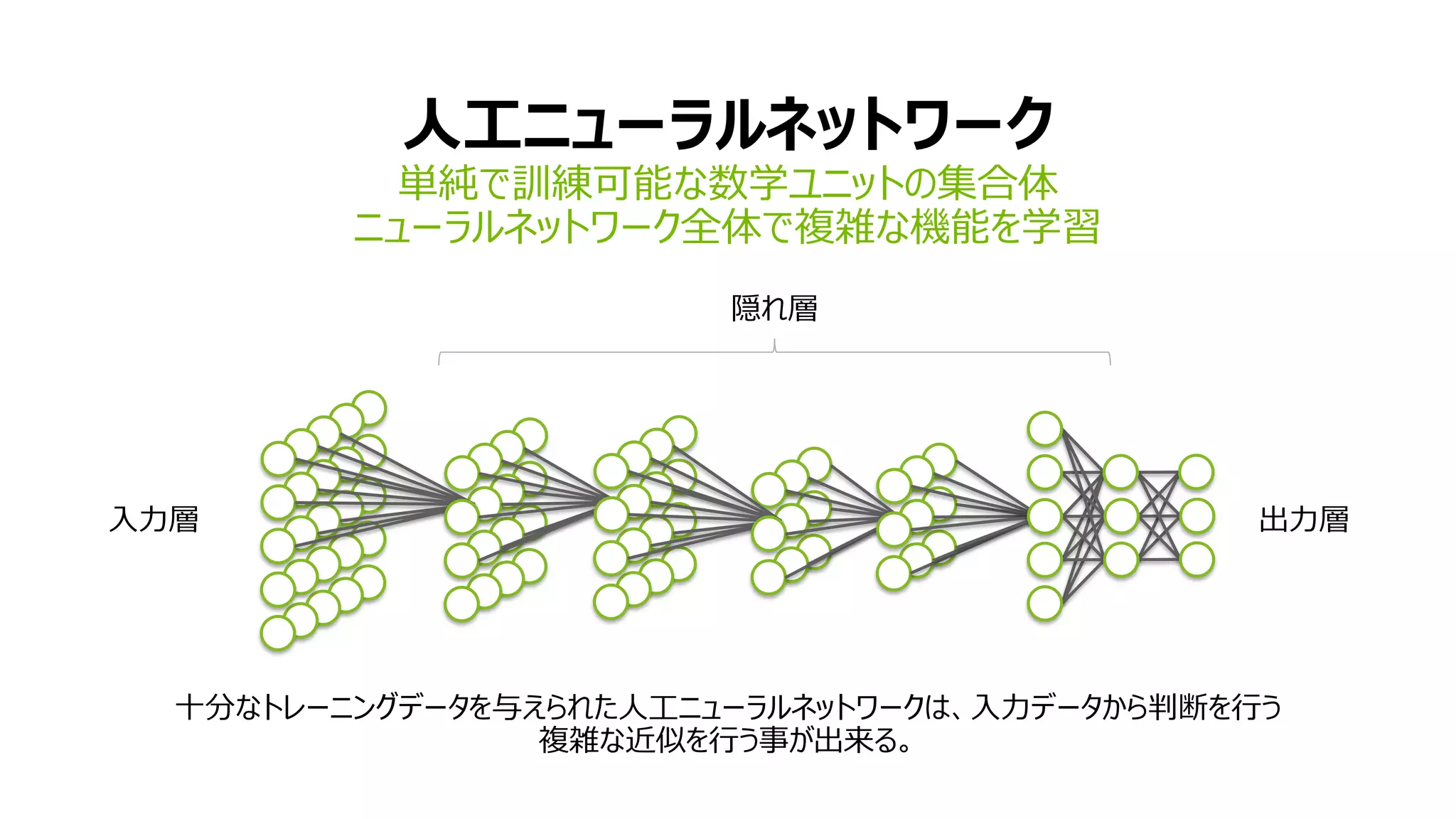

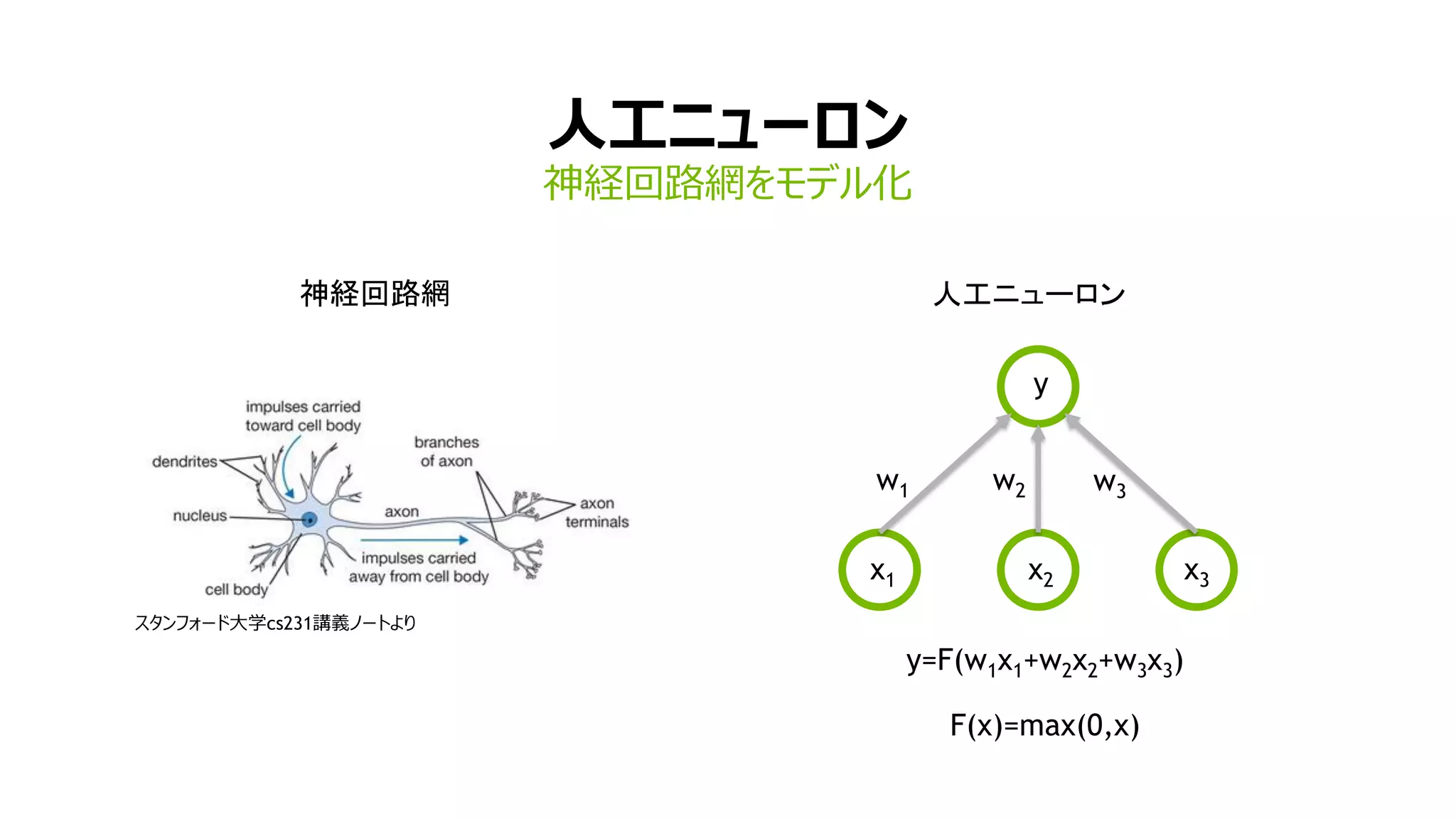

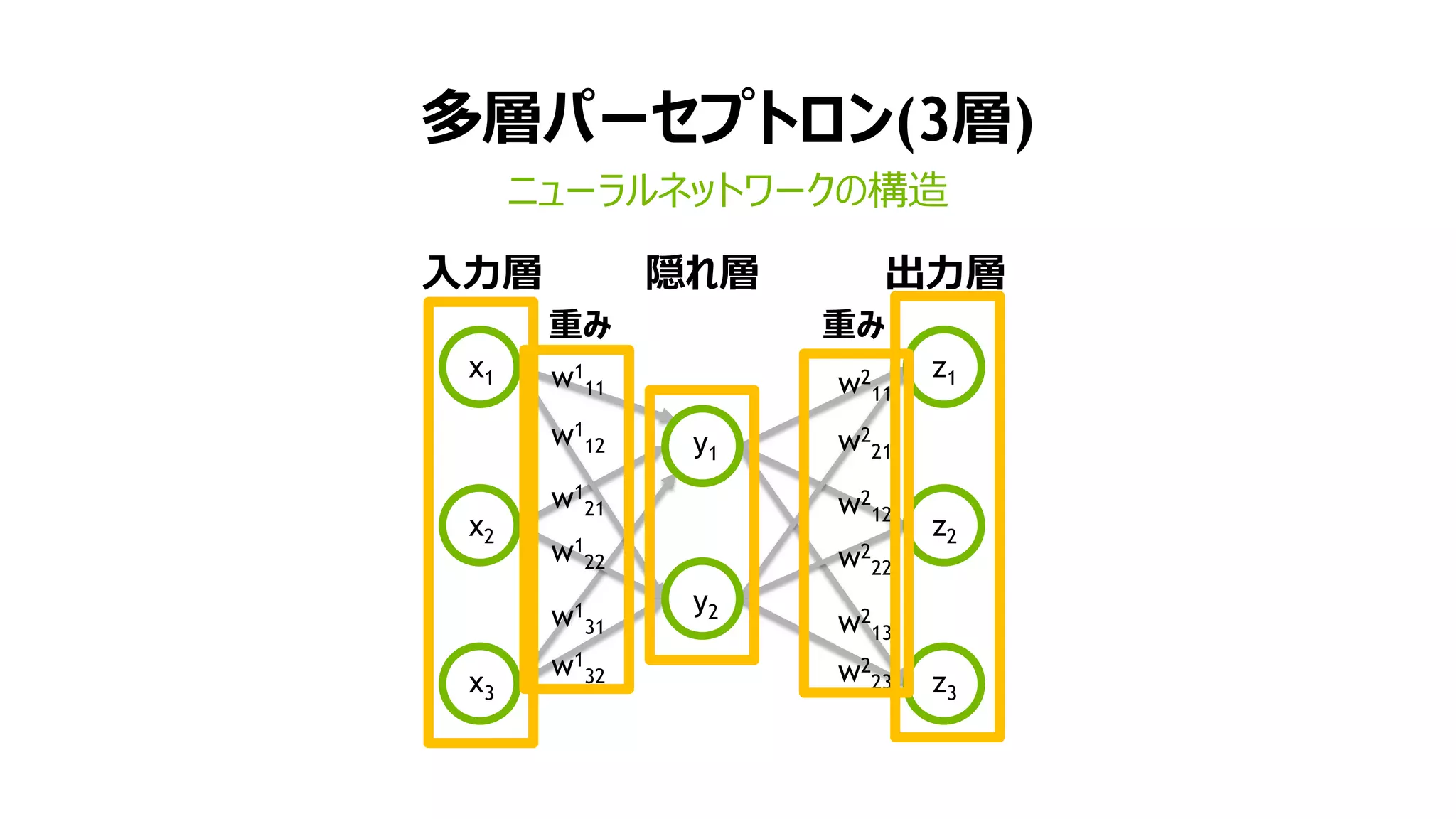

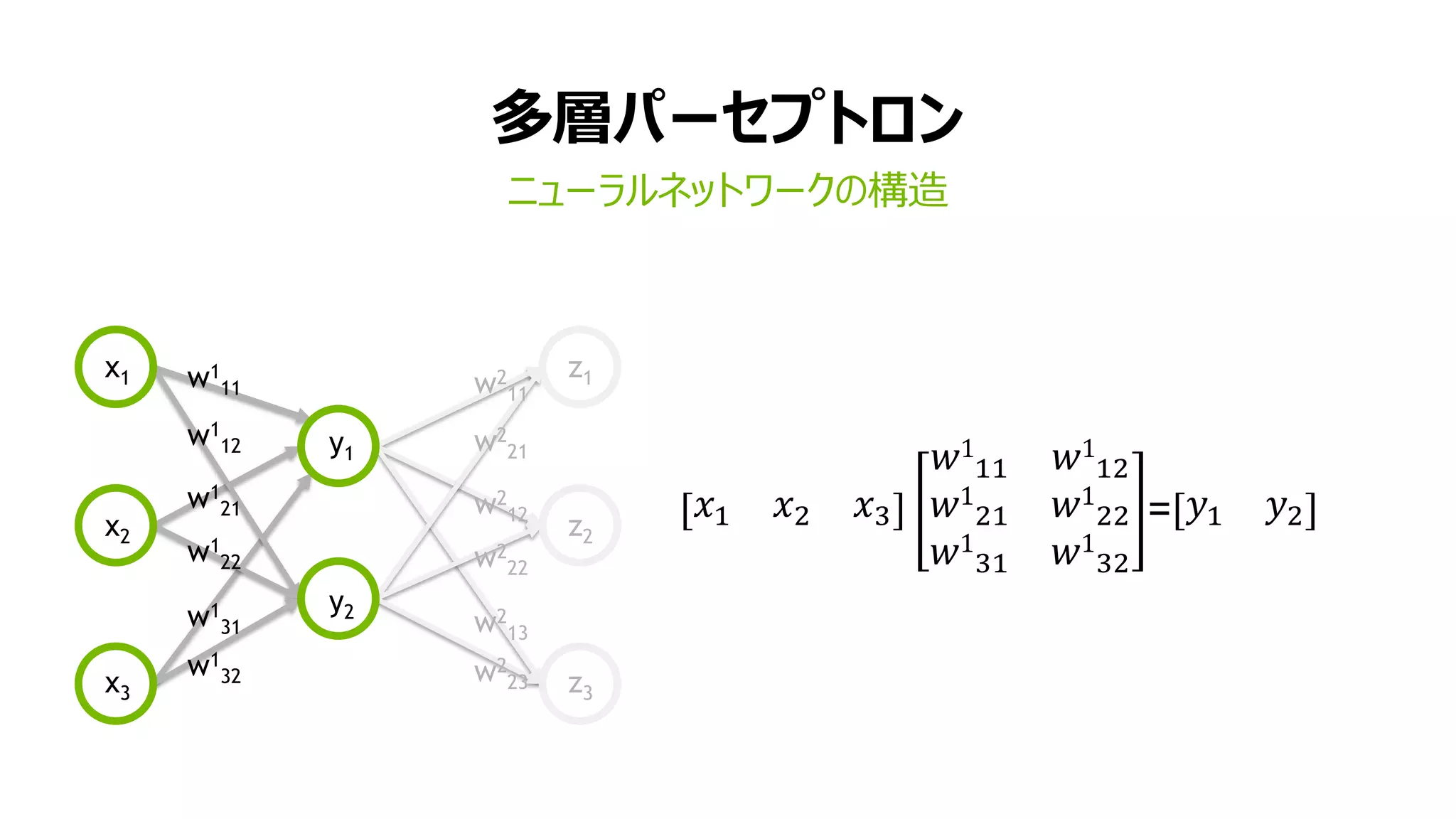

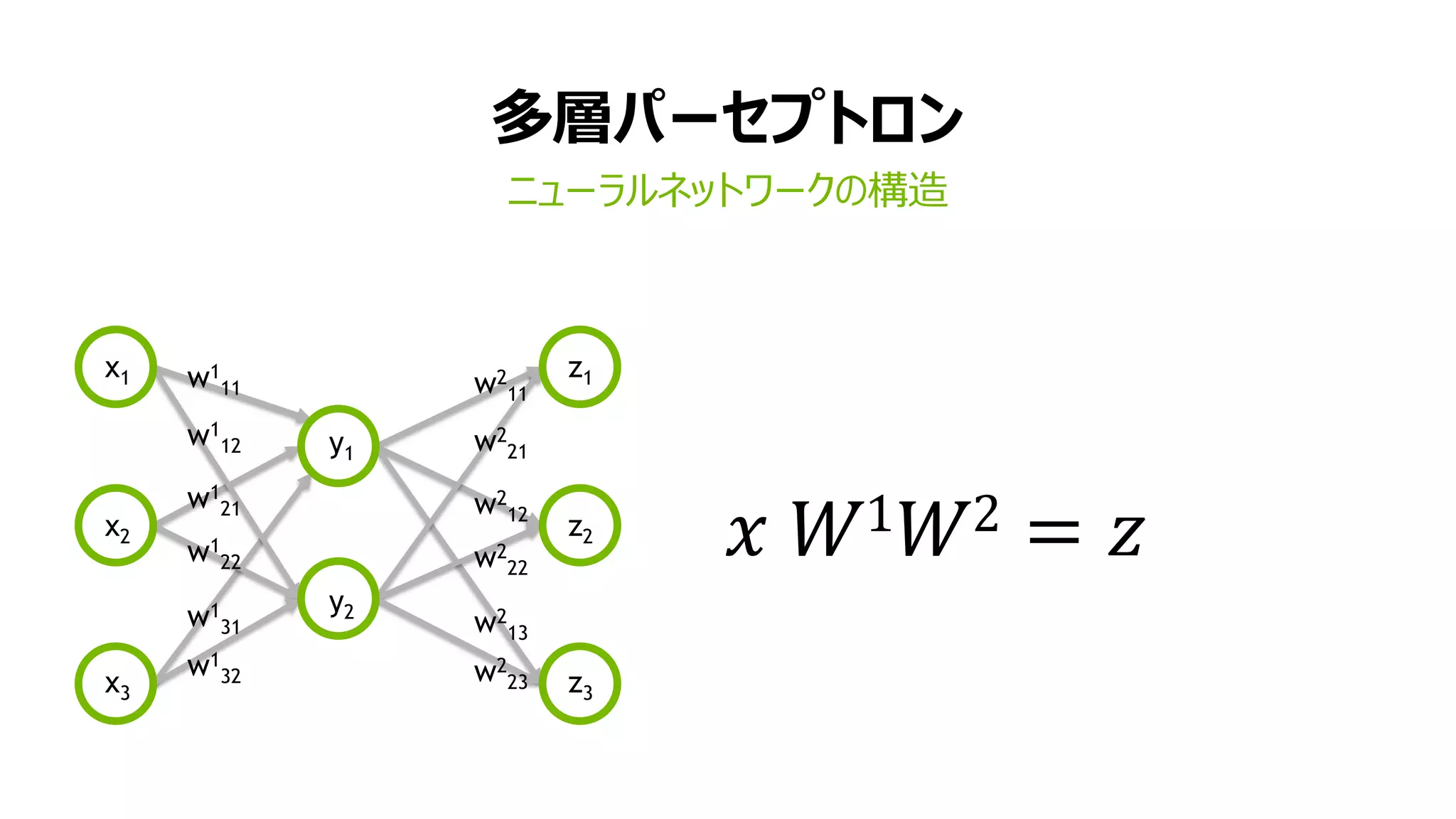

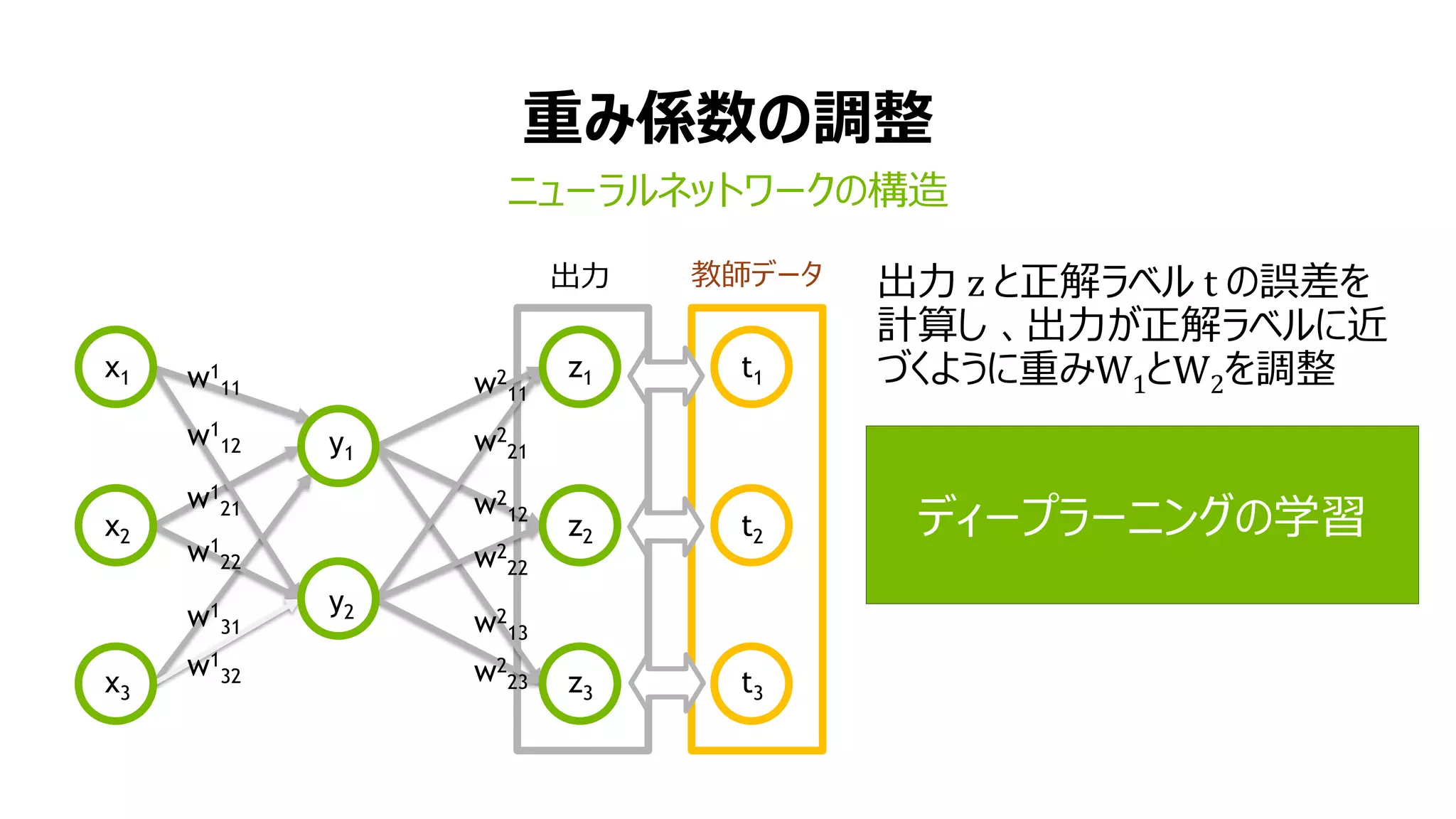

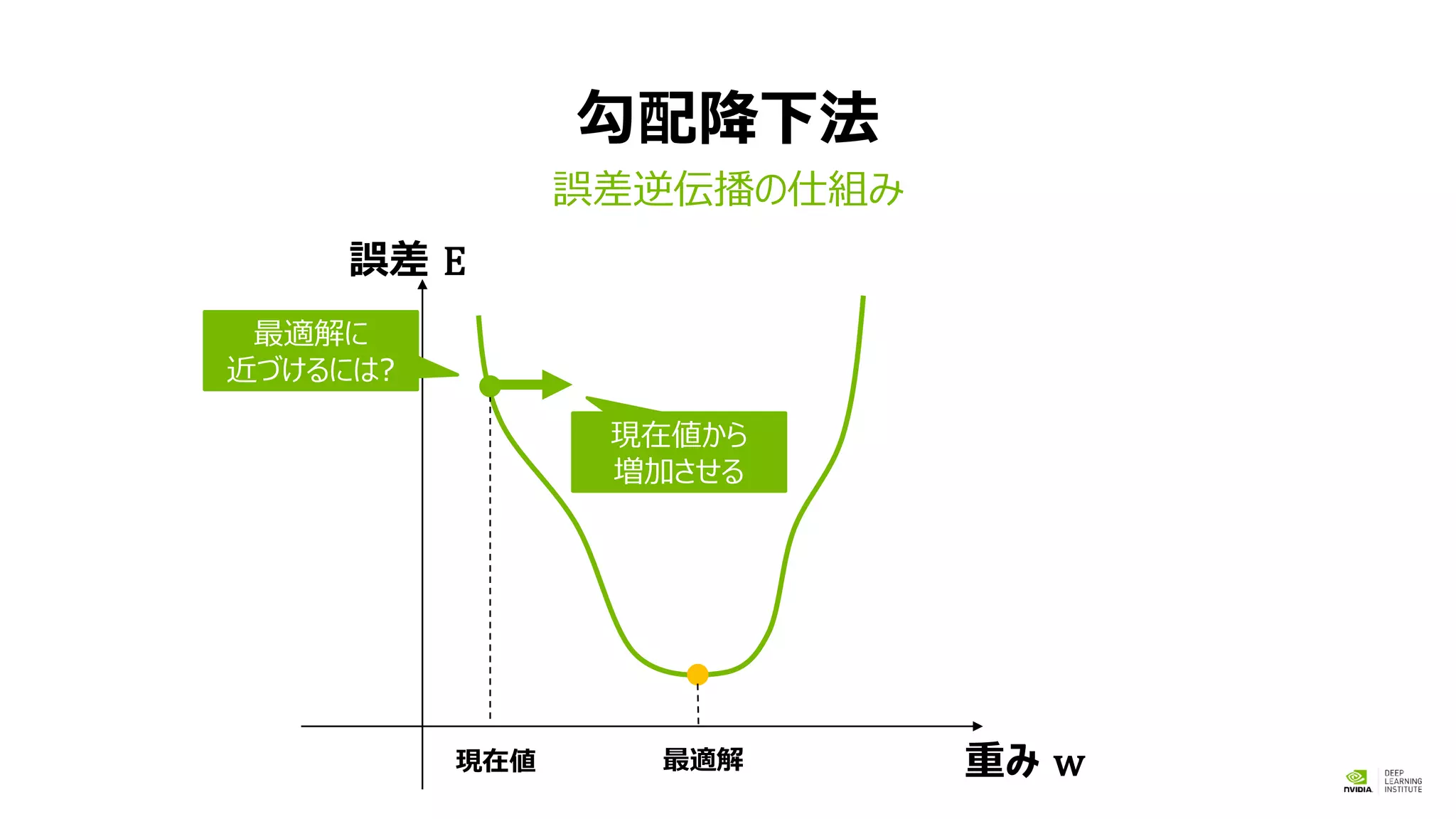

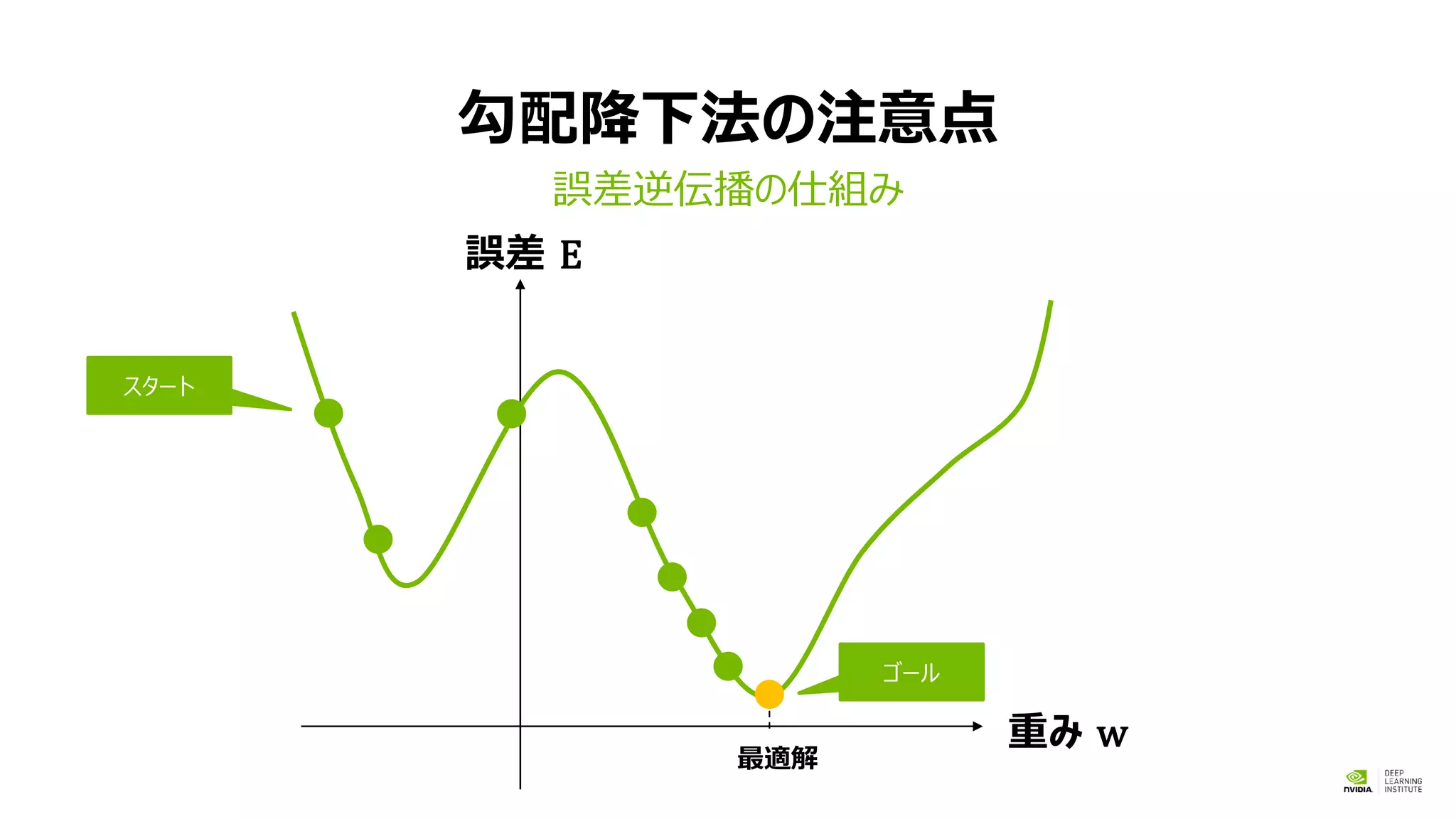

このセッションでは、ディープラーニングをこれから始める方を対象に、必要な基本知識について説明します。ディープラーニングではニューラル ネットワークに大量のデータを学習させる事で画像認識や物体検出など様々な認識を行う事が可能です。セッション前半は、画像認識問題で使われる畳み込みニューラル ネットワーク (CNN) を理解する為の基礎概念について説明します。ニューラル ネットワークの基本となる多層パーセプトロン、誤差逆伝播法、確率的勾配降下法やミニバッチ学習などディープラーニングの学習過程を理解するで必要な数学的な基礎概念を解説します。

当該イベントにて、午後に開催されるハンズオンで用いられる基礎的な概念を、参加者の皆様に前もってご理解いただき、ハンズオンをより有意義に受講いただくためのセッションとなります。

![39

w

x y

w

x y

w

x y

レイヤー1

01000

“dog”

レイヤー2

入力

出力レイヤーN

ロス

関数

00010

“cat”

正解ラベル

x[N] y[M]

w[N][M]

順伝播(forward propagation)

誤差逆伝播法](https://image.slidesharecdn.com/01introductiontodlv06-170116032903/75/slide-35-2048.jpg)