公開URL:https://arxiv.org/pdf/2404.19174

出典:Guilherme Potje, Felipe Cadar, Andre Araujo, Renato Martins, Erickson R. ascimento: XFeat: Accelerated Features for Lightweight Image Matching, Proceedings of the 2024 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) (2023)

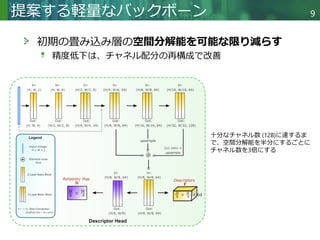

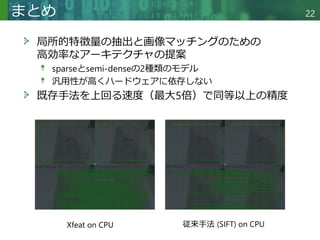

概要:リソース効率に優れた特徴点マッチングのための軽量なアーキテクチャ「XFeat(Accelerated Features)」を提案します。手法は、局所的な特徴点の検出、抽出、マッチングのための畳み込みニューラルネットワークの基本的な設計を再検討します。特に、リソースが限られたデバイス向けに迅速かつ堅牢なアルゴリズムが必要とされるため、解像度を可能な限り高く保ちながら、ネットワークのチャネル数を制限します。さらに、スパース下でのマッチングを選択できる設計となっており、ナビゲーションやARなどのアプリケーションに適しています。XFeatは、高速かつ同等以上の精度を実現し、一般的なラップトップのCPU上でリアルタイムで動作します。

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

背景 5

ローカルな画像特徴抽出とマッチング

Local Feature Matching (LFM)

ハイレベルなvision taskの一種

画像特徴量抽出は多くのタスクで重要

SLAM[1], 3Dモデルの自動生成[2], 画像のマッチング

最近の進歩にも関わらず、

改善のほとんどが高い計算量と複雑な実装

[1]の地図生成結果 [2]の3Dモデルの生成結果](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-5-320.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

関連研究 6

画像のマッチング

キーポイント検出, CNNまで多岐にわたる

最先端手法はtransformerを使用したモデル

ロバスト性と正確性の改善がメイン

特徴記述子 (feature descriptors)と画像のマッ

チング

SuperPoint[3]

自己教師ありCNN

ZippyPoint[4]

量子化と二値化を組み込んだCNN

※ 特徴量記述子 = どのように特徴を表現するか(=特徴抽出)](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-6-320.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

バックボーンの軽量化の歴史 8

処理コスト削減する方法: VGG16

概要

空間次元(𝐻𝑖,𝑗, 𝑊𝑖,𝑗)を徐々に半分にしながら、

畳み込み層のチャネル数(𝐶𝑖)を2倍にする

計算量

𝐹𝑜𝑝𝑠 = 𝐻𝑖 ∙ 𝑊𝑖 ∙ 𝐶𝑖 ∙ 𝐶𝑖+1 ∙ 𝑘2

最大で1/9まで計算量を削減

高解像度を扱う場合は効果が少ない

𝐻𝑖 ∙ 𝑊𝑖 がボトルネック

Super-Point[3]とALIKE[5]の登場](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-8-320.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

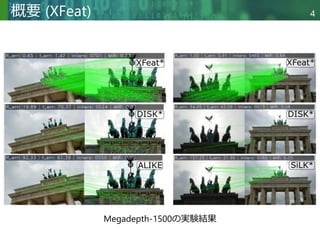

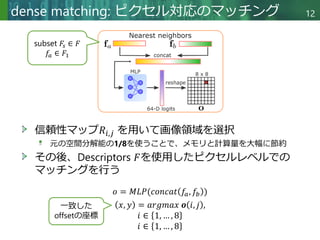

Local feature extraction 10

Multi scaleな特徴量をマージすることで

特徴マップ𝐹 ∈ ℝ

𝐻

8

×

𝑊

8

×64

を抽出

Feature Pyramid Networks[6]により、ネットワーク受容野が

増加

𝐹𝑖,𝑗が確信を持ってマッチングできる確率のマップ

𝑅 ∈ ℝ

𝐻

8×

𝑊

8 ×64](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-10-320.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

keypoint head 11

処理方法はSuperPoint[3]と同様

1/8になった最終エンコーダの特徴量を使用

平坦化した8x8グリッド内のキーポイントを分類

SuperPointと異なる点

Keypointの検出専用に並列ブランチを使用](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-11-320.jpg)

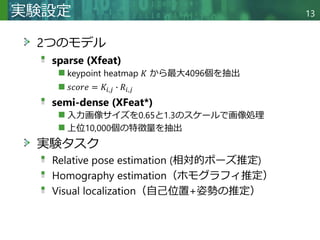

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

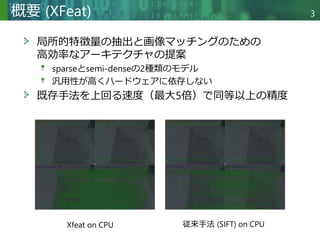

Relative pose estimation 14

データセットの特徴

視点と照明が同時に大きく変化

定性評価の結果

既存手法よりも検出とマッチング精度に優れている

汎用性も高い

Megadepth-1500[7]の定性評価](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-14-320.jpg)

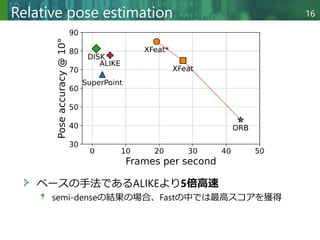

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Relative pose estimation 15

ベースの手法であるALIKEより5倍高速

semi-denseの結果の場合、Fastの中では最高スコアを獲得

Megadepth-1500[7]の定量評価

@5°

=最大角度誤差が5°以下

平均インライア率

=

正しい対応関係

全マッチングの対応関係

記述子の次元数

f: 浮動小数点

b: バイナリベース](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-15-320.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Homography estimation 17

中程度から強い視点移動と照明変化がある

2つの平面画像

評価にはHPaches[8]を使用

HPatches[8]のデータセット](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-17-320.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Homography estimation 18

他の手法と同等な精度を達成

照明変化と視点変化のどちらも対応可能

HPatchesによる定量評価

MHA =

変換行列(ホモグラ

フィ行列)で変換後と

元画像の誤差平均

ホモグラフィ行列の例[9]](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-18-320.jpg)

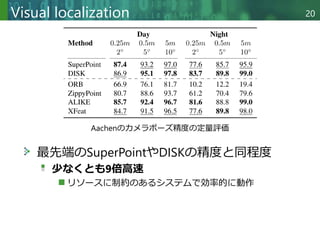

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Visual localization 19

画像を使用した現在位置特定

Aachen: 昼と夜のシーンの画像とカメラの場所

昼夜画像のマッチングは難易度が高い

Aachen[10]のデータセットと結果](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-19-320.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

参考文献 23

[1] Raul Mur-Artal and Juan D Tardos. Orb-slam2: An open-source slam system for monocular, stereo, and rgb-d cameras. IEEE

Trans. on Robotics., 33(5):1255–1262, 2017.

[2] Guilherme Potje, Gabriel Resende, Mario Campos, and Erickson R Nascimento. Towards an efficient 3d model estimation

methodology for aerial and ground images. Mach. Vis. and Applications., 28:937–952, 2017.

[3] Daniel DeTone, Tomasz Malisiewicz, and Andrew Rabinovich. Superpoint: Self-supervised interest point detection and

description. In CVPRW, pages 224–236, 2018.

[4] Menelaos Kanakis, Simon Maurer, Matteo Spallanzani, Ajad Chhatkuli, and Luc Van Gool. Zippypoint: Fast interest point

detection, description, and matching through mixed precision discretization. In CVPRW, pages 6113–6122, 2023.

[5] Xiaoming Zhao, Xingming Wu, Jinyu Miao, Weihai Chen, Peter CY Chen, and Zhengguo Li. Alike: Accurate and lightweight

keypoint detection and descriptor extraction. IEEE TMM, 2022.

[6] Tsung-Yi Lin, Piotr Dollar, Ross Girshick, Kaiming He, Bharath Hariharan, and Serge Belongie. Feature pyramid networks for

object detection. In CVPR, pages 2117–2125, 2017.

[7] Zhengqi Li and Noah Snavely. Megadepth: Learning singleview depth prediction from internet photos. In CVPR, pages 2041–

2050, 2018.

[8] Vassileios Balntas, Karel Lenc, Andrea Vedaldi, and Krystian Mikolajczyk. Hpatches: A benchmark and evaluation of

handcrafted and learned local descriptors. In CVPR, pages 5173–5182, 2017.

[9] Deepでポン!Deep Learningによるホモグラフィ推定技術の調査(コード有り), ABEJA Tech Blog, https://tech-

blog.abeja.asia/entry/awesome-deep-homography-202004, 2024年5月30日参照

[10] Torsten Sattler, Will Maddern, Carl Toft, Akihiko Torii, Lars Hammarstrand, Erik Stenborg, Daniel Safari, Masatoshi Okutomi,

Marc Pollefeys, Josef Sivic, et al. Benchmarking 6dof outdoor visual localization in changing conditions. In CVPR, pages 8601–

8610, 2018.](https://image.slidesharecdn.com/20240531dlseminarmori-240531072559-33abeac1/85/DL-XFeat-Accelerated-Features-for-Lightweight-Image-Matching-23-320.jpg)