2020/6/11 画像センシングシンポジウム オーガナイズドセッション2 「限られたデータからの深層学習」

https://confit.atlas.jp/guide/event/ssii2020/static/organized#OS2

での招待講演資料です。

コンピュータビジョン分野を中心とした転移学習についての講演です。

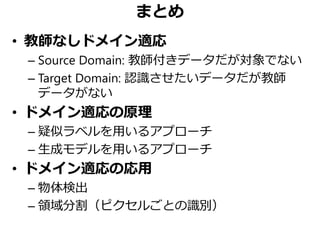

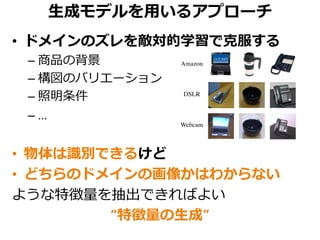

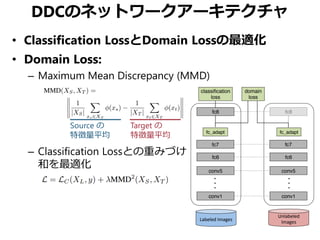

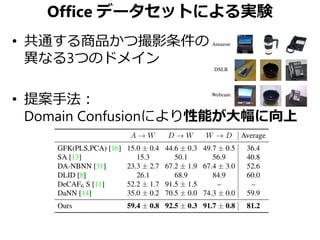

パブリックなデータセットも増えていて、物体検出や領域分割などの研究も盛んですが、実際に社会実装しようとするときのデータは学習データと異なる性質(異なるドメイン)のデータである場合も非常に多いです。

本講演では、そのような場合に有効なドメイン適応の原理となるアプローチ2つと応用としての物体検出と領域分割の事例を紹介しています。

![自己紹介

2014.4 博士(情報理工学)、東京大学

2014.4~2016.3 NTT CS研 研究員

2016.4~ 東京大学 講師 (原田・牛久研究室)

2016.9~ 産業技術総合研究所 協力研究員

2016.12~ 国立国語研究所 共同研究員

2018.4~ オムロンサイニックエックス株式会社

Principal Investigator

2019.1~ 株式会社Ridge-I CRO

[Ushiku+, ACMMM 2012]

[Ushiku+, ICCV 2015]

画像キャプション生成 主観的な感性表現を持つ

画像キャプション生成

動画の特定区間と

キャプションの相互検索

[Yamaguchi+, ICCV 2017]

A guy is skiing with no shirt on

and yellow snow pants.

A zebra standing in a field

with a tree in the dirty

background.

[Shin+, BMVC 2016]

A yellow train on the tracks

near a train station.](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-2-320.jpg)

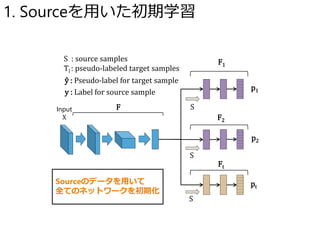

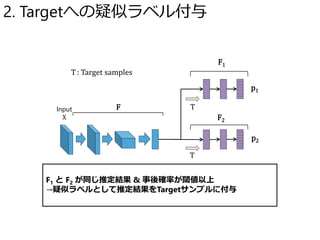

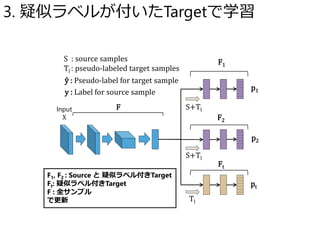

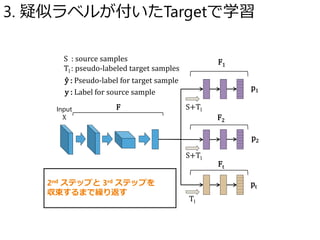

![疑似ラベルを用いたドメイン適応

1st: Sourceで学習 → Targetの簡単なサンプルに疑似ラベル付与

2nd~: Sourceと疑似ラベル付きTargetで学習 → 疑似ラベル追加

eight

nine

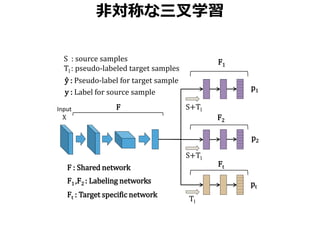

Asymmetric Tri-training for Domain Adaptation

[Saito+, ICML 2017]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-6-320.jpg)

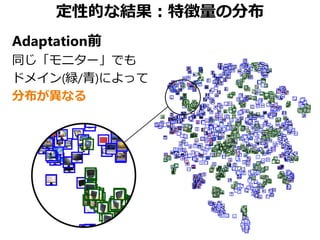

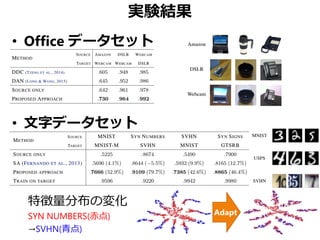

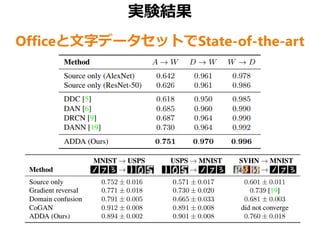

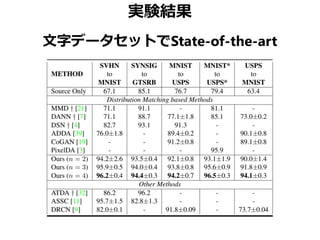

![Targetドメインでの識別精度

• 当時の代表的な手法との比較

– BN: バッチ正規化

– Weight constraint: F1とF2が離れるように学習

Source MNIST MNIST SVHN SYNDIG SYN NUM

Method Target MN-M SVHN MNIST SVHN GTSRB

Source Only (w/o BN) 59.1 37.2 68.1 84.1 79.2

Source Only (with BN) 57.1 34.9 70.1 85.5 75.7

DANN [Ganin et al., 2014] 81.5 35.7 71.1 90.3 88.7

MMD [Long et al., 2015 ICML] 76.9 - 71.1 88.0 91.1

DSN [Bousmalis et al, 2016 NIPS] 83.2 - 82.7 91.2 93.1

K-NN Labeling [Sener et al., 2016 NIPS] 86.7 40.3 78.8 - -

Ours (w/o BN) 85.3 39.8 79.8 93.1 96.2

Ours (w/o Weight constraint) 94.2 49.7 86.0 92.4 94.0

Ours 94.0 52.8 86.8 92.9 96.2](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-13-320.jpg)

![Deep Domain Confusion (DDC)

• Sourceドメインの識別エラーを最小化

• ドメイン間の分布の重なりを最大化

[Tzeng+, arXiv 2014]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-16-320.jpg)

![DANNネットワークアーキテクチャ

• ドメインに依らない特徴量を抽出したい𝐺𝐺𝑓𝑓

• クラス識別をしたい𝐺𝐺𝑦𝑦

• ドメイン識別をしたい𝐺𝐺𝑑𝑑

[Ganin+Lempitsky, ICML 2015]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-21-320.jpg)

![Adversarial Discriminative Domain Adaptation

DANNと同様にドメイン識別器を敵対的学習

[Tzeng+, CVPR 2017]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-25-320.jpg)

![Strong-Weak Distribution Alignment

• 前段で局所特徴分布の強い一致を図り

• 後段で大域特徴分布の弱い一致を図る

[Saito+, CVPR 2019]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-30-320.jpg)

![Strong-Weak Distribution Alignment

Faster RCNNに対して強弱の分布一致を実現

[Saito+, CVPR 2019]

分布](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-31-320.jpg)

![自己学習と敵対的背景正則化

SSDと疑似ラベルを利用したドメイン適応

[Kim+, ICCV 2019]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-33-320.jpg)

![自己学習と敵対的背景正則化

Targetに対して物体領域を提案

• 疑似ラベルが付与されたもの→正例

• 低い損失のみの負例→負例

[Kim+, ICCV 2019]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-34-320.jpg)

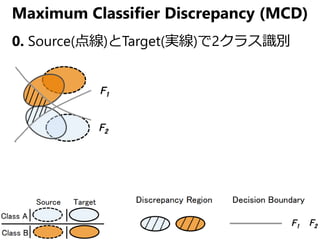

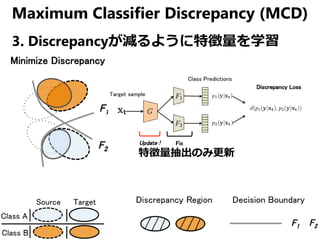

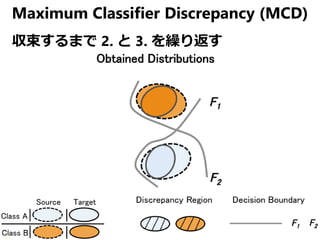

![Maximum Classifier Discrepancy (MCD)

ここまでのドメインを一致させようと

している手法では…

• ドメイン全体の分布を一致させても

クラスごとの分布は一致しないのでは

[Saito+, CVPR 2018]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-37-320.jpg)

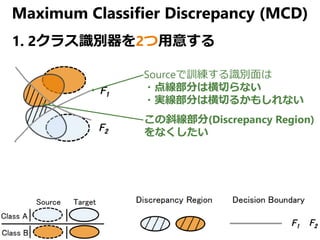

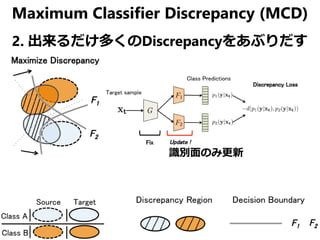

![Maximum Classifier Discrepancy (MCD)

ここまでのドメインを一致させようと

している手法では…

• ドメイン全体の分布を一致させても

クラスごとの分布は一致しないのでは

• ドメインの一致ではなくクラス識別面の一致では

[Saito+, CVPR 2018]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-38-320.jpg)

![深度推定を活用したドメイン適応

同じ物体ラベルのピクセル=同じ深度では

[Vu+, ICCV 2019]

深度を活用すると…

物体の領域の欠損が改善される!](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-46-320.jpg)

![深度推定を活用したドメイン適応

入力画像から深度と領域分割を同時推定

教師あり学習:深度推定と領域分割をSourceで学習

教師なし学習:SourceとTargetを敵対的に弁別

[Vu+, ICCV 2019]](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-47-320.jpg)

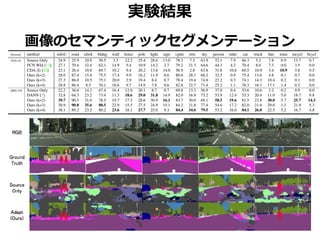

![実験結果

• 著者らの前バージョンAdvEnt [Vu+, CVPR 2019] より改善

AdvEnt: SourceとTargetの領域分割結果だけを敵対的に弁別](https://image.slidesharecdn.com/domainadaptation-200514200909/85/slide-48-320.jpg)