このスライドは 2017 年 1 月 17 日 (火)、ベルサール高田馬場で開催された「NVIDIA Deep Learning Institute 2017」のハンズオン トレーニング「DIGITS による物体検出入門」にて、エヌビディア合同会社 ディープラーニング部 村上 真奈が解説しました。

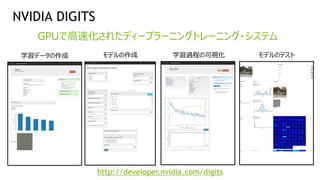

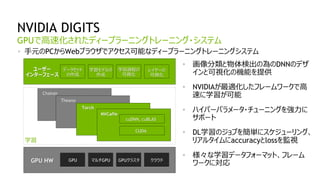

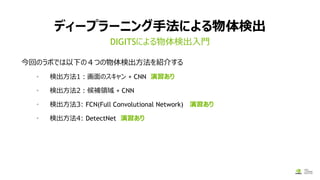

このセッションでは、画像分類の次のステップとして、ディープラーニングを使った物体検出について学びます。「物体検出」を行うことで、入力画像の中から「犬」や「猫」といった特定の物体の位置を検出することができます。物体検出には様々な手法が提案されており、それぞれ、学習時間、認識精度、検出速度など、特性が異なります。このラボでは NVIDIA DIGITS を使って、いくつかの手法を実際に手を動かしながら学んでいただきます。

![DIGITSの使い方4

データセット作成/モデルの作成

物体検出したい場合

[Object Detection]を選択

画像分類したい場合

[Classification]を選択](https://image.slidesharecdn.com/03objectdetectionusingdigitsv6-170118080924/85/DIGITS-32-320.jpg)

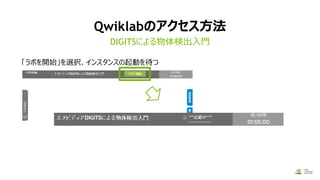

![Qwiklabのアクセス方法

https://nvlabs.qwiklab.com/にアクセスし、[DLI2017-Japan]->[エヌビディアDIGITSによる物

体検出]を選択

DIGITSによる物体検出入門

①

②

③](https://image.slidesharecdn.com/03objectdetectionusingdigitsv6-170118080924/85/DIGITS-36-320.jpg)

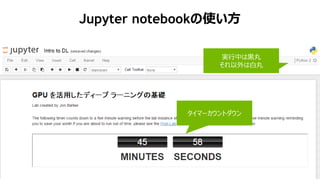

![57

Jupyter notebookの使い方

1/18/2017

In []: と書いてあるセルは動的実行が出来ます

選択されていると緑の枠が

表示される

再生ボタンでセルの実行が出来る

(Shift-Enterでも良い)](https://image.slidesharecdn.com/03objectdetectionusingdigitsv6-170118080924/85/DIGITS-39-320.jpg)

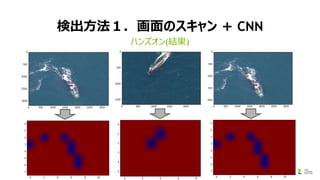

![検出方法1.画面のスキャン + CNN

1. Jupyter notebookからDIGITSを起動し、「鯨」「非鯨」を判別するニューラルネットワークを作

成する。

1. DIGITSで[Datasets]->[Image Classication]から学習データを作成する

2. DIGITSで[Models]->[Image Classication]からモデル作成と学習をする

2. 学習が終わったら、ジョブIDを控える

3. Jupyter notebookに戻り、先ほど学習したモデルを用いて推論(インファレンス)処理を行う

ハンズオン](https://image.slidesharecdn.com/03objectdetectionusingdigitsv6-170118080924/85/DIGITS-45-320.jpg)

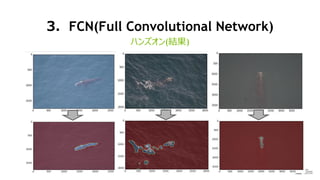

![3.FCN(Full Convolutional Network)

1. 検出方法1のハンズオンで作成した「鯨」と「非鯨」を分類するモデルをFCNに書き換える

1. [Clone Job]でモデルを複製

2. [Standard Networks]->[Alexnet横のcustom]をクリック->テキストボックス内部のネット

ワーク定義を書きかえる

• fc6 – fc8までのエリアを書き換える

• [Model Name]を適当につけて、[Create]ボタンをクリックして、学習を開始

2. 学習が終わったら、ジョブIDを控える

3. Jupyter notebookに戻り、先ほど学習したモデルを用いて推論(インファレンス)処理を行う

ハンズオン](https://image.slidesharecdn.com/03objectdetectionusingdigitsv6-170118080924/85/DIGITS-49-320.jpg)