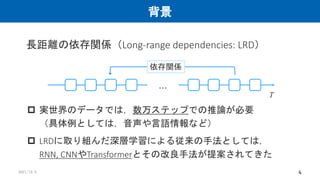

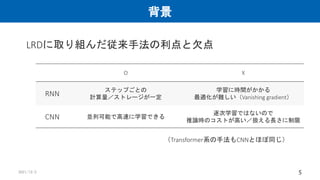

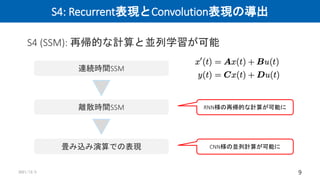

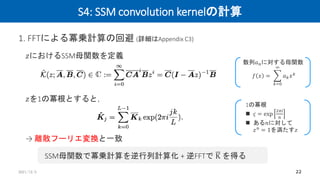

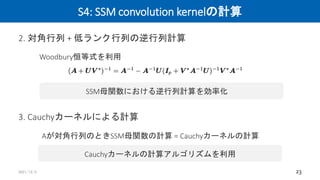

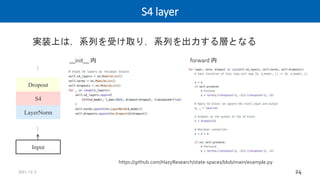

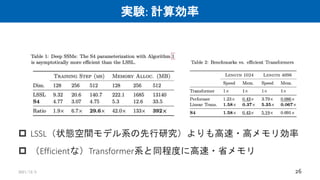

This document summarizes a research paper on modeling long-range dependencies in sequence data using structured state space models and deep learning. The proposed S4 model (1) derives recurrent and convolutional representations of state space models, (2) improves long-term memory using HiPPO matrices, and (3) efficiently computes state space model convolution kernels. Experiments show S4 outperforms existing methods on various long-range dependency tasks, achieves fast and memory-efficient computation comparable to efficient Transformers, and performs competitively as a general sequence model.

![1

DEEP LEARNING JP

[DL Papers]

http://deeplearning.jp/

“Efficiently Modeling Long Sequences with Structured State Spaces”

Naoki Nonaka

2021/12/3](https://image.slidesharecdn.com/211203nonakadl-211203021319/75/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-1-2048.jpg)

![背景

2021/12/3 7

状態空間モデル

入力,出力,状態の3つの変数からなる数学的モデル

多くの数理モデルの基礎となっているモデル

状態空間モデル x 深層学習の手法は存在しなかった※

※ 厳密には同一著者の先行研究[1]が不完全ながら取り組んでいる

図は[1]をもとに改変](https://image.slidesharecdn.com/211203nonakadl-211203021319/85/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-7-320.jpg)

![提案手法: S4

2021/12/3 8

S4: Structured State Space sequence model

→ 状態空間モデル x 深層学習の手法

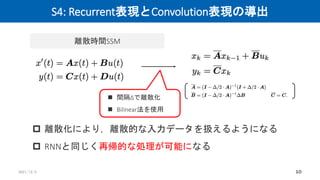

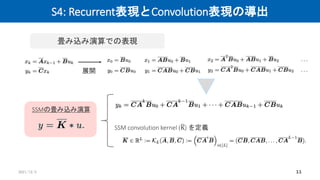

1. SSMのRecurrent表現とConvolution表現の導出

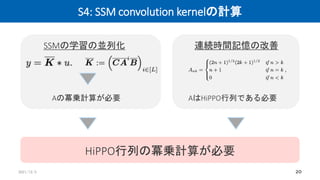

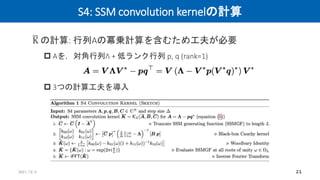

2. HiPPO行列による連続時間記憶の問題の解決 ※

3. SSM convolutionカーネル(後述)の計算の効率化

※ 同一著者の先行研究[1]における工夫と同じ

S4の導出過程](https://image.slidesharecdn.com/211203nonakadl-211203021319/85/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-8-320.jpg)

![提案手法: S4

2021/12/3 13

S4: Structured State Space sequence model

→ 状態空間モデル x 深層学習の手法

1. SSMのRecurrent表現とConvolution表現の導出

2. HiPPO行列による連続時間記憶の問題の解決 ※

3. SSM convolutionカーネル(後述)の計算の効率化

※ 同一著者の先行研究[1]における工夫と同じ

S4の導出過程](https://image.slidesharecdn.com/211203nonakadl-211203021319/85/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-12-320.jpg)

![S4: HiPPO行列による連続時間記憶

2021/12/3 14

直交多項式の重み付き和によって過去の系列を表現

RNNに組み込むと記憶性能が向上する

HiPPO: High-order Polynomial Projection Operators

図は[2]より](https://image.slidesharecdn.com/211203nonakadl-211203021319/85/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-13-320.jpg)

![提案手法: S4

2021/12/3 19

S4: Structured State Space sequence model

→ 状態空間モデル x 深層学習の手法

1. SSMのRecurrent表現とConvolution表現の導出

2. HiPPO行列による連続時間記憶の問題の解決 ※

3. SSM convolutionカーネル(後述)の計算の効率化

※ 同一著者の先行研究[1]における工夫と同じ

S4の導出過程](https://image.slidesharecdn.com/211203nonakadl-211203021319/85/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-14-320.jpg)

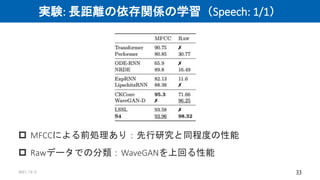

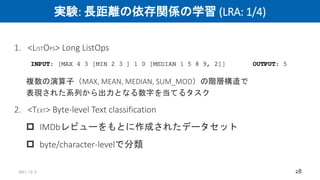

![実験: 長距離の依存関係の学習

2021/12/3 27

Long Range Arena (LRA)

(主にTransformer系の手法を念頭にした)

長距離の依存関係のモデリング性能を評価するためのデータセット []

6つのタスクで構成される

Raw speech classification

Speech Commandデータセット(35クラス,100,503件のサンプル)

話し言葉の音声データの中からキーワードを検出するタスク](https://image.slidesharecdn.com/211203nonakadl-211203021319/85/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-22-320.jpg)

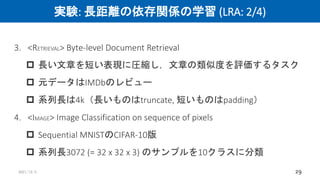

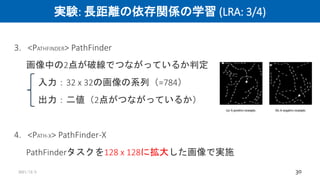

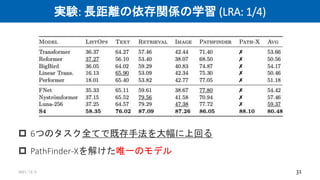

![実験: 長距離の依存関係の学習

2021/12/3 32

Long Range Arena (LRA)

(主にTransformer系の手法を念頭にした)

長距離の依存関係のモデリング性能を評価するためのデータセット []

6つのタスクで構成される

Raw speech classification

Speech Commandデータセット(35クラス,100,503件のサンプル)

話し言葉の音声データの中からキーワードを検出するタスク](https://image.slidesharecdn.com/211203nonakadl-211203021319/85/DL-Efficiently-Modeling-Long-Sequences-with-Structured-State-Spaces-27-320.jpg)