This document summarizes a research paper on scaling laws for neural language models. Some key findings of the paper include:

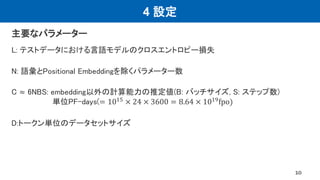

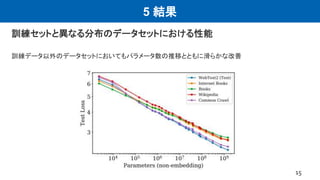

- Language model performance depends strongly on model scale and weakly on model shape. With enough compute and data, performance scales as a power law of parameters, compute, and data.

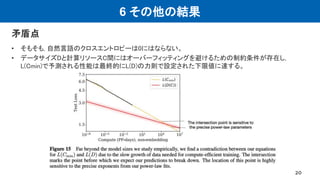

- Overfitting is universal, with penalties depending on the ratio of parameters to data.

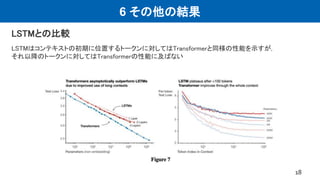

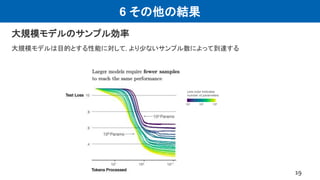

- Large models have higher sample efficiency and can reach the same performance levels with less optimization steps and data points.

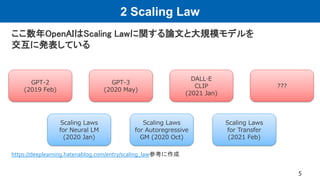

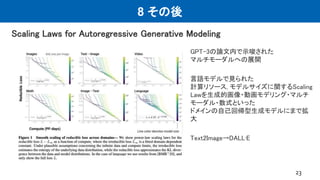

- The paper motivated subsequent work by OpenAI on applying scaling laws to other domains like computer vision and developing increasingly large language models like GPT-3.

![1

DEEP LEARNING JP

[DL Papers]

http://deeplearning.jp/

“Scaling Laws for Neural Language Models” (2020)

Itsuki Okimura, PSI B3](https://image.slidesharecdn.com/dl210219okimura-210219023458/85/DL-Scaling-Laws-for-Neural-Language-Models-1-320.jpg)

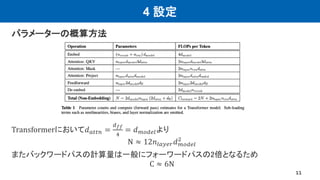

![DEEP LEARNING JP

[DL Papers]

“Scaling Laws for Neural Language Models” (2020)

Itsuki Okimura, PSI B3

http://deeplearning.jp/](https://image.slidesharecdn.com/dl210219okimura-210219023458/85/DL-Scaling-Laws-for-Neural-Language-Models-27-320.jpg)