長岡技術科学大学

2015年度先端GPGPUシミュレーション工学特論(全15回,大学院生対象講義)

第7回総和計算(Atomic演算)

2015年度先端GPGPUシミュレーション工学特論

・第1回 先端シミュレーションおよび産業界におけるGPUの役割

http://www.slideshare.net/ssuserf87701/2015gpgpu1-59180313

・第1回補足 GROUSEの利用方法

http://www.slideshare.net/ssuserf87701/2015gpgpu1-59180326

・第2回 GPUによる並列計算の概念とメモリアクセス

http://www.slideshare.net/ssuserf87701/2015gpgpu2-59180382

・第3回 GPUプログラム構造の詳細(threadとwarp)

http://www.slideshare.net/ssuserf87701/2015gpgpu3-59180483

・第4回 GPUのメモリ階層の詳細(共有メモリ)

http://www.slideshare.net/ssuserf87701/2015gpgpu4-59180572

・第5回 GPUのメモリ階層の詳細(様々なメモリの利用)

http://www.slideshare.net/ssuserf87701/2015gpgpu5-59180652

・第6回 プログラムの性能評価指針(Flop/Byte,計算律速,メモリ律速)

http://www.slideshare.net/ssuserf87701/2015gpgpu6-59180736

・第7回 総和計算(Atomic演算)

http://www.slideshare.net/ssuserf87701/2015gpgpu7-59180844

・第8回 偏微分方程式の差分計算(拡散方程式)

http://www.slideshare.net/ssuserf87701/2015gpgpu8-59180918

・第9回 偏微分方程式の差分計算(移流方程式)

http://www.slideshare.net/ssuserf87701/2015gpgpu9-59180982

・第10回 Poisson方程式の求解(線形連立一次方程式)

http://www.slideshare.net/ssuserf87701/2015gpgpu10-59181031

・第11回 数値流体力学への応用(支配方程式,CPUプログラム)

http://www.slideshare.net/ssuserf87701/2015gpgpu11-59181134

・第12回 数値流体力学への応用(GPUへの移植)

http://www.slideshare.net/ssuserf87701/2015gpgpu12-59181230

・第13回 数値流体力学への応用(高度な最適化)

http://www.slideshare.net/ssuserf87701/2015gpgpu13-59181316

・第14回 複数GPUの利用

http://www.slideshare.net/ssuserf87701/2015gpgpu14-59181367

・第15回 CPUとGPUの協調

http://www.slideshare.net/ssuserf87701/2015gpgpu15-59181450

2015年度GPGPU実践基礎工学

・第1回 学際的分野における先端シミュレーション技術の歴史

http://www.slideshare.net/ssuserf87701/2015gpgpu1

2015年度GPGPU実践プログラミング

・第1回 GPGPUの歴史と応用例

http://www.slideshare.net/ssuserf87701/2015gpgpu1-59179080

講義には長岡技術科学大学のGPGPUシステム(GROUSE)を利用しています。

開発環境

CPU Intel Xeon X5670 × 32

GPU NVIDIA Tesla M2050(Fermi世代) × 64

CUDA 4.0(諸般の事情によりバージョンアップされていません)

PGI Fortran 11.3

![リダクション(Reduction,換算)

2015/05/28先端GPGPUシミュレーション工学特論3

配列の全要素から一つの値を抽出

総和,総積,最大値,最小値など

ベクトル和や移動平均,差分法とは処理が異なる

リダクションの特徴

データ参照が大域的

計算順序は交換可能

出力が一つ

出力は並列に計算できない

並列化に工夫が必要 sum

a[i]

+ + + + + +](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-3-320.jpg)

![リダクション(Reduction,換算)

2015/05/28先端GPGPUシミュレーション工学特論4

リダクションの特徴

データ参照が大域的

計算順序は交換可能

出力が一つ

出力は並列に計算できない

並列化に工夫が必要

ベクトル和の特徴

データ参照が局所的

計算が独立

多出力

出力は並列に計算できる

単純に並列化可能

c[i]

a[i]

b[i]

+ + + + + +

sum

a[i]

+ + + + + +](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-4-320.jpg)

![#include<stdio.h>

#include<stdlib.h>

#define N (256)

#define Nbytes (N*sizeof(int))

int reduction(int *idata){

int sum,i;

sum = 0;

for(i=0;i<N;i++){

sum += idata[i];

}

return sum;

}

void init(int *idata){

int i;

for(i=0;i<N;i++){

idata[i] = 1;

}

}

int main(){

int *idata,sum;

idata = (int *)malloc(Nbytes);

init(idata);

sum = reduction(idata);

printf("sum = %d¥n", sum);

free(idata);

return 0;

}

総和計算のCPUプログラム

2015/05/28先端GPGPUシミュレーション工学特論5

reduction.c](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-5-320.jpg)

![ベクトル和の並列化

2015/05/28先端GPGPUシミュレーション工学特論6

forループをスレッドの数だけ分割

1スレッドが一つの配列添字を計算

for(i=0;i<N;i++){

c[i]=a[i]+b[i];

}

i=blockIdx.x*blockDim.x+threadIdx.x;

c[i]=a[i]+b[i];

c[i]

a[i]

b[i]

+ + + +

スレッド

0

スレッド

2

スレッド

1

スレッド

3](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-6-320.jpg)

![sum

+ + + +

総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論7

GPUでは並列計算が必須

ベクトル和のようにforループを分割

for(i=0;i<N;i++){

sum += idata[i];

}

i=blockIdx.x*blockDim.x+threadIdx.x;

sum += idata[i];

?

スレッド

0

スレッド

2

スレッド

1

スレッド

3

a[i]](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-7-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論8

単純な並列化は不可能

データ競合(データレース)が発生

1.各スレッドが配列a[i]の値を読込み,

レジスタに格納

2.各スレッドが変数sumの値を読込み,

レジスタに格納したa[i]と加算

3.各スレッドがレジスタの値でsumを更新

スレッドがメモリにアクセスした順

番によって結果が変化

プログラム実行毎に変化 sum = 0

a[i] 1 2 3 4

sumの値(0)を参照

スレッド

0

スレッド

2

スレッド

1

スレッド

3](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-8-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論9

単純な並列化は不可能

データ競合(データレース)が発生

1.各スレッドが配列a[i]の値を読込み,

レジスタに格納

2.各スレッドが変数sumの値を読込み,

レジスタに格納したa[i]と加算

3.各スレッドがレジスタの値でsumを更新

スレッドがメモリにアクセスした順

番によって結果が変化

プログラム実行毎に変化 sum = 0

0+1を書込み

1

スレッド

0

スレッド

2

スレッド

1

スレッド

3

a[i] 1 2 3 4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-9-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論10

単純な並列化は不可能

データ競合(データレース)が発生

1.各スレッドが配列a[i]の値を読込み,

レジスタに格納

2.各スレッドが変数sumの値を読込み,

レジスタに格納したa[i]と加算

3.各スレッドがレジスタの値でsumを更新

スレッドがメモリにアクセスした順

番によって結果が変化

プログラム実行毎に変化 sum = 0

0+2を書込み

2

スレッド

0

スレッド

2

スレッド

1

スレッド

3

a[i] 1 2 3 4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-10-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論11

単純な並列化は不可能

データ競合(データレース)が発生

1.各スレッドが配列a[i]の値を読込み,

レジスタに格納

2.各スレッドが変数sumの値を読込み,

レジスタに格納したa[i]と加算

3.各スレッドがレジスタの値でsumを更新

スレッドがメモリにアクセスした順

番によって結果が変化

プログラム実行毎に変化 sum = 2

sumの値(2)を参照

スレッド

0

スレッド

2

スレッド

1

スレッド

3

a[i] 1 2 3 4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-11-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論12

単純な並列化は不可能

データ競合(データレース)が発生

1.各スレッドが配列a[i]の値を読込み,

レジスタに格納

2.各スレッドが変数sumの値を読込み,

レジスタに格納したa[i]と加算

3.各スレッドがレジスタの値でsumを更新

スレッドがメモリにアクセスした順

番によって結果が変化

プログラム実行毎に変化 sum = 2

2+4を書込み

6

スレッド

0

スレッド

2

スレッド

1

スレッド

3

a[i] 1 2 3 4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-12-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論13

単純な並列化は不可能

データ競合(データレース)が発生

1.各スレッドが配列a[i]の値を読込み,

レジスタに格納

2.各スレッドが変数sumの値を読込み,

レジスタに格納したa[i]と加算

3.各スレッドがレジスタの値でsumを更新

スレッドがメモリにアクセスした順

番によって結果が変化

プログラム実行毎に変化 sum = 2

2+3を書込み

5

スレッド

0

スレッド

2

スレッド

1

スレッド

3

a[i] 1 2 3 4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-13-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論14

単純な並列化は不可能

単一スレッドの処理が正しく(逐次実行の

通りに)実行されない

値の読み込み→加算→結果の書き込み

Read‐Modify‐Write

他のスレッドに割り込まれずにRead‐

Modify-Writeを実行する仕組み

が必要

Atomic演算

他のスレッドに任せられない最小単位の

処理

sum = 1

スレッド

0

スレッド

2

スレッド

1

スレッド

3

a[i] 1 2 3 4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-14-320.jpg)

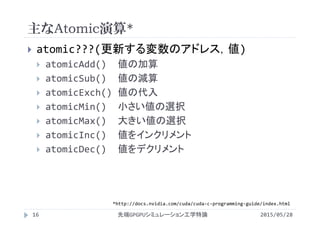

![atomicAdd

2015/05/28先端GPGPUシミュレーション工学特論17

atomicAdd

値の加算

signed int, unsigned int, unsigned long long

int, float(Fermi世代以降)をサポート

__global__ void reduction(int *input, int *sum){

int i=blockIdx.x*blockDim.x + threadIdx.x;

atomicAdd(sum, input[i]);

}

アドレス 値

マルチスレッドで処理しているように見えるが,

本質的に逐次実行と同じ](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-17-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論18

リダクションの並列性

並列性なし

i=0の処理が終了しないとi=1の処理ができない

リダクションの並列化

リダクションの特徴に適した並列化が必要

Parallel Reduction

for(i=0;i<N;i++){

sum += idata[i];

}](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-18-320.jpg)

![総和計算の並列化

2015/05/28先端GPGPUシミュレーション工学特論19

リダクションの並列化

演算順序の変更による並列性の確保

カスケード計算(associative fan‐in algorithm)

カスケード計算

加算の結合法則を利用

乗算や比較でも利用可能

配列要素数が2の冪乗以外では適用

に工夫が必要

変数に浮動小数を用いる場合は値が

一致しないことがある

sum

a[i]

+ + + +

+ +

+](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-19-320.jpg)

![#include<stdio.h>

#include<stdlib.h>

#define N (512)

#define Nbytes (N*sizeof(int))

#define NT (1)

#define NB (1)

__global__ void reduction0(int *idata,int *odata){

int i;

odata[0] = 0;

for(i=0;i<N;i++){

odata[0] += idata[i];

}

}

void init(int *idata){

int i;

for(i=0;i<N;i++){

idata[i] = 1;

}

}

GPUプログラム(1スレッド実装)

2015/05/28先端GPGPUシミュレーション工学特論21

reduction0.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-21-320.jpg)

![実行時間

2015/05/28先端GPGPUシミュレーション工学特論

カーネル

N=512 N=1024

実行時間

[s]

データ転送

[GB/s]

実行時間

[s]

データ転送

[GB/s]

0 54.6 0.035 121 0.032

23](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-23-320.jpg)

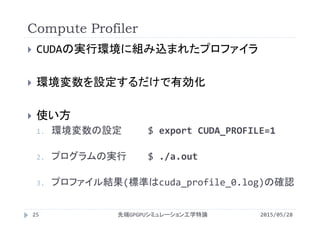

![プロファイル結果の確認

2015/05/28先端GPGPUシミュレーション工学特論28

標準で出力される値

method カーネルや関数(API)の名称

gputime GPU上で処理に要した時間(s単位)

cputime CPUで処理(=カーネル起動)に要した時間

実際の実行時間=cputime+gputime

occupancy 同時実行されているWarp数と実行可能な最大

Warp数の比(一般的には1に近いほどよい)

$ cat cuda_profile_0.log

# CUDA_PROFILE_LOG_VERSION 2.0

# CUDA_DEVICE 0 Tesla M2050

# TIMESTAMPFACTOR fffff6139ae53e88

method,gputime,cputime,occupancy

method=[ memcpyHtoD ] gputime=[ 2.208 ] cputime=[ 42.000 ]

method=[ _Z10reduction0PiS_ ] gputime=[ 120.704 ] cputime=[ 15.000 ] occupancy=[ 0.021 ]

method=[ memcpyDtoH ] gputime=[ 2.592 ] cputime=[ 164.000 ]](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-28-320.jpg)

![#include<stdio.h>

#include<stdlib.h>

#define N (512)

#define Nbytes (N*sizeof(int))

#define NT (256)

#define NB (N/NT)

__global__ void reduction0(int *idata, int *sum){

int i = blockIdx.x*blockDim.x + threadIdx.x;

atomicAdd(sum,idata[i]);

}

void init(int *idata){

//初期化の内容は同じなので省略

}

GPUプログラム(atomic演算)

2015/05/28先端GPGPUシミュレーション工学特論30

reduction0atomic.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-30-320.jpg)

![実行時間

2015/05/28先端GPGPUシミュレーション工学特論

カーネル

N=512 N=1024

実行時間

[s]

データ転送

[GB/s]

実行時間

[s]

データ転送

[GB/s]

0 54.6 0.035 121 0.032

atomic 11.8 0.162 19.7 0.194

32](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-32-320.jpg)

![総和の並列実行(Ver.1)

2015/05/28先端GPGPUシミュレーション工学特論33

1ブロック内の複数のスレッドが並列に加算を実行

1スレッドは「自身が読み込む配列要素iの値」と「隣の配列

要素の値」を加算

idata[i]

+ + + +

+ +

+

idata[i]

idata[i]

idata[i] odata[0]](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-33-320.jpg)

![__global__ void reduction1(int *idata,int *odata){

int i = blockIdx.x*blockDim.x + threadIdx.x;//スレッドと配列要素の対応

int tx = threadIdx.x; //スレッド番号

int step; //Reductionの段数をカウントする変数

int stride; //隣の配列要素までの距離

stride = 1;

for(step=1;step<=STEP;step++){

if(tx%(2*stride)==0){

idata[i] = idata[i]+idata[i+stride];

}

__syncthreads();

stride = stride*2;

}

if(tx==0) odata[0] = idata[0];

}

GPUプログラム(Ver.1)

2015/05/28先端GPGPUシミュレーション工学特論38

reduction1.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-38-320.jpg)

![odata[0]

各Stepでの総和計算(Step 1)

2015/05/28先端GPGPUシミュレーション工学特論39

ストライドを保持する変数strideを1に

初期化

カウンタ変数stepを1に初期化

処理を行うスレッドを選択

スレッド番号を2で割った剰余が0

除数はstride*2

スレッド番号が2の倍数と0スレッドが「自身が

読み込む配列要素iの値」と「隣の配列要素

の値」を加算

スレッド間の同期をとる

ストライドを2倍して次のstepに備える

+ + + +

+ +

+

Step 1

Step 2

Step 3

stride = 1;

for(step=1;step<=STEP;step++){

if(tx%(stride*2)==0){

idata[i]=idata[i]+idata[i+stride];

}

__syncthreads();

stride = stride*2;

}

スレッド0 スレッド2 スレッド4 スレッド6](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-39-320.jpg)

![odata[0]

各Stepでの総和計算(Step 2)

2015/05/28先端GPGPUシミュレーション工学特論40

stepを2に進める

strideを2倍(stride=2)

処理を行うスレッドを選択

スレッド番号をstride*2で割った剰余が0

スレッド番号が4の倍数と0のスレッドが「自

身が読み込む配列要素iの値」と「隣

の配列要素の値」を加算

スレッド間の同期をとる

ストライドを2倍して次のstepに備える

+ + + +

+ +

+

Step 1

Step 2

Step 3

stride = 1;

for(step=1;step<=STEP;step++){

if(tx%(stride*2)==0){

idata[i]=idata[i]+idata[i+stride];

}

__syncthreads();

stride = stride*2;

}

スレッド0 スレッド4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-40-320.jpg)

![odata[0]

各Stepでの総和計算(Step 3)

2015/05/28先端GPGPUシミュレーション工学特論41

stepを3に進める

strideを2倍(stride=4)

処理を行うスレッドを選択

スレッド番号をstride*2で割った剰余が0

スレッド番号が8の倍数と0のスレッドが「自

身が読み込む配列要素iの値」と「隣

の配列要素の値」を加算

スレッド間の同期をとる

ストライドを2倍して次のstepに備える

stepがlog2Nに達するまで繰り返す

+ + + +

+ +

+

Step 1

Step 2

Step 3

stride = 1;

for(step=1;step<=STEP;step++){

if(tx%(stride*2)==0){

idata[i]=idata[i]+idata[i+stride];

}

__syncthreads();

stride = stride*2;

}

スレッド0](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-41-320.jpg)

![各Stepでの総和計算(結果の書き出し)

2015/05/28先端GPGPUシミュレーション工学特論42

スレッド0が総和を出力用変数odataに

書き込んで終了

+ + + +

+ +

+

Step 1

Step 2

Step 3

if(tx==0) odata[0] = idata[0];

odata[0]

スレッド0](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-42-320.jpg)

![実行時間

2015/05/28先端GPGPUシミュレーション工学特論

カーネル

N=512 N=1024

実行時間

[s]

データ転送

[GB/s]

実行時間

[s]

データ転送

[GB/s]

0 54.6 0.035 121 0.032

atomic 11.8 0.162 19.7 0.194

1 9.73 0.196 12.8 0.297

43](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-43-320.jpg)

![__global__ void reduction1(int *idata,int *odata){

int i = blockIdx.x*blockDim.x + threadIdx.x;//スレッドと配列要素の対応

int tx = threadIdx.x; //スレッド番号

int step; //Reductionの段数をカウントする変数

int stride; //隣の配列要素までの距離

//ストライドを2倍

for(step=1,stride = 1;step<=STEP;step++, stride = stride*2;){

if(tx%(stride*2)==0){

idata[i] = idata[i]+idata[i+stride];

}

__syncthreads();

}

if(tx==0) odata[0] = idata[0];

}

GPUプログラム(Ver.1.1)

2015/05/28先端GPGPUシミュレーション工学特論46

reduction1shift.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-46-320.jpg)

![__global__ void reduction1(int *idata,int *odata){

int i = blockIdx.x*blockDim.x + threadIdx.x;//スレッドと配列要素の対応

int tx = threadIdx.x; //スレッド番号

int step; //Reductionの段数をカウントする変数

int stride; //隣の配列要素までの距離

//ストライドを左に一つビットシフト(値が2倍になる)

for(step=1,stride = 1;step<=STEP;step++, stride<<=1;){

if(tx%(stride*2)==0){

idata[i] = idata[i]+idata[i+stride];

}

__syncthreads();

}

if(tx==0) odata[0] = idata[0];

}

GPUプログラム(Ver.1.1)

2015/05/28先端GPGPUシミュレーション工学特論48

reduction1shift.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-48-320.jpg)

![実行時間

2015/05/28先端GPGPUシミュレーション工学特論

カーネル

N=512 N=1024

実行時間

[s]

データ転送

[GB/s]

実行時間

[s]

データ転送

[GB/s]

1 9.73 0.196 12.8 0.297

1.1 9.70 0.197 12.8 0.298

49](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-49-320.jpg)

![__global__ void reduction1(int *idata,int *odata){

int i = blockIdx.x*blockDim.x + threadIdx.x;//スレッドと配列要素の対応

int tx = threadIdx.x; //スレッド番号

int step; //Reductionの段数をカウントする変数 //#define STEPも削除

int stride; //隣の配列要素までの距離

for(stride = 1; stride <= blockDim.x/2; stride<<=1){

if(tx%(2*stride) == 0){

idata[i] = idata[i]+idata[i+stride];

}

__syncthreads();

}

if(tx==0) odata[0] = idata[0];

}

GPUプログラム(Ver.1.2)

2015/05/28先端GPGPUシミュレーション工学特論51

reduction1stride.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-51-320.jpg)

![odata[0]

各Stepでの総和計算(Step 1)

2015/05/28先端GPGPUシミュレーション工学特論52

ストライドを保持する変数strideを1に

初期化

処理を行うスレッドを選択

スレッド番号を2で割った剰余が0

除数はstride*2

スレッド番号が2の倍数と0スレッドが「自身が

読み込む配列要素iの値」と「隣の配列要素

の値」を加算

スレッド間の同期をとる

ストライドを2倍し,ストライドがN/2以下

ならループを継続

+ + + +

+ +

+

stride

が1の段

for(stride = 1; stride <= blockDim.x/2;

stride<<=1){

if(tx%(2*stride) == 0){

idata[i]=idata[i]+idata[i+stride];

}

__syncthreads();

}

スレッド0 スレッド2 スレッド4 スレッド6](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-52-320.jpg)

![odata[0]

各Stepでの総和計算(Step 2)

2015/05/28先端GPGPUシミュレーション工学特論53

処理を行うスレッドを選択

スレッド番号をstride*2で割った剰余が0

スレッド番号が4の倍数と0のスレッドが「自

身が読み込む配列要素iの値」と「隣

の配列要素の値」を加算

スレッド間の同期をとる

ストライドを2倍し,ストライドがN/2以下

ならループを継続

strideが4になるのでstride=N/2

※NとblockDim.xが等しくなるように設定し

ているため

+ + + +

+ +

+

stride

が2の段

for(stride = 1; stride <= blockDim.x/2;

stride<<=1){

if(tx%(2*stride) == 0){

idata[i]=idata[i]+idata[i+stride];

}

__syncthreads();

}

スレッド0 スレッド4](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-53-320.jpg)

![odata[0]

各Stepでの総和計算(Step 3)

2015/05/28先端GPGPUシミュレーション工学特論54

処理を行うスレッドを選択

スレッド番号をstride*2で割った剰余が0

スレッド番号が8の倍数と0のスレッドが「自

身が読み込む配列要素iの値」と「隣

の配列要素の値」を加算

スレッド間の同期をとる

ストライドを2倍し,ストライドがN/2以下

ならループを継続

strideが8になるのでstride>N/2となって

ループを抜ける

+ + + +

+ +

+stride

が4の段

for(stride = 1; stride <= blockDim.x/2;

stride<<=1){

if(tx%(2*stride) == 0){

idata[i]=idata[i]+idata[i+stride];

}

__syncthreads();

}

スレッド0](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-54-320.jpg)

![各Stepでの総和計算(結果の書き出し)

2015/05/28先端GPGPUシミュレーション工学特論55

スレッド0が総和を出力用変数odataに

書き込んで終了

+ + + +

+ +

+

if(tx==0) odata[0] = idata[0];

odata[0]

スレッド0](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-55-320.jpg)

![実行時間

2015/05/28先端GPGPUシミュレーション工学特論

実行時間が増加

forループに対する最適化が抑制された?

#pragma unrollでループ展開してもLoop was not unrolled,

cannot deduce loop trip countというメッセージが出力

Nを変更するとSTEPも変更されるなら,バージョン1.1でもよい

カーネル

N=512 N=1024

実行時間

[s]

データ転送

[GB/s]

実行時間

[s]

データ転送

[GB/s]

1 9.73 0.196 12.8 0.297

1.1 9.70 0.197 12.8 0.298

1.2 12.8 0.149 18.3 0.209

56](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-56-320.jpg)

![総和の並列実行(Ver.2)

2015/05/28先端GPGPUシミュレーション工学特論58

全スレッドがグローバルメ

モリから共有メモリへデー

タをコピー

共有メモリ上で総和を計算

1ブロック内の複数のスレッ

ドが並列に加算を実行

1スレッドは「自身が読み込む

配列要素iの値」と「隣の配列

要素の値」を加算

s_idata[i]

+ + + +

+ +

+

s_idata[i]

s_idata[i]

s_idata[i]odata[0]

idata[i]](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-58-320.jpg)

![__global__ void reduction2(int *idata,int *odata){

int i = blockIdx.x*blockDim.x + threadIdx.x;//スレッドと配列要素の対応

int tx = threadIdx.x; //スレッド番号

int stride; //”隣”の配列要素までの距離

__shared__ volatile int s_idata[N]; //共有メモリの宣言

s_idata[i] = idata[i]; //グローバルメモリから共有メモリへデータをコピー

__syncthreads(); //共有メモリのデータは全スレッドから参照されるので同期を取る

//総和計算はVer.1.2(reduction1stride.cu)と同じ

for(stride = 1; stride <= blockDim.x/2; stride<<=1){

if(tx%(2*stride) == 0){

s_idata[i] = s_idata[i]+s_idata[i+stride];

}

__syncthreads();

}

if(tx==0) odata[0] = s_idata[0];

}

GPUプログラム(Ver.2)

2015/05/28先端GPGPUシミュレーション工学特論62

reduction2.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-62-320.jpg)

![volatile修飾子

2015/05/28先端GPGPUシミュレーション工学特論63

コンパイラの最適化を抑制

複数のスレッドからアクセスされる変数に対する最適化

コンパイラが不要と判断して処理を削除

複数スレッドが変数の値をプライベートな領域にコピーし

て書き戻さない等

このバージョンでは不要だが後々必要

さらに最適化する場合は必須

volatile int s_idata[NT];](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-63-320.jpg)

![総和計算

2015/05/28先端GPGPUシミュレーション工学特論64

ブロック内の全スレッドがグローバルメ

モリへアクセスし,データを共有メモリへ

コピー

全スレッドが1回は何らかの処理を行う

総和計算はVer.1.2と同じ

取り扱う配列がidata[]からs_idata[]に

変更されているだけ

+ + + +

strideが

1の段

s_idata[i] = idata[i];

__syncthreads();

idata[i]

s_idata[i]](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-64-320.jpg)

![実行時間

2015/05/28先端GPGPUシミュレーション工学特論

カーネル

N=512 N=1024

実行時間

[s]

データ転送

[GB/s]

実行時間

[s]

データ転送

[GB/s]

0 54.6 0.035 121 0.032

atomic 11.8 0.162 19.7 0.194

1 9.73 0.196 12.8 0.297

2 10.9 0.175 15.9 0.240

65](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-65-320.jpg)

![総和の並列実行(Ver.3)

2015/05/28先端GPGPUシミュレーション工学特論68

ブロック内の全スレッドが

グローバルメモリから共有

メモリへデータをコピー

共有メモリ上で総和を計算

1ブロック内の複数のス

レッドが並列に加算を実行

主な変更点

共有メモリを参照する添字

アトミック演算の追加

s_idata[tx]

+ + + +

+ +

s_idata[tx]

idata[i]

+

sum

blockIdx.x=0 blockIdx.x=1

+](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-68-320.jpg)

![総和の並列実行(Ver.3)

2015/05/28先端GPGPUシミュレーション工学特論69

実装に必要な情報

部分和の記録場所

s_idata[0]

共有メモリ用の配列添字と

グローバルメモリ用の配列

添字の区別

s_idata[tx]

+ + + +

+ +

s_idata[tx]

idata[i]

blockIdx.x=0

+

+

blockIdx.x=1

sum](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-69-320.jpg)

![__global__ void reduction3(int *idata,int *odata){

int i = blockIdx.x*blockDim.x + threadIdx.x;//スレッドと配列要素の対応

int tx = threadIdx.x; //スレッド番号

int stride; //”隣”の配列要素までの距離

__shared__ volatile int s_idata[NT]; //共有メモリの宣言

s_idata[tx] = idata[i]; //グローバルメモリから共有メモリへデータをコピー

__syncthreads(); //共有メモリのデータは全スレッドから参照されるので同期を取る

//総和計算はバージョン1.2(reduction1stride.cu)と同じ

for(stride = 1; stride <= blockDim.x/2; stride<<=1){

if(tx%(2*stride) == 0){

s_idata[tx] = s_idata[tx]+s_idata[tx+stride];

}

__syncthreads();

}

if(tx==0) atomicAdd(odata,s_idata[tx]);

}

GPUプログラム(Ver.3)

2015/05/28先端GPGPUシミュレーション工学特論72

reduction3.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-72-320.jpg)

![総和計算

2015/05/28先端GPGPUシミュレーション工学特論73

共有メモリサイズは1ブロックが処理する

データの数と同じ

ブロック内の全スレッドがグローバルメ

モリへアクセスし,データを共有メモリへ

コピー

総和計算はバージョン1.2と同じ

グローバルメモリにアクセスするための配列

添字i

共有メモリにアクセスするための配列添字tx

+ + + +

strideが

1の段

__shared__ volatile int s_idata[NT];

s_idata[tx] = idata[i];

__syncthreads();

idata[i]

s_idata[tx]

i= 0 1 2 3 4 5 6 7

threadIdx.x= 0 1 2 3 0 1 2 3](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-73-320.jpg)

![+

+

各ブロックでの部分和の計算

2015/05/28先端GPGPUシミュレーション工学特論74

ストライドを保持する変数strideを1に

初期化

処理を行うスレッドを選択

スレッド番号を2で割った剰余が0

除数はstride*2

スレッド番号が2の倍数と0スレッドが「自身が

読み込む配列要素iの値」と「隣の配列要素

の値」を加算

スレッド間の同期をとる

ストライドを2倍し,ストライドがN/2以下

ならループを継続

+ + + +

+ +

strideが

1の段

for(stride = 1; stride <= blockDim.x/2;

stride<<=1){

if(tx%(2*stride) == 0){

s_idata[tx]=s_idata[tx]+s_idata[tx+stride];

}

__syncthreads();

}

スレッド0 スレッド2 スレッド0 スレッド2](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-74-320.jpg)

![+

+

各ブロックでの部分和の計算

2015/05/28先端GPGPUシミュレーション工学特論75

処理を行うスレッドを選択

スレッド番号をstride*2で割った剰余が0

スレッド番号が4の倍数と0のスレッドが「自

身が読み込む配列要素iの値」と「隣

の配列要素の値」を加算

スレッド間の同期をとる

ストライドを2倍し,ストライドがN/2以下

ならループを継続

strideが4になるのでstride >

blockDim.x/2となってループを抜ける

+ + + +

+ +strideが

2の段

for(stride = 1; stride <= blockDim.x/;

stride<<=1){

if(tx%(2*stride) == 0){

s_idata[i]=s_idata[i]+s_idata[i+stride];

}

__syncthreads();

}

スレッド0 スレッド0

for(stride = 1; stride <= blockDim.x/2;

stride<<=1){

if(tx%(2*stride) == 0){

s_idata[tx]=s_idata[tx]+s_idata[tx+stride];

}

__syncthreads();

}](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-75-320.jpg)

![各ブロックでの部分和の計算(結果の出力)

2015/05/28先端GPGPUシミュレーション工学特論76

各ブロックのスレッド0がatomicAdd()

を呼び出す

各ブロックのs_idata[0]に計算された

部分和が格納

各ブロックのスレッド0が,部分和をグローバルメ

モリsumへ排他的に加算

+ + + +

+ +

if(tx==0) atomicAdd(sum,s_idata[tx]);

sum

スレッド0 スレッド0

+

+](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-76-320.jpg)

![実行時間

2015/05/28先端GPGPUシミュレーション工学特論

配列要素数が少なくてもスレッド数を適切に決定できる

配列要素数を大きくするにつれてデータ転送レートが向上

atomic演算はそこまで遅くない?

カーネルの最適化が十分なのか検討が必要

77

N(NT) 実行時間 [s] データ転送[GB/s]

29(256) 8.80 0.217

210(256) 8.83 0.432

212(256) 9.47 1.61

214(256) 15.1 4.04

216(256) 43.2 5.65

218(256) 155 6.30

220(256) 596 6.55

カーネルVer.2の結果

10.9 ms, 0.175 GB/s

カーネルVer.2の結果

15.9 ms, 0.240 GB/s](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-77-320.jpg)

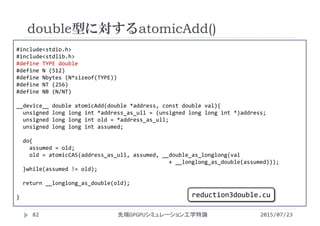

![__global__ void reduction3(TYPE *idata, TYPE *sum){

int i = blockIdx.x*blockDim.x + threadIdx.x;

int tx = threadIdx.x;

int stride;

__shared__ volatile TYPE s_idata[NT];

s_idata[tx] = idata[i];

__syncthreads();

for(stride = 1; stride <= blockDim.x/2; stride<<=1){

if(tx%(2*stride) == 0){

s_idata[tx] = s_idata[tx]+s_idata[tx+stride];

}

__syncthreads();

}

if(tx==0) atomicAdd(sum,s_idata[tx]);

}

double型に対するatomicAdd()

2015/07/23先端GPGPUシミュレーション工学特論83

reduction3double.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-81-320.jpg)

![void init(TYPE *idata){

int i;

for(i=0;i<N;i++){

idata[i] = 1;

}

}

int main(){

TYPE *idata,*odata;

TYPE *host_idata,sum;

cudaMalloc( (void **)&idata, Nbytes);

cudaMalloc( (void **)&odata, sizeof(TYPE));

host_idata = (TYPE *)malloc(Nbytes);

init(host_idata);

cudaMemcpy(idata, host_idata,Nbytes, cudaMemcpyHostToDevice);

free(host_idata);

double型に対するatomicAdd()

2015/07/23先端GPGPUシミュレーション工学特論84

reduction3double.cu](https://image.slidesharecdn.com/advancedgpgpu07-160307060152/85/2015-GPGPU-7-Atomic-82-320.jpg)