近年数値シミュレーション研究において、本来グラフィック処理用のGPU(Graphics Processing Unit)を演算用途に用いることが進んでいる。GPUは、CPUに比べて高い演算性能、プロセッサ-メモリ間での高いデータ転送速度に加えて高い電力効率といった特徴を持つことから、米国オークリッジ国立研究所のTitan(2012年11月に世界最高演算性能を記録)、東京工業大学のTSUBAME2.0などGPUを用いた大規模スーパーコンピュータ(以下スパコン)の割合が増加している。

気象・気候モデルへのGPUの適用では、先進的な事例としてShimokawabe et al. (2010)による気象モデルASUCAのGPUへの移植とTSUBAME2.0での大規模実行がある。しかしながら、気象・気候学からの研究成果を創出するほどにはGPUは普及していない状況である。考えられる理由としては、GPUはCPUに比べてコア数が多く超並列でのプログラミングが求められること、CPUとGPUの複合アーキテクチャとなること、GPU用言語(CUDA)の利用、コードのポータビリティの問題に加え先行事例が少ないために知見の蓄積が不十分であることが挙げられる。

その一方国外では NIM(NOAA)またはCAM-SE(NCAR)など、気象・気候モデルのGPUへの移植が進行中であり、GPUの高い性能を生かした気象・気候学としての成果がTitan等の大規模GPUスパコンを用いて得られることが見込まれている。今後国内でも気象・気候モデルのGPUへの適用を検討する重要性は高い。

また、2018 年頃を目標 に京コンピュータの100倍の性能を目指して開発が進むエクサスケール規模のスパコンでは、数百の計算コアを持つプロセッサの採用が見込まれている。GPUにて気象・気候モデルの超並列計算を研究することは、エクサスケール規模のスパコンで必須となる超並列計算に向けた基礎研究としての意味を持つ。

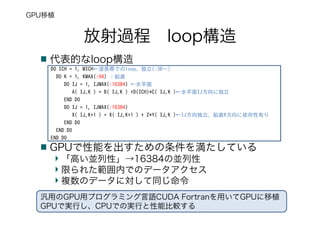

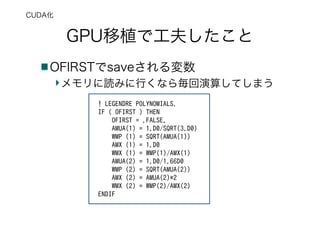

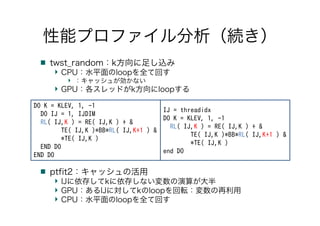

以上を踏まえ、気象・気候モデルのGPUへの適用性の検討と適用に必要な知見の蓄積を目標に、気候モデル放射カーネルのGPUへの移植とその高速化を試みた。

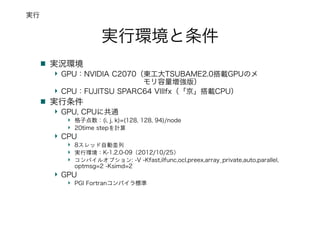

![実行結果

経過時間

259.6[s]:CPU(FUJITSU SPARC64 VIIIfx)

55.4[s]:GPU(NVIDIA C2070)

実効性能

18.9GFLOPS:CPU (15%, 理論128GFLOPS)

88.6GFLOPS:GPU (17%, 理論515GFLOPS)

info.

GPUの経過時間にはCPU-GPU間データ転送時間を含まず

CPUは基本プロファイラ計測

GPUはタイマ挿入して計測

GPUの実効性能は経過時間からの比較で推定

CPUの4.7倍 CPUと同程度以上

結果](https://image.slidesharecdn.com/2013metspringposter-170326011222/85/GPU-21-320.jpg)