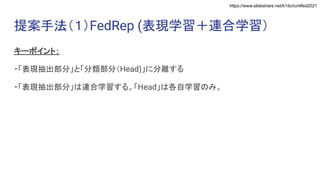

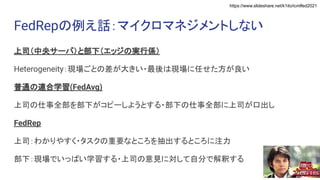

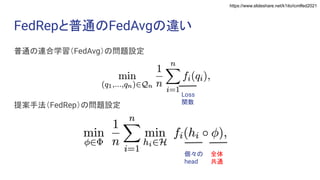

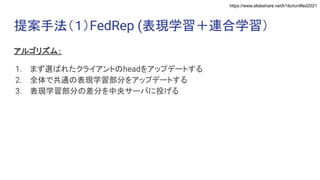

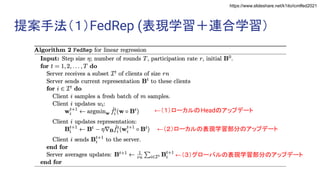

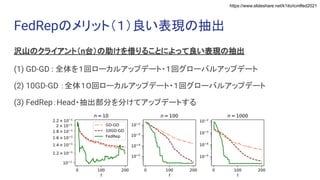

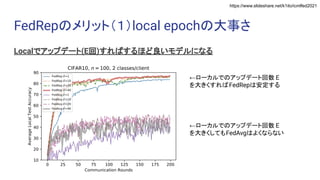

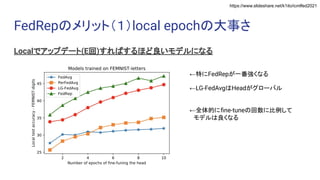

Exploiting Shared Representations for Personalized Federated Learning (ICML 2021) https://arxiv.org/abs/2102.07078 キーワード:連合学習・表現学習

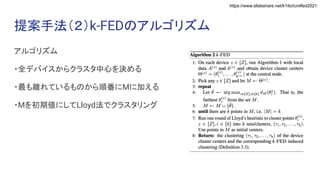

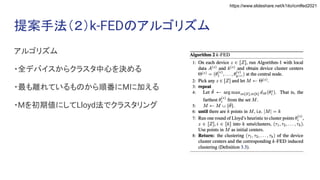

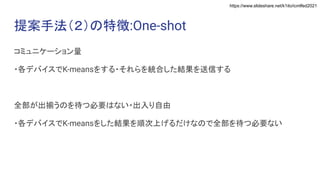

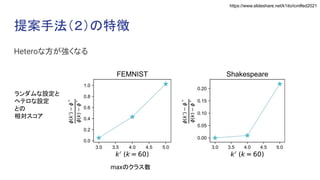

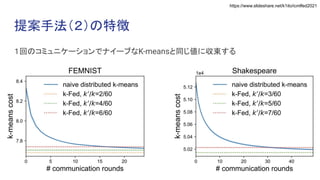

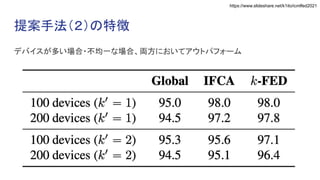

Heterogeneity for the Win: One-Shot Federated Clustering (ICML 2021) https://arxiv.org/abs/2103.00697 キーワード:教師なし・one-shot・連合学習