SSII2022 [OS3-02] Federated Learningの基礎と応用

6月10日 (金) 11:00 - 12:30 メイン会場

登壇者:西尾 理志 氏(東京工業大学)

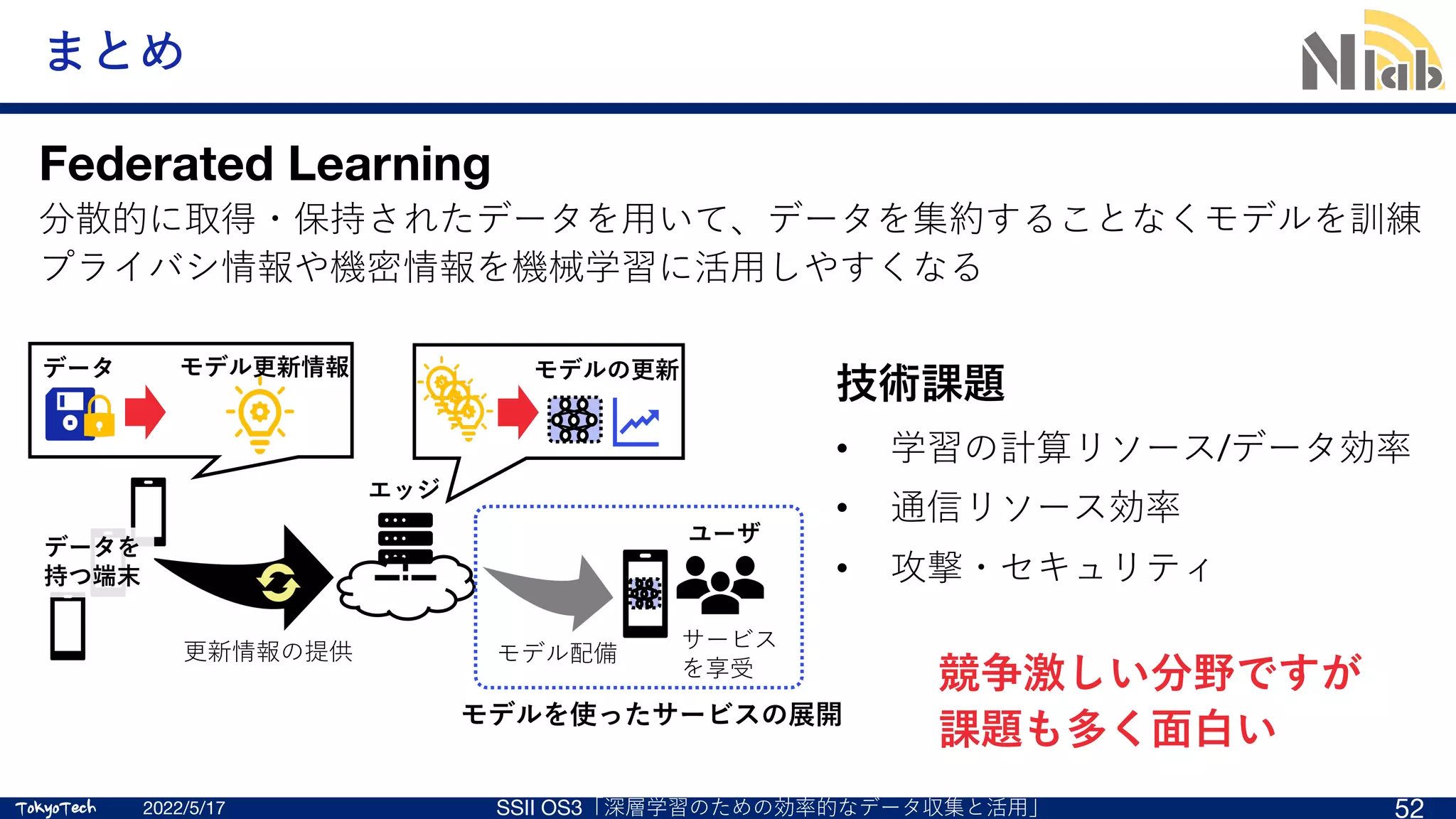

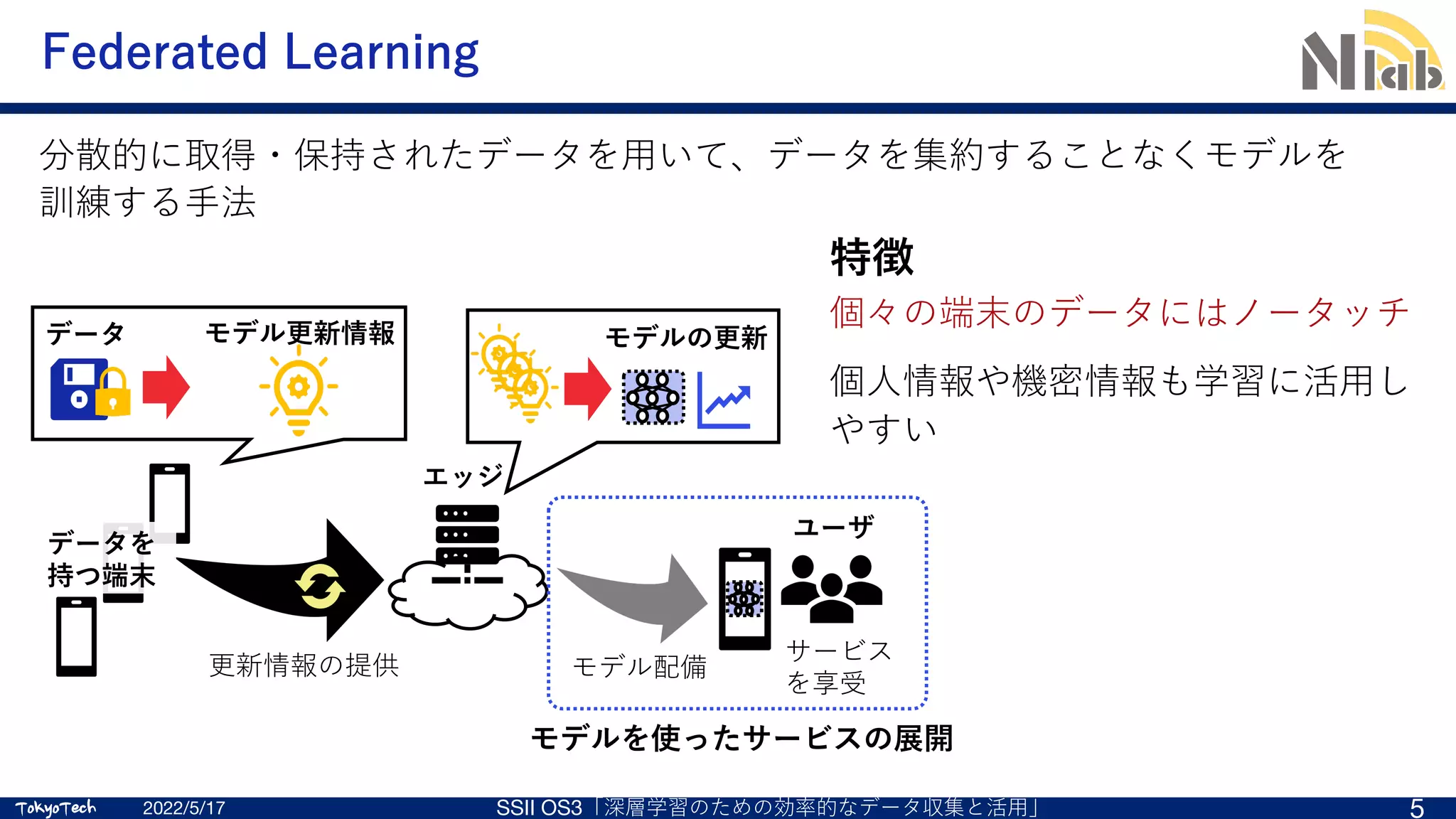

概要:Federated Learning (FL)とは、分散して保持されたデータを収集・集約することなく機械学習モデルの訓練に用いる方法である。画像や音声、ヘルスケア情報など個人情報や機密情報の保護の観点から集約が難しいデータを機械学習へ活用できるという期待から、学術および産業の両面から注目を集めている。本講演では、FLの原理と応用例、FLの課題解決に向けた近年の取り組みについて解説する。

![TokyoTech

TokyoTech

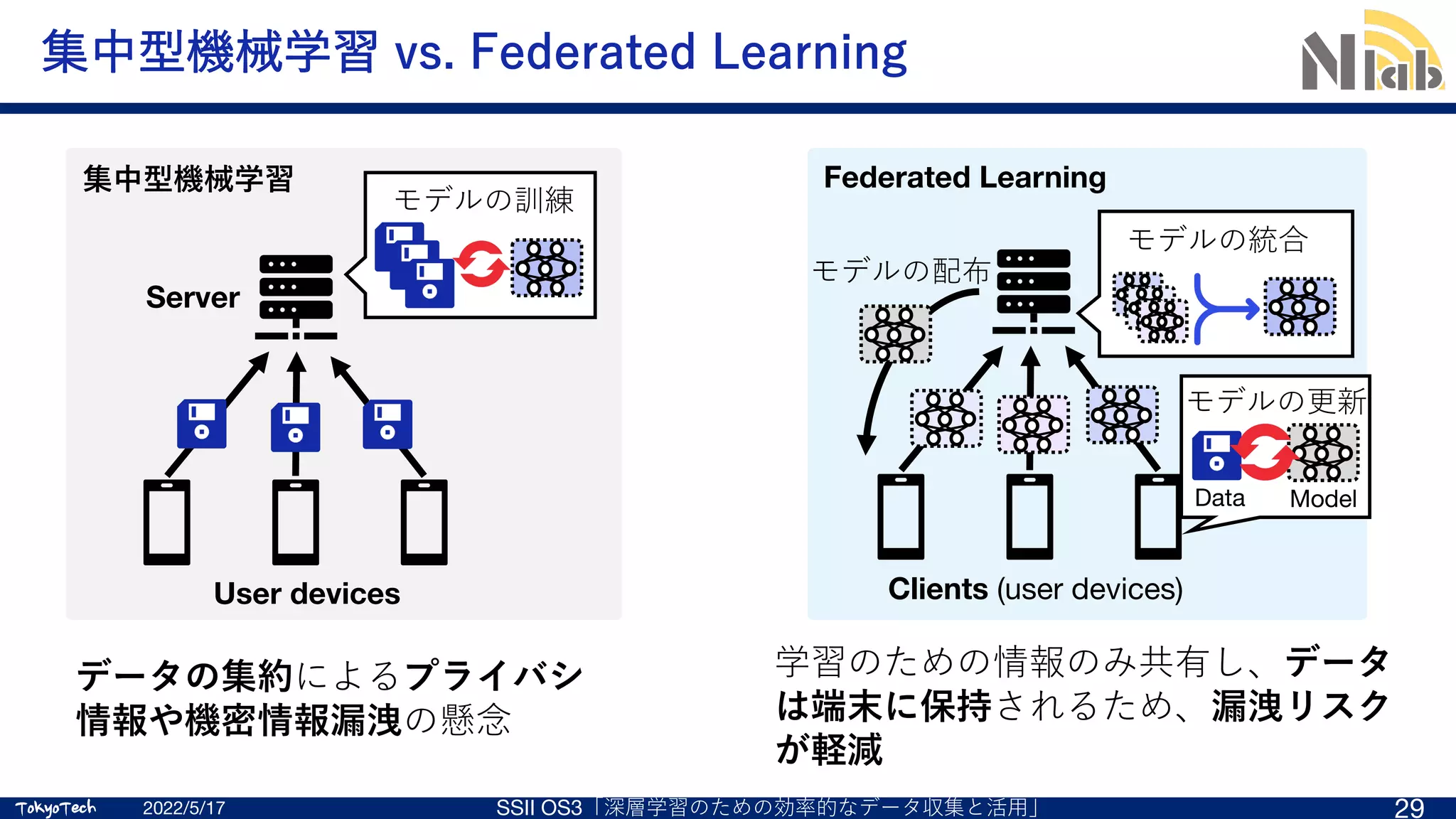

機械学習のためにデータを収集したいが…

データの集約にはリスクが伴う

•データの漏洩

•プライバシ情報の流出

⼼理的障壁

•データを提供するのはなんとなく嫌

2022/5/17 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 4

Federated Learning (FL, 連合機械学習)[1]

[1] B. McMahan, et al.,“Communication-efficient learning of deep networks from decentralized data,” Proc. AISTATS, pp. 1273–1282, Apr. 2017.

Server

盗聴

クラッキング

個⼈の特定

Motivation: データを集約せずに学習に活⽤したい!](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-4-2048.jpg)

![TokyoTech

TokyoTech

Applications: Emoji prediction from Google [4]

2022/5/17 T5: Part1 8

[4] Ramaswamy, et al., “Federated Learning for Emoji

Prediction in a Mobile Keyboard,” arXiv:1906.04329.

ML model predicts a Emoji based on the context.

The model trained via FL achieved better prediction accuracy (+7%).](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-7-2048.jpg)

![TokyoTech

TokyoTech

Applications: Oxygen needs prediction from NVIDIA [6]

[6] https://blogs.nvidia.com/blog/2020/10/05/federated-learning-covid-oxygen-needs/

2022/5/17 T5: Part1 9

Using NVIDIA Clara Federated Learning Framework,

researchers at individual hospitals were able to

use a chest X-ray, patient vitals and lab values to

train a local model and share only a subset of model

weights back with the global model in a privacy-

preserving technique called federated learning.](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-8-2048.jpg)

![TokyoTech

TokyoTech

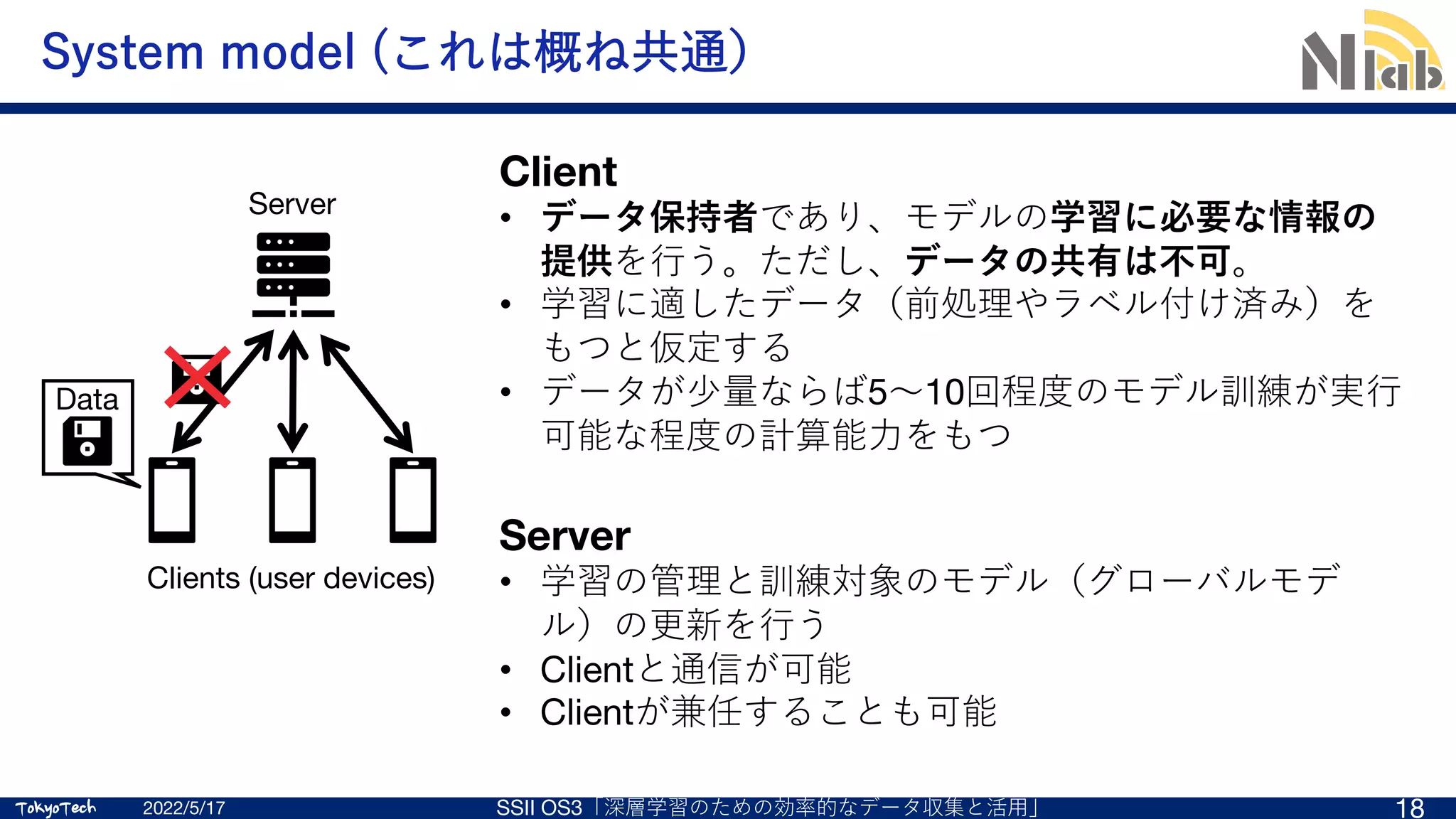

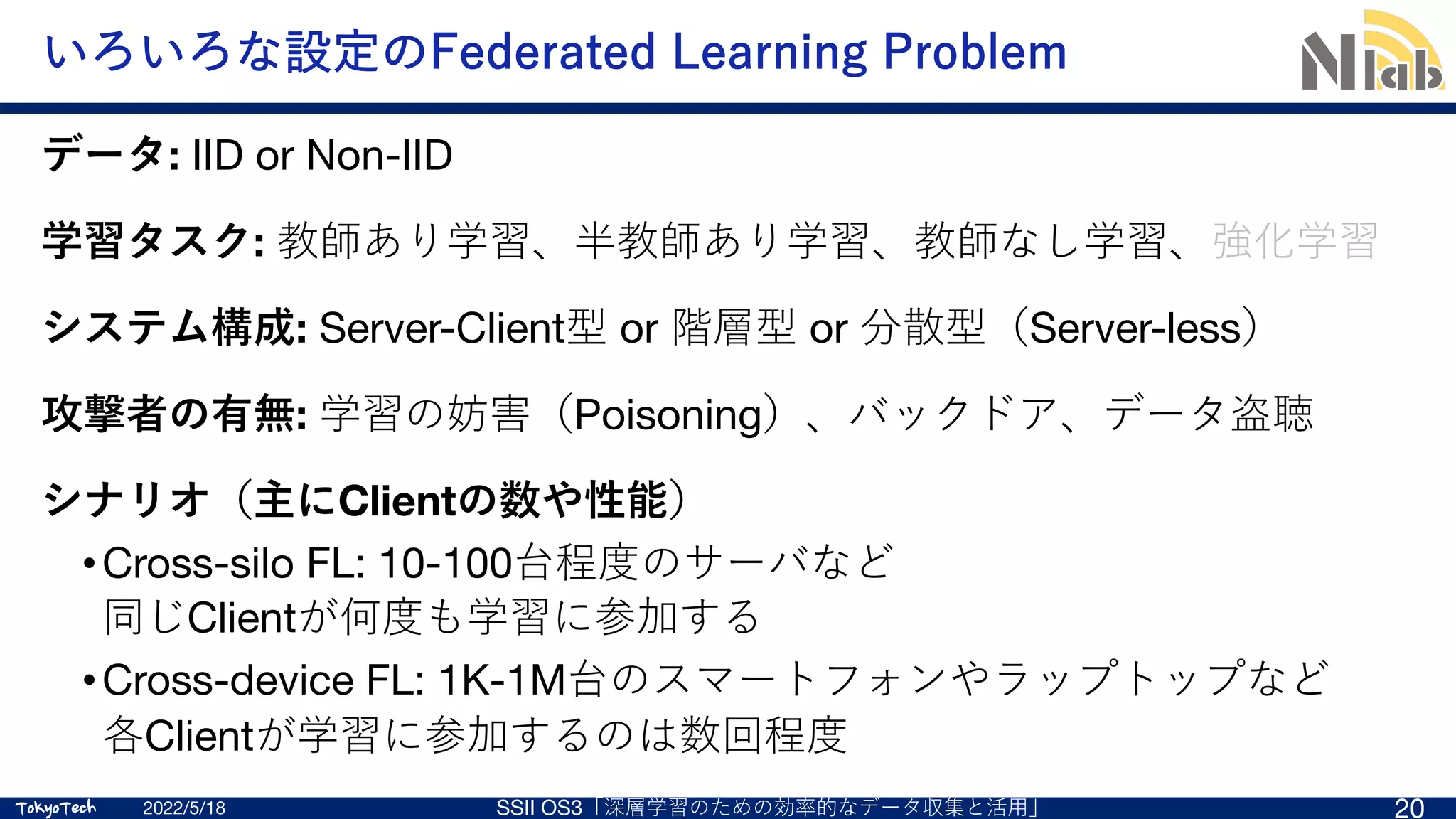

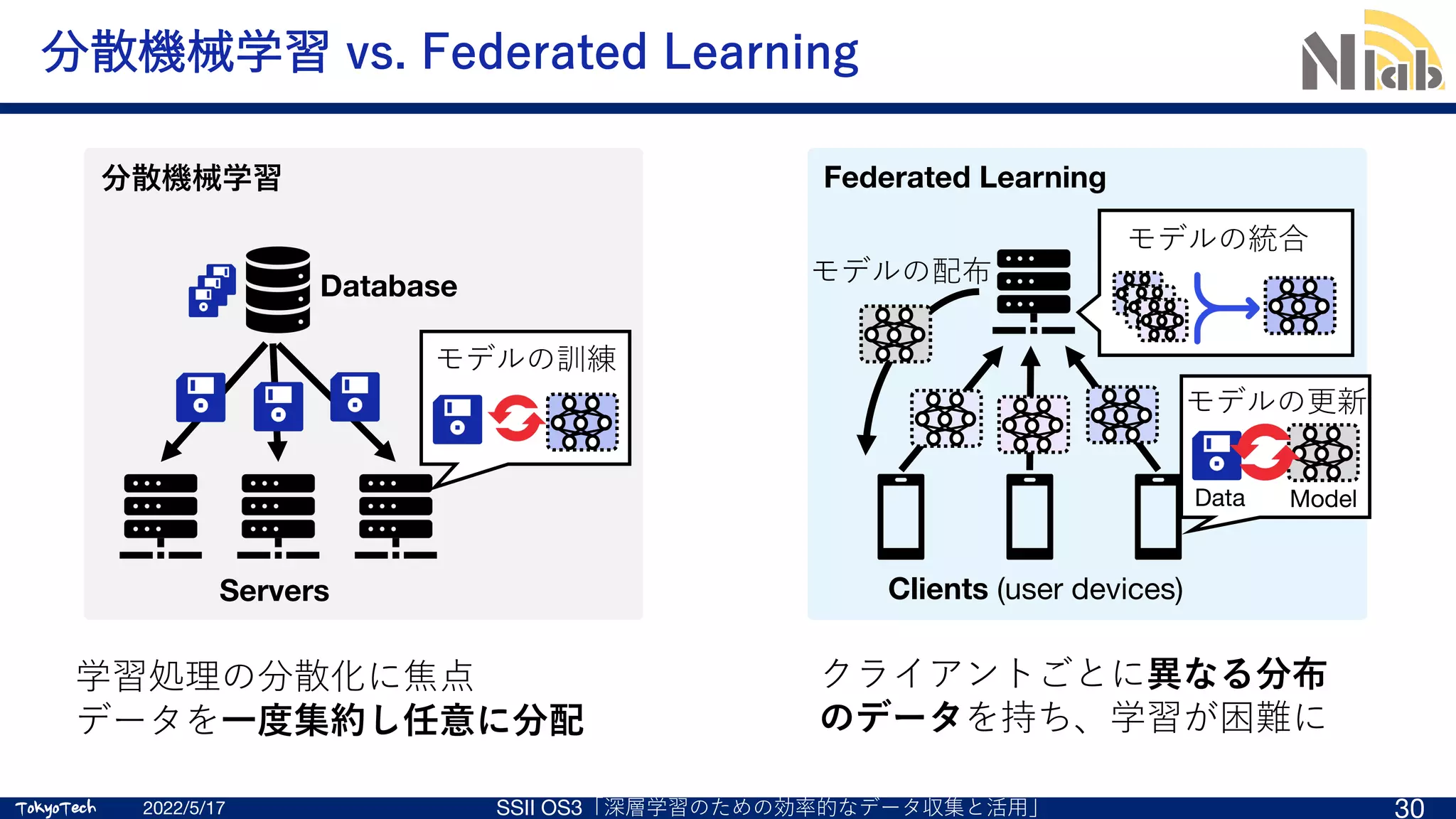

補⾜:シナリオ(主にClientの数や性能)の違い 1/2

2022/5/18 T5: Part1 22

Cross-silo federated learning

Cross-device federated learning

Clients: millions of devices such as

mobile phones and IoT sensors

Clients: small numbers of data silos

such as institutions and factories

Server

Use cases

• Keyboard next-word

prediction [3]

• Emoji prediction [4]

• Speaker recognition [5]

Client: Millions of smart phone

Server

Use case

Oxygen need prediction [6]

Client: 20 hospitals

Silo A

Silo B

Clients](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-13-2048.jpg)

![TokyoTech

TokyoTech

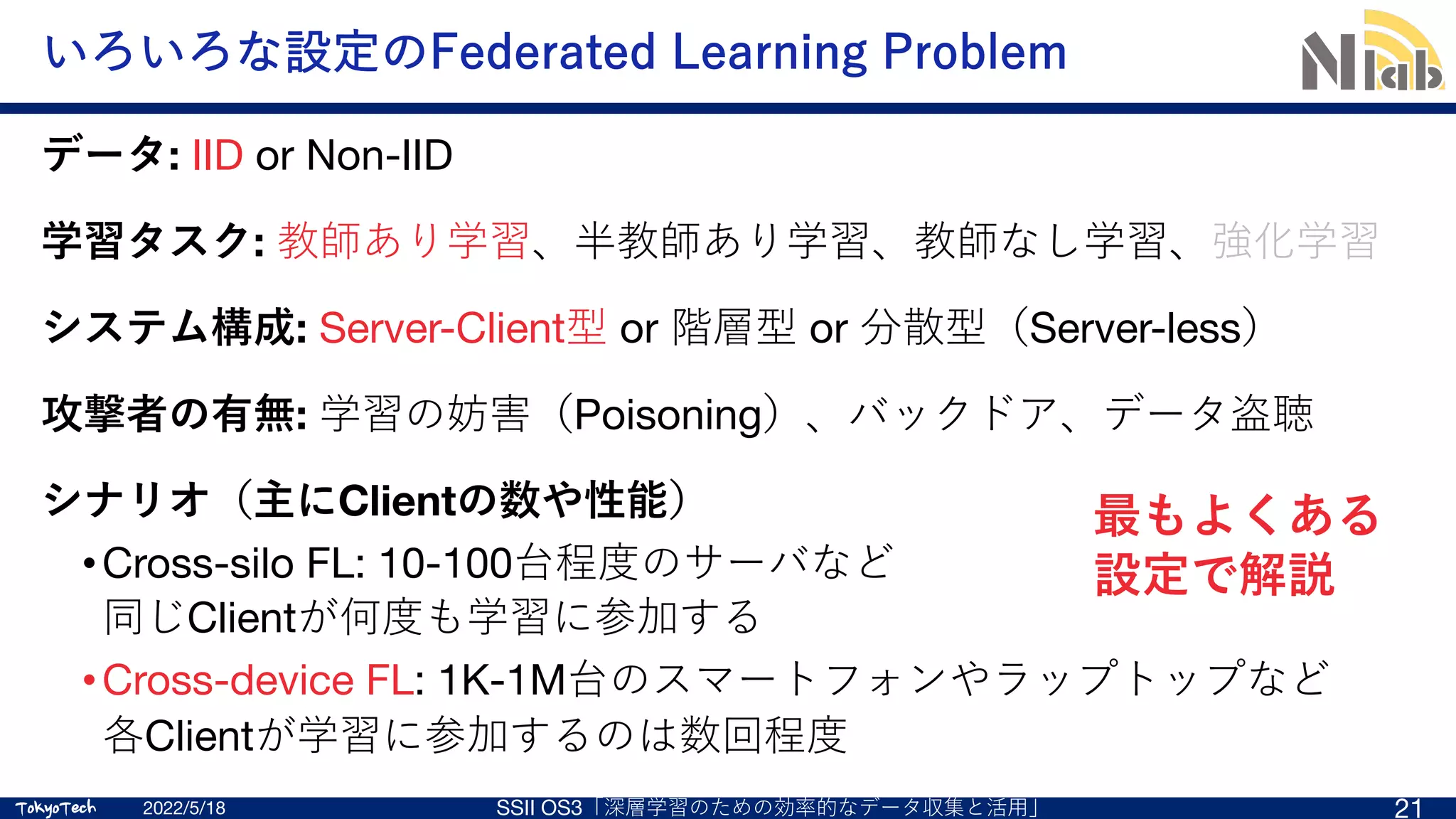

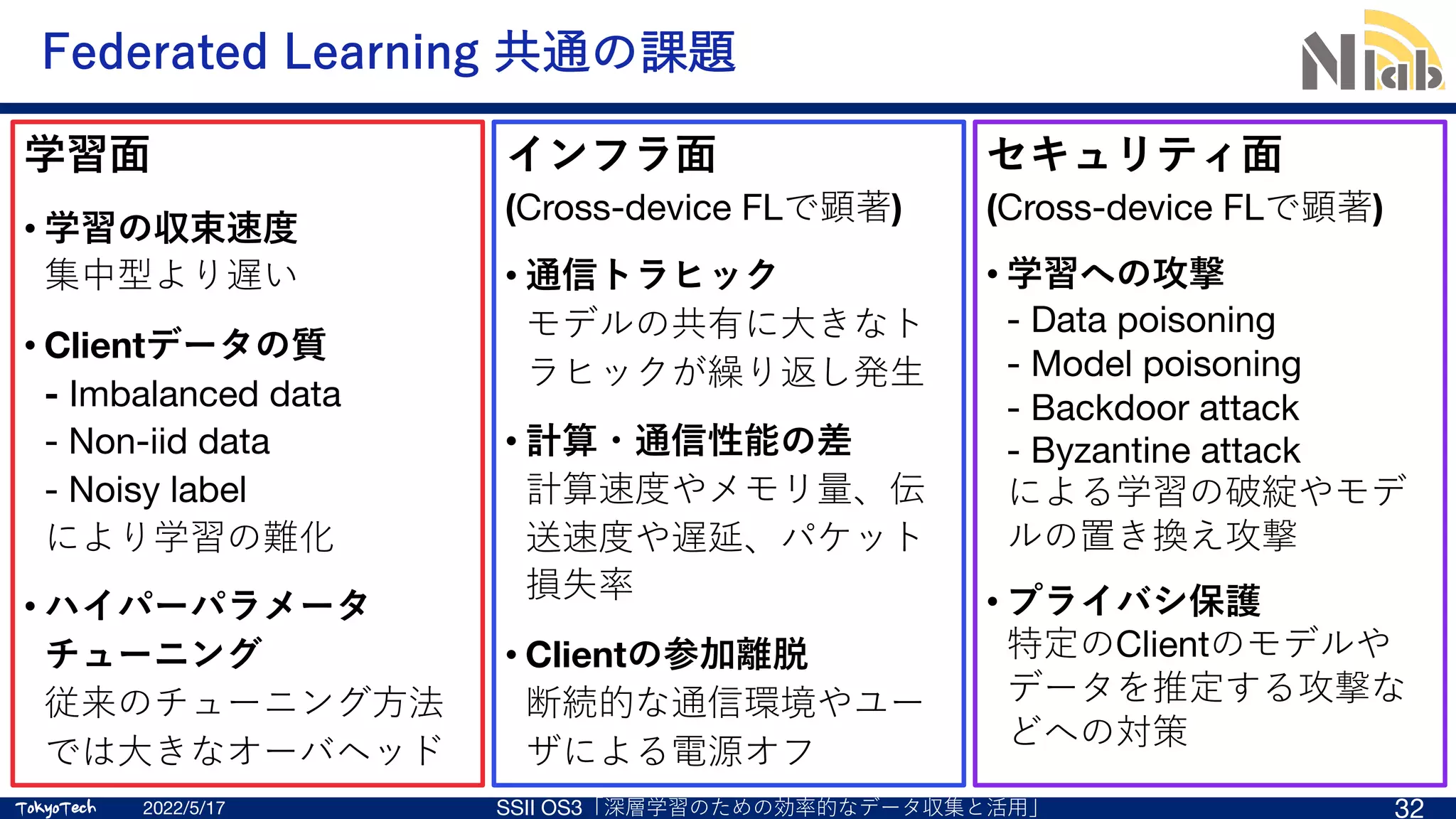

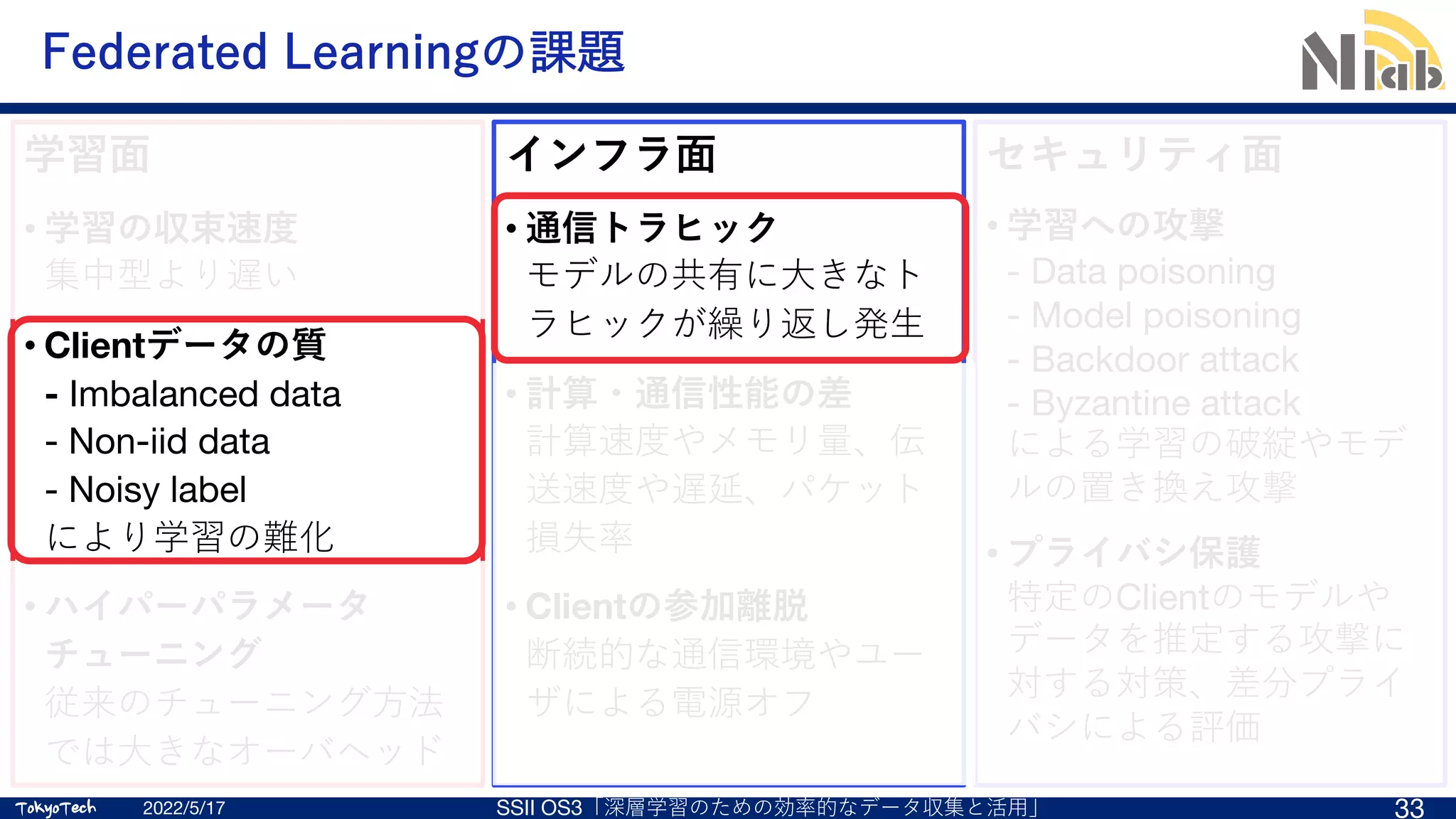

Federated Learningの具体的なアルゴリズム

2022/5/18 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 24

Clients (user devices)

Model

Data

3. モデルの更新

5. モデルの統合

2. モデルの配布

FedAvg (Federated Averaging) [1]

各Clientが訓練したモデルのパラメタ

を収集し、算術平均をとることで⼀つ

のモデルに統合し、学習する⽅式

• Server-Client間でやりとりするのは

モデルだけ

• データはそれを保持するClient⾃⾝

しか参照しない

[1] B. McMahan, et al.,“Communication-efficient learning of deep networks from decentralized data,” Proc. AISTATS, pp. 1273–1282, Apr. 2017.](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-15-2048.jpg)

![TokyoTech

TokyoTech

Federated Learningの具体的なアルゴリズム

1. Client selection: サーバはラウンド(⼀連

の更新⼿順)に参加するClientを選択

2. 選択されたClientにグローバルモデルを配布

3. Local update: Clientは⾃⾝の持つデータを

使って、配布されたモデルを更新する。更

新したモデルはローカルモデルと呼ぶ。

4. ローカルモデルのパラメタをサーバに共有

する

5. Model aggregation: 共有されたパラメタを

平均し、グローバルモデルとする

6. 1~5の⼿順を繰り返す

2022/5/18 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 25

[1] B. McMahan, et al.,“Communication-efficient learning of deep networks from decentralized data,” Proc. AISTATS, pp. 1273–1282, Apr. 2017.

Clients (user devices)

Model

Data

3. モデルの更新

5. モデルの統合

2. モデルの配布](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-16-2048.jpg)

![TokyoTech

TokyoTech

性能評価 (Supplementary PDF of [B. McMahan, et al.,“Communication-efficient learning of deep networks from

decentralized data,” Proc. AISTATS, pp. 1273‒1282, Apr. 2017.])

2022/5/17 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 28

CIFAR-10 (画像分類タスク)

ハイパーパラメータにもよるが、

データを集約した場合と同程度の

精度までモデルを訓練できている](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-18-2048.jpg)

![TokyoTech

TokyoTech

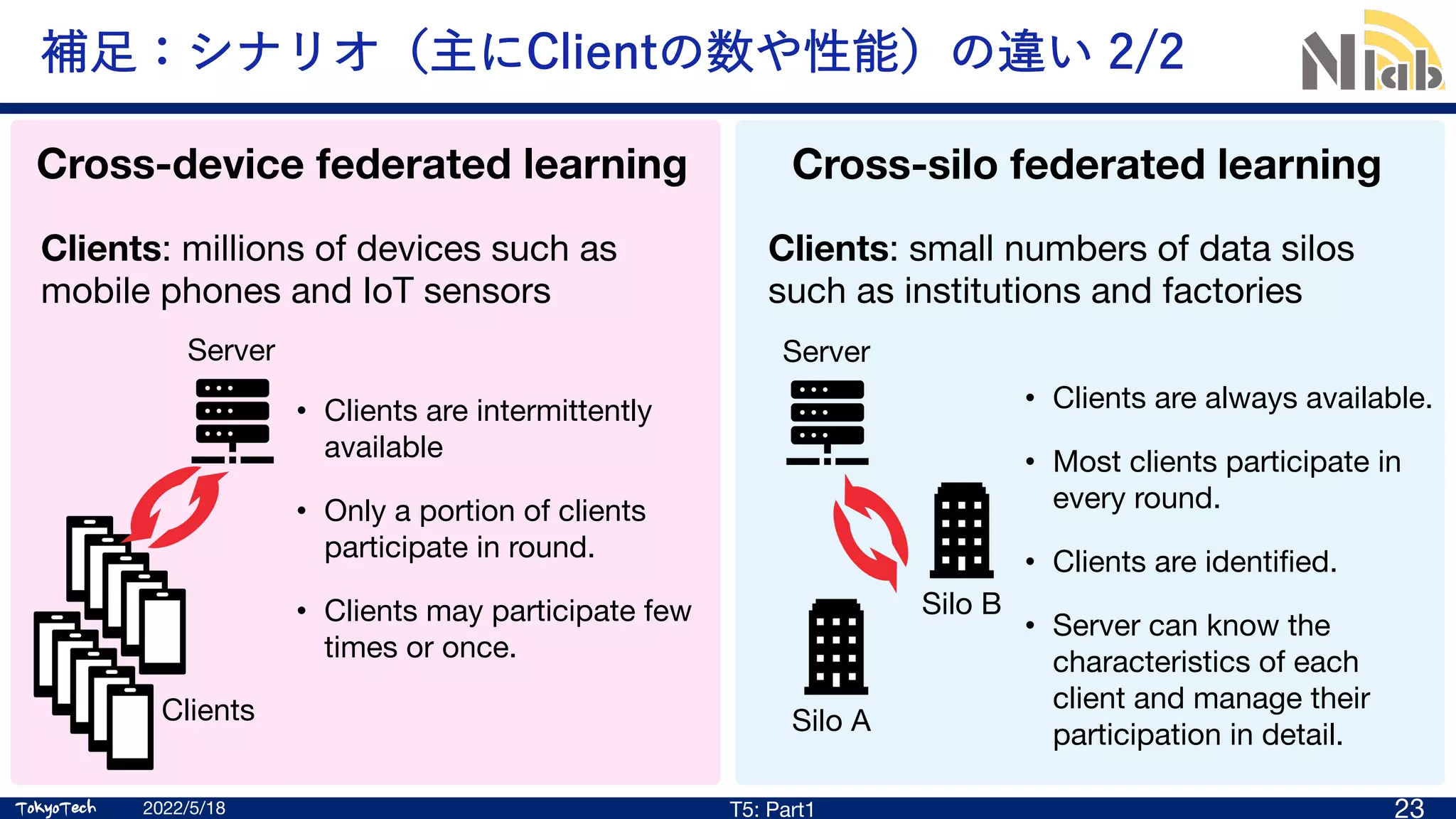

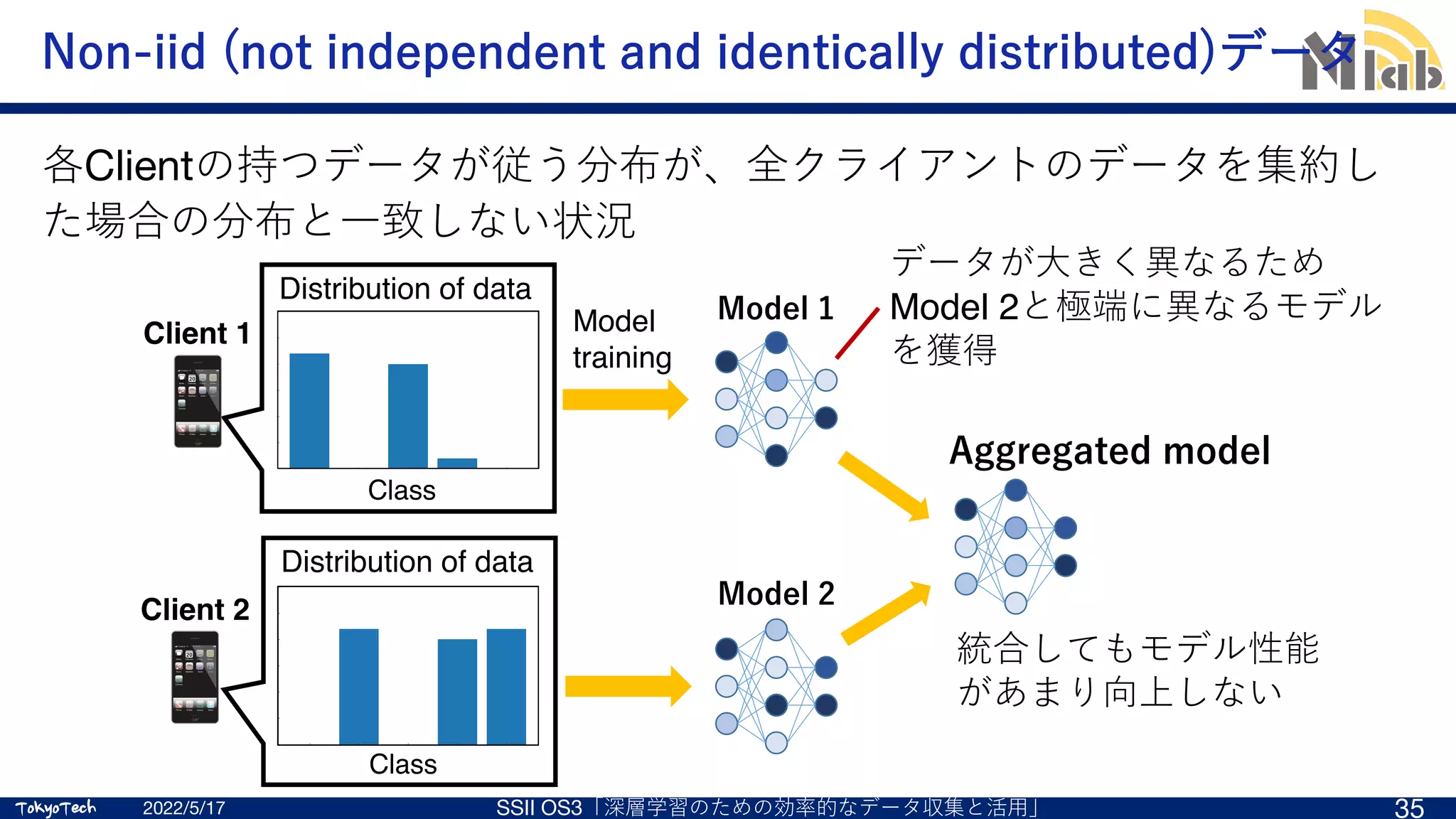

Non-iidデータ 1/2

Local updateの改良

2022/5/17 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 40

SCAFFOLD [N1]

グローバルモデルの更新⽅向を推定

し、その⽅向にローカルモデルが更

新されるよう補正を加える [N1] Karimireddy, Sai Praneeth, et al. "Scaffold: Stochastic

controlled averaging for federated learning." ICML 2020.

引⽤

[N2] Wang, Hao, et al. "Optimizing federated

learning on non-iid data with reinforcement

learning." IEEE INFOCOM, 2020.

Client selectionの改良

FAVOR [N2]

モデル性能の向上に寄与するClient

セット選択戦略を強化学習により学習

引⽤](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-28-2048.jpg)

![TokyoTech

TokyoTech

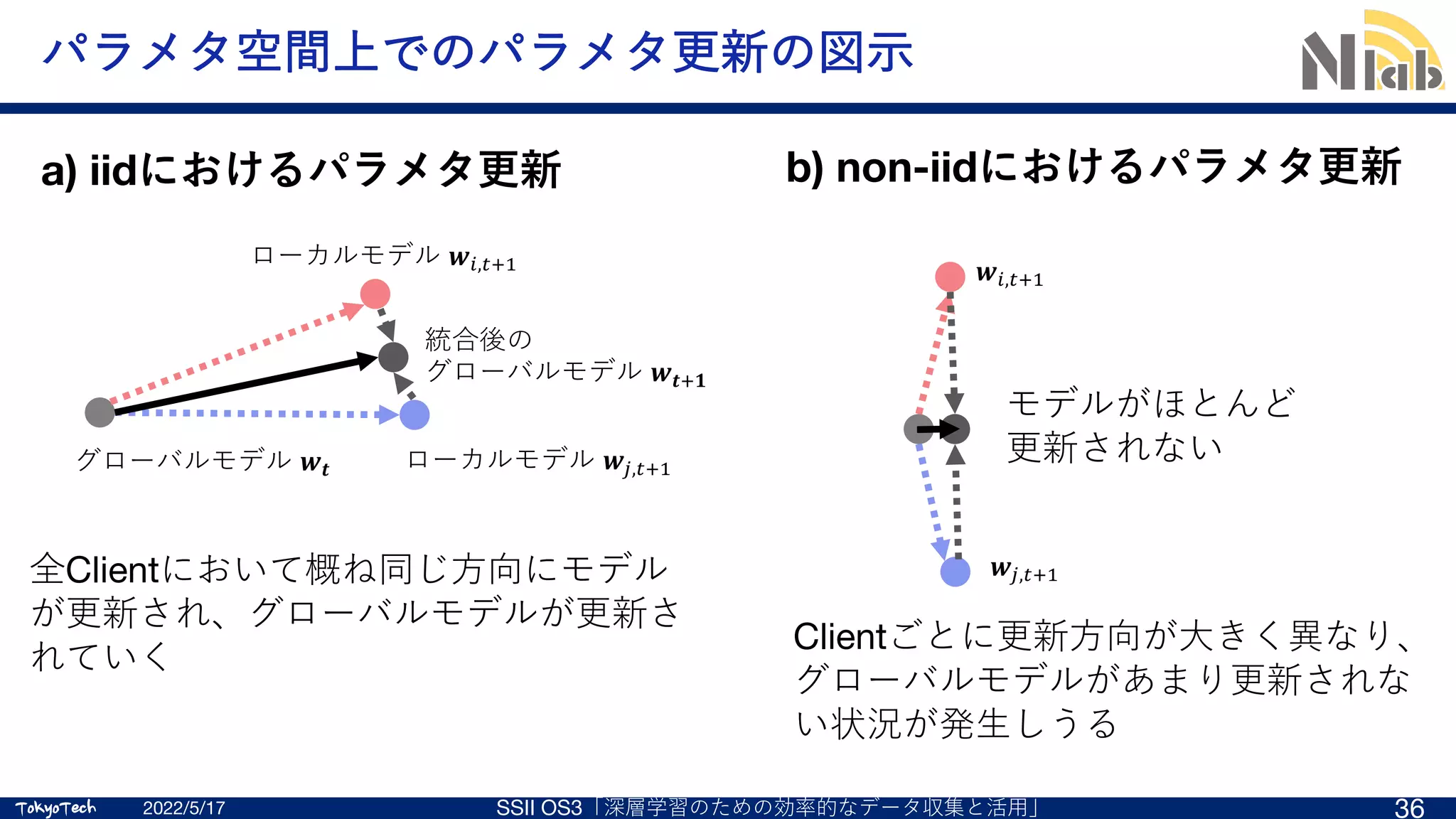

Non-iidデータ 2/2

2022/5/18 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 41

Model aggregationの改良 [N4] H. Wu and P. Wang, “Fast-Convergent

Federated Learning With Adaptive Weighting,”

IEEE Transactions on Cognitive

Communications and Networking, vol. 7, no. 4,

pp. 1078-1088, Dec. 2021.

FedAdp [N4]

Clientの学習への貢献(更新時の勾配をもと

に算出)をもとにAggregation時の重みを調整

少量のIIDデータの活⽤

[N3] N. Yoshida, T. Nishio, et al., "Hybrid-FL for Wireless Networks:

Cooperative Learning Mechanism Using Non-IID Data," IEEE ICC 2020.

Hybrid FL [N3]

極少数 (~1%)のClientはデータのアップロードを許可

アップロードデータでサーバ側にIIDデータセットを

構築し、モデル更新に活⽤

2 4 6 8 10

Mode of r, µ

0.0

0.2

0.4

0.6

0.8

1.0

Accuracy

(a) CIFAR-10.

Centralized model training FedCS

IID

non-IID

2 4 6 8 10

Mode of r, µ

0.0

0.2

0.4

0.6

0.8

1.0

Accuracy

(a) CIFAR-10.

Centralized model training FedCS Hybrid-FL (maxThroughput/minCV)

2 4 6

Mode of r, µ

0.0

0.2

0.4

0.6

0.8

1.0

Accuracy

(b) Fashion MNIST.](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-29-2048.jpg)

![TokyoTech

TokyoTech

Non-iidデータ 2/2

少量のIIDデータの活⽤

2022/5/17 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 42

[N3] N. Yoshida, T. Nishio, et al., "Hybrid-FL for Wireless Networks:

Cooperative Learning Mechanism Using Non-IID Data," IEEE ICC 2020.

Hybrid FL [N3]

極少数 (~1%)のClientはデータのアップロードを許可

アップロードデータでサーバ側にIIDデータセットを構築し、モデル更新に活⽤

2 4 6 8 10

Mode of r, µ

0.0

0.2

0.4

0.6

0.8

1.0

Accuracy

(a) CIFAR-10.

Centralized model training FedCS Hybrid-FL (maxThroughput/minCV)

2 4 6 8 10

Mode of r, µ

0.0

0.2

0.4

0.6

0.8

1.0

Accuracy

(b) Fashion MNIST.

IID

non-IID IID

non-IID](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-30-2048.jpg)

![TokyoTech

TokyoTech

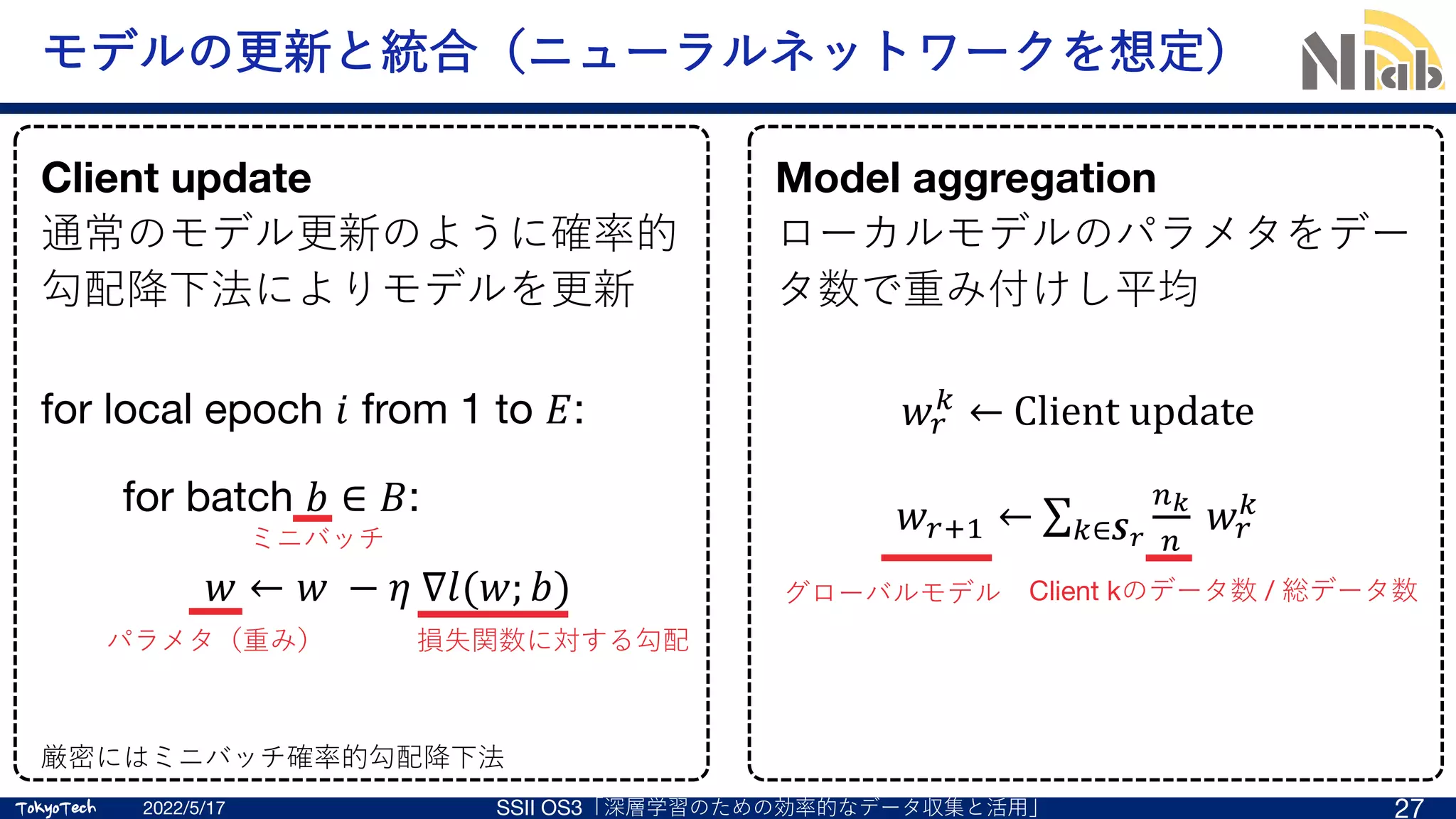

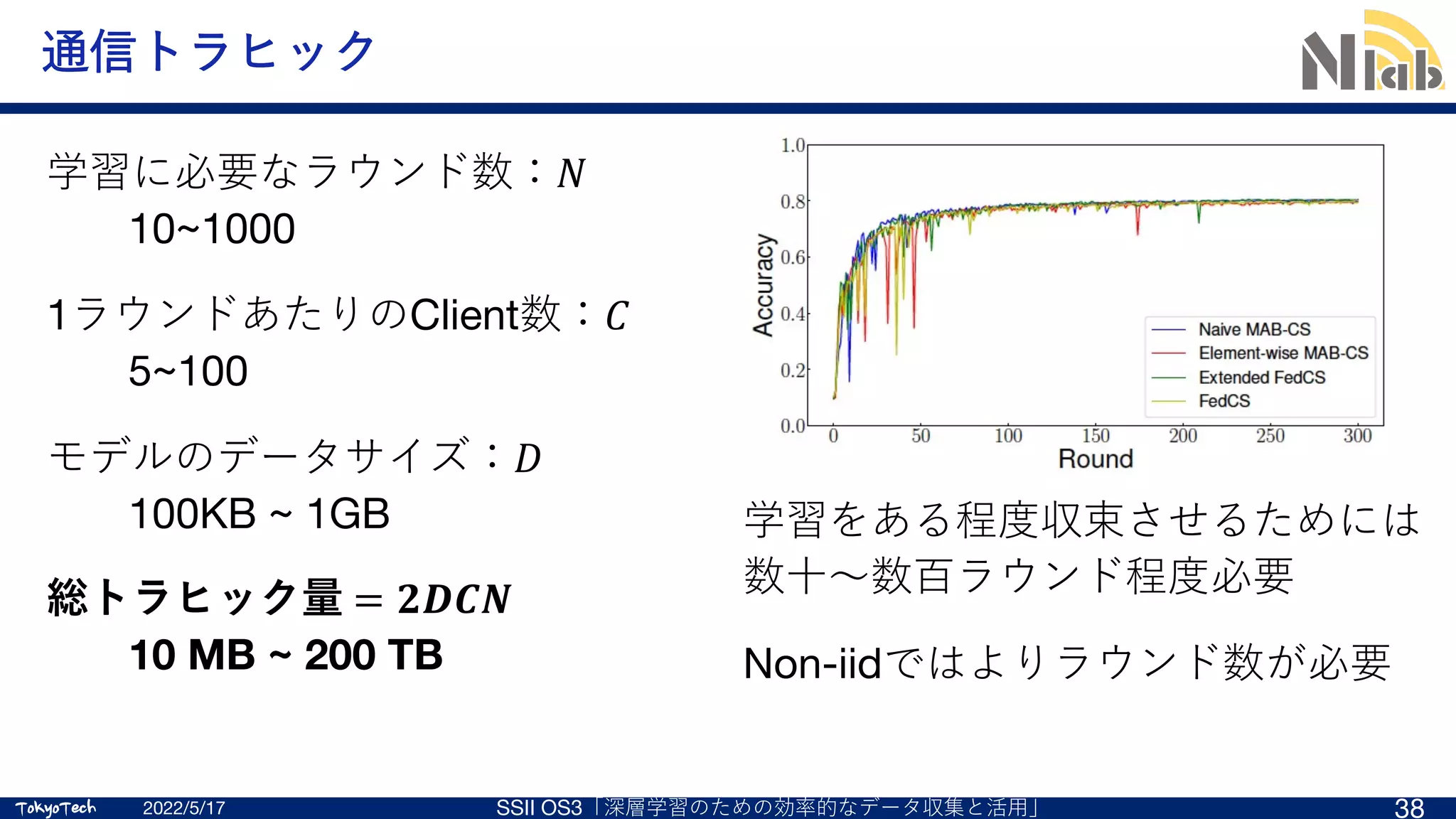

通信トラヒック削減

モデルの圧縮

巨⼤なニューラルネットワークに対し、

パラメタの量⼦化、枝刈り、パラメタの少ないモデルに

置き換え等を⾏い、モデルのデータサイズを⼩さくする。

2022/5/17 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 43

空中計算

1

3

3+1=4

空中計算

データをアナログ振幅変調し、多数のClientが同時送信するこ

とで、電波の重畳現象により受信振幅値から総和を求める⼿法

モデル統合に応⽤することで、送信局の数が⾮常に多い場合に

チャネル専有時間が削減される

スパース化

モデルを共有しない学習⽅法: Distillation-based Federated Learning

[C2] K. Yang et al., "Federated learning via over-the-air computation."

IEEE Trans. Wireless Commun. 2020.

[C1] F. Haddadpour, et al., "Federated learning with compression: Unified

analysis and sharp guarantees." AISTATS 2021.](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-31-2048.jpg)

![TokyoTech

TokyoTech

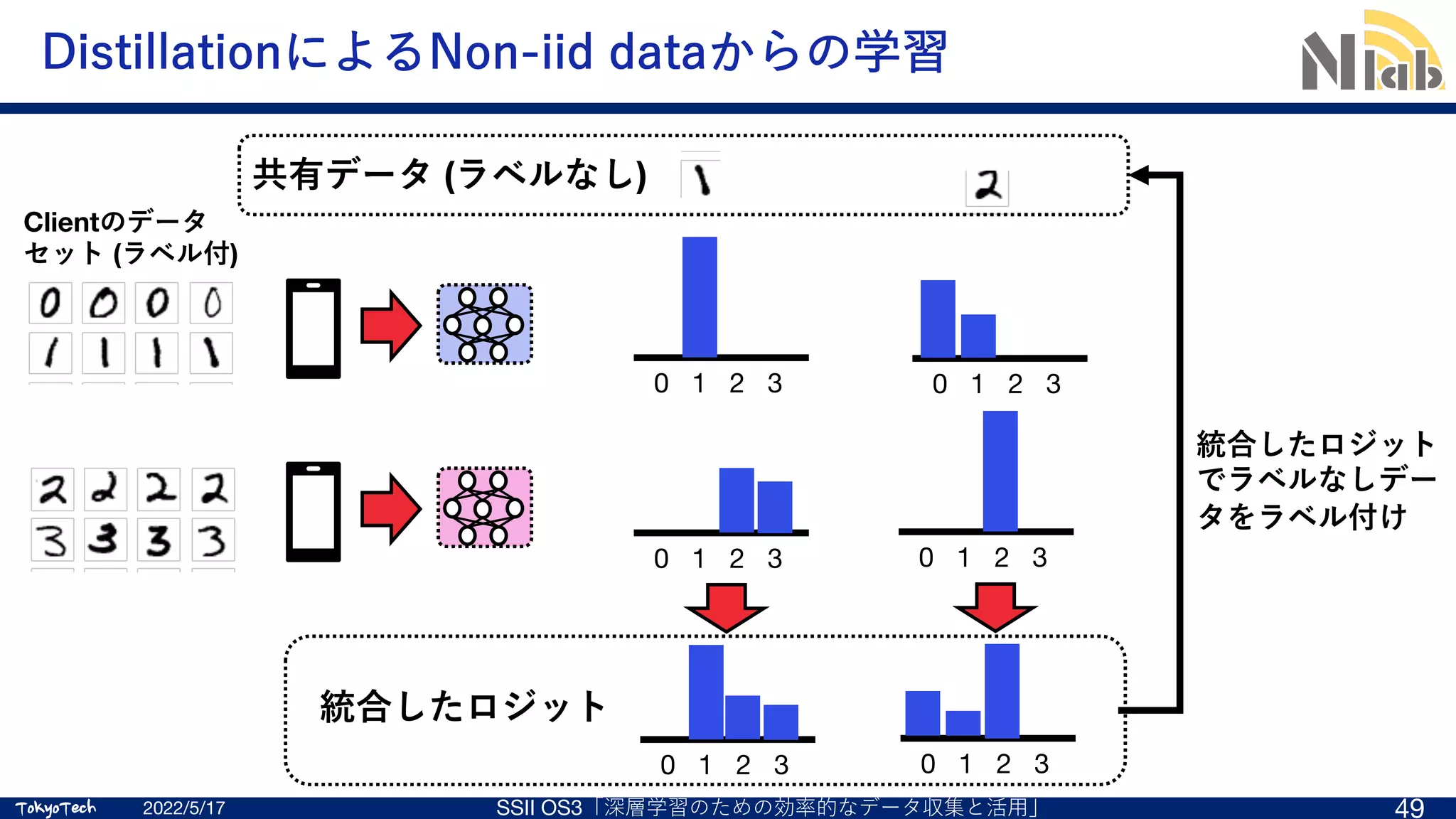

Distillation based Semi-Supervised Federated Learning (DS-FL) [A]

[A] S. Itahara, T. Nishio, et al.,, “Distillation-Based Semi-Supervised Federated Learning for Communication-Efficient Collaborative Training with Non-IID Private Data,”

IEEE Trans. Mobile Compt.

2022/5/17 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 44

Distillation (蒸留)

モデルの出⼒であるロジットを⽤いた学習⽅式

モデルの代わりにサイズの⼩さいロジットを⽤いることでトラヒック

を⼤幅に削減

Semi-supervised learning (半教師あり学習)

ラベル付きデータに加えて、ラベルなしデータも活⽤する機械学習

従来はモデルの汎化性能向上に⽤いられることが多い

本⽅式ではDistillationをFLに組み込むために活⽤

通信トラヒックを⼤幅削減可能(FedAvgの1/50)な学習⼿法](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-32-2048.jpg)

![TokyoTech

TokyoTech

DS-FLと従来⼿法(FedAvg)の⽐較

[A] S. Itahara, T. Nishio, et al.,, “Distillation-Based Semi-Supervised Federated Learning for Communication-Efficient Collaborative Training with Non-IID Private Data,” IEEE Trans. Mobile Compt.

2022/5/17 SSII OS3「深層学習のための効率的なデータ収集と活⽤」 46

データサイズの⼤きいモデルを何度も

共有するため⼤きなトラヒックが発⽣

Clients (user devices)

Model

Data

モデルの更新

出⼒統合とモデル訓練

Model Logit

モデルの出⼒

提案⼿法

Clients (user devices)

Model

Data

モデルの更新

モデルの統合

モデルの配布

従来のFL

モデルの出⼒情報を⽤いて学習するこ

とで学習時のトラヒックを⼤幅に削減](https://image.slidesharecdn.com/ssii2022-os3-02-220607020834-2b5f93ff/75/SSII2022-OS3-02-Federated-Learning-33-2048.jpg)