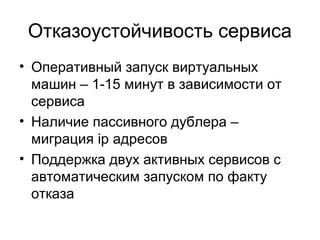

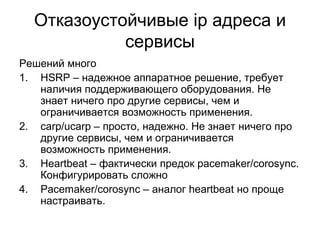

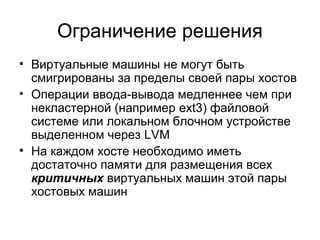

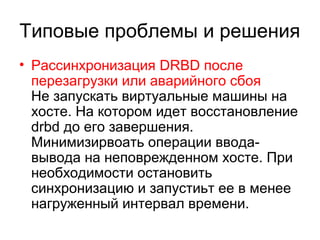

Доклад Виталия Гаврилова посвящен созданию отказоустойчивого микрокластера с помощью попарно соединенных физических серверов, описывая ключевые технологии и методы, такие как 'живая' миграция виртуальных машин и использование решений на базе corosync/pacemaker. Он включает детальную настройку сетевых интерфейсов, дискового пространства и файловой системы, а также методы мониторинга и автоматизации запуска виртуальных машин. Заключение подчеркивает преимущества и ограничения, связанные с отказоустойчивыми инфраструктурами.

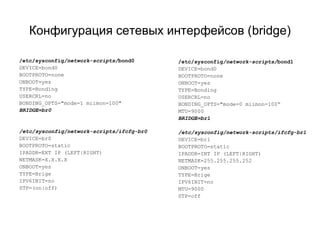

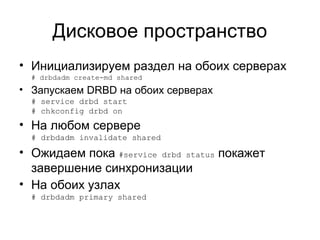

![Конфигурация сетевых интерфейсов (bonding)

/etc/sysconfig/network-scripts/eth[0-1]

DEVICE="eth[0-1]"

BOOTPROTO="static"

HWADDR=“XX:XX:XX:XX:XX:XX"

NM_CONTROLLED="no"

ONBOOT="yes"

MASTER=bond0

SLAVE=yes

TYPE="Ethernet"

/etc/sysconfig/network-scripts/bond0

DEVICE=bond0

BOOTPROTO=none

ONBOOT=yes

IPADDR=EXT IP (LEFT|RIGHT)

NETMASK=X.X.X.X

TYPE=Bonding

USERCRL=no

BONDING_OPTS="mode=1 miimon=100"

/etc/sysconfig/network-scripts/eth[2-3]

DEVICE="eth[2-3]"

BOOTPROTO="static"

HWADDR=“XX:XX:XX:XX:XX:XX"

NM_CONTROLLED="no"

ONBOOT="yes"

MASTER=bond1

SLAVE=yes

MTU=9000

TYPE="Ethernet“

/etc/sysconfig/network-scripts/bond1

DEVICE=bond0

BOOTPROTO=none

ONBOOT=yes

IPADDR=INT IP (LEFT|RIGHT)

NETMASK=255.255.255.252

TYPE=Bonding

USERCRL=no

MTU=9000

BONDING_OPTS="mode=0 miimon=100"](https://image.slidesharecdn.com/random-141111101912-conversion-gate02/85/slide-10-320.jpg)