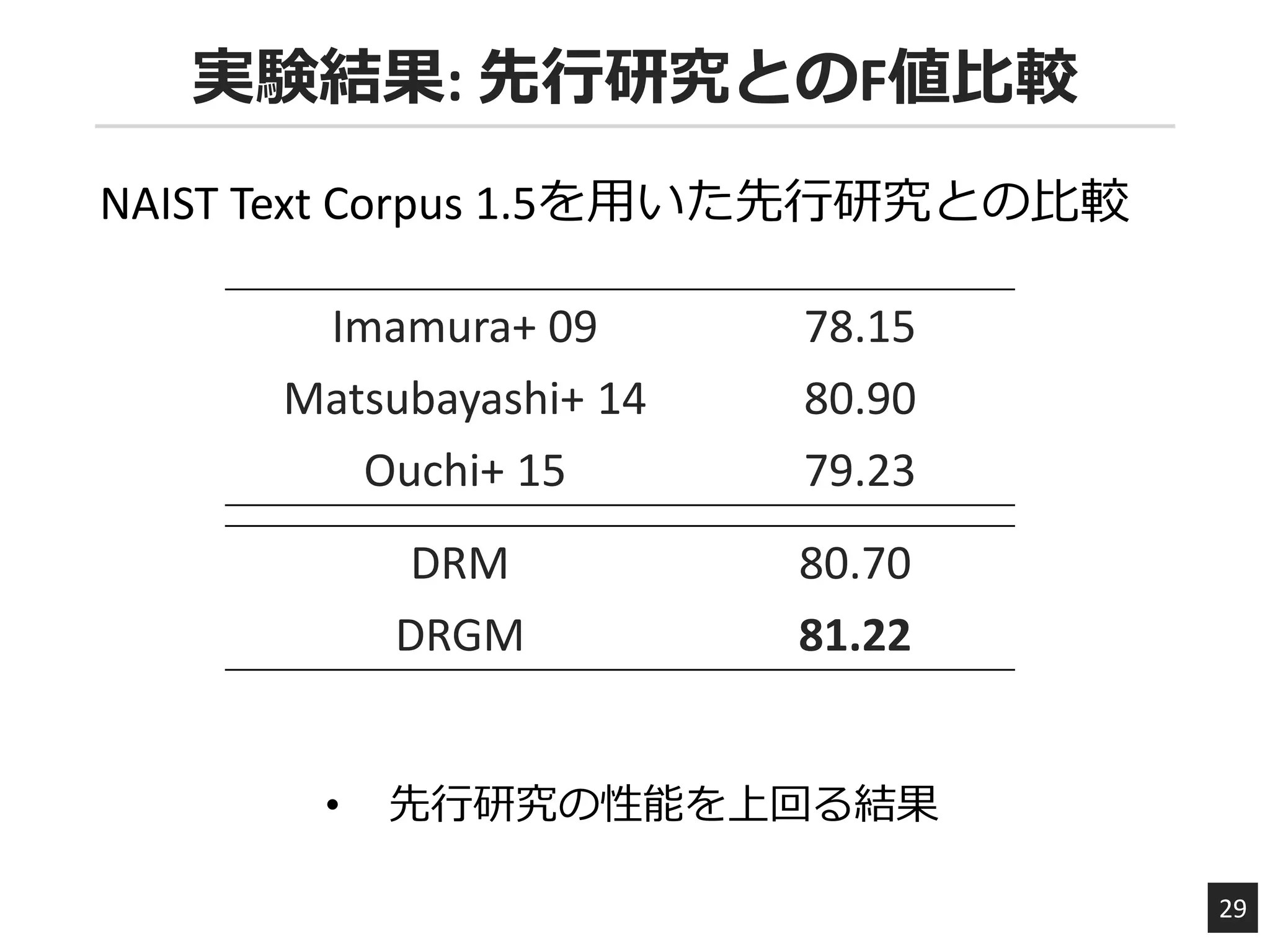

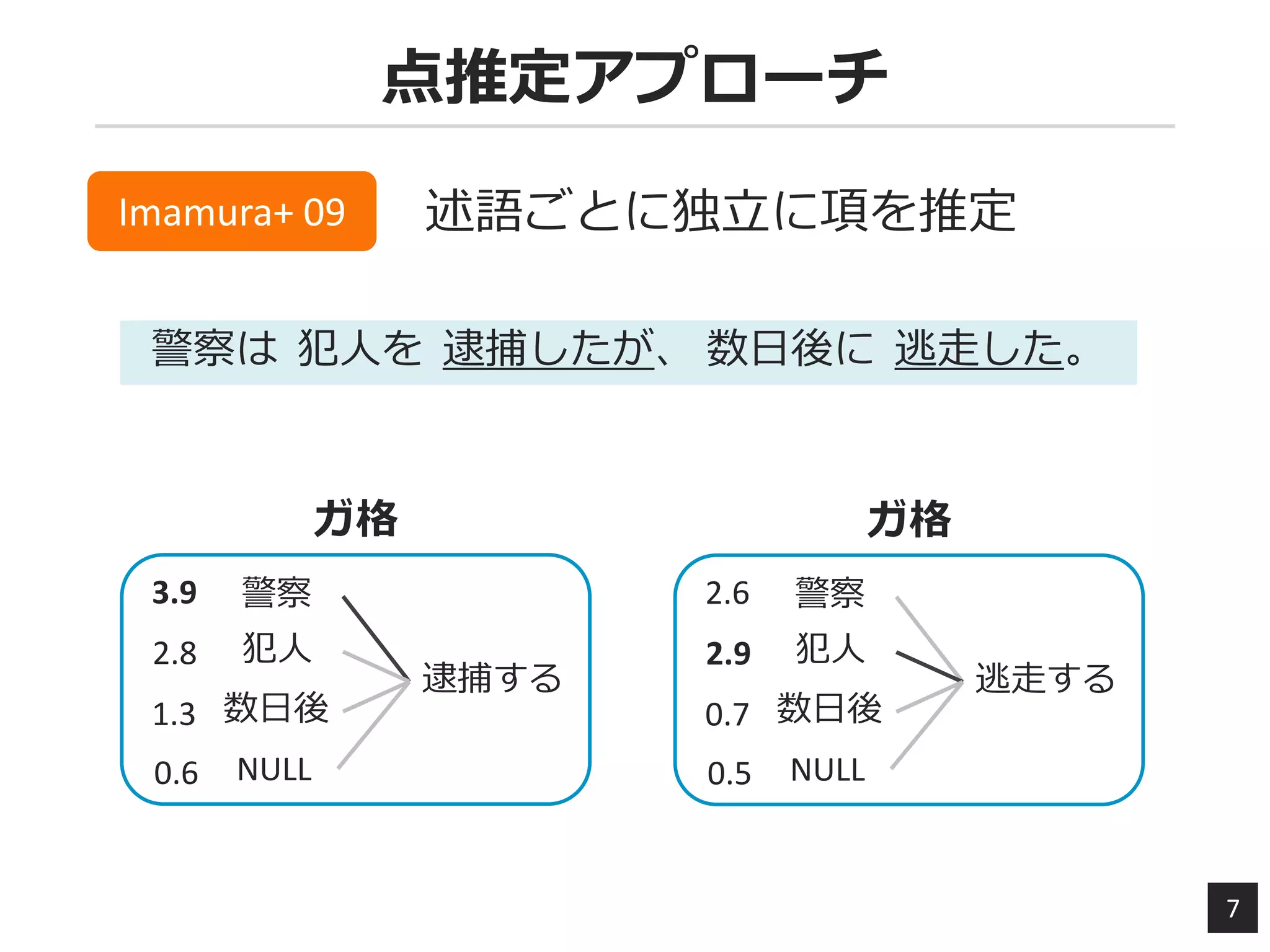

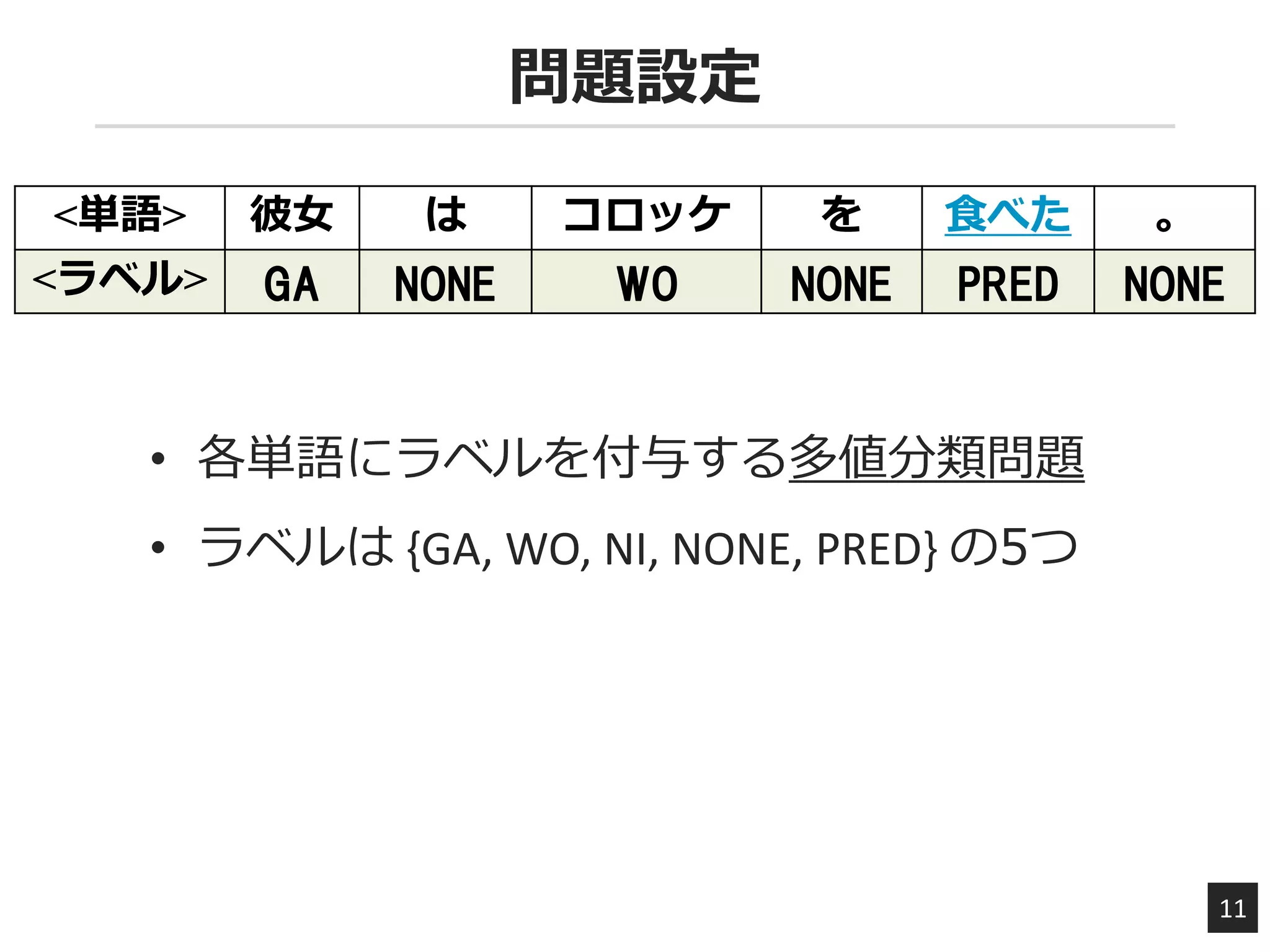

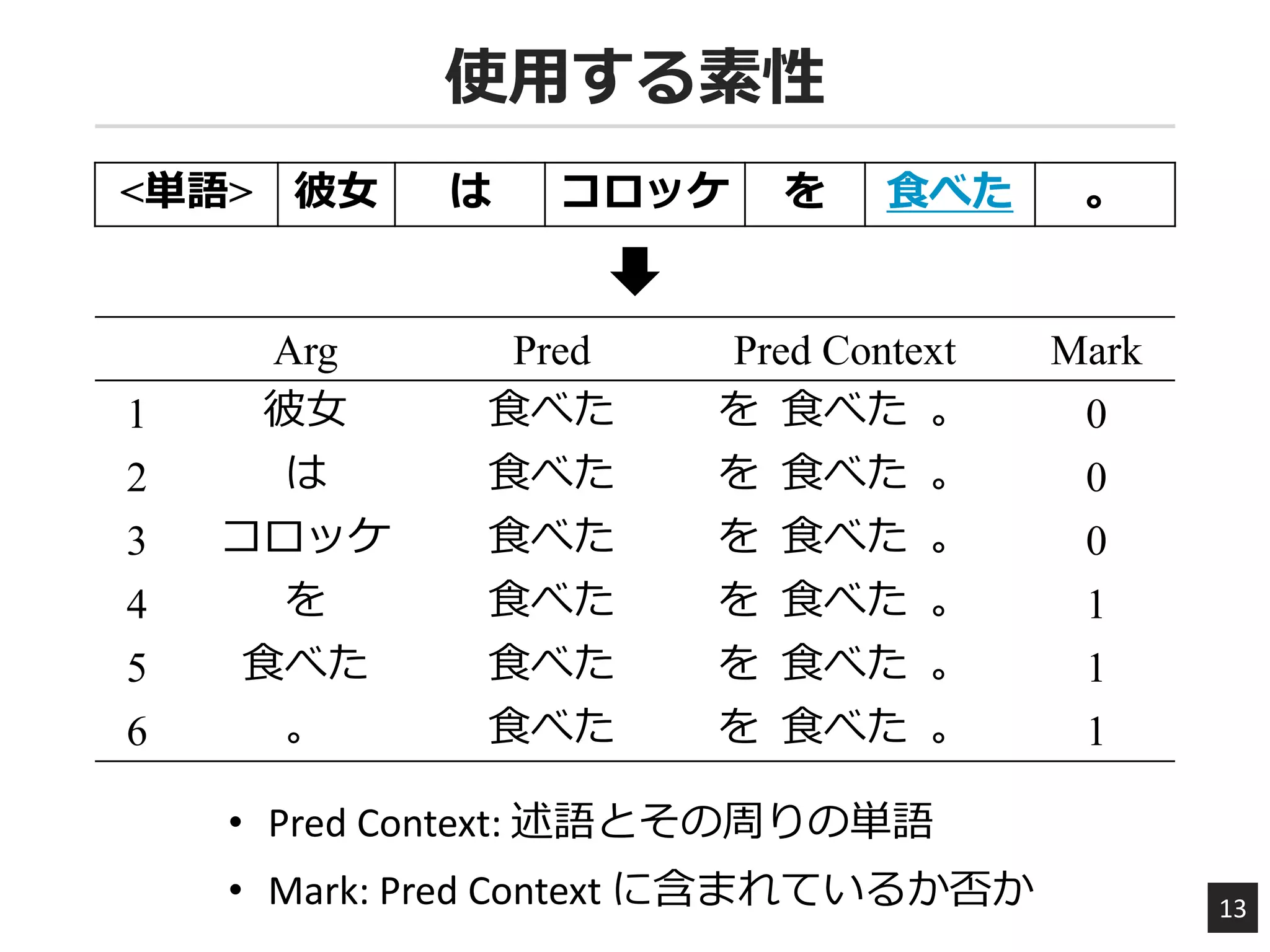

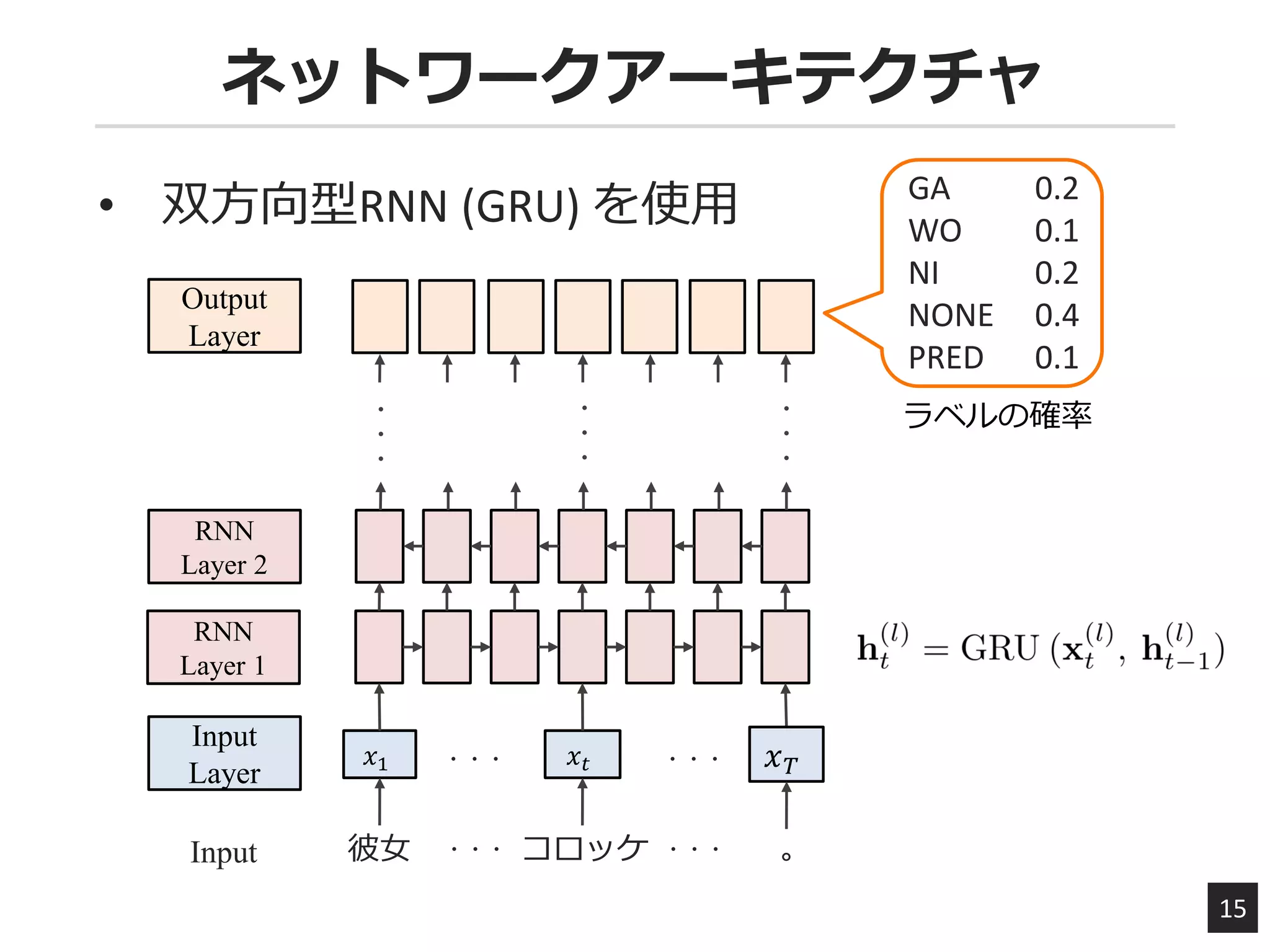

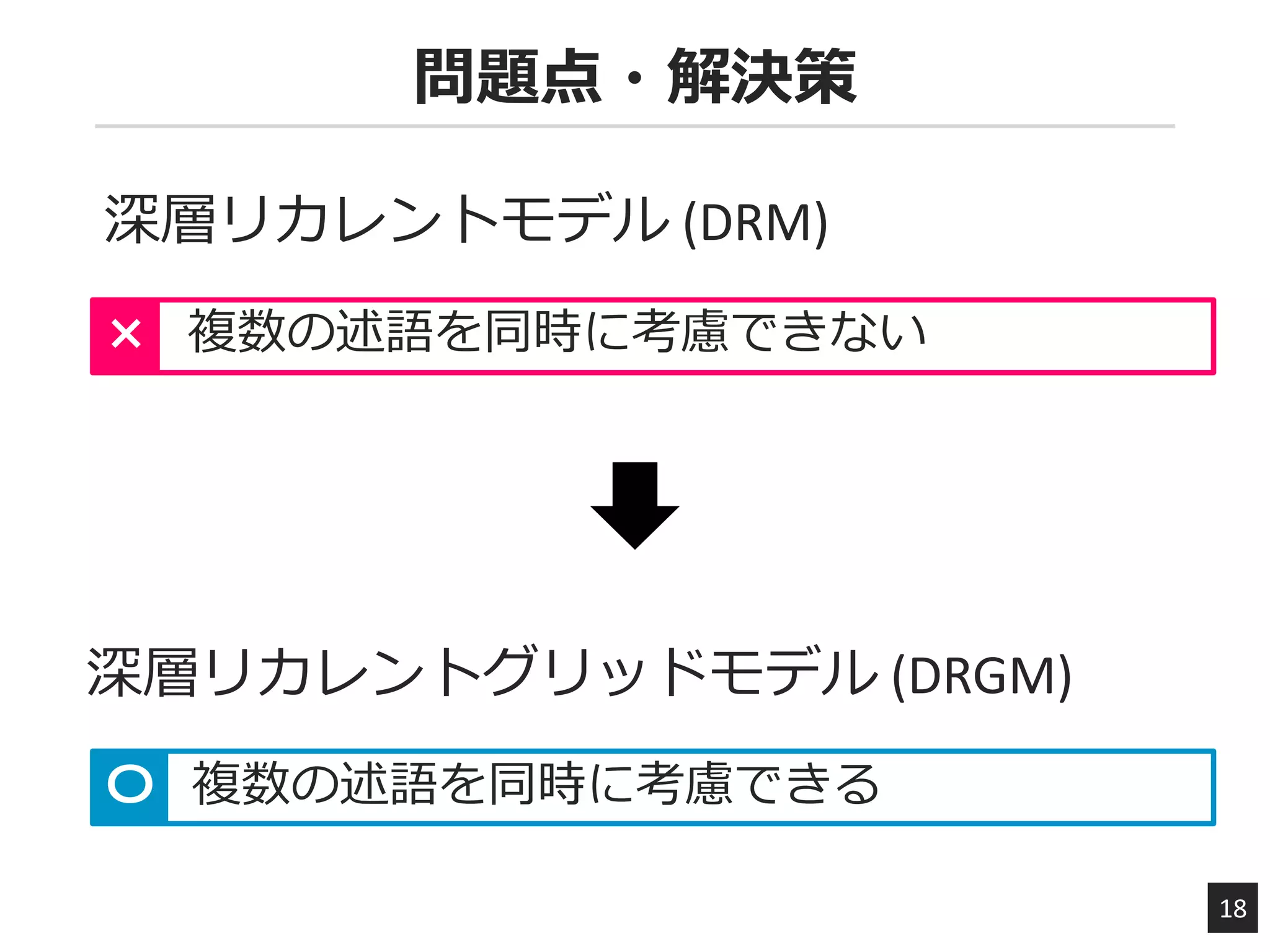

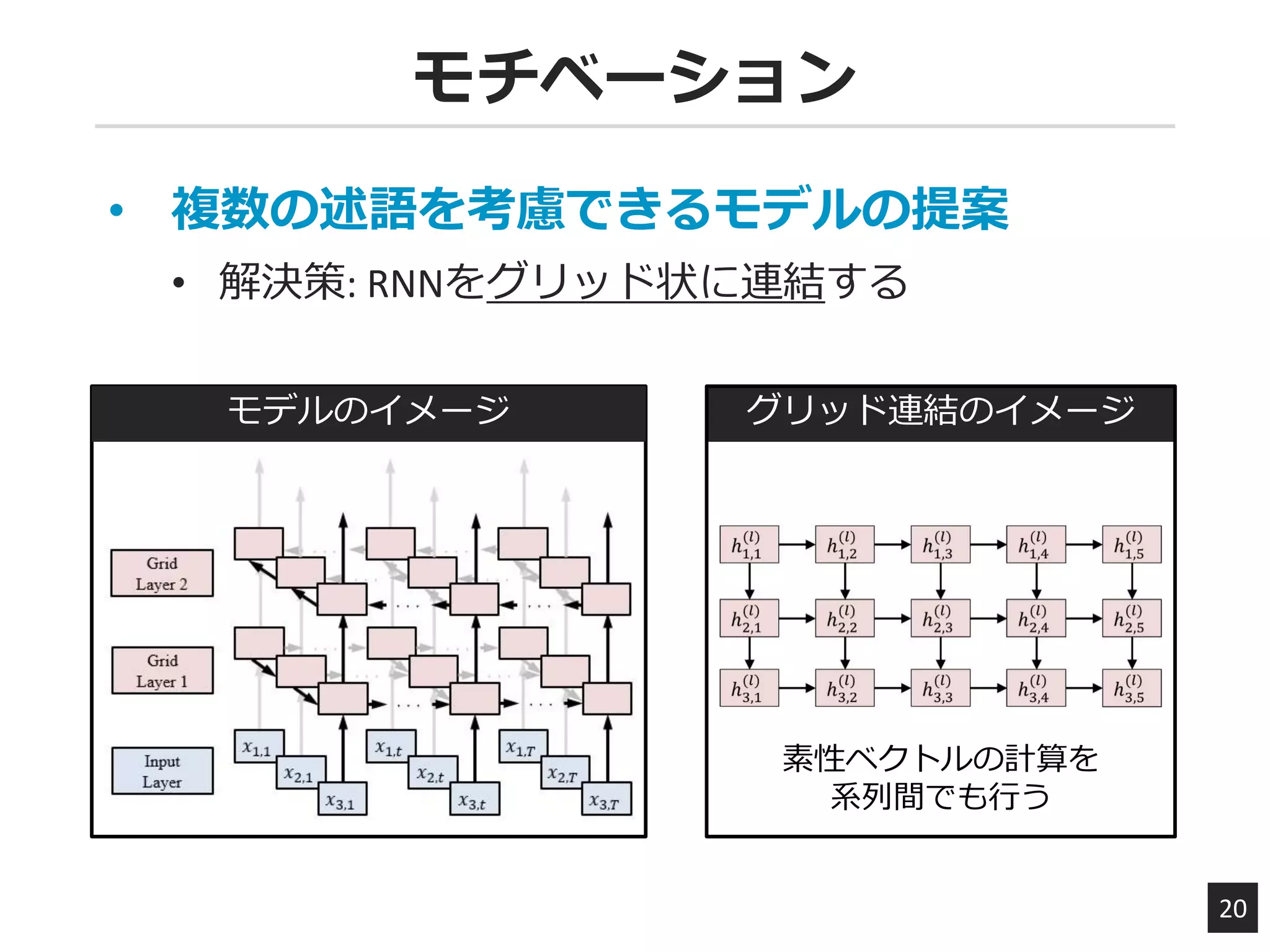

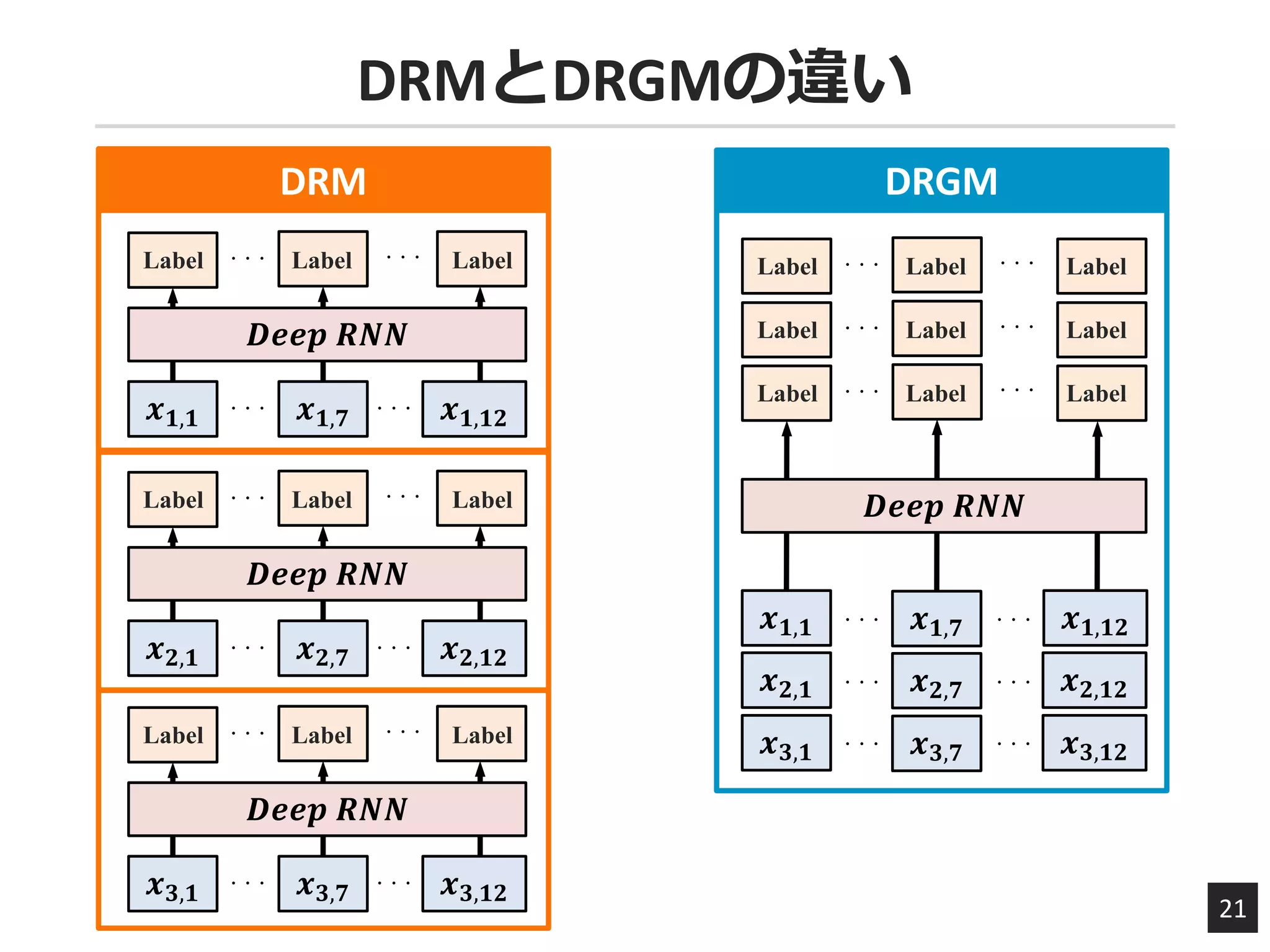

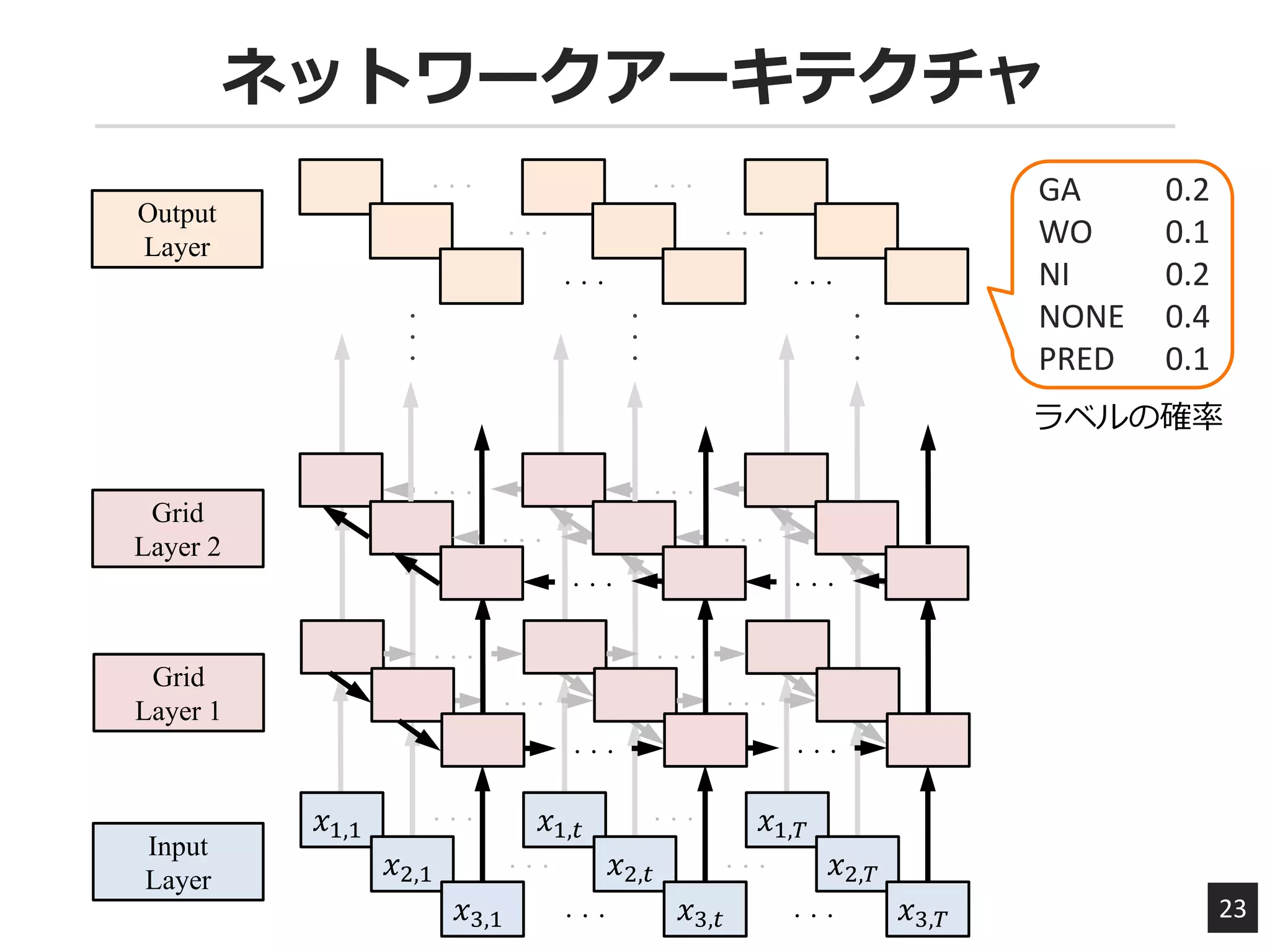

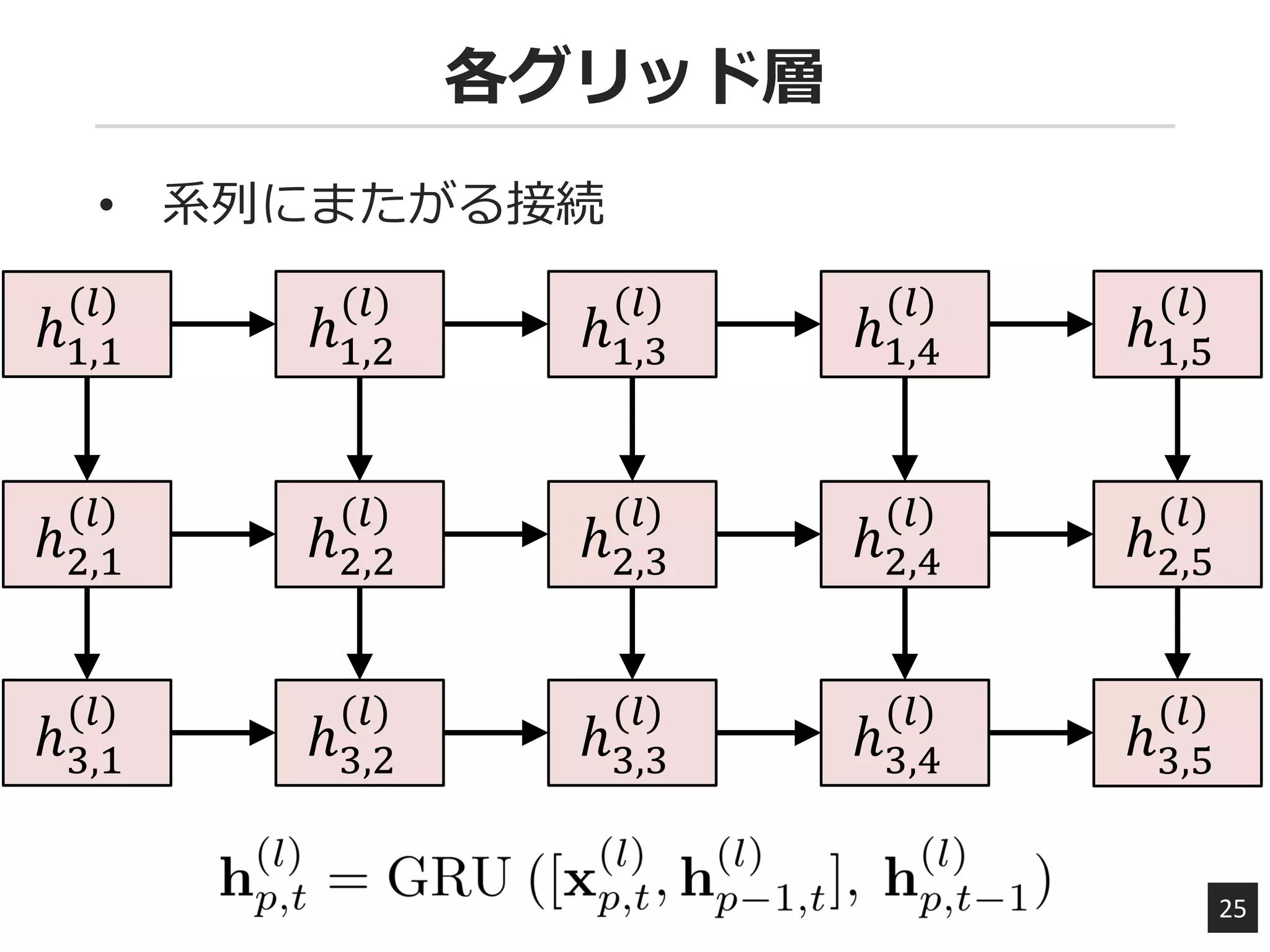

既存の日本語述語項構造解析では,形態素解析や構文解析を行い,それらの情報に基づいて各述語の項を予測していた.しかし,パイプライン処理に起因する誤り伝搬や,人手による素性設計コストの上昇などが問題点となっている.本研究では,深層リカレントニューラルネットワークを利用し,単語などの表層情報のみを用いて述語項構造解析を行う手法を提案する. また,複数の述語を同時に考慮して述語構造解析の精度を向上させるために,述語ごとのモデルをグリッド上に連結した深層リカレントグリッドモデルを提案する.NAIST テキストコーパスを用いた実験の結果,これまでに報告されている最先端の日本語述語項構造解析器の精度を上回ることを確認した.

![実験設定

27

データセット

NAIST Text Corpus Ver. 1.5

訓練 25,000

開発 5,000

評価 9,000

実装

ライブラリ: Theano

ハイパーパラメータ

単語/隠れ層の次元: 32次元, ランダム初期化

最適化手法: Adam

L2正則化: [0.0001, 0.0005, 0.001]](https://image.slidesharecdn.com/2016-1222nluploaded-161226015836/75/slide-27-2048.jpg)