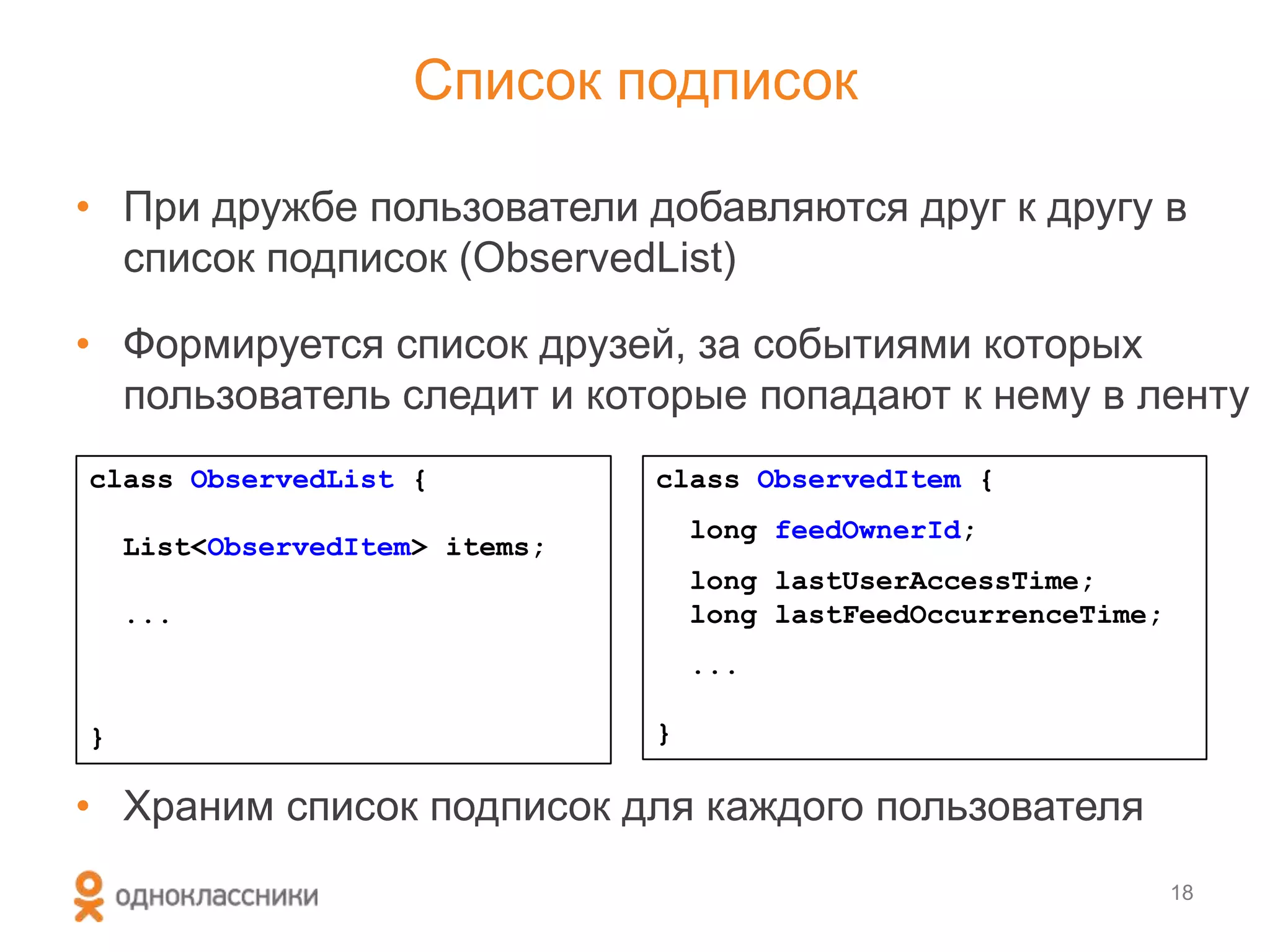

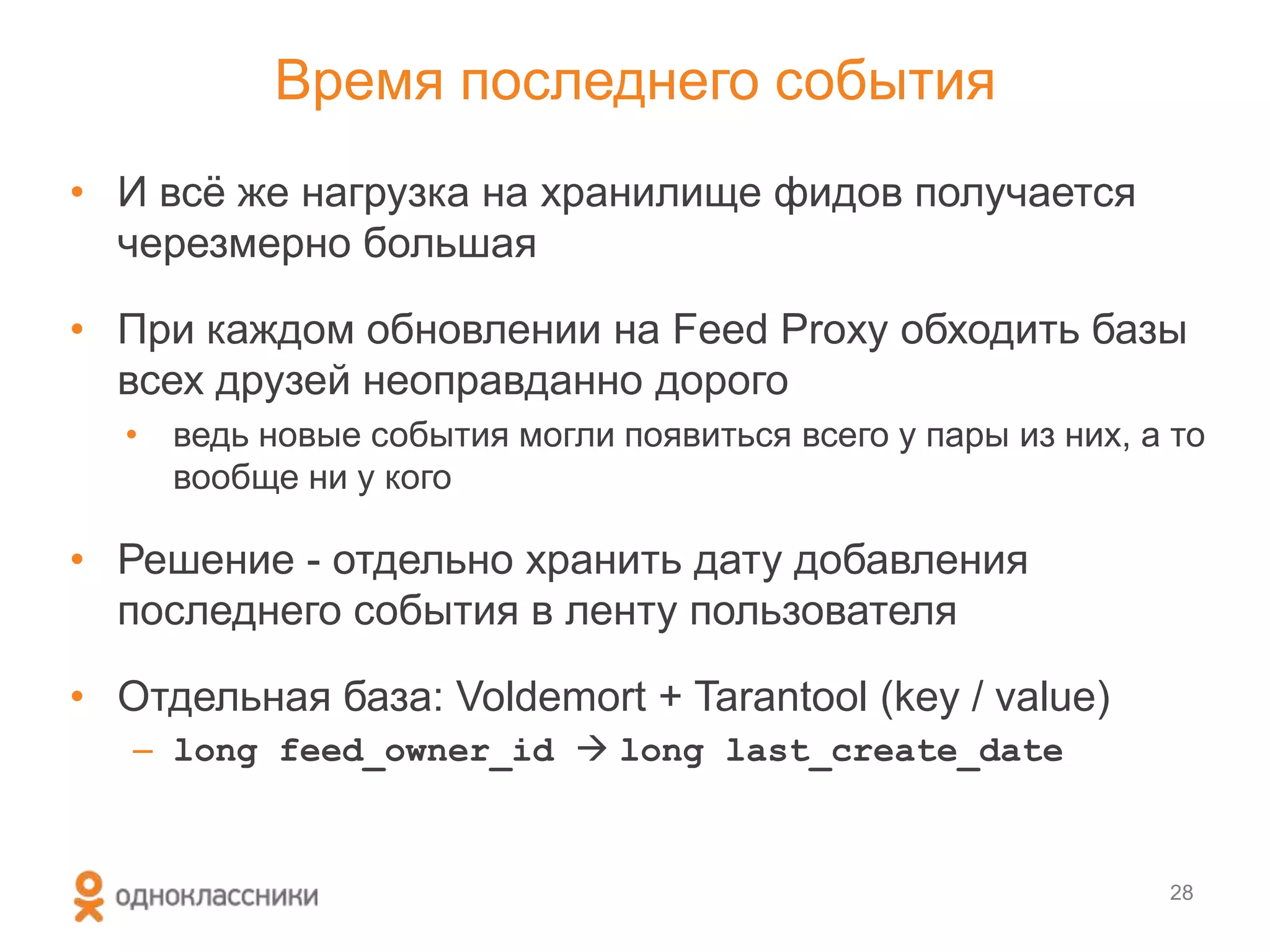

Документ описывает архитектуру ленты событий на портале Одноклассники, включая различные аспекты хранения и обработки данных пользователей, их подписок и событий. Основное внимание уделяется проблемам, связанным с высокой нагрузкой, и решениям, включая использование технологий хранения данных типа Cassandra и кеширования для обеспечения высокой доступности и производительности. Также рассматриваются алгоритмы сбора и сортировки событий, а также методы приоритизации для улучшения пользовательского опыта.

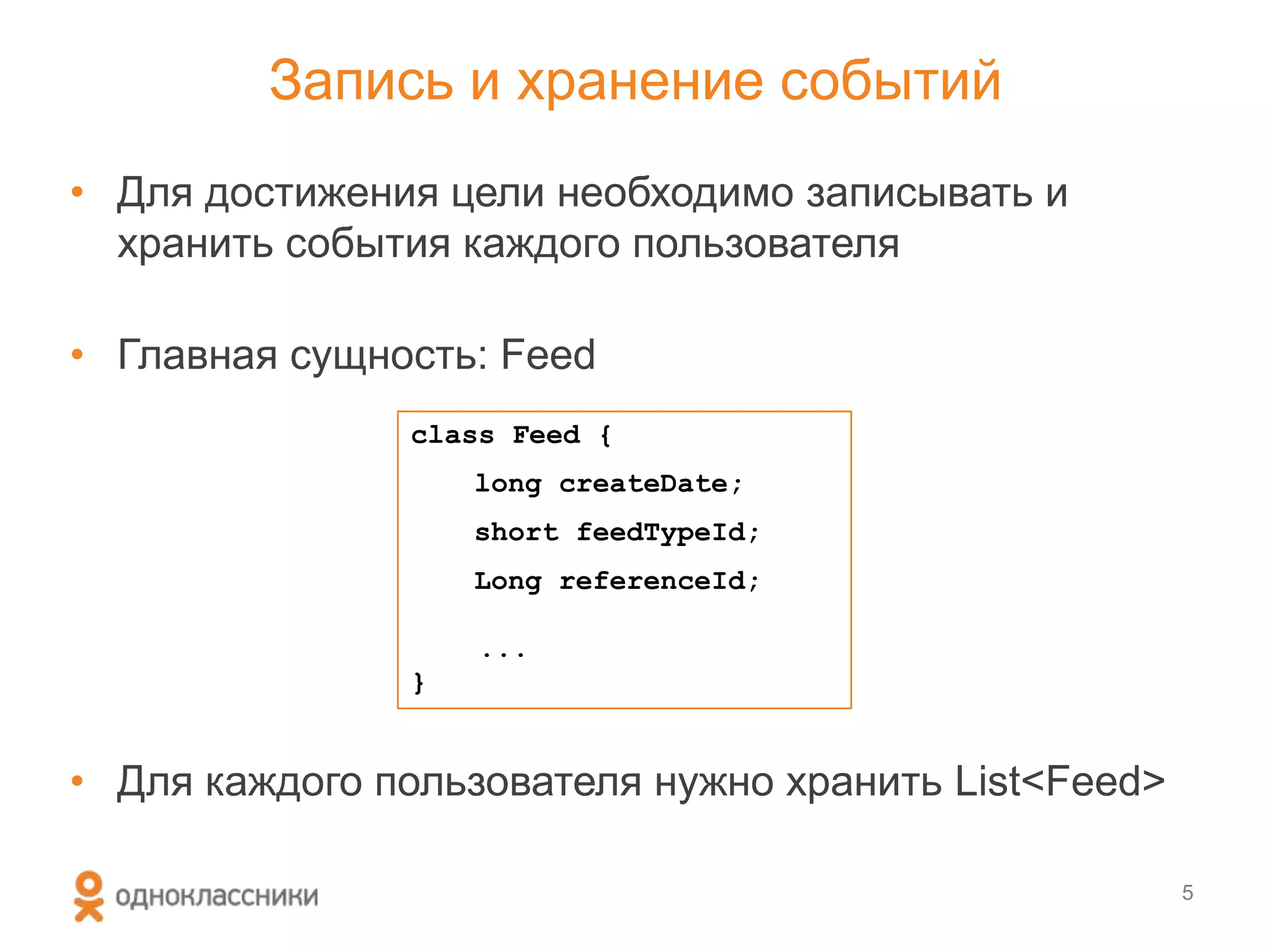

![История развития хранилища фидов

• Oracle Berkeley DB

– Key / Value хранилище CP-типа

– Key: long feedOwnerId

– Value: List<Feed> byte[]

– Хранятся последние N записей (500)

9

• Через ~2 года добавили Voldemort + Tarantool

– Key / Value хранилище AP-типа

– Хранение данных в памяти

– Более высокая производительность

– Более высокая доступность

– Хранятся последние 30 записей

– Использовался одновременно с Berkeley](https://image.slidesharecdn.com/random-130906061834-/75/slide-10-2048.jpg)

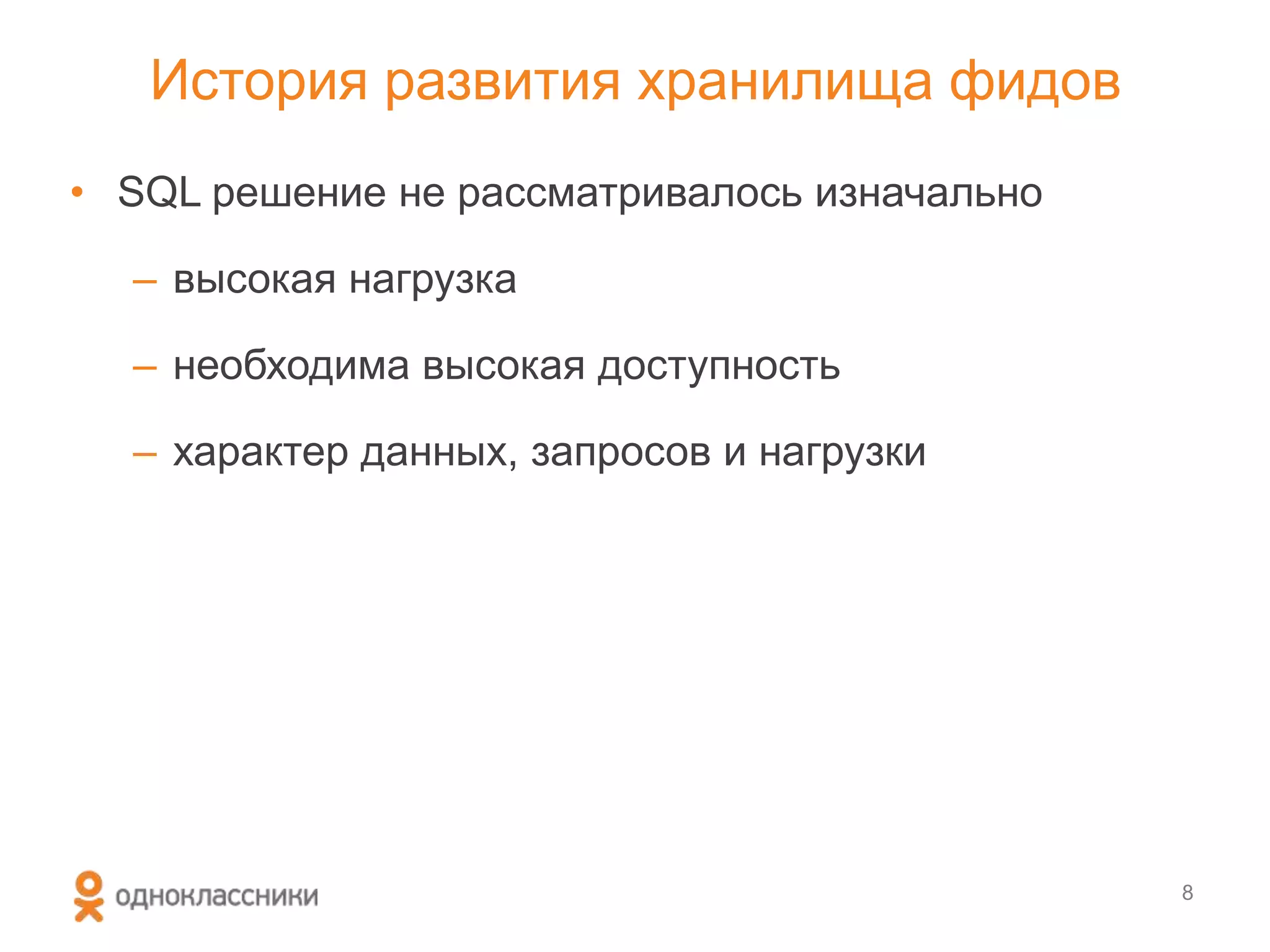

![1. Получаем список подписок из ObservedList

2. По каждой подписке получаем список фидов из Storage

3. Объединяем, сортируем

Алгоритм сборки общей ленты [simplified]

List<Feed> feeds = new ArrayList<Feed>();

ObservedList observedList = getObservedList(feedFollowerId);

for (ObservedItem item: observedList.getItems()){

List<Feed> userFeeds =

getFeeds(observedItem.getFeedOwnerId());

feeds.addAll(userFeeds);

}

Collections.sort(feeds, FEEDS_COMPARATOR);

20

Выполняется

на Feed Proxy](https://image.slidesharecdn.com/random-130906061834-/75/slide-21-2048.jpg)

![• Перед запросом в базу Feeds проверяется значение

UpdateInfo - появились ли новые события

Алгоритм сборки общей ленты [improved]

30

public List<Feed> collectRecentFeeds(

long feedFollowerId, long lastUpdated){

1. ПОЛУЧАЕМ СПИСОК ПОДПИСОК (OBSERVED LIST)

2. ДЛЯ КАЖДОЙ ПОДПИСКИ

3. ПРОВЕРЯЕМ UpdateInfo

if (hasNewFeeds(item.getId(), lastUpdated)){

4. ПОЛУЧАЕМ ФИДЫ

5. ДОБАВЛЯЕМ ФИДЫ В ОБЩИЙ СПИСОК

}

}

...

}

Хотя в UpdateInfo тоже ходим не каждый раз.

Значения кэшируются в ObservedList.](https://image.slidesharecdn.com/random-130906061834-/75/slide-31-2048.jpg)