Recommended

PPTX

[DL輪読会]Bayesian Uncertainty Estimation for Batch Normalized Deep Networks

PDF

PDF

PDF

SSII2022 [SS2] 少ないデータやラベルを効率的に活用する機械学習技術 〜 足りない情報をどのように補うか?〜

PDF

PDF

PPTX

PPTX

PDF

PDF

PDF

PPTX

PPTX

How Much Position Information Do Convolutional Neural Networks Encode?

PDF

文献紹介:Temporal Convolutional Networks for Action Segmentation and Detection

PPTX

PDF

深層生成モデルと世界モデル,�深層生成モデルライブラリPixyzについて

PPTX

Tensor コアを使った PyTorch の高速化

PDF

【DL輪読会】Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

PDF

深層学習によるHuman Pose Estimationの基礎

PDF

SSII2022 [OS3-02] Federated Learningの基礎と応用

PDF

[DL輪読会]SOM-VAE: Interpretable Discrete Representation Learning on Time Series

PDF

ガウス過程回帰の導出 ( GPR : Gaussian Process Regression )

PPTX

3Dマップを活用したVisual Localization

PPTX

勾配ブースティングの基礎と最新の動向 (MIRU2020 Tutorial)

PDF

[DL輪読会]Wasserstein GAN/Towards Principled Methods for Training Generative Adv...

PPTX

[DL輪読会]Grokking: Generalization Beyond Overfitting on Small Algorithmic Datasets

PDF

PDF

PDF

Bayesian Neural Networks : Survey

PPTX

[DL輪読会]Batch Renormalization: Towards Reducing Minibatch Dependence in Batch-...

More Related Content

PPTX

[DL輪読会]Bayesian Uncertainty Estimation for Batch Normalized Deep Networks

PDF

PDF

PDF

SSII2022 [SS2] 少ないデータやラベルを効率的に活用する機械学習技術 〜 足りない情報をどのように補うか?〜

PDF

PDF

PPTX

PPTX

What's hot

PDF

PDF

PDF

PPTX

PPTX

How Much Position Information Do Convolutional Neural Networks Encode?

PDF

文献紹介:Temporal Convolutional Networks for Action Segmentation and Detection

PPTX

PDF

深層生成モデルと世界モデル,�深層生成モデルライブラリPixyzについて

PPTX

Tensor コアを使った PyTorch の高速化

PDF

【DL輪読会】Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

PDF

深層学習によるHuman Pose Estimationの基礎

PDF

SSII2022 [OS3-02] Federated Learningの基礎と応用

PDF

[DL輪読会]SOM-VAE: Interpretable Discrete Representation Learning on Time Series

PDF

ガウス過程回帰の導出 ( GPR : Gaussian Process Regression )

PPTX

3Dマップを活用したVisual Localization

PPTX

勾配ブースティングの基礎と最新の動向 (MIRU2020 Tutorial)

PDF

[DL輪読会]Wasserstein GAN/Towards Principled Methods for Training Generative Adv...

PPTX

[DL輪読会]Grokking: Generalization Beyond Overfitting on Small Algorithmic Datasets

PDF

PDF

Similar to Bayesian Uncertainty Estimation for Batch Normalized Deep Networks

PDF

Bayesian Neural Networks : Survey

PPTX

[DL輪読会]Batch Renormalization: Towards Reducing Minibatch Dependence in Batch-...

PPTX

PDF

[DL Hacks] Deterministic Variational Inference for RobustBayesian Neural Netw...

PPTX

Paper reading - Dropout as a Bayesian Approximation: Representing Model Uncer...

PPTX

Active Learning と Bayesian Neural Network

PDF

Layer Normalization@NIPS+読み会・関西

PDF

[DL輪読会]Estimating Predictive Uncertainty via Prior Networks

PPTX

Paper reading - Dropout as a Bayesian Approximation: Representing Model Uncer...

PDF

単一の深層学習モデルによる不確実性の定量化の紹介 ~その予測結果正しいですか?~

PPTX

Icml2019 kyoto ohno_ver20190805

PDF

自然言語処理における深層学習を用いた予測の不確実性 - Predictive Uncertainty in NLP -

PDF

PDF

PDF

第2回nips+読み会: Learning to learn by gradient decent by gradient decent

PPTX

The 53th Computer Vision Study@ kantou by Takamitsu Omasa

PDF

[DL輪読会]Scalable Training of Inference Networks for Gaussian-Process Models

PDF

20180115_東大医学部機能生物学セミナー_深層学習の最前線とこれから_岡野原大輔

PDF

【参考文献追加】20180115_東大医学部機能生物学セミナー_深層学習の最前線とこれから_岡野原大輔

PDF

Journal club dec24 2015 splice site prediction using artificial neural netw...

More from harmonylab

PDF

Collaborative Document Simplification Using Multi-Agent Systems

PDF

Can Large Language Models perform Relation-based Argument Mining?

PDF

UniPAD: A Universal Pre-training Paradigm for Autonomous Driving

PDF

Efficient anomaly detection in tabular cybersecurity data using large languag...

PDF

APT-LLM Embedding-Based Anomaly Detection of Cyber Advanced Persistent Threat...

PDF

CTINexus: Automatic Cyber Threat Intelligence Knowledge Graph Construction Us...

PDF

Mixture-of-Personas Language Models for Population Simulation

PDF

QuASAR: A Question-Driven Structure-Aware Approach for Table-to-Text Generation

PDF

Large Language Model based Multi-Agents: A Survey of Progress and Challenges

PDF

Mixture-of-Personas Language Models for Population Simulation

PDF

TransitReID: Transit OD Data Collection with Occlusion-Resistant Dynamic Pass...

PDF

Data Scaling Laws for End-to-End Autonomous Driving

PDF

DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Lea...

PDF

Is Ego Status All You Need for Open-Loop End-to-End Autonomous Driving?

PDF

Encoding and Controlling Global Semantics for Long-form Video Question Answering

PDF

AECR: Automatic attack technique intelligence extraction based on fine-tuned ...

PDF

Enhancing Zero-Shot Chain-of-Thought Reasoning in Large Language Models throu...

PDF

Towards Scalable Human-aligned Benchmark for Text-guided Image Editing

PDF

Multiple Object Tracking as ID Prediction

PDF

【卒業論文】LLMを用いたMulti-Agent-Debateにおける反論の効果に関する研究

Recently uploaded

PDF

100年後の知財業界-生成AIスライドアドリブプレゼン イーパテントYouTube配信

PDF

Starlink Direct-to-Cell (D2C) 技術の概要と将来の展望

PDF

自転車ユーザ参加型路面画像センシングによる点字ブロック検出における性能向上方法の模索 (20260123 SeMI研)

PDF

PMBOK 7th Edition_Project Management Process_WF Type Development

PDF

PMBOK 7th Edition_Project Management Context Diagram

PDF

Reiwa 7 IT Strategist Afternoon I Question-1 3C Analysis

PDF

FY2025 IT Strategist Afternoon I Question-1 Balanced Scorecard

PDF

Team Topology Adaptive Organizational Design for Rapid Delivery of Valuable S...

PDF

PMBOK 7th Edition Project Management Process Scrum

PDF

ST2024_PM1_2_Case_study_of_local_newspaper_company.pdf

PDF

第21回 Gen AI 勉強会「NotebookLMで60ページ超の スライドを作成してみた」

PDF

Reiwa 7 IT Strategist Afternoon I Question-1 Ansoff's Growth Vector

PDF

2025→2026宙畑ゆく年くる年レポート_100社を超える企業アンケート総まとめ!!_企業まとめ_1229_3版

Bayesian Uncertainty Estimation for Batch Normalized Deep Networks 1. Bayesian Uncertainty Estimation for

Batch Normalized Deep Networks

Mattias Teye, Hossein Azizpour and Kevin Smith

北海道大学大学院情報科学研究科

調和系工学研究室

修士2年 吉田

2019年5月29日 論文紹介ゼミ

2. 紹介する論文

• タイトル

– Bayesian Uncertainty Estimation for Batch Normalized Deep

Networks

• 著者

– Mattias Teye1,2, Hossein Azizpour1 and Kevin Smith1,3

• 1) School of Electrical Engineering and Computer Science, KTH

Royal Institute of Technology, Stockholm, Sweden

• 2) Electronic Arts, SEED, Stockholm, Sweden

• 3) Science for Life Laboratory

• 学会

– ICML2018

– http://proceedings.mlr.press/v80/teye18a.html

1

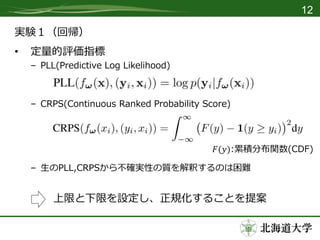

3. 4. 5. 6. 7. 8. 9. 10. 11. 12. 13. 14. 実験1(回帰)

• 定量的評価指標(正規化)

– 下限

• 入力に関わらず一定の分散を予測するベースラインを定義

• 分散として検証データでCRPSを最適化する固定値を設定

• Constant Uncertainty BN (CUBN)と呼ぶ

– 上限

• 各観測点(𝑦𝑖, 𝑥𝑖)でPPLを最大化(CRPSを最小化)する分散𝑇𝑖を予測する

モデルを定義

– 正規化

13

15. 実験1(回帰)

• 比較

– MCBN(提案手法)

– MCDO

– MNF

• Multiple Normalizing Flows for variational Bayesian networks

• http://proceedings.mlr.press/v70/louizos17a.html

• 新しい可視化手法の提案

– 後述

14

16. 17. 18. 19. 20. 21. 22. 23. 24. 25.