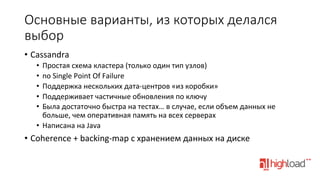

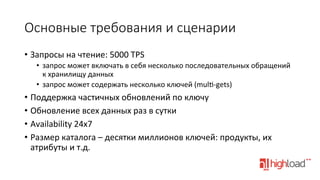

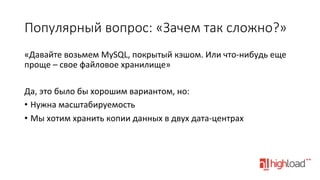

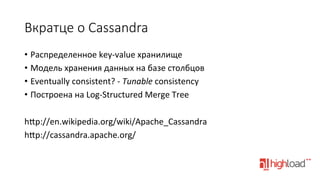

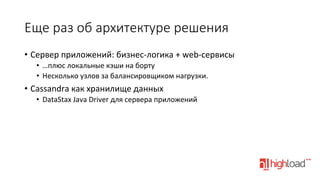

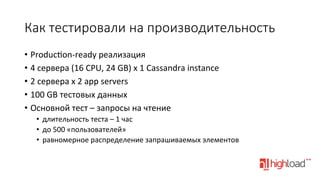

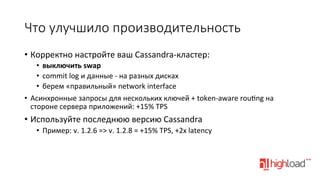

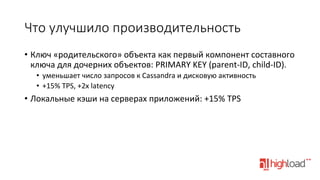

Документ сравнивает использование Cassandra и in-memory data grid в контексте электронной коммерции, описывая миграцию онлайн-каталога на Cassandra для повышения производительности и надежности. Основное внимание уделяется архитектуре решения, требованиям к производительности и причинам выбора Cassandra как системы хранения данных. Также упоминаются улучшения производительности и особенности, такие как поддержка нескольких дата-центров и отсутствие единой точки сбоя.