Jaringan Syaraf Tiruan (JST)

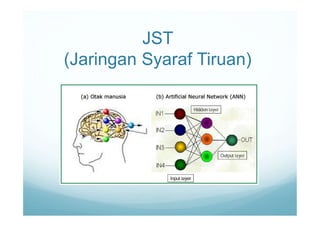

- 2. Pendahuluan • Jaringan Syaraf Tiruan merupakan salah satu representasi buatan dari otak manusia yang selalu mencoba untuk mensimulasikan proses pembelajaran pada otak manusia tersebut. • Istilah buatan digunakan karena jaringan syaraf ini diimplementasikan dengan menggunakan program komputer yang mampu menyelesaikan sejumlah proses perhitungan selama proses pembelajaran

- 3. Pendahuluan • JST adalah paradigma pengolahan informasi yang terinspirasi oleh sistem syaraf secara biologis, seperti proses informasi pada otak manusia. • Cara kerja JST seperti cara kerja manusia, yaitu belajar melalui contoh. • Sebuah JST dikonfigurasikan untuk aplikasi tertentu, seperti pengenalan pola atau klasifikasi data, melalui proses pembelajaran.

- 4. Pendahuluan • Otak manusia berisi berjuta-juta sel syaraf yang bertugas untuk memproses informasi. • Setiap sel syaraf (neuron) akan memiliki satu inti sel, inti sel ini yang akan bertugas untuk melakukan pemrosesan informasi. .

- 5. Pendahuluan • Neuron, sel syaraf yang akan mentransformasikan informasi yang diterima melalui sambungan keluarnya menuju neuron-neuron yang lain. • Pada jaringan syaraf, hubungan antar neuron- neuron dikenal dengan nama bobot. • Penghubung antar neuron memiliki bobot yang akan memperkuat atau memperlemah sinyal. • Untuk menentukan output, setiap neuron menggunakan fungsi aktivasi. Besarnya output ini selanjutnya dibandingkan dengan suatu batas ambang (Threshold).

- 6. Pendahuluan JST juga ditentukan oleh 3 hal : 1. Pola hubungan antar neuron (disebut arsitektur jaringan). 2. Metode untuk menentukan bobot penghubung (disebut metode training/learning). 3. Fungsi aktivasi, yaitu fungsi yang digunakan untuk menentukan keluaran suatu neuron.

- 7. Mengapa Menggunakan JST ? • Mampu menyelesaikan permasalahan yang tidak terstruktur dan sulit didefinisikan, dapat belajar dari pengalaman. • Mampu mengakuisisi pengetahuan walaupun tidak ada kepastian. • Mampu melakukan generalisasi dan ekstraksi dari suatu pola data tertentu, dapat menciptakan suatu pola pengetahuan melalui pengaturan diri atau kemampuan belajar (self organizing).

- 8. Mengapa Menggunakan JST ? • Mampu memilih suatu input data ke dalam kategori tertentu yang sudah ditetapkan (klasifikasi), • Mampu menggambarkan suatu obyek secara keseluruhan, walaupun hanya diberikan sebagian data dari obyek tersebut (asosiasi), • Mampu mengolah data-data input tanpa harus mempunyai target (Self organizing), • Mampu menemukan suatu jawaban terbaik sehingga mampu meminimalisasi fungsi biaya (optimasi).

- 9. • Belajar Adaptive : Kemampuan untuk mempelajari bagaimana melakukan pekerjaan berdasarkan data yang diberikan untuk pelatihan atau pengalaman awal. • Self-Organisation : Sebuah JST dapat membuat organisasi sendiri atau representasi dari informasi yang diterimanya selama waktu belajar. • Real Time Operation : perhitungan JST dapat dilakukan secara paralel, sehingga perangkat keras yang dirancang dan diproduksi secara khusus dapat mengambil keuntungan dari kemampuan ini. Kelebihan JST

- 10. Kelemahan JST 1. Tidak efektif jika digunakan untuk melakukan operasi- operasi numerik dengan presisi tinggi 2. Tidak efisien jika digunakan untuk melakukan operasi algoritma aritmatik, operasi logika dan simbolis. 3. Untuk beroperasi JST butuh pelatihan, sehingga bila jumlah datanya besar, waktu yang digunakan untuk proses pelatihan sangat lama.

- 11. Untuk menyelesaikan masalah menggunakan pemrograman konvensional, kita harus mengerti masalah tersebut dan kita harus tahu bagaimana menyelesaikan masalah tersebut. Hal ini yang membatasi kemampuan pemecahan masalah menggunakan pemrograman konvensional. JST Versus Pemrograman Konvensional JST bisa menyelesaikan masalah tanpa harus mengetahui terlebih dahulu bagaimana menyelesaikan masalah tersebut. Kelemahannya adalah bahwa karena jaringan menemukan cara untuk memecahkan masalah dengan sendirinya, pengoperasiannya tidak dapat diprediksi. JST dan pemrograman konvensional tidak saling bersaing, tetapi saling melengkapi. Ada masalah-masalah yang harus diselesaikan menggunakan pendekatan algoritmik seperti operasi aritmatika dan masalah-masalah yang harus diselesaikan menggunakan JST. Bahkan ada juga masalah-masalah besar yang terpaksa menggunakan kombinasi dari keduanya.

- 12. Contoh Aplikasi

- 13. Contoh Aplikasi

- 14. Contoh Aplikasi

- 16. OTAK MANUSIA • Otak manusia berisi berjutajuta sel syaraf yang bertugas untuk memproses informasi. • Setiap sel syaraf (neuron) akan memiliki satu inti sel, inti sel ini yang akan bertugas untuk melakukan pemrosesan informasi.

- 17. SEJARAH • Tahun 1940-an, para ilmuwan menemukan bahwa psikologi otak sama dengan mode pemrosesan yang dilakukan oleh komputer • Tahun 1943, McCulloch dan Pitts merancang model formal yang pertama kali sebagai perhitungan dasar neuron • Tahun 1954, Farley dan Clark mensetup model- model untuk relasi adaptif stimulus-respon dalam jaringan random.

- 18. SEJARAH • Tahun 1958, Rosenblatt mengembangkan konsep dasar tentang perception untuk klasifikasi pola • Tahun 1960, Widrow dan Hoff mengembangkan ADALINE yang dilatih dengan pembelajaran Least Mean Square (LMS). • Tahun 1974, Werbos memperkenalkan algoritma backpropagation • Tahun 1975, Little dan Shaw menggambarkan jaringan syaraf dengan probabilistik

- 19. SEJARAH • Tahun 1982, Kohonen mengembangkan metode pembelajaran jaringan syaraf yang tidak terawasi untuk pemetaan. • Tahun 1982, Hopfield mengembangkan jaringan syaraf reccurent • Tahun 1985, algoritma pembelajaran dengan mensin Boltzmann • Tahun 1987, Kosko mengembangkan jaringan Adaptive Bidirectional Associative Memory (BAM) • Tahun 1988, dikembangkan fungsi radial bebas

- 20. KOMPONEN JST • Neuron, sel syaraf yang akan mentransformasikan informasi yang diterima melalui sambungan keluarnya menuju neuron- neuron yang lain. • Pada jaringan syaraf, hubungan antar neuron- neuron dikenal dengan nama bobot.

- 21. KOMPONEN JST • Pada jaringan syaraf, neuron-neuron akan dikumpulkan dalam lapisan-lapisan (layer) yang disebut dengan lapisan neuron (neuron layers) • Informasi yang diberikan pada jaringan syaraf akan dirambatkan lapisan ke lapisan, mulai dari lapisan input sampai ke lapisan output melalui lapisan yang lainnya, yang dikenal dengan lapisan tersembunyi (hidden layer), tergantung pada algoritma pembelajarannya, bisa jadi informasi tersebut akan dirambatkan secara mundur pada jaringan.

- 22. ARSITEKTUR JARINGAN • Jaringan saraf tiruan memiliki komponen yang digunakan dalam membangun suatu arsitektur-arsitektur jaringan. • Faktor terpenting untuk menentukan kelakuan suatu neuron adalah fungsi aktivasi dan pola bobotnya.

- 23. ARSITEKTUR JARINGAN • Neuron dikelompokkan ke dalam beberapa lapisan yang mana saling memiliki hubungan satu dengan yang lainnya yang disebut dengan lapisan (layer) • Lapisan Masukan (Input Layer), berisi node-node yang masing-masing menyimpan sebuah nilai masukan • Lapisan Tersembunyi (Hidden Layer), proses pada fase pelatihan dan fase pengenalan dijalankan di lapisan ini • Lapisan Keluaran (Output Layer), menampilkan hasil perhitungan sistem

- 24. ARSITEKTUR JARINGAN A) JARINGAN LAPISAN TUNGGAL (SINGLE LAYER NET) • Hanya memiliki satu lapisan dengan bobot-bobot terhubung • Jaringan ini hanya menerima input kemudian secara langsung akan mengolahnya menjadi output tanpa harus melalui lapisan tersembunyi.

- 25. ARSITEKTUR JARINGAN A) JARINGAN LAPISAN TUNGGAL

- 26. ARSITEKTUR JARINGAN B) Jaringan Lapisan Banyak (Multilayer Net) • Memiliki 1 atau lebih lapisan yang terletak diantara lapisan input dan lapisan output • Ada lapisan yang berbobot yang terletak antara 2 lapisan yang bersebelahan

- 27. ARSITEKTUR JARINGAN B) JARINGAN LAPISAN BANYAK

- 28. ARSITEKTUR JARINGAN C) Jaringan dengan lapisan kompetitif (compotitive layer net) Hubungan antar neuron pada lapisan kompetitif tidak diperlihatkan pada diagram arsitektur

- 30. Fungsi Aktivasi a. Fungsi Undak Biner Hard Limit 0xjika,1 0xjika,0 y Jaringan dengan lapisan tunggal sering menggunakan fungsi undak untuk menkonversi input dari suatu variabel yang bernilai kontinu ke suatu output biner

- 31. Fungsi Aktivasi b. Fungsi Undak Biner Threshold xjika,1 xjika,0 y Fungsi undak biner dengan menggunakan nilai ambang sering disebut fungsi nilai ambang atau fungsi Heaviside.

- 32. Fungsi Aktivasi c. Fungsi Bipolar Symetric Hard Limit 0xjika,1 0xjika,0 0xjika,1 y Hampir sama dengna fungsi undak biner, hanya saja output yang dihasilkan berupa 1, 0 atau -1

- 33. Fungsi Aktivasi d. Fungsi Bipolar dengan threshold xjika xjika xjika y ,1 ,0 ,1 Fungsi yang menghasilkan output berupa 1, 0 atau -1

- 34. Fungsi Aktivasi e. Fungsi Linear (identitas) xy Fungsi linear memiliki nilai output yang sama dengan nilai input

- 35. Fungsi Aktivasi f. Fungsi Saturating Linear 5,0xjika;0 5,0x5,0jika;5,0x 5,0xjika;1 y Fungsi ini akan bernilai 0 jika inputnya kurang dari -½, dan akan bernilai 1 jika inputnya lebih dari ½. Sedangkan jika nilai input terletak antara -½ dan ½, maka outputnya akan bernilai sama dengan nilai input ditambah ½.

- 36. Fungsi Aktivasi g. Fungsi Symetric Saturating Linear 1xjika;1 1x1jika;x 1xjika;1 y Fungsi ini akan bernilai -1 jika inputnya kurang dari -1. Sedangkan jika nilai input terletak antara -1 dan 1, maka outputnya akan bernilai sama dengan nilai inputnya.

- 37. Fungsi Aktivasi h. Fungsi Sigmoid Biner x e1 1 )x(fy )]x(f1)[x(f)x('f Digunakan untuk jaringan syaraf yang dilatih dengan menggunakan metode backpropagation. Memiliki nilai pada range 0 sampai 1.

- 38. Fungsi Aktivasi i. Fungsi Sigmoid Bipolar x x e1 e1 )x(fy )]x(f1)][x(f1[ 2 )x('f Output dari fungsi ini memiliki range antara 1 sampai -1

- 40. Model Neuron McCulloch-Pitts Buatlah model neuron McCulloch-Pitts untuk mengenali pola fungsi logika “AND” sesuai tabel kebenaran berikut :

- 41. Model Neuron McCulloch-Pitts terdapat dua input yaitu x1 dan x2 dan satu output y. Bila nilai bobot w1 dan w2 dibuat sama dengan 1, (w1 = 1 dan w2 = 1), maka kita bisa menghitung jumlah seluruh input yang masuk untuk tiap-tiap data sebagai berikut : Agar y(net) memenuhi fungsi logika “AND”, maka nilai ambang θ pada fungsi aktivasi dibuat sama dengan 2, sehingga

- 42. Model Neuron McCulloch-Pitts dapat mencoba mengubah-ubah nilai bobot w dan nilai ambang θ yang lainnya.

- 43. Model Neuron McCulloch-Pitts Buatlah model neuron McCulloch-Pitts untuk mengenali pola fungsi logika “OR” sesuai tabel kebenaran berikut : terdapat dua input yaitu x1 dan x2 dan satu output y. Bila nilai bobot w1 dan w2 dibuat sama dengan 1, (w1 = 1 dan w2 = 1), maka kita bisa menghitung jumlah seluruh input yang masuk untuk tiap-tiap data sebagai berikut :

- 44. Model Neuron McCulloch-Pitts Agar y(net) memenuhi fungsi logika “OR”, maka nilai ambang θ pada fungsi aktivasi dibuat sama dengan 1, sehingga

- 45. Model Neuron McCulloch-Pitts Buatlah model neuron McCulloch-Pitts untuk mengenali pola fungsi logika “XOR” sesuai tabel kebenaran berikut : karena fungsi logika “XOR” mempunyai 2 buah output yang bernilai “1”. Untuk menyelesaikan masalah ini, fungsi tersebut harus diubah dahulu menjadi

- 46. Model Neuron McCulloch-Pitts Ini berarti unit masukan (X1 dan X2) harus berhubungan dahulu dengan sebuah layar tersembunyi (z1 dan z2) kemudian layar tersembunyi tersebut dihubungkan langsung dengan unit keluaran Y. Bila arsitektur jaringan dibuat seperti berikut

- 48. Model Neuron McCulloch-Pitts maka kita bisa menghitung jumlah seluruh input yang masuk untuk tiap-tiap data pada layar tersembunyi sebagai berikut :

- 49. Model Neuron McCulloch-Pitts Kemudian kita bisa menghitung jumlah seluruh input yang masuk untuk tiap-tiap data pada layar output sebagai berikut :

- 50. Model Neuron McCulloch-Pitts tampak bahwa untuk mengenali pola, model neuron McCulloch-Pitts, harus menentukan bobot w dan nilai ambang θ secara analitik (dengan cara coba-coba) sehingga model neuron McCulloch-Pitts dapat mengenali pola tersebut. Jaringan seperti ini hanya bisa dibuat untuk merepresentasikan fungsi-fungsi yang sederhana. Tetapi untuk masalah-masalah yang komplek misalnya jumlah input lebih dari 2 atau tidak biner maka cara seperti ini sulit dilakukan.

- 51. Paradigma Pembelajaran Pelatihan jaringan syaraf tiruan dibagi menjadi dua yaitu,. a. Pembelajaran dengan supervisi /Terawasi (supervised learning). Metode pembelajaran pada jaringan syaraf disebut terawasi jika output yang diharapkan telah diketahui sebelumnya. b. Pembelajaran Tak Terawasi (unsupervised learning) Pada metode pembelajaran tak terawasi ini tidak memerlukan target output. Tujuan metode ini adalah pengelompokan unit-unit yang hampir sama dalam suatu area tertentu. Tujuan dari pelatihan ini adalah memodifikasi bobot hingga diperoleh bobot yang bisa membuat keluaran jaringan sama dengan target yang diinginkan.

- 52. Algoritma Pembelajaran Dengan Supervisi 1. Hebb rule 2. Perceptron 3. Delta Rule 4. Backpropagation 5. Hetroassociative Memory 6. Bidirectional Associative Memory 7. Learning vector Quantization

- 53. Hebb Rule Metode pembelajaran yang paling sederhana, pembelajaran dilakukan dengan cara memperbaiki nilai bobot sedemikian rupa sehingga jika ada 2 neuron yang terhubung dan keduanya dalam kondisi “on” pada saat yang sama, maka bobot antara keduanya dinaikkan

- 55. Hebb Rule Algoritma pelatihan Hebb : a) Inisialisasi bobot dan bias: wi = 0; dengan i =1,2,...,n; b = 0 b)Untuk setiap pasangan input-target (s-t), lakukan: 1. Set aktivasi unit input : xi = si; (i=1,2,...,n) 2. Set aktivasi unit output: yj = tj;(j=1,2,...,m) c) Perbaiki bobot menurut persamaan berikut: wi(baru) = wi(lama) + xi*yj; (i =1,2,...,n; dan j =1,2,...,m) d)Perbaiki bias menurut persamaan berikut : b(baru) = b(lama) + y

- 56. Hebb Rule fungsi logika “AND” dengan masukan bipolar dan keluaran bipolar dapat dinyatakan sebagai berikut

- 57. Hebb Rule Inisialisasi bobot dan bias : w1 = 0; w2 = 0; b = 0 --------------------------------------------------------------------------------- Data ke-1 : x1 = 1 x2 = 1 y = 1 (target) Perubahan bobot dan bias untuk data ke-1: w1(baru) = w1(lama) + x1*y = 0 + ( 1).( 1) = 1 w2(baru) = w2(lama) + x2*y = 0 + ( 1).( 1) = 1 b(baru) = b(lama) + y = 0 + ( 1) = 1

- 58. Hebb Rule Data ke-2 : x1 = 1 x2 =1 y = 1 (target) Perubahan bobot dan bias untuk data ke-2: w1(baru) = w1(lama) + x1*y = 1 + ( 1).( 1) = 2 w2(baru) = w2(lama) + x2*y = 1 + 1.( 1) = 0 b(baru) = b(lama) + y = ( 1) + ( 1) = 2

- 59. Hebb Rule Data ke-3 : x1 = 1 x2 = 1 y = 1 (target) Perubahan bobot dan bias untuk data ke-3: w1(baru) = w1(lama) + x1*y = 2 + 1.( 1) = 1 w2(baru) = w2(lama) + x2*y = 0 + ( 1).( 1) = 1 b(baru) = b(lama) + y = ( 2) + ( 1) = 3

- 60. Hebb Rule Data ke-4 : x1 = 1 x2 =1 y = 1 (target) Perubahan bobot dan bias untuk data ke-4: w1(baru) = w1(lama) + x1*y = 1 + 1.1 = 2 w2(baru) = w2(lama) + x2*y = 1 + 1.1 = 2 b(baru) = b(lama) + y = ( 3) + 1 = 2

- 61. Hebb Rule Disini diperoleh nilai bobot dan bias sebagai berikut : w1 = 2; w2 = 2 dan b = 2. Nilai-nilai ini dipakai untuk menguji seluruh data masukan, hasilnya adalah : Terlihat bahwa nilai f(net) sama dengan target yang diinginkan pada fungsi logika “AND”. Ini berarti untuk masukan bipolar dan keluaran bipolar dua input, jaringan bisa mengenali pola fungsi logika “AND”.

- 62. Hebb Rule Kelemahan: dalam jaringan Hebb, pengenalan pola tidak hanya ditentukan oleh algoritma untuk merevisi bobot saja, tetapi representasi data juga ikut menentukan hasil pengenalan pola. Biasanya representasi data yang digunakan pada jaringan Hebb adalah bipolar.

- 63. Hebb Rule

- 64. Hebb Rule Algoritma pelatihan Hebb : -------------------------------- Inisialisasi bobot dan bias : w1 = w2 = w3 = w4 = w5 = w6 = w7 = w8 = w9 = 0 dan bias b = 0

- 65. Hebb Rule Pola ke-1 : Perubahan bobot dan bias untuk pola ke-1: w1(baru) = w1(lama) + x1*y = 0 + 1.1 = 1 w2(baru) = w2(lama) + x2*y = 0 + 1.1 = 1 w3(baru) = w3(lama) + x3*y = 0 + 1.1 = 1 w4(baru) = w4(lama) + x4*y = 0 + ( 1).1 = 1 w5(baru) = w5(lama) + x5*y = 0 + 1.1 = 1 w6(baru) = w6(lama) + x6*y = 0 + ( 1).1 = 1 w7(baru) = w7(lama) + x7*y = 0 + ( 1).1 = 1 w8(baru) = w8(lama) + x8*y = 0 + 1.1 = 1 w9(baru) = w9(lama) + x9*y = 0 + ( 1).1 = 1 b(baru) = b(lama) + y = 0 + 1 = 1

- 66. Hebb Rule Pola ke-2 : Perubahan bobot dan bias untuk pola ke-2: w1(baru) = w1(lama) + x1*y = 1 + 1. ( 1) = 0 w2(baru) = w2(lama) + x2*y = 1 + ( 1). ( 1) = 2 w3(baru) = w3(lama) + x3*y = 1 + 1. ( 1) = 0 w4(baru) = w4(lama) + x4*y = ( 1) + 1.( 1) = 2 w5(baru) = w5(lama) + x5*y = 1 + ( 1). ( 1) = 2 w6(baru) = w6(lama) + x6*y = ( 1) + 1.( 1) = 2 w7(baru) = w7(lama) + x7*y = ( 1) + 1. ( 1) = 2 w8(baru) = w8(lama) + x8*y = 1 + 1. ( 1) = 0 w9(baru) = w9(lama) + x9*y = ( 1) + 1. ( 1) = 2 b(baru) = b(lama) + y = 1 + ( 1) = 0

- 67. Hebb Rule Diperoleh nilai : w1 = 0, w2 = 2, w3 = 0, w4 = 2, w5 = 2, w6 = 2, w7 = 2, w8 = 0, w9 = 2, dan b = 0 Nilai-nilai ini dipakai untuk menguji seluruh data masukan, hasilnya adalah : = karena b = 0bxwnet ii ii xw

- 68. Hebb Rule Pola ke-1 net = 0.1 + 2.1 + 0.1 + ( 2)( 1) + 2.1+ ( 2)( 1) + ( 2)( 1) + 0.1 + ( 2)( 1) = 12 f (12) = 1 (sama dengan target) Pola ke-2 net = 0.1 + 2. ( 1) + 0.1 + ( 2).1 + 2. ( 1) + ( 2).1 + ( 2).1 + 0.1 + ( 2).1 = 12 f ( 12) = 1 (sama dengan target) jelas bahwa untuk kedua pola tersebut keluaran jaringan sama dengan target yang diinginkan. Artinya adalah jaringan ini bisa mengenali pola dengan baik.

- 69. Perceptron Biasanya digunakan untuk mengklasifikasikan suatu tipe pola tertentu yang sering dikenal dengan pemisahan secara linear. Algoritma yang digunakan akan mengatur parameter-parameter bebasnya melalui proses pembelajaran

- 70. Perceptron

- 71. Perceptron

- 72. Perceptron Algoritma Pelatihan Perceptron: 1. Inisialisasi semua bobot dan bias (biasanya = 0) Set learning rate: (0 < 1). untuk penyederhanaan set sama dengan 1. Set nilai threshold (θ) untuk fungsi aktivasi 2. Untuk setiap pasangan pembelajaran s-t, kerjakan: a) set aktivasi unit input xi = si; b) Hitung respon untuk unit output: c) Masukkan kedalam fungsi aktivasi : i ii wxbnetiny )(_ inyjika inyjika inyjika y _,1 _,0 _,1

- 73. Perceptron d) Bandingkan nilai output jaringan y dengan target t jika y ≠ t , lakukan perubahan bobot dan bias dengan cara : wi(baru) = wi(lama) + *t*xi b(baru) = b(lama) + *t jika y = t , tidak ada perubahan bobot dan bias: wi(baru) = wi(lama) b(baru) = b(lama) 3. Lakukan iterasi terus-menerus hingga semua pola memiliki output jaringan yang sama dengan targetnya. Artinya bila semua output jaringan sama dengan target maka jaringan telah mengenali pola dengan baik dan iterasi dihentikan.

- 74. Contoh Soal .1 Buat jaringan Perceptron untuk menyatakan fungsi logika AND dengan menggunakan masukan biner dan keluaran bipolar. Pilih = 1 dan = 0,2 Jawab : x1 x2 t 0 0 -1 0 1 -1 1 0 -1 1 1 1 Pola hubungan masukan-target : f X1 net y X2 b 2,0_,1 2,0_2,0,0 2,0_,1 inyjika inyjika inyjika y

- 75. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 1 0 0 0 0 0 1 -1 0 0 0 0 -1 0 0 -1 0 1 1 -1 -1 -1 0 0 -1 1 0 1 -1 -1 -1 0 0 -1 1 1 1 1 -1 -1 1 1 1 1 1 0 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 2 0 0 1 -1 0 0 0 0 -1 1 1 -1 0 1 1 -1 0 0 0 -1 -1 1 0 -2 1 0 1 -1 -1 -1 1 0 -2 1 1 1 1 -1 -1 1 1 1 2 1 -1

- 76. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke – 3 2 1 -1 0 0 1 -1 -1 -1 2 1 -1 0 1 1 -1 0 0 0 -1 -1 2 0 -2 1 0 1 -1 0 0 -1 0 -1 1 0 -3 1 1 1 1 -2 -1 1 1 1 2 1 -2 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Exoch ke - 4 0 0 1 -1 -2 -1 2 1 -2 0 1 1 -1 -1 -1 2 1 -2 1 0 1 -1 0 0 -1 0 -1 1 1 -3 1 1 1 1 -1 -1 1 1 1 2 2 -2

- 77. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 5 2 2 -2 0 0 1 -1 -2 -1 2 2 -2 0 1 1 -1 0 0 0 -1 -1 2 1 -3 1 0 1 -1 -1 -1 2 1 -3 1 1 1 1 0 0 1 1 1 3 2 -2 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 6 3 2 -2 0 0 1 -1 -2 -1 3 2 -2 0 1 1 -1 0 0 0 -1 -1 3 1 -3 1 0 1 -1 0 0 -1 0 -1 2 1 -4 1 1 1 1 -1 -1 1 1 1 3 2 -3

- 78. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 7 3 2 -3 0 0 1 -1 -3 -1 3 2 -3 0 1 1 -1 -1 -1 3 2 -3 1 0 1 -1 0 0 -1 0 -1 2 2 -4 1 1 1 1 0 0 1 1 1 3 3 -3 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 8 0 0 1 -1 -3 -1 3 3 -3 0 1 1 -1 0 0 0 -1 -1 3 2 -4 1 0 1 -1 -1 -1 3 2 -4 1 1 1 1 1 1 3 2 -4

- 79. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 9 3 2 -4 0 0 1 -1 -4 -1 3 2 -4 0 1 1 -1 -2 -1 3 2 -4 1 0 1 -1 -1 -1 3 2 -4 1 1 1 1 1 1 3 2 -4

- 80. Contoh Soal .1 Buat jaringan Perceptron untuk menyatakan fungsi logika AND dengan menggunakan masukan biner dan keluaran bipolar. Pilih = 0,8 dan = 0,5 Jawab : x1 x2 t 0 0 -1 0 1 -1 1 0 -1 1 1 1 Pola hubungan masukan-target : f X1 net y X2 b 5,0_,1 5,0_5,0,0 5,0_,1 inyjika inyjika inyjika y

- 81. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke – 1 0 0 0 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 2 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1

- 82. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke – 3 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 4 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1

- 83. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 5 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 6 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1

- 84. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 7 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1 Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 8 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1

- 85. Masukan Target xi wi + b Output Perubahan bobot w = xi t b = t Bobot baru wbaru = wlama + w bbaru = blama + b x1 x2 t net y=f(n) w1 w2 b w1 w2 b Epoch ke - 9 0 0 0,8 -1 0 1 0,8 -1 1 0 0,8 -1 1 1 0,8 1

- 86. Latihan Soal .3 (TUGAS) Buat jaringan Perceptron untuk mengenali pola pada tabel di bawah ini. Gunakan = 1 dan = 0,1. x1 x2 X3 t 0 1 1 -1 1 0 1 -1 1 1 0 -1 1 1 1 1

- 87. Delta Rule Mengubah bobot yang menghubungkan antara jaringan input ke unit output dengan nilai target.

- 88. Delta Rule Algoritma delta rule untuk memperbaiki bobot ke-i (untuk setiap pola) adalah: w (baru) = w(lama) + (t – y)*xi; dengan: xi = input jaringan y = output jaringan. t = target. α = learning rate pelatihan akan dihentikan jika nilai error (t – y) pada suatu epoch bernilai nol.

- 89. Delta Rule

- 90. Masukan Target xi wi Output Error (t-y) Perubahan bobot w = (t-y)x Bobot baru wbaru = wlama + w x1 x2 t net y=f(n) Error w1 w2 w1 w2 Epoch ke – 1 0,1 0,3 0 0 0,2 0 0 0 0 0,1 0,3 0 1 0,2 1 0,3 0 1 0 0,2 0,1 0,5 1 0 0,2 1 0,1 0 1 0,2 0 0,3 0,5 1 1 0,2 1 0,8 1 0 0,3 0,5 Masukan Target xi wi Output Error (t-y) Perubahan bobot w = (t-y)x Bobot baru wbaru = wlama + w x1 x2 t net y=f(n) Error w1 w2 w1 w2 Epoch ke – 2 0,3 0,5 0 0 0,2 0 0 0 0 0,3 0,5 0 1 0,2 1 0,5 1 0 0,3 0,5 1 0 0,2 1 0,3 0 1 0,2 0 0,5 0,5 1 1 0,2 1 1 1 0 0,5 0,5

- 91. Masukan Target xi wi Output Error (t-y) Perubahan bobot w = (t-y)x Bobot baru wbaru = wlama + w x1 x2 t net y=f(n) Error w1 w2 w1 w2 Epoch ke – 3 0,5 0,5 0 0 0,2 0 0 0 0 0,5 0,5 0 1 0,2 1 0,5 1 0 0,5 0,5 1 0 0,2 1 0,5 1 0 0,5 0,5 1 1 0,2 1 1 1 0 0,5 0,5 Jadi bobot terakhir untuk jaringan adalah w1 = 0,5 dan w2 = 0,5

- 92. Masukan Target xi wi Output Error (t-y) Perubahan bobot w = (t-y)x Bobot baru wbaru = wlama + w x1 x2 t net y=f(n) Error w1 w2 w1 w2 Epoch ke – 1 0,1 0,1 0 0 0,2 0 0 0 0 0,1 0,1 0 1 0,2 1 0,1 0 1 0 0,2 0,1 0,3 1 0 0,2 1 0,1 0 1 0,2 0 0,3 0,3 1 1 0,2 1 0,6 1 0 0,3 0,3 Masukan Target xi wi Output Error (t-y) Perubahan bobot w = (t-y)x Bobot baru wbaru = wlama + w x1 x2 t net y=f(n) Error w1 w2 w1 w2 Epoch ke – 2 0,3 0,3 0 0 0,2 0 0 0 0 0,3 0,3 0 1 0,2 1 0,3 0 1 0 0,2 0,3 0,5 1 0 0,2 1 0,3 0 1 0,2 0 0,5 0,5 1 1 0,2 1 1 1 0 0,5 0,5

- 93. Masukan Target xi wi Output Error (t-y) Perubahan bobot w = (t-y)x Bobot baru wbaru = wlama + w x1 x2 t net y=f(n) Error w1 w2 w1 w2 Epoch ke – 3 0,5 0,5 0 0 0,2 0 0 0 0 0,5 0,5 0 1 0,2 1 0,5 1 0 0,5 0,5 1 0 0,2 1 0,5 1 0 0,5 0,5 1 1 0,2 1 1 1 0 0,5 0,5

- 94. Backpropagation Backpropagation adalah metode penurunan gradien untuk meminimalkan kuadrat error keluaran. Ada tiga tahap yang harus dilakukan dalam pelatihan jaringan, yaitu : tahap perambatan maju (forward propagation) , tahap perambatan-balik, tahap perubahan bobot dan bias. Arsitektur jaringan ini terdiri dari input layer, hidden layer dan output layer seperti pada Gambar berikut

- 95. Backpropagation

- 96. Backpropagation Algoritma backpropagation: * Inisialisasi bobot (ambil nilai random yang cukup kecil). * Selama kondisi berhenti bernilai salah, kerjakan : Tahap Perambatan Maju (forward propagation) a) Setiap unit input (Xi, i=1,2,3,...,n) menerima sinyal xi dan meneruskan sinyal tersebut ke semua unit pada lapisan tersembunyi. b) Setiap unit tersembunyi (Zj, j=1,2,3,...,p) menjumlahkan bobot sinyal input dengan persamaan berikut: n 1i ijij0j vxvin_z

- 97. Backpropagation Dan menerapkan fungsi aktivasi untuk menghitung sinyal outputnya : zj = f(z_inj) biasanya fungsi aktivasi yang digunakan adalah fungsi sigmoid. kemudian mengirimkan sinyal tersebut ke semua unit output. c) Setiap unit output (Yk, k=1,2,3,...,m) menjumlahkan bobot sinyal input p 1i jkik0k wzwin_y

- 98. Backpropagation Dan menerapkan fungsi aktivasi untuk menghitung sinyal outputnya : yk = f(y_ink) Tahap Perambatan-Balik (Backpropagation) d) Setiap unit output (Yk, k=1,2,3,...,m) menerima pola target yang sesuai dengan pola input pelatihan, kemudian hitung error dengan persamaan berikut: k = (tk – yk) f’(y_ink) f ‘ adalah turunan dari fungsi aktivasi kemudian hitung koreksi bobot dengan persaamaan berikut: wjk = k zj Dan menghitung koreksi bias dengan persamaan berikut : w0k = k Sekaligus mengirimkan k ke unit-unit yang ada di lapisan paling kanan.

- 99. Backpropagation e) Setiap unit tersembunyi (Zj, j=1,2,3,...,p) menjumlahkan delta inputnya (dari unit-unit yang berada pada lapisan di kanannya): m 1k jkkj win_ untuk menghitung informasi error, kalikan nilai ini dengan turunan dari fungsi aktivasinya: j = _inj f’(z_inj) kemudian hitung koreksi bobot dengan persamaan berikut: vjk = j xi Setelah itu hitung juga koreksi bias dengan persamaan berikut: v0j = j

- 100. Backpropagation Tahap Perubahan Bobot dan Bias f) Setiap unit output (Yk, k=1,2,3,...,m) dilakukan perubahan bobot dan bias (j=0,1,2,...,p) dengan persamaan berikut: wjk(baru) = wjk(lama) + wjk Setiap unit tersembunyi (Zj, j=1,2,3,...,p) dilakukan perubahan bobot dan bias (i=0,1,2,...,n) dengan persamaan berikut: vij(baru) = vij(lama) + vij g) Tes kondisi berhenti

- 101. Heteroassociative Memory Jaringan syaraf heteroassociative memory adalah jaringan yang dapat menyimpan kumpulan pengelompokan pola, dengan cara menentukan bobot-bobotnya sedemikian rupa. Setiap kelompok merupakan pasangan vektor (s(n),t(n)) dengan n=1,2,...,N. Algoritma pelatihan yang biasa digunakan adalah Hebb rule Algoritma: 1. Inisialisasi semua bobot = 0. 2. Perbaiki bobot dengan persamaan berikut : Wij(baru) = wij(lama) + xi*tj

- 102. Heteroassociative Memory 3. Untuk setiap vektor input, kerjakan: * Set input dengan nilai sama dengan vektor input: * Hitung input jaringan ke unit output: i ijij w*xin_y

- 103. Heteroassociative Memory * Tentukan aktivasi dari setiap unit output: 0_;1 0_;0 0_;1 j j j j iny iny iny y (untuk target bipolar) 0_,1 0_,0 inyjika inyjika yj (untuk target biner)

- 104. Bidirectional Associative Memory (BAM) Bidirectional Associative Memory (BAM) adalah model jaringan syaraf yang memiliki 2 lapisan, yaitu lapisan input dan lapisan output yang mempunyai hubungan timbal balik antara keduanya. Hubungan ini bersifat bidirectional artinya jika bobot matrik dari sinyal yang dikirim dari lapisan input X ke lapisan output Y adalah W, maka bobot matrik dari sinyal yang dikirim dari lapisan output Y ke lapisan input X adalah WT. Arsitektur jaringan untuk 3 neuron pada lapisan input dan 2 neuron pada lapisan output seperti terlihat pada Gambar berikut.

- 105. Bidirectional Associative Memory (BAM)

- 106. Learning Vector Quantization (LVQ) Learning Vector Quantization (LVQ) adalah suatu metode pelatihan pada lapisan kompetitif terawasi yang akan belajar secara otomatis untuk mengklasifikasikan vektor-vektor input ke dalam kelas-kelas tertentu. Kelas-kelas yang dihasilkan tergantung pada jarak antara vektor-vektor input. Jika ada 2 vektor input yang hampir sama, maka lapisan kompetitif akan mengklasifikasikan kedua vektor input tersebut ke dalam kelas yang sama.

- 107. Pembelajaran Tanpa Supervisi (Jaringan Kohonen) Pertama kali yang memperkenalkan jaringan kohonen adalah Prof. Teuvo Kohonen pada tahun 1982. Pada jaringan ini, neuron-neuron pada suatu lapisan akan menyusun dirinya sendiri berdasarkan input nilai tertentu dalam suatu cluster. Dalam proses penyusunan diri, cluster yang dipilih sebagai pemenang adalah cluster yang mempunyai vektor bobot paling cocok dengan pola input (memiliki jarak yang paling dekat). Neuron yang menjadi pemenang beserta neuron-neuron tetangganya akan memperbaiki bobot-bobotnya.

- 108. Algoritma (Jaringan Kohonen) 0. Inisialisasi bobot Wij Set parameter-parameter tetangga Set parameter learning rate 1. Kerjakan jika kondisi berhenti bernilai FALSE a. Untuk setiap vektor input x, kerjakan