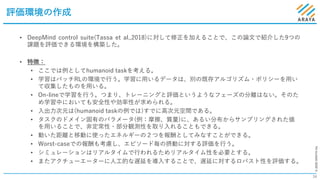

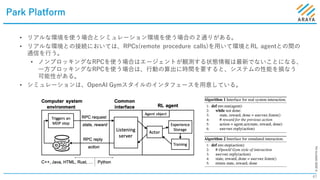

近年、実世界の様々な分野において強化学習の活用が進んでいる。2019年6月には、ICML2019にて、Reinforcement Learning for Real LifeというWorkshopが開催された(https://sites.google.com/view/RL4RealLife)。今回の勉強会では、このWorkshopでBest Paperに選ばれた論文の中から、3本を選んで紹介する。いずれも、強化学習を実タスクに適用する上でのアーキテクチャ・アルゴリズム上の工夫について扱っており、強化学習の実運用を検討する上で参考になると考えている。 簡単に内容を説明すると、[1]は強化学習を実世界の問題に適用する際に生じる課題を整理、[2]はFacebookによって開発された、実運用を見据えた強化学習フレームワークについての紹介、[3]はコンピュータシステムのリソース制御に強化学習を適用するためのプラットフォームの紹介となっている。

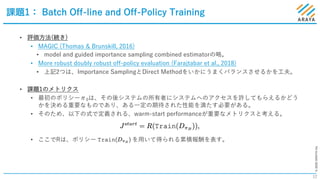

[1] Challenges of Real-World Reinforcement Learning. ICML 2019 Workshop, https://openreview.net/forum?id=S1xtR52NjN

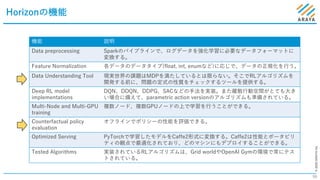

[2] Horizon: Facebook’s Open Source Applied Reinforcement Learning Platform. ICML 2019 Workshop, https://openreview.net/forum?id=SylQKinLi4

[3] Park: An Open Platform for Learning Augmented Computer Systems. ICML 2019 Workshop, https://openreview.net/forum?id=BkgfRbEPsE