RDOを使ったOpenStack Havana環境構築手順をまとめましたので共有します。

RDO-QuickStart-1

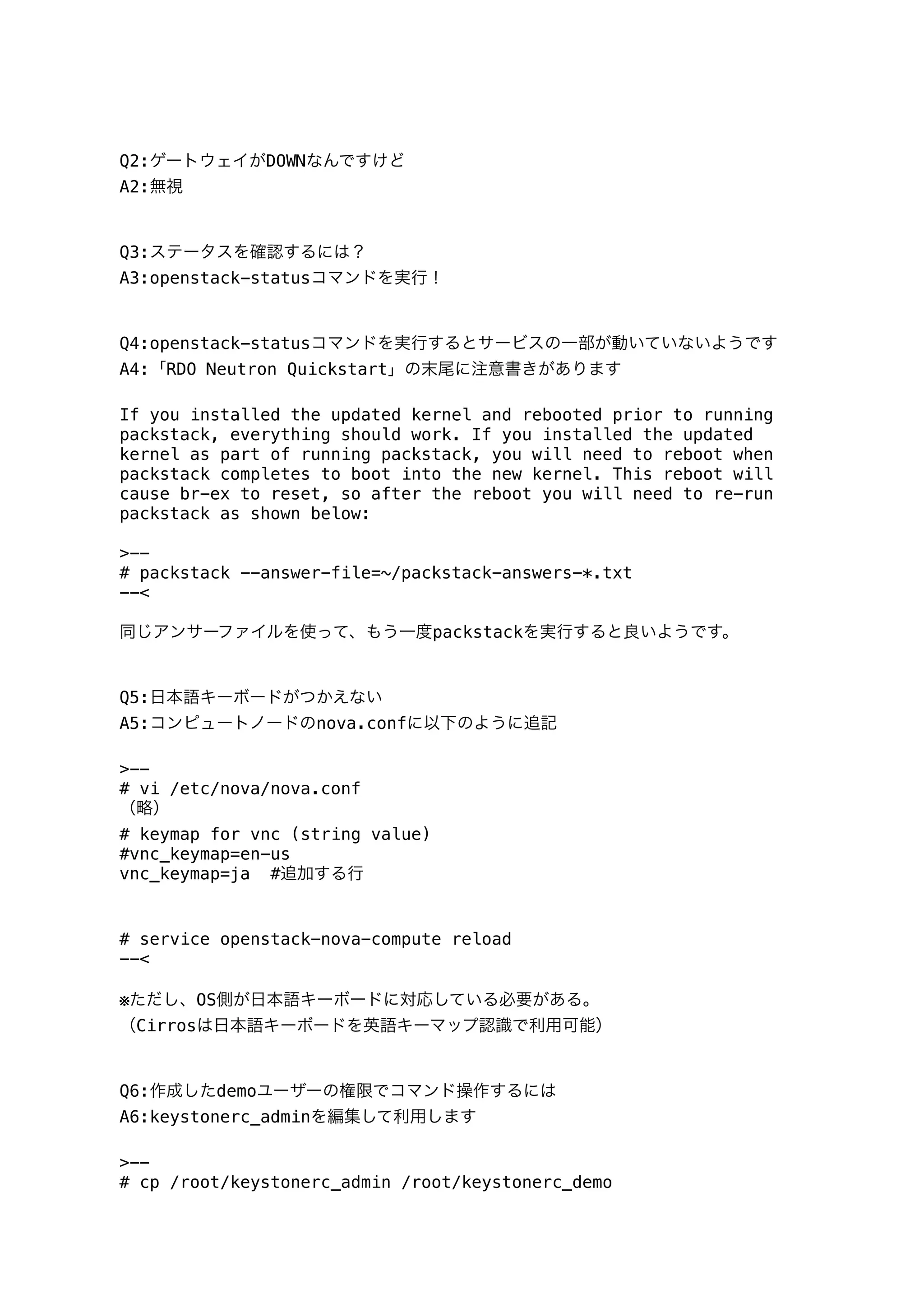

単体構成(all-in-one)

構築手順書は140421-Havana-RDO-QuickStart-1.pdfです。

answer.txtを使って構築します。

RDO-QuickStart-2

コンピュート2台構成(GRE)

構築手順書は140421-Havana-RDO-QuickStart-2.pdfです。

answer2.txtを使って構築します。

RDO-QuickStart-3

コンピュート2台構成(GRE)

CinderボリュームとしてNFSを利用したバージョン

構築手順書は140421-Havana-RDO-QuickStart-3.pdfです。

answer3.txtを使って構築します。

RDO-QuickStart-4

コンピュート3台構成(GRE)

CinderボリュームとしてNFSを利用したバージョン

構築手順書は140421-Havana-RDO-QuickStart-4.pdfです。

answer4.txtを使って構築します。

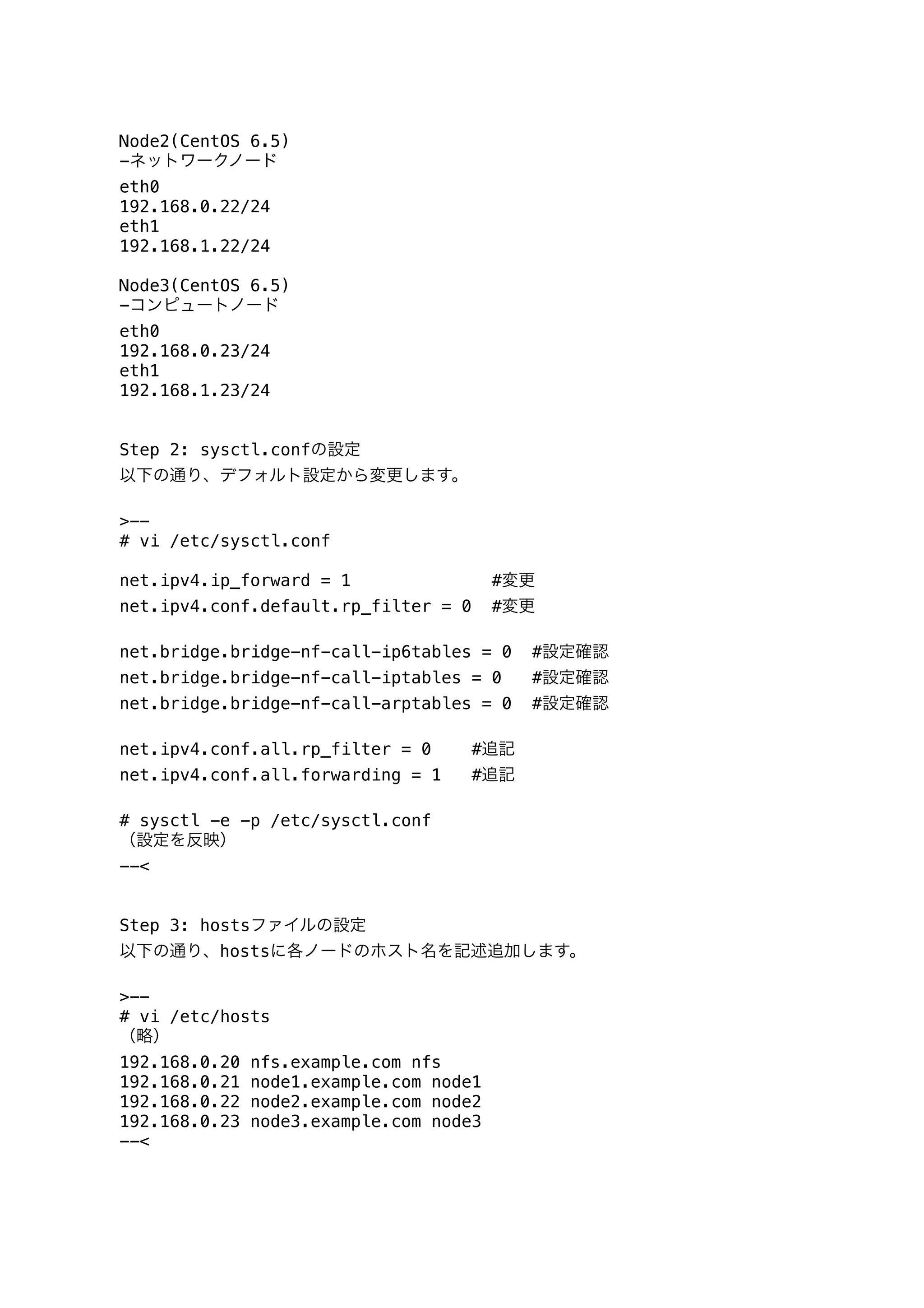

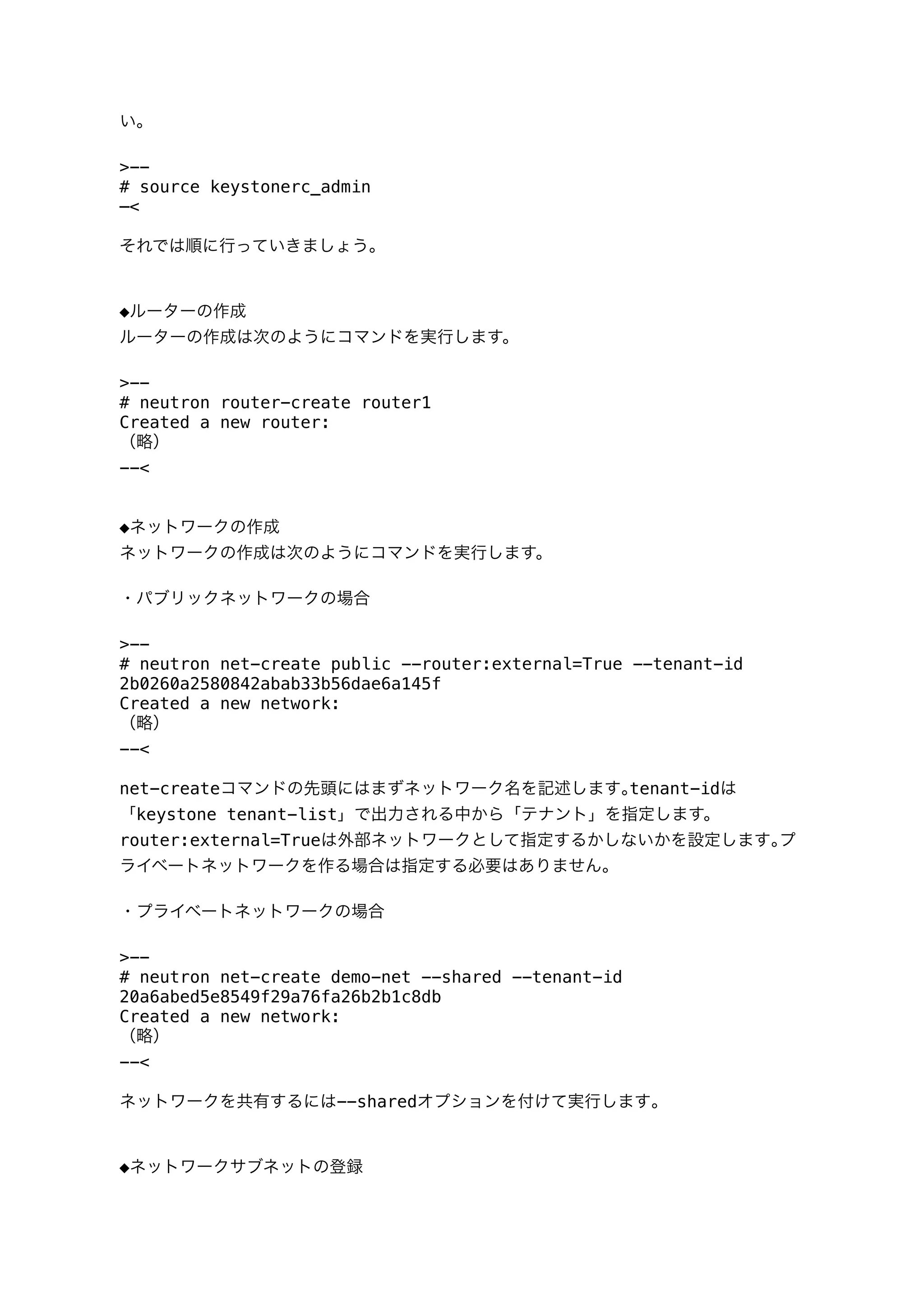

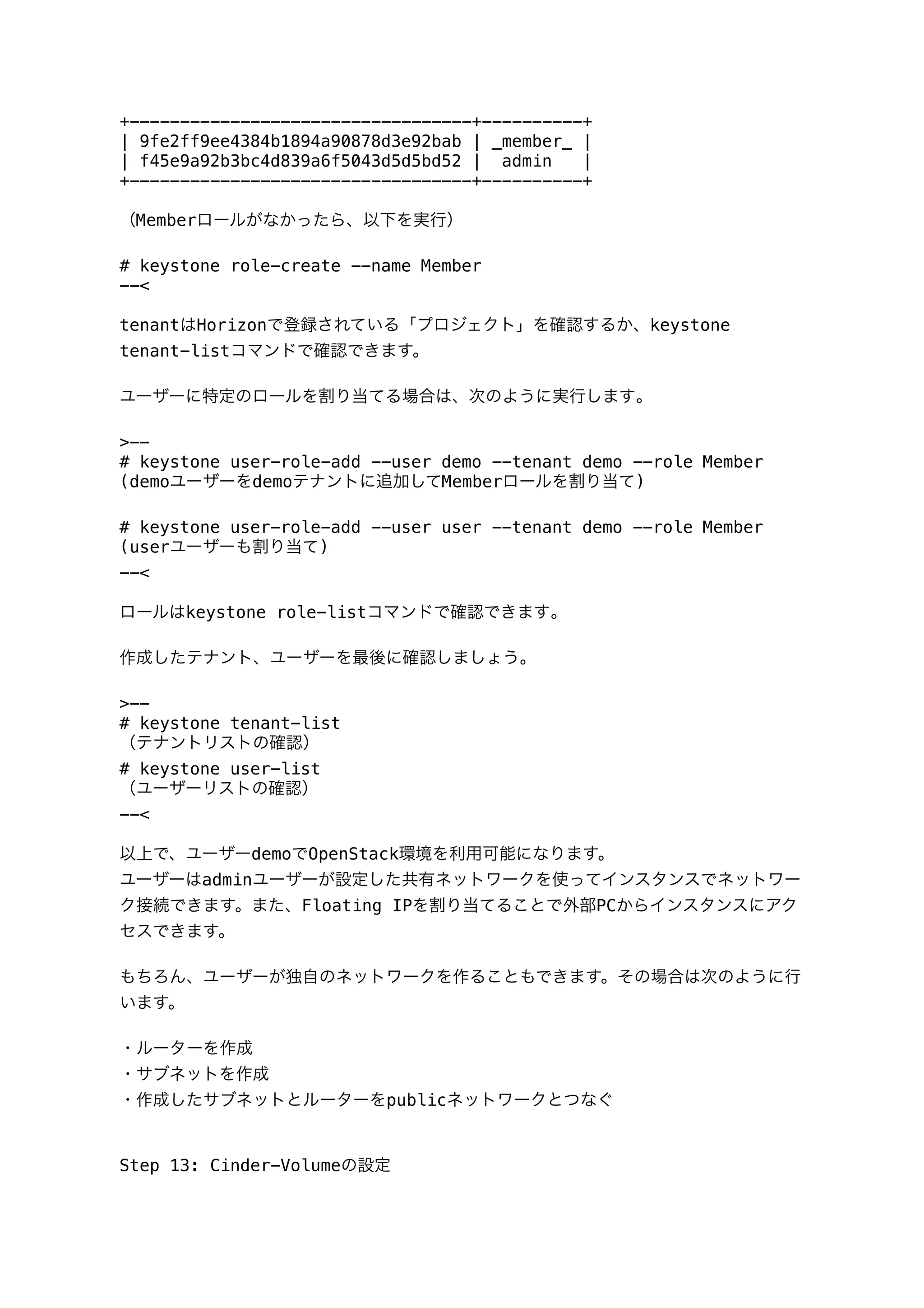

![(上書き問い合わせに対して、yと入力していく)

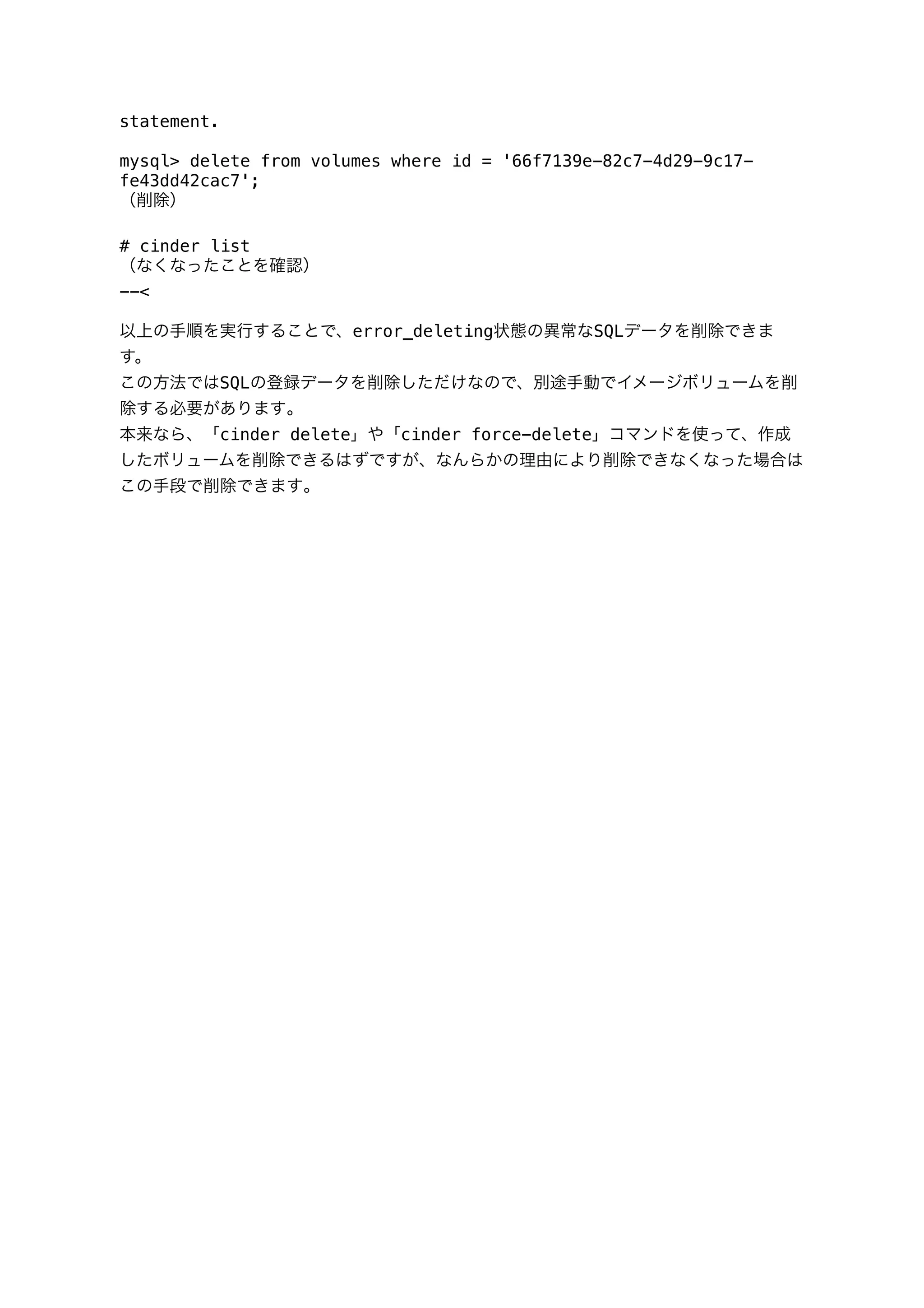

・Cinder Volumeの場所を設定

デフォルトはlvmに設定されているので、適宜設定を行う。

(例)NFSを設定

# The Cinder backend to use, valid options are: lvm, gluster, nfs

CONFIG_CINDER_BACKEND=nfs

# A single or comma seprated list of NFS exports to mount, eg: ip-

# address:/export-name

CONFIG_CINDER_NFS_MOUNTS=192.168.0.20:/nfs

Step 9: RDOによるOpenStackのインストール

設定を書き換えたアンサーファイルを使ってOpenStackを導入するには、次のようにアン

サーファイルを指定して実行します。

>--

# packstack --answer-file=/root/answer.txt

(略)

Installing:

Clean Up... [ DONE ]

Setting up ssh keys...root@192.168.0.21's password:

root@192.168.0.22's password:

root@192.168.0.23's password:

(ノード毎のrootアカウントパスワードを入力)

--<

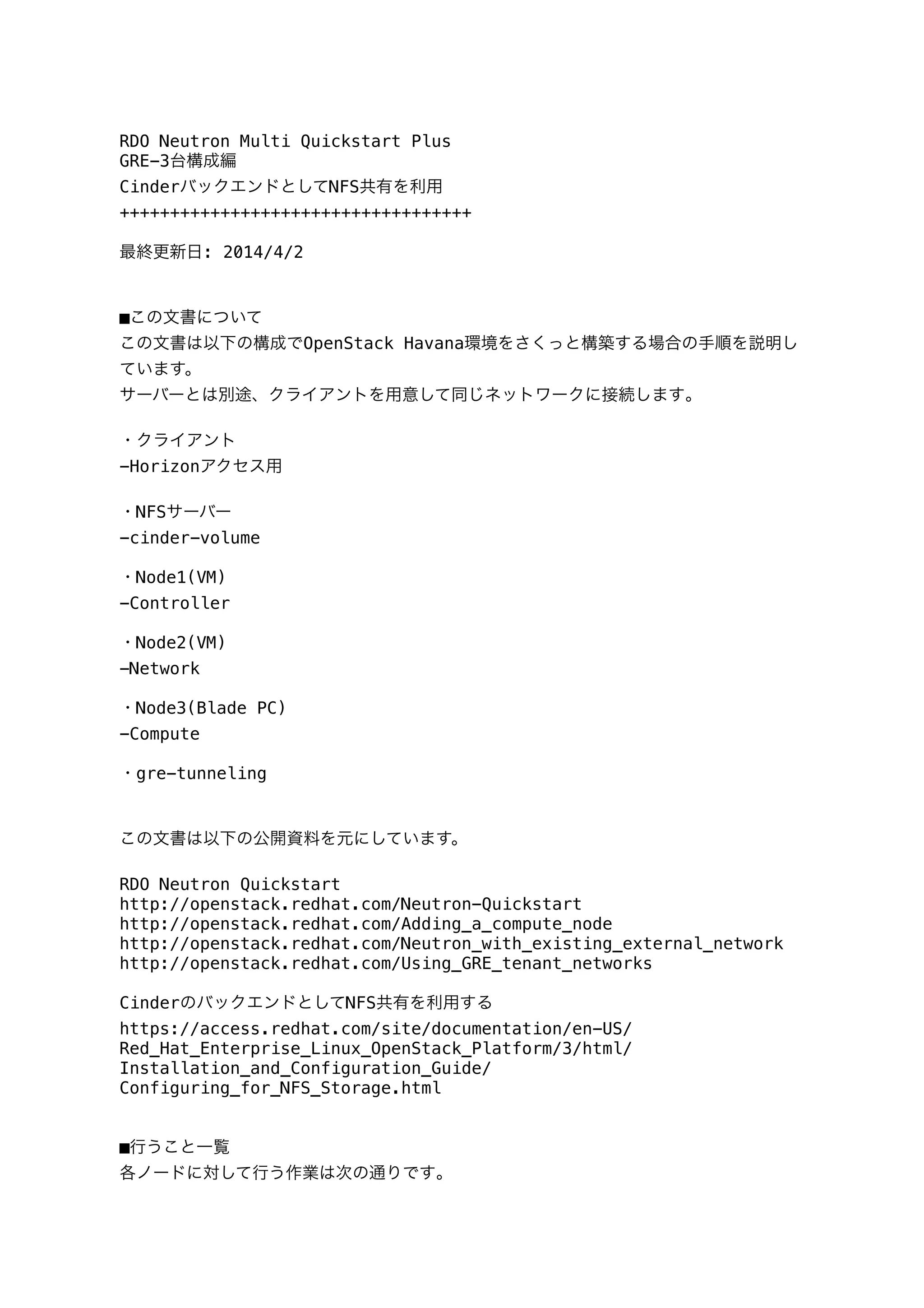

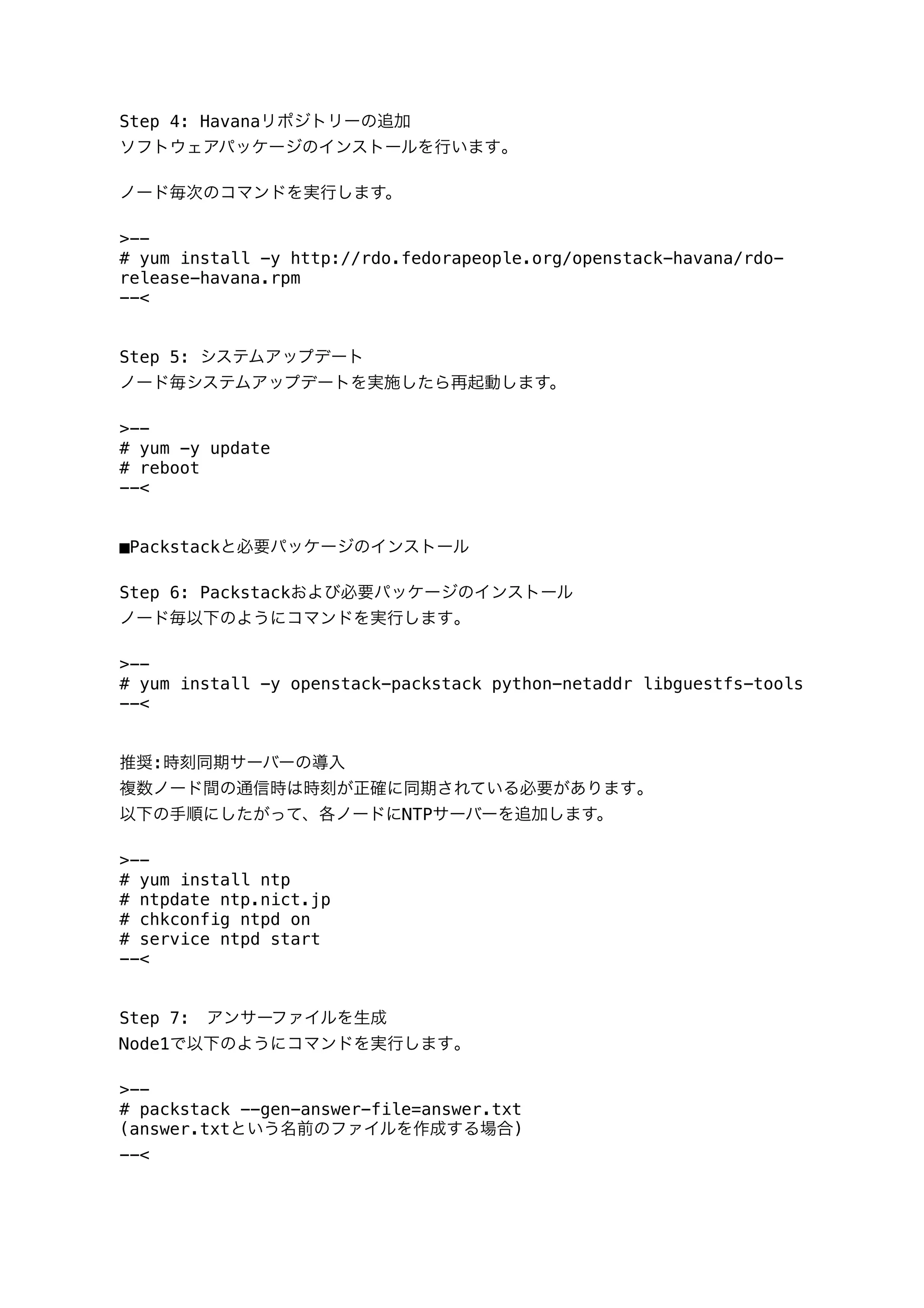

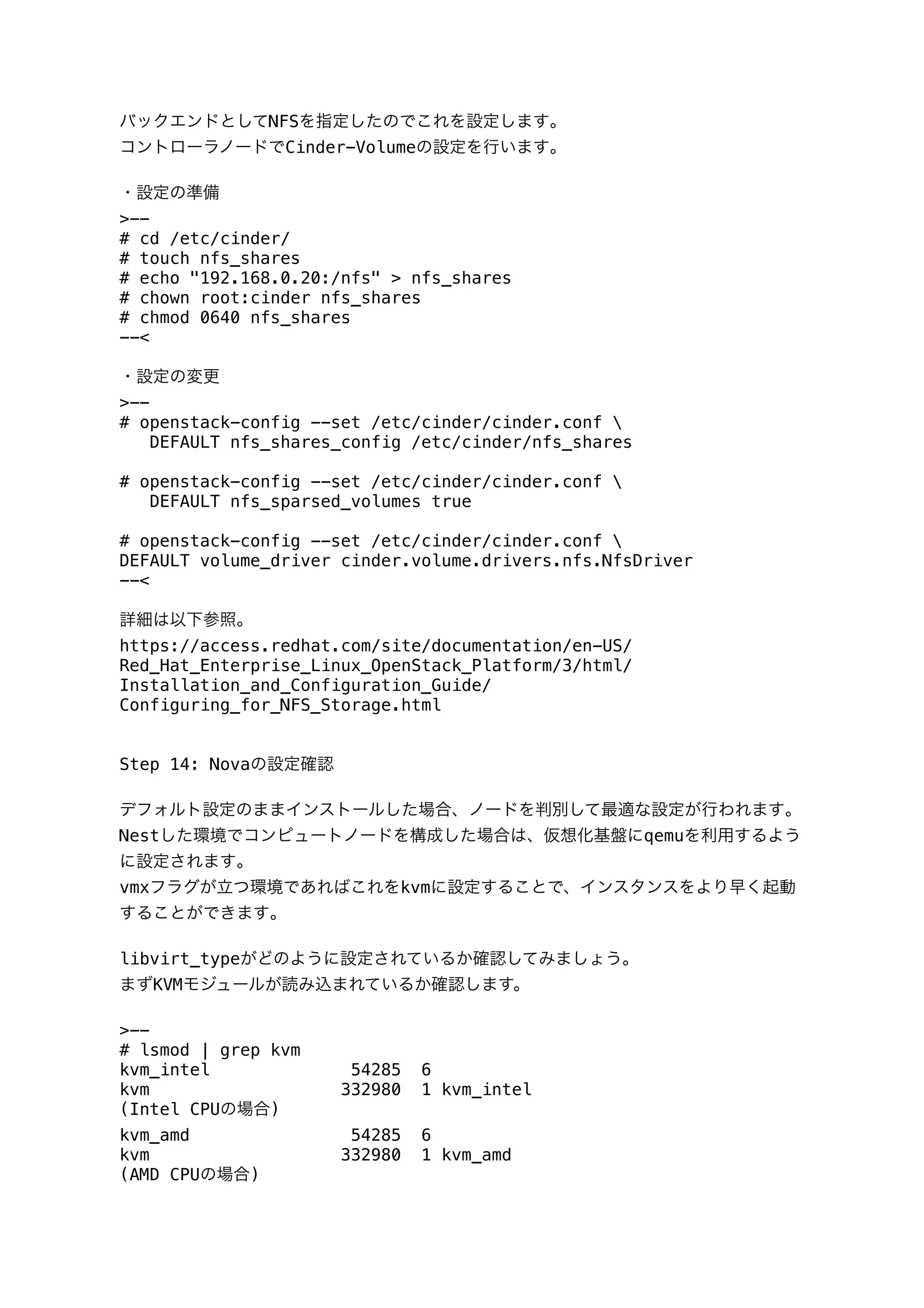

Step 10: ネットワークの設定

次に外部と通信できるようにするための設定を行います。

http://openstack.redhat.com/Neutron_with_existing_external_network

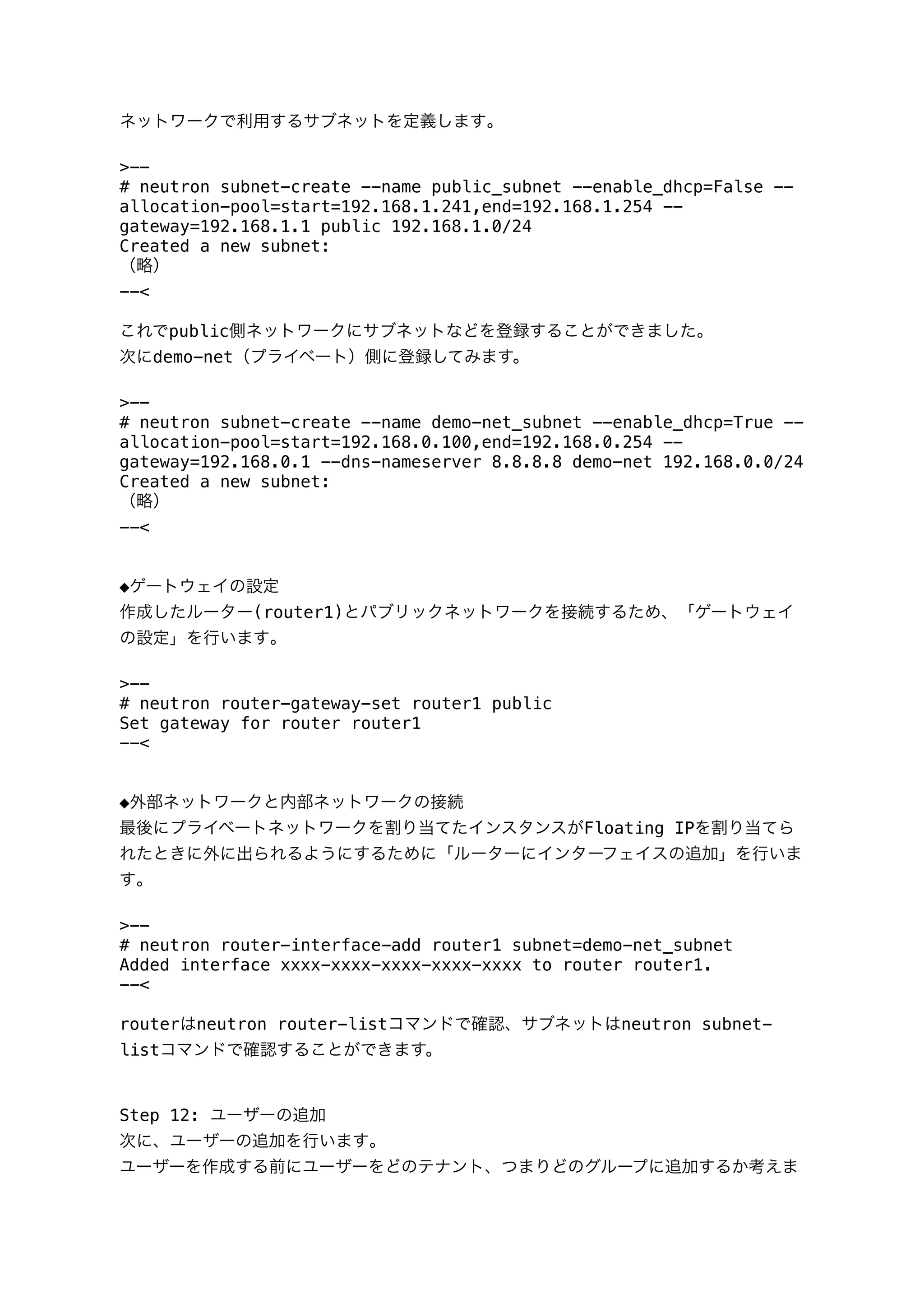

◆public用として使うNICの設定ファイルを修正

packstack実行後、ネットワークノード(Node2)のeth1をbr-exにつなぐように設定をし

ます(※BOOTPROTOは設定しない)

eth1からIPアドレス、サブネットマスク、ゲートウェイの設定を削除して次の項目だけを

記述し、br-exの方に設定を書き込みます。

>--

# vi /etc/sysconfig/network-scripts/ifcfg-eth1

DEVICE=eth1

ONBOOT=yes

HWADDR=52:54:00:92:05:AE # your eth0's hwaddr](https://image.slidesharecdn.com/rdo-quickstart-4-140420194920-phpapp02/75/Havana-RDO-QuickStart-4-140421-Havana-RDO-QuickStart-4-pdf-7-2048.jpg)

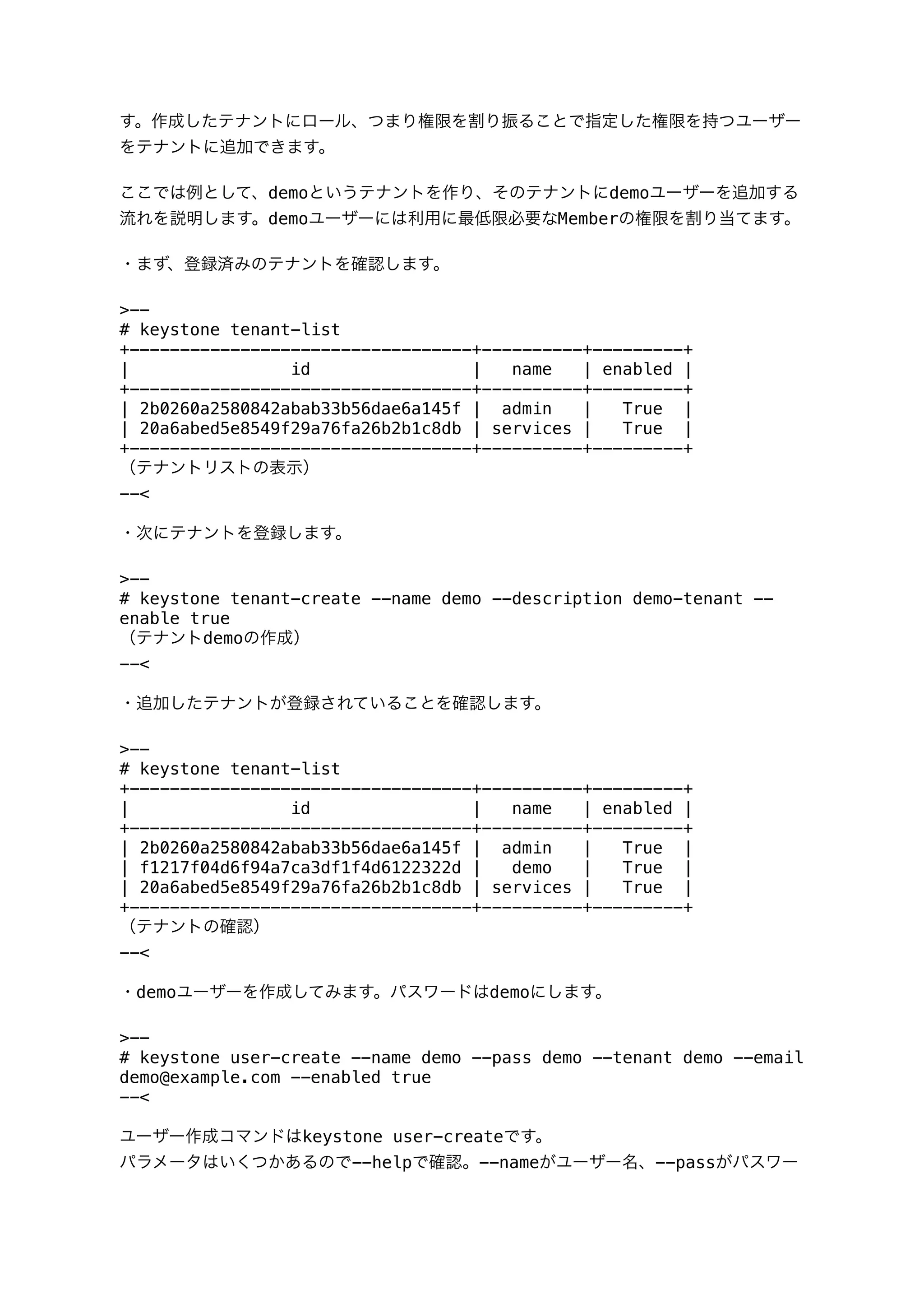

![TYPE=OVSPort

DEVICETYPE=ovs

OVS_BRIDGE=br-ex

--<

◆ブリッジインターフェイスの作成

br-exにeth1のIPアドレスを設定します。

>--

# vi /etc/sysconfig/network-scripts/ifcfg-br-ex

DEVICE=br-ex

ONBOOT=yes

DEVICETYPE=ovs

TYPE=OVSBridge

BOOTPROTO=none

IPADDR=192.168.1.22

NETMASK=255.255.255.0 # netmask

GATEWAY=192.168.1.1 # gateway

DNS1=8.8.8.8 # nameserver

DNS2=8.8.4.4

--<

各ノードのneutron/plugin.iniに次の設定がされていることを確認します。

local_ipをInternal側のIPアドレスを設定します。

>--

# vi /etc/neutron/plugin.ini

[OVS]

vxlan_udp_port=4789

tunnel_type=gre

tunnel_id_ranges=1:1000

tenant_network_type=gre

local_ip=192.168.0.21

enable_tunneling=True

integration_bridge=br-int

tunnel_bridge=br-tun

[AGENT]

polling_interval=2

[SECURITYGROUP]

firewall_driver=neutron.agent.linux.iptables_firewall.OVSHybridIptab

lesFirewallDriver

--<

ここまでできたらいったん各ノードを再起動します。

>--

# reboot

--<](https://image.slidesharecdn.com/rdo-quickstart-4-140420194920-phpapp02/75/Havana-RDO-QuickStart-4-140421-Havana-RDO-QuickStart-4-pdf-8-2048.jpg)

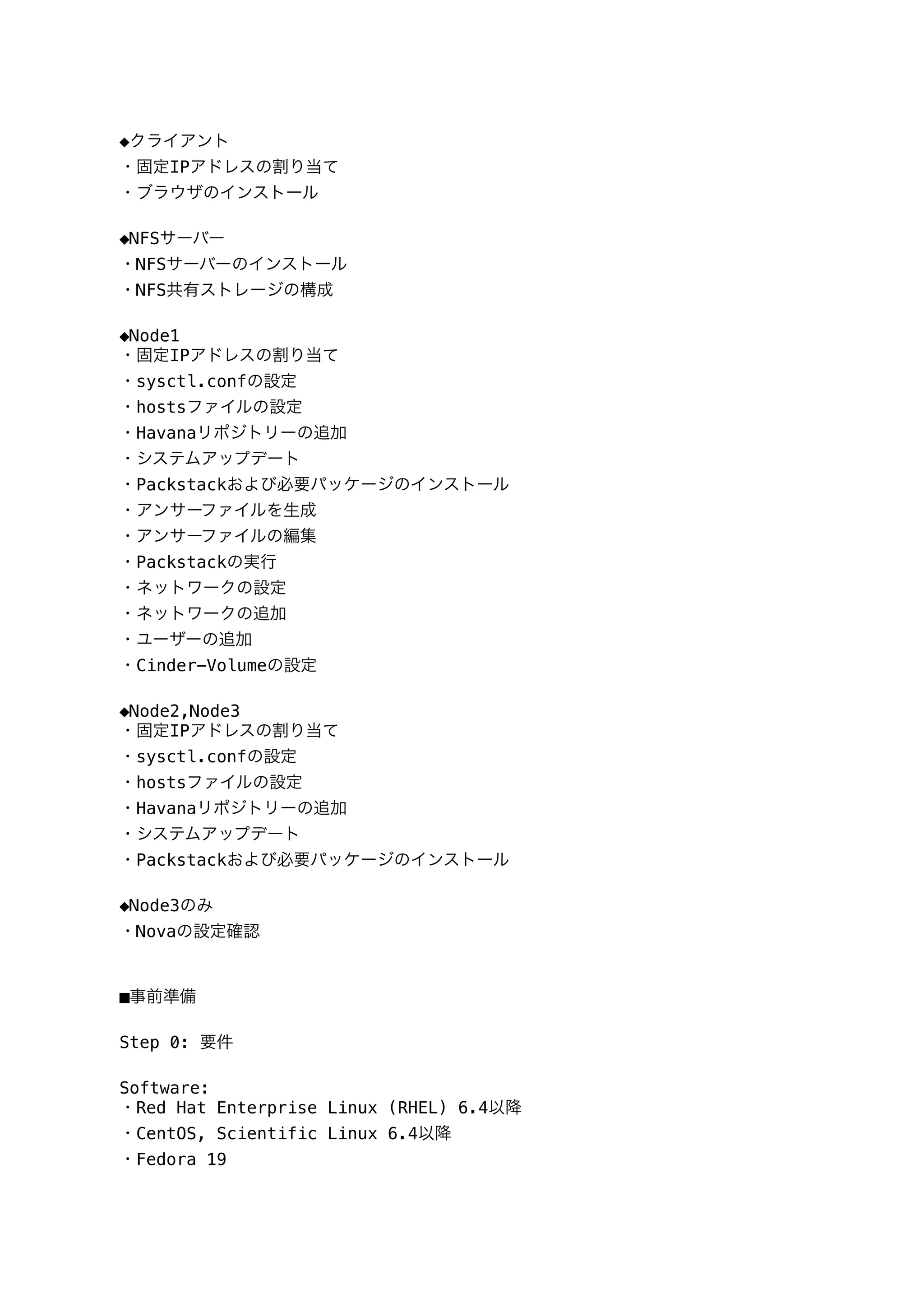

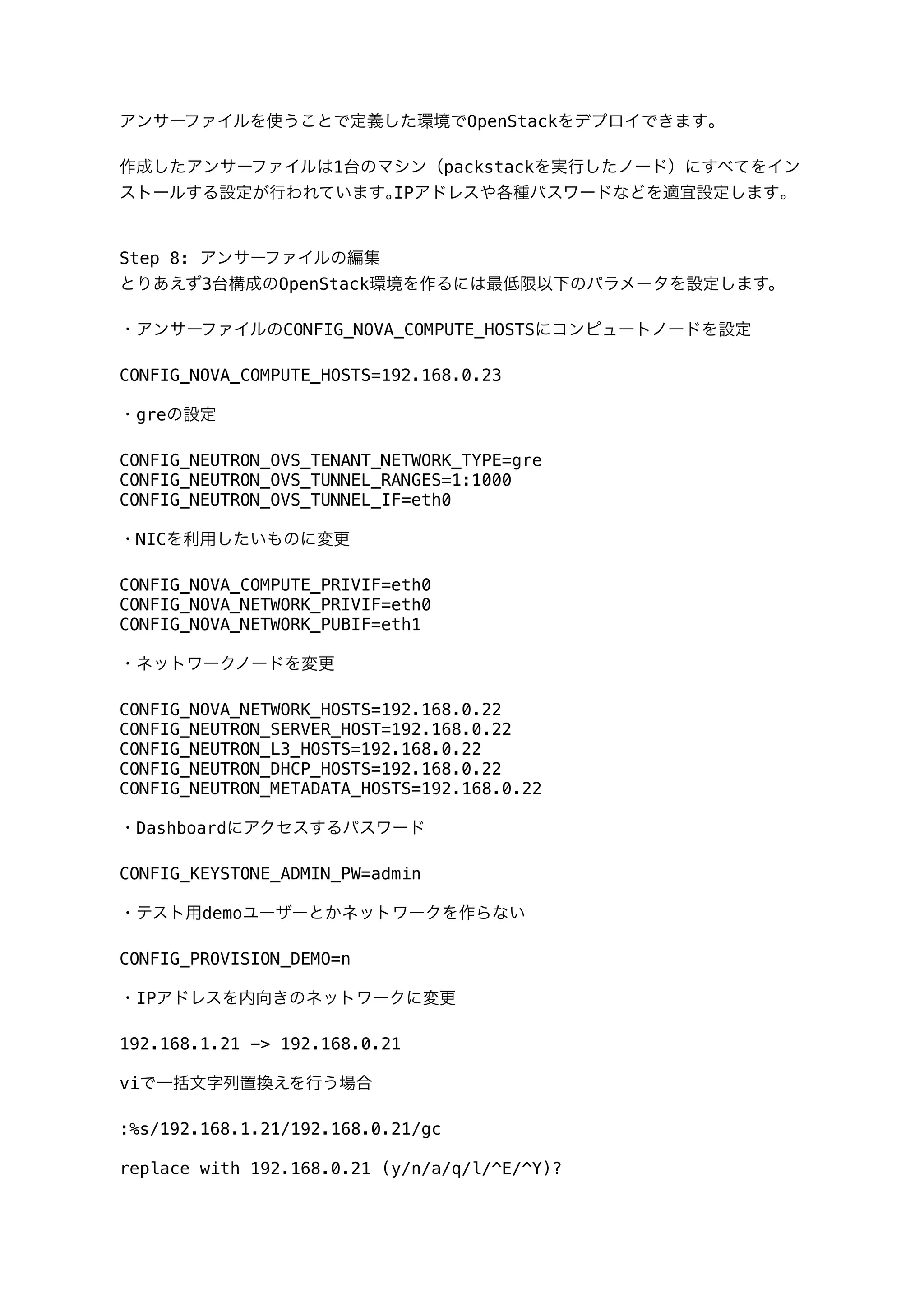

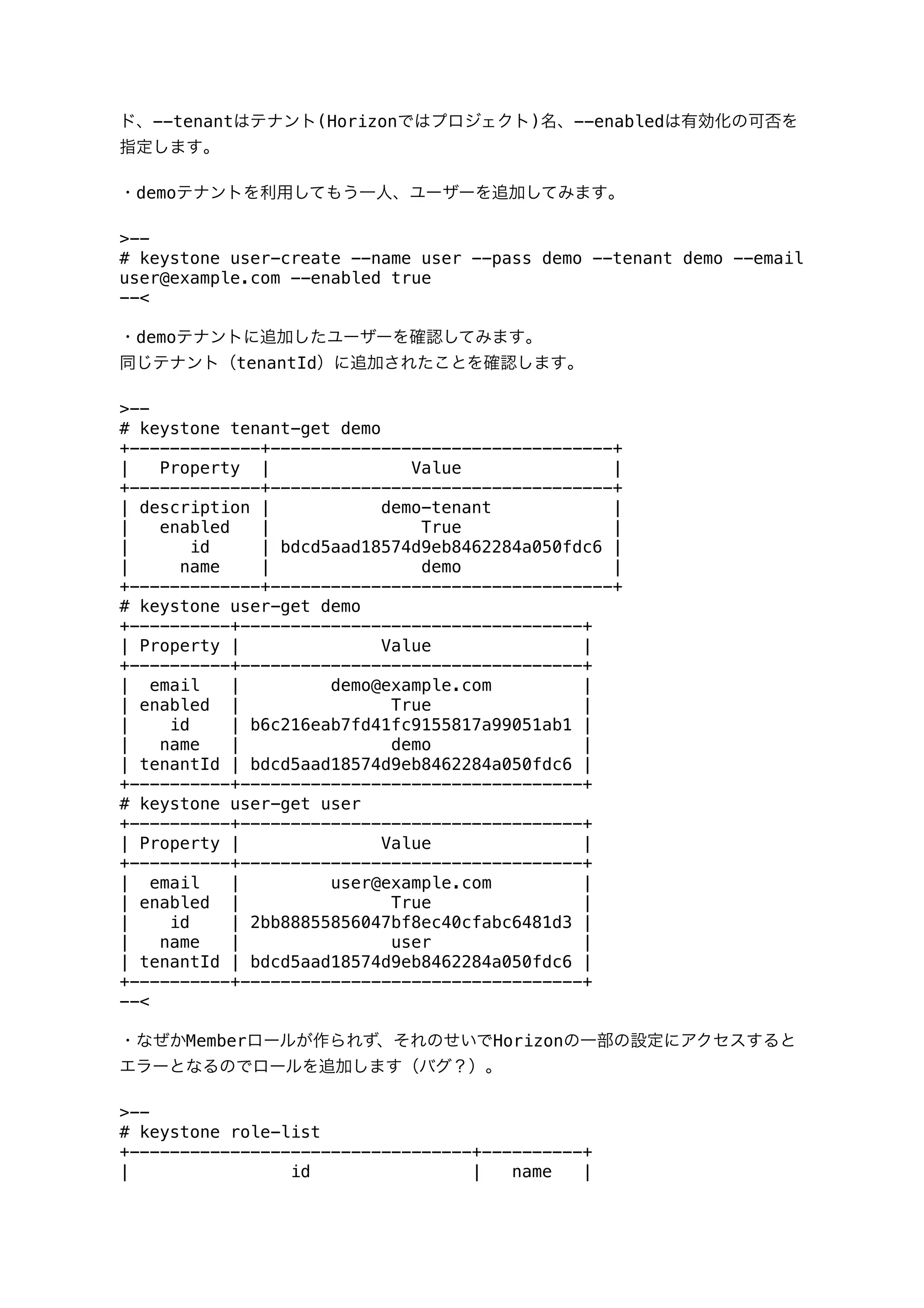

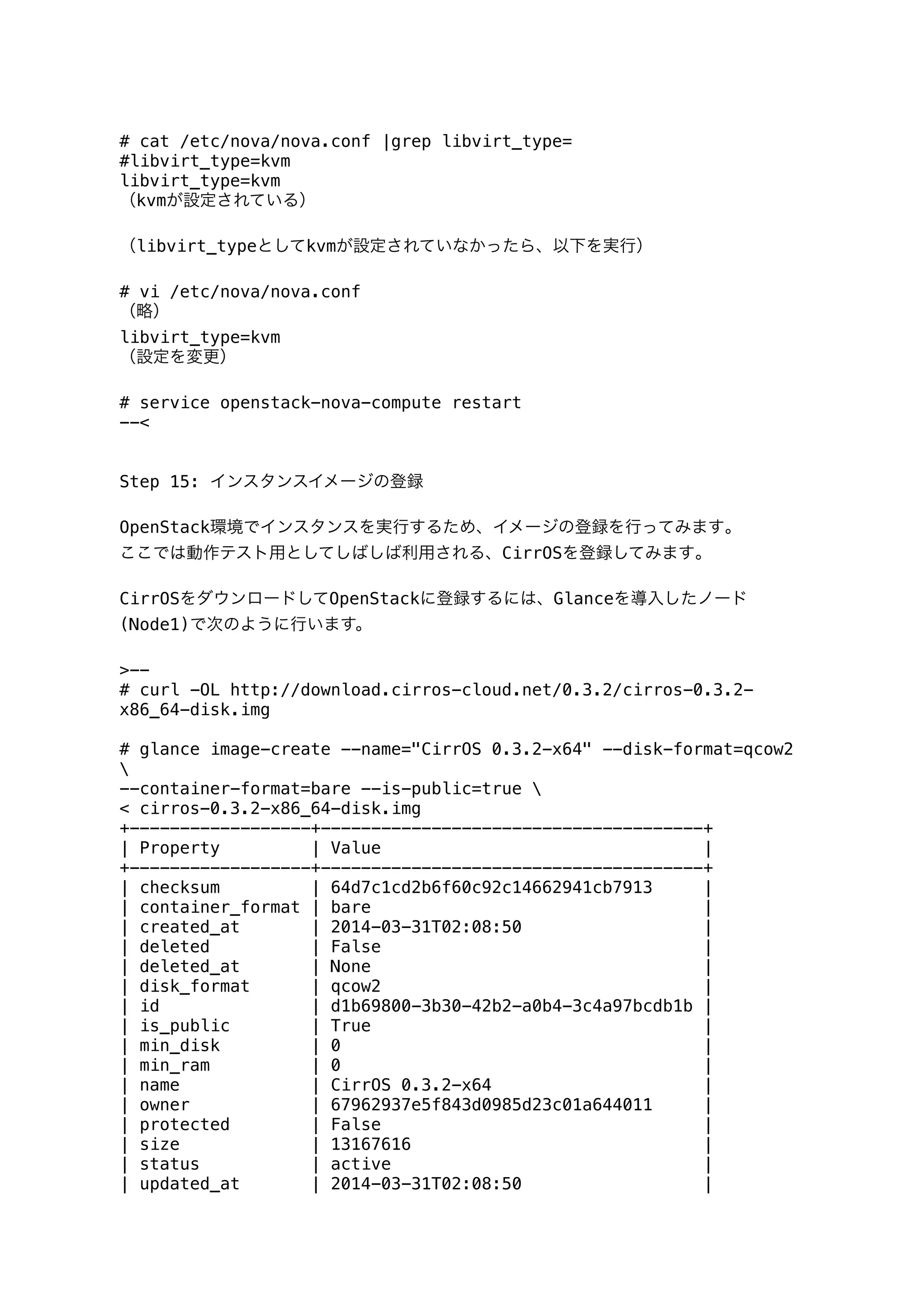

![(keystonercをコピー)

# vi /root/keystonerc_demo

export OS_USERNAME=demo

export OS_TENANT_NAME=demo

export OS_PASSWORD=demo

export OS_AUTH_URL=http://192.168.1.11:35357/v2.0/

export PS1='[u@h W(keystone_demo)]$ '

--<

設定箇所

・export OS_USERNAMEをdemo

・export OS_TENANT_NAMEをdemo

・export OS_PASSWORDをdemoユーザー作成時に設定したパスワード

・export PS1をkeystone_demoに設定

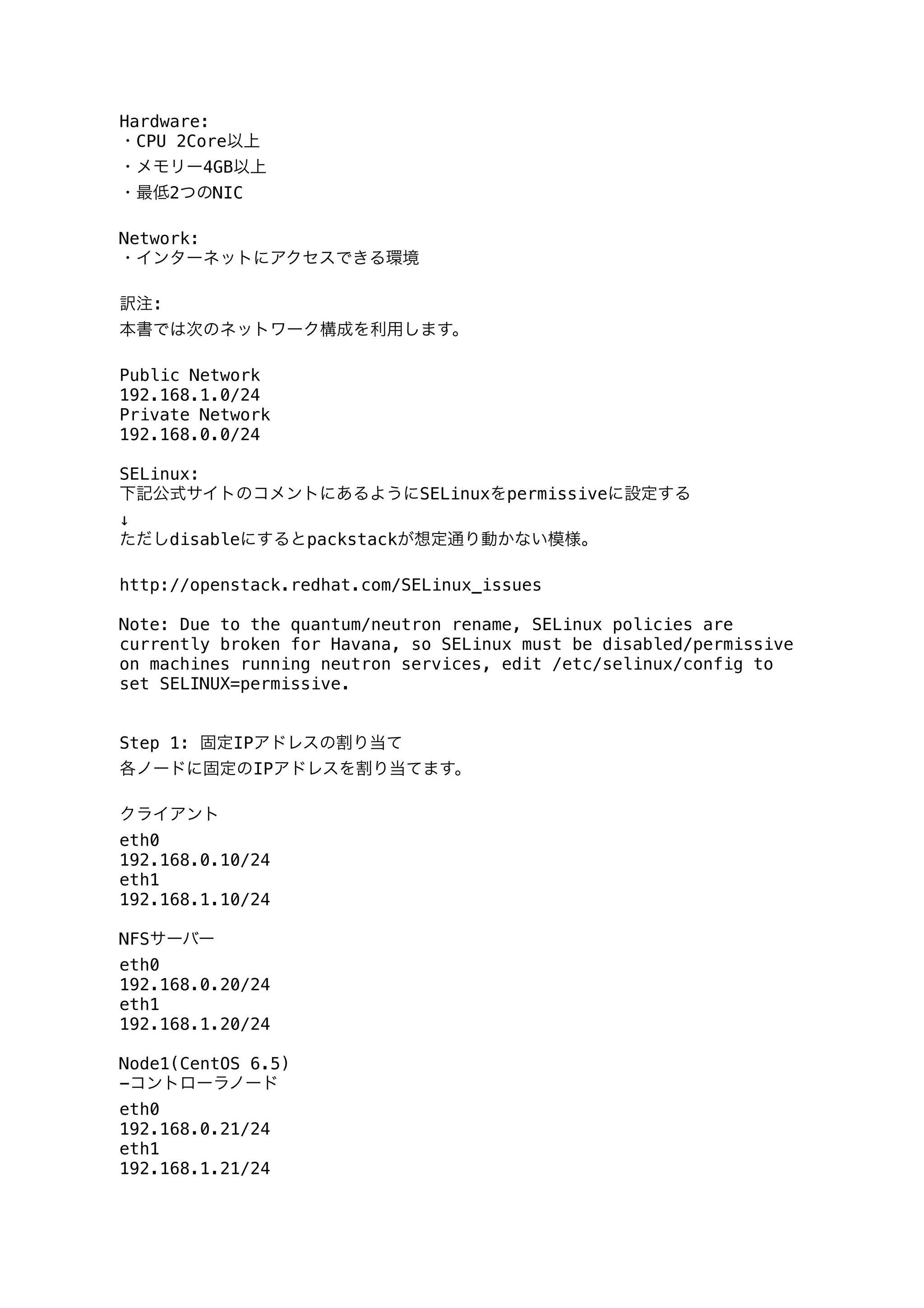

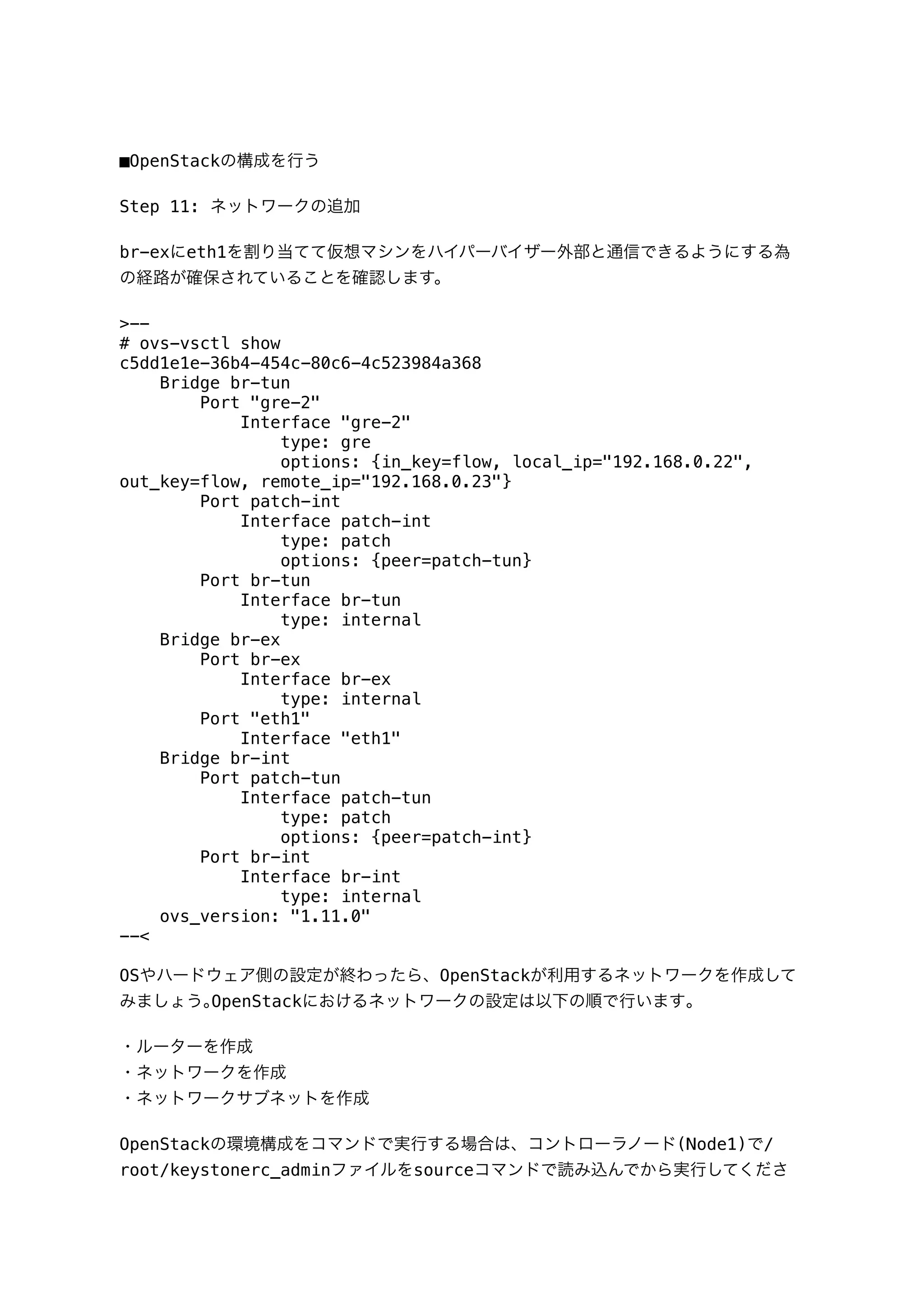

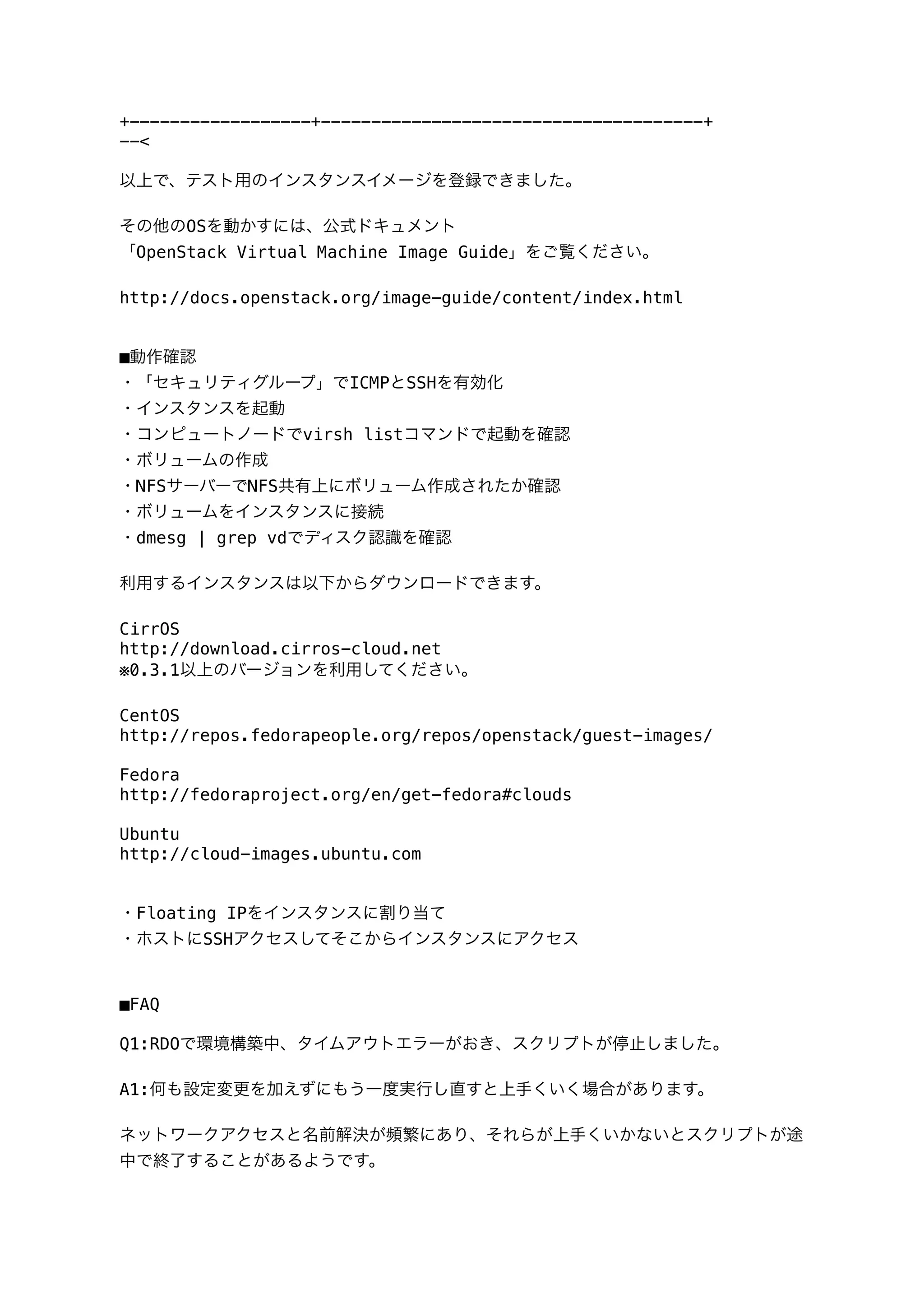

Q7:マルチノードでやるには

A7:以下公式ドキュメントを参照。

http://openstack.redhat.com/Adding_a_compute_node

Q8:ボリュームの削除をすると状態が「Error_Deleting」のまま、いつまでたっても変

わらない

A8:検索すると類似例がいくつか見つかります。次の手順で対処可能です。

【error_deleting関連】

https://bugzilla.redhat.com/show_bug.cgi?id=888987

https://bugs.launchpad.net/cinder/+bug/1039706

https://ask.openstack.org/en/question/1378/cannot-remove-volume/

>--

# cinder list

+--------------------------------------+----------------

+--------------+--

| ID | Status | Display

Name |

+--------------------------------------+----------------

+--------------+--

| 66f7139e-82c7-4d29-9c17-fe43dd42cac7 | error_deleting | disk01

|

+--------------------------------------+----------------

+--------------+--

# mysql -u cinder -p -D cinder

Enter password:

(パスワードはanswer.txtの"CONFIG_CINDER_DB_PW"の値を入力)

Type 'help;' or 'h' for help. Type 'c' to clear the current input](https://image.slidesharecdn.com/rdo-quickstart-4-140420194920-phpapp02/75/Havana-RDO-QuickStart-4-140421-Havana-RDO-QuickStart-4-pdf-19-2048.jpg)