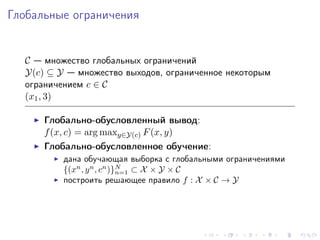

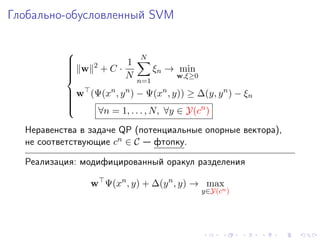

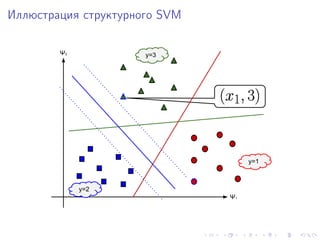

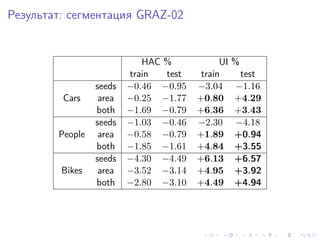

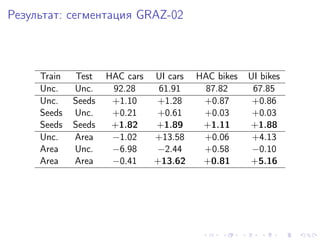

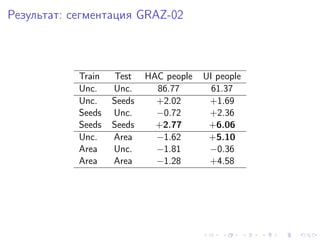

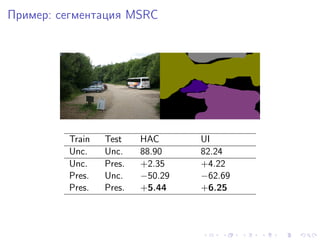

Документ обсуждает структурное обучение и использование SVM для задач сегментации изображений. Он включает примеры формулировок, функций потерь и методов оптимизации, а также показывает результаты сегментации на различных наборах данных. Разбираются глобально-обусловленные выводы и обучение с глобальными ограничениями.

![Пример: сегментация изображения

x y yi

xi

F (x, y) = log p(y|x) = −E(y|x)

= ypk · Upk (x) + [yp = yq ] · Ppq (x)

p k p p,q

data smoothness](https://image.slidesharecdn.com/presentationssvmandcoursework2012-130210190001-phpapp01/85/SVM-3-320.jpg)

![Пример: сегментация изображения

x y yi

xi

F (x, y; w) = log p(y|x; w) = −E(y|x; w)

= ypk · wk ψp (x) + [yp = yq ] · wsm ψpq (x)

p k p p,q

= w Ψ(x, y)

Ψ(x, y) — вектор признаков (joint feature map)](https://image.slidesharecdn.com/presentationssvmandcoursework2012-130210190001-phpapp01/85/SVM-4-320.jpg)

![Пример: сегментация изображения

x y yi

xi

F (x, y; w) = log p(y|x; w) = −E(y|x; w)

= ypk · wk ψp (x) + [yp = yq ] · wsm ψpq (x)

p k p p,q

= w Ψ(x, y)

Функция потерь:

∆(y, y ) = [y = y ] (0/1-loss)

ˆ ˆ

∆(y, y ) = p [yp = yp ]

ˆ ˆ

... Intersection/Union, HAC, etc.](https://image.slidesharecdn.com/presentationssvmandcoursework2012-130210190001-phpapp01/85/SVM-5-320.jpg)

![Глобальные ограничения

Пример: статистики по всем переменным

Методы оптимизации: SMD [Osokin & Vetrov, 2011], ...](https://image.slidesharecdn.com/presentationssvmandcoursework2012-130210190001-phpapp01/85/SVM-8-320.jpg)