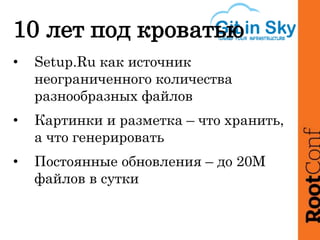

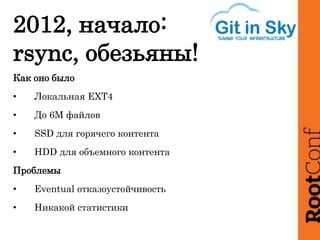

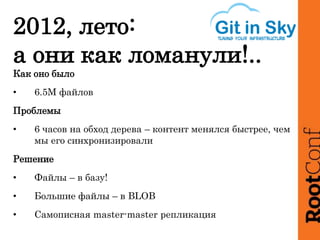

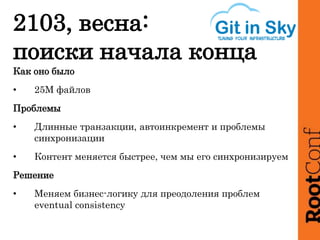

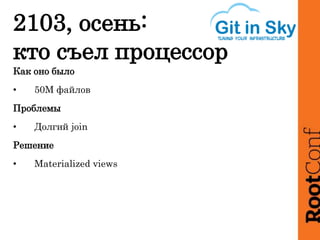

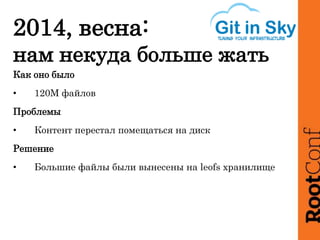

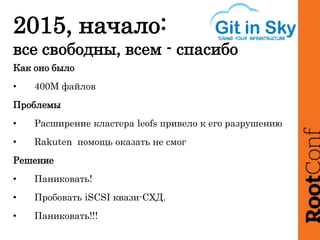

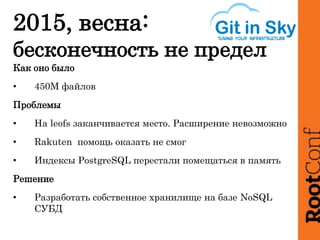

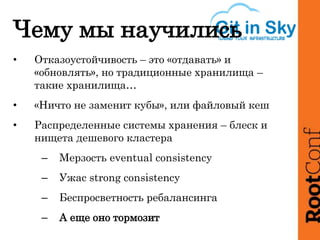

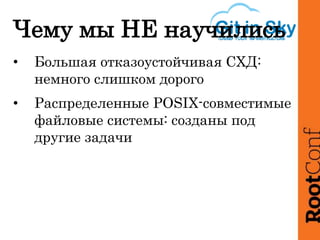

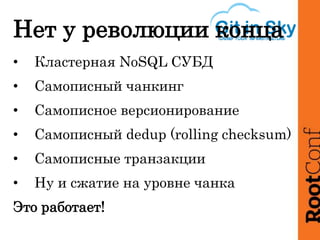

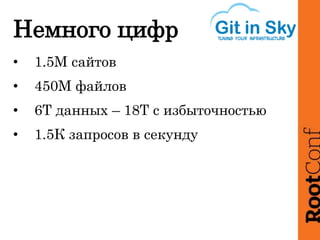

Документ описывает опыт построения и эксплуатации большого файлового хранилища, включая проблемы с управлением файлами и их быстрым обновлением. Он выделяет важные моменты, такие как необходимость изменения бизнес-логики и использование различных технологий для управления большими объемами данных. В итоге представлена статистика, указывающая на масштаб хранилища и объем операций.