More Related Content Similar to LAB-ゼミ資料-1-20150413

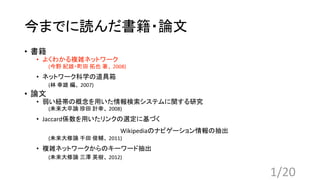

Similar to LAB-ゼミ資料-1-20150413 (20) 1. 今までに読んだ書籍・論文

• 書籍

• よくわかる複雑ネットワーク

(今野 紀雄・町田 拓也 著、 2008)

• ネットワーク科学の道具箱

(林 幸雄 編、 2007)

• 論文

• 弱い紐帯の概念を用いた情報検索システムに関する研究

(未来大卒論 珍田 計幸、 2008)

• Jaccard係数を用いたリンクの選定に基づく

Wikipediaのナビゲーション情報の抽出

(未来大修論 千田 俊輔、 2011)

• 複雑ネットワークからのキーワード抽出

(未来大修論 三澤 英樹、 2012)

1/20

3. よくわかる複雑ネットワーク

一章 つながりの世界

• 6次の隔たり

• ランダムに選ばれた二人が案外少ない人数を介して結ばれること

• ミルグラムのスモールワールド実験

• 確率、頻度、割合

• 0〜1の間の値、全て足すと1になる

• 片対数グラフ、両対数グラフ

• 片対数グラフ … 通常のグラフの縦軸or横軸を対数軸にしたもの

• 両対数グラフ … 通常のグラフの立軸と横軸両方を対数軸にしたもの

3/20

4. よくわかる複雑ネットワーク

二章 ネットワークの基礎

• ネットワーク … “点” と ”線” で表す

• 次数 … 点につながっている線の数

• 次数分布 … 各次数の頂点数の割合

• 平均次数 … 字数分布の平均値

1!

"

#

+ 2 !

"

&

+ 3 !

"

#

+ 4 !

"

&

=

𝟕

𝟑

字数:4

字数:2 V1

V6

V4

V5

V2

V3

次数 1 2 3 4

頂点の割合 1

3

1

6

1

3

1

6

字数分布の表

字数:3

字数:1

字数:3

字数:1

4/20

5. よくわかる複雑ネットワーク

二章 ネットワークの基礎

• 頂点間距離… 2頂点を行き来するための最小ステップ

• V6 -‐> V4の頂点間距離 … l(V6, V4) = 2

• V1 -‐> V5の頂点間距離 … l(V1, V5) = 1

• 平均頂点間距離 … 頂点間距離の平均値

L =

/

0(023)

5

S … 頂点間距離の合計

n … 頂点の数

n(n-‐1)/2 … 異なる2頂点の組み合わせ総数

V1

V6

V4

V5

V2

V3

5/20

6. よくわかる複雑ネットワーク

二章 ネットワークの基礎

• 平均頂点間距離の計算

(V1, V2)=1、(V1, V3)=1、(V1, V4)=2、(V1, V5)=1、(V1, V6)=1

(V2, V3)=2、(V2, V4)=3、(V2, V5)=1、(V2, V6)=2

(V3, V4)=1、(V3, V5)=1、(V3, V6)=2

(V4, V5)=2、(V4, V6)=3

(V5, V6)=2 計 S = 25

L =

/

0(023)

5

=

67

8(823)

5

=

7

#

V1

V6

V4

V5

V2

V3

6/20

7. よくわかる複雑ネットワーク

二章 ネットワークの基礎

• クラスター係数

… 自分と繋がっている点同士が繋がっているかどうかの指標

Ci =

頂点9:を頂点に持つ三角形の数

;: ;: <" /6

(𝐾? ≥ 2)

Ci … クラスター係数

Ki … 頂点Viの次数

• C1 =

6(△93959B, △939D9B)

E E<" /6

=

"

#

、C2 =

"(△93959B)

6 6<" /6

= 1

V1

V6

V4

V5

V2

V3

7/20

11. よくわかる複雑ネットワーク

四章 ランダムグラフ

• ランダム・グラフ … 各頂点の間に、ランダムに枝を置いてできる

• 次数分布

p(k) = L<" 𝐶N 𝑝N

(1 − 𝑝)L<"<N

※[np]で、二項分布のグラフは最大値を示す

(npが整数の場合は、np、np-‐1で最大値を取る)

• 平均次数

𝑘 = (n-‐1)p

k … 次数

n … 頂点数

P … 枝を張る確率

11/20

12. よくわかる複雑ネットワーク

五章 スモールワールド

• WSモデル

… 規則的なネットワークの枝を繋ぎかえて構成される

• 修正WSモデル

… 規則的なネットワークに枝を加えて構成される

WSモデル 拡張WSモデル

構成方法 もともある枝を繋ぎかえる 新たに枝を付け加える

枝の総数 変わらない 増加する

pを増加させた際の振る舞い ランダムグラフに近づく 完全グラフに近づく

連結性 非連結になる場合がある 必ず連結になる

※ 円環・拡張版円環をベースに構成する

… aを偶数として右隣a/2個、左隣a/2個の頂点と枝で繋がっている

12/20

13. よくわかる複雑ネットワーク

五章 スモールワールド

• WSモデル作成の手順

1. 任意の枝を選び、どちらかの頂点の片方と枝を切り離す

2. 以下の禁則事項の元、切り離した枝を任意の頂点と繋ぎなおす

• 自分自身には繋がない

• 左右a/2個以内の頂点には繋がない

• 左右a/2個以内の頂点を除いたものの内、既に繋がっている頂点には繋がない

※ WSモデルができないこともある

• 頂点数3、a=2、p=1のケース … 三角形

-‐> 枝の繋ぎかえが全て禁則事項に当てはまる

13/20

14. よくわかる複雑ネットワーク

五章 スモールワールド

• 次数分布

一点分布 … 次数が一種類しかないネットワークの字数分布

• 平均字数

𝑘 =

𝑆(ネットワーク次数の総和)

𝑛(頂点数)

• 平均頂点間距離

L ∝ log 𝑛

• クラスター係数

C ∝ 1

p 0 ↔ 1

次数分布 一点分布 ⇔ ポアソン分布

スモールワールドとは

1. 平均頂点間距離 … 小

2. クラスター係数 … 大

14/20

15. よくわかる複雑ネットワーク

六章 スケールフリーネットワーク

• スケールフリーネットワーク

• 一部の頂点が膨大な枝を持つ一方、ほとんどの頂点がごく少数の枝しか

持っていないネットワーク

※字数分布がベキ乗に従う

• BAモデル(Barabashi and Albert)

• 「成長」と「優先的選択」によりネットワークが作成される

… 新しい頂点が追加し、枝を張ることでネットワークが大きくなっていく

例)インターネットのハイパーリンク

15/20

18. よくわかる複雑ネットワーク

七章 様々な複雑ネットワーク

• 閾値モデル

• 各頂点に重みを与え、2頂点の重みの和がある値θより大きいとき枝を置く

※スターが出現する可能性がある

• スター … すべての頂点とつながっている頂点

• スター以外の頂点はスターとしか繋がっていないネットワークの発生条件

1. スターの重みがθ以上

2. スター以外の重みがθに比べてはるかに小さい

18/20

19. よくわかる複雑ネットワーク

七章 様々な複雑ネットワーク

• 頂点非活性化モデル

• 活性化状態と非活性化状態の状態の頂点が存在するネットワーク

• 頂点非活性モデルの作り方

1. 活性化状態の頂点を追加する

2. 追加した頂点と、活性化状態のすべての頂点を枝で繋ぐ

3. 活性化頂点のひとつを非活性化状態にする

• 非活性化状態にするための選択確率

P(𝑘?) =

3

k: l m

∑

3

kY l mmno:pq

19/20