More Related Content

PPTX

[DL輪読会]Neural Ordinary Differential Equations PDF

PDF

PDF

論文紹介:Dueling network architectures for deep reinforcement learning PPTX

PDF

[DL輪読会]Deep Learning 第15章 表現学習 PDF

[DL輪読会]Deep Learning 第2章 線形代数 PPTX

勾配ブースティングの基礎と最新の動向 (MIRU2020 Tutorial) What's hot

PDF

PDF

[DL輪読会]SlowFast Networks for Video Recognition PPTX

PDF

ゼロから始める深層強化学習(NLP2018講演資料)/ Introduction of Deep Reinforcement Learning PDF

PPTX

Curriculum Learning (関東CV勉強会) PPTX

【DL輪読会】The Forward-Forward Algorithm: Some Preliminary PDF

三次元点群を取り扱うニューラルネットワークのサーベイ PDF

PDF

PDF

【DL輪読会】Poisoning Language Models During Instruction Tuning Instruction Tuning... PDF

PPTX

Swin Transformer (ICCV'21 Best Paper) を完璧に理解する資料 PDF

Transformerを用いたAutoEncoderの設計と実験 PDF

PPTX

有向グラフに対する 非線形ラプラシアンと ネットワーク解析 PDF

ディープラーニングの2値化(Binarized Neural Network) PPTX

PDF

PPTX

Similar to 深層学習入門 スライド

DOCX

PDF

PDF

PDF

深層学習(岡本孝之 著) - Deep Learning chap.1 and 2 PPTX

Deep learning basics described PDF

PDF

深層学習 勉強会第1回 ディープラーニングの歴史とFFNNの設計 PDF

ディープラーニング入門 ~ 画像処理・自然言語処理について ~ PDF

PPTX

Machine Learning Fundamentals IEEE PDF

PDF

PPTX

PPTX

PDF

深層学習(岡本孝之 著)Deep learning chap.4_1 PDF

PDF

PDF

[DL Hacks] Deterministic Variational Inference for RobustBayesian Neural Netw... PDF

[第2版]Python機械学習プログラミング 第13章 PDF

Recently uploaded

PDF

Reiwa 7 IT Strategist Afternoon I Question-1 Ansoff's Growth Vector PDF

PDF

100年後の知財業界-生成AIスライドアドリブプレゼン イーパテントYouTube配信 PDF

さくらインターネットの今 法林リージョン:さくらのAIとか GPUとかイベントとか 〜2026年もバク進します!〜 PDF

第21回 Gen AI 勉強会「NotebookLMで60ページ超の スライドを作成してみた」 PDF

Reiwa 7 IT Strategist Afternoon I Question-1 3C Analysis PDF

Starlink Direct-to-Cell (D2C) 技術の概要と将来の展望 PPTX

PDF

2025→2026宙畑ゆく年くる年レポート_100社を超える企業アンケート総まとめ!!_企業まとめ_1229_3版 深層学習入門 スライド

- 1.

- 2.

- 3.

- 4.

- 5.

X1

x2

x3

x4

u1,z1

u2z2

u3 z3

z1

z2

z3

入力

𝑢1 =𝑤11 𝑥1 + 𝑤12 𝑥2 + 𝑤13 𝑥3 + 𝑤14 𝑥4 + 𝑏1

𝑢2 = 𝑤21 𝑥1 + 𝑤22 𝑥2 + 𝑤23 𝑥3 + 𝑤24 𝑥4 + 𝑏2

𝑢3 = 𝑤31 𝑥1 + 𝑤32 𝑥2 + 𝑤33 𝑥3 + 𝑤34 𝑥4 + 𝑏3

𝑢4 = 𝑤41 𝑥1 + 𝑤42 𝑥2 + 𝑤43 𝑥3 + 𝑤44 𝑥4 + 𝑏4

↓

𝑢𝑗 = 𝑖=1

𝐼

𝑤𝑗𝑖 𝑥𝑖 + 𝑏𝑗

出力 𝑧𝑗 = 𝑓(𝑢𝑗)

→ ベクトルと行列を用いて 𝑢 = 𝑊𝑥 + 𝑏

𝑧 = 𝑓(𝑢)

- 6.

# coding:Shift-JIS

import numpyas np

# 重みWを設定する(出力素子が3つの場合)

W = np.array([[0.5,0.3,0.6,0.7],[0.9,0.2,0.8,0.4],[0.1,0.2,0.9,0.4]])

# 与えるデータxを設定する

x = np.array([0.2,0.6,0.8,0.7])

# バイアスbを設定する

b = np.array([1,2,3])

# ユニットが受け取る総入力uを定義

# メモ np.dotで、行列の掛け算の計算ができる!

u = np.dot(W,x) + b

print(u)

> [ 2.25 3.22 4.14]

- 7.

- 8.

正規化線形関数 線形写像(恒等写像)

𝑓 𝑢= max 𝑢, 0 𝑓 𝑢 = 𝑢

−1 (𝑢 < −1)

𝑓 𝑢 = 𝑢 −1 ≤ 𝑢 < 1

1 (𝑢 ≥ 1)

http://mathtrain.jp/rampfunction

- 9.

# さっきの続き

# 活性化関数を定義(ロジスティックシグモイド関数)

defsigmoid(u):

return 1 / (1 + np.exp(-1 * u))

# vfをロジスティックシグモイド関数でベクトル的に定義

vf = np.vectorize(sigmoid)

# vf(u)を出力

print("ロジスティックシグモイド関数")

print(vf(u))

# 双曲線正接関数はnumpyに定義されているからそのまま使う

# 双曲線正接関数の結果を出力

print("双曲線正接関数")

print(np.tanh(u))

- 10.

# 活性化関数を定義(正規化線形関数)

def rectified(u):

returnmax(u,0)

# vfを正規化線形関数でベクトル的に定義

vf = np.vectorize(rectified)

# vf(u)を出力

print("正規化線形関数")

print(vf(u))

>ロジスティックシグモイド関数

[ 0.90465054 0.96158001 0.98432671]

双曲線正接関数

[ 0.97802611 0.99681228 0.99949305]

正規化線形関数

[ 2.25 3.22 4.14]

- 11.

多層ネットワーク

入力層(𝑙 = 1)データxを入力

中間層 𝑙 = 2

𝑢(2)

= 𝑊(2)

𝑥 + 𝑏(2)

, 𝑧(2)

= 𝑓(𝑢 2

)

出力層 𝑙 = 3

𝑢(3) = 𝑊(3) 𝑥(2) + 𝑏(3) , 𝑧(3) = 𝑓(𝑢 3 )

一般化すると・・・

𝑢(𝑙+1)

= 𝑊(𝑙+1)

𝑥(𝑙)

+ 𝑏(𝑙+1)

, 𝑧(𝑙+1)

= 𝑓 𝑢 𝐿+1

最終的な出力

𝑦 ≡ 𝑧(𝑙)

x

𝑙 = 1 𝑙 = 2 𝑙 = 3

𝑧(1)

𝑧(2)

𝑧(3)

𝑦 = 𝑧(3)

- 12.

- 13.

- 14.

- 15.

- 16.

- 17.

- 18.

- 19.

- 20.

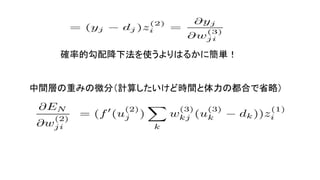

誤差関数に二乗誤差

𝐸 𝑤 =

1

2𝑗(𝑦𝑗 𝑥 − 𝑑𝑗) をとるとすると

重みでの微分

𝜕𝐸 𝑁

𝜕𝑤 𝑗𝑖

(3) と

𝜕𝐸 𝑁

𝜕𝑤 𝑗𝑖

(2) を計算しよう!

前提として、

これらは、 𝜕𝑤𝑗𝑖

(3)

には関係しない

- 21.

- 22.

- 23.

- 24.

- 25.

- 26.

- 27.

![# coding:Shift-JIS

import numpy as np

# 重みWを設定する(出力素子が3つの場合)

W = np.array([[0.5,0.3,0.6,0.7],[0.9,0.2,0.8,0.4],[0.1,0.2,0.9,0.4]])

# 与えるデータxを設定する

x = np.array([0.2,0.6,0.8,0.7])

# バイアスbを設定する

b = np.array([1,2,3])

# ユニットが受け取る総入力uを定義

# メモ np.dotで、行列の掛け算の計算ができる!

u = np.dot(W,x) + b

print(u)

> [ 2.25 3.22 4.14]](https://image.slidesharecdn.com/random-170830040410/85/slide-6-320.jpg)

![# 活性化関数を定義(正規化線形関数)

def rectified(u):

return max(u,0)

# vfを正規化線形関数でベクトル的に定義

vf = np.vectorize(rectified)

# vf(u)を出力

print("正規化線形関数")

print(vf(u))

>ロジスティックシグモイド関数

[ 0.90465054 0.96158001 0.98432671]

双曲線正接関数

[ 0.97802611 0.99681228 0.99949305]

正規化線形関数

[ 2.25 3.22 4.14]](https://image.slidesharecdn.com/random-170830040410/85/slide-10-320.jpg)

![確率的勾配降下法

サンプルの一部だけを使って勾配を計算し、パラメータの更新を行う

𝛻𝐸 ≡

𝜕𝐸

𝜕𝑤

= [

𝜕𝐸

𝜕𝑤1

⋯

𝜕𝐸

𝜕𝑤 𝑀

] 𝑇

𝑤(𝑡+1) = 𝑤(𝑡) − 𝜖𝛻𝐸 𝑛

→ 勾配降下法を計算するには、𝛻𝐸を計算しなければならない。

→ 偏微分の計算は、面倒だし、活性化関数wが入れ子になる。

→ この計算を高速化する方法を考えないと!](https://image.slidesharecdn.com/random-170830040410/85/slide-16-320.jpg)

![参考文献

[1] 岡谷 貴之:深層学習 (機械学習プロフェッショナルシリーズ)

[2] 堅田洋資他:フリーライブラリで学ぶ機械学習入門

他多数のWebページ](https://image.slidesharecdn.com/random-170830040410/85/slide-27-320.jpg)