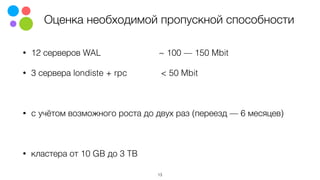

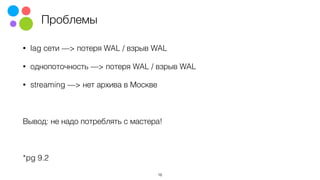

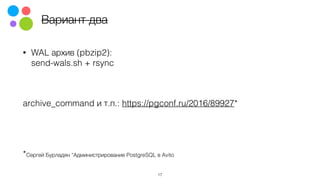

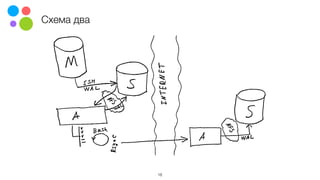

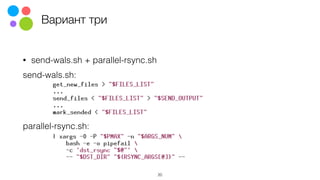

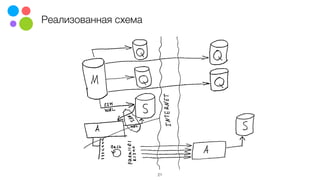

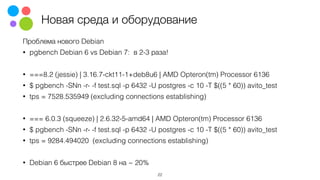

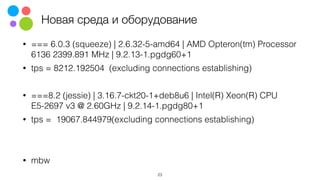

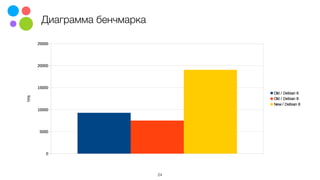

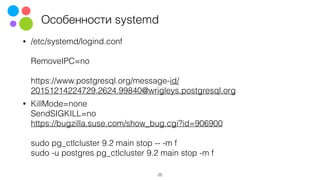

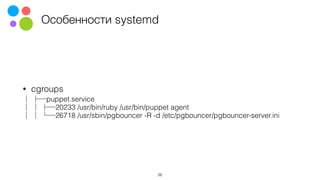

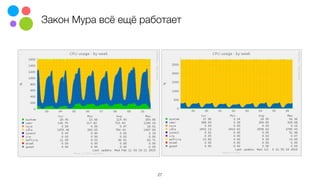

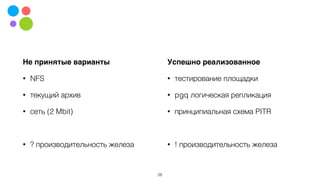

Документ обсуждает опыт миграции данных между дата-центрами, включая важные аспекты, такие как законодательные изменения, репликация для минимизации даунтайма и особенности работы с новым оборудованием. Упоминается о возможных сложностях, связанных с качеством сети и потерь данных, а также о проведенных нагрузочных тестах на различных версиях операционной системы и PostgreSQL. Авторы делают акцент на том, что некоторые подходы, такие как использование NFS и сетевые ограничения, оказались неэффективными.