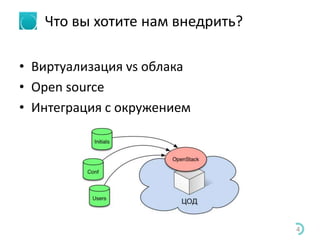

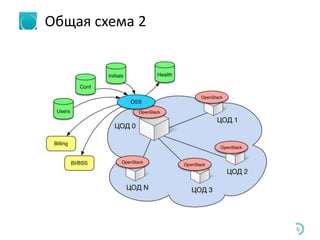

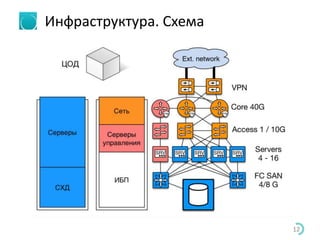

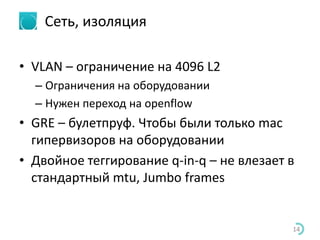

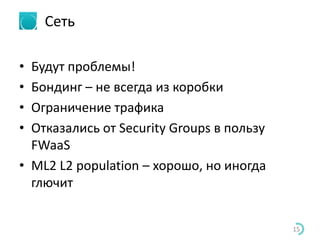

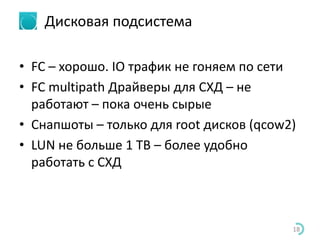

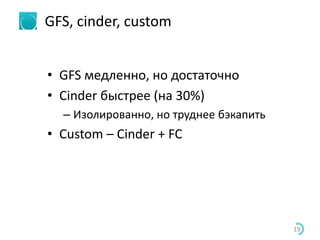

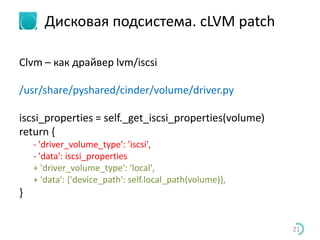

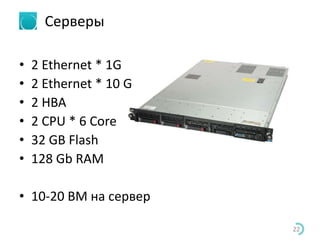

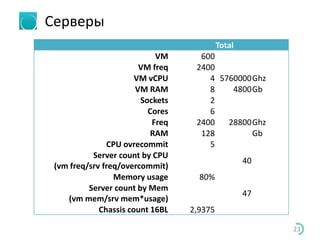

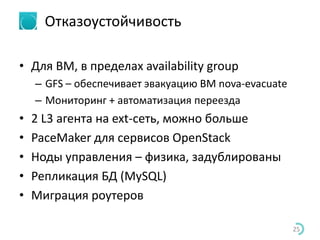

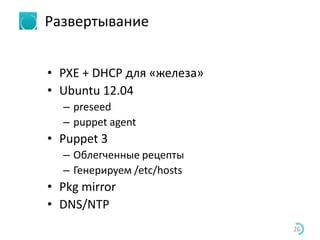

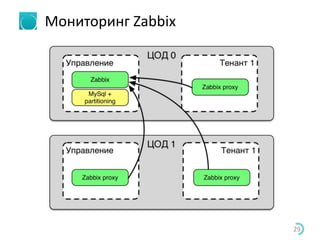

Документ описывает опыт внедрения инфраструктуры OpenStack с акцентом на технические детали и особенности задач, таких как интеграция с существующими системами и обеспечение защиты данных. Также рассмотрены компоненты системы, включая использование OpenSource технологий и описание сетевой инфраструктуры. В заключение, затрагиваются проблемы и решения в процессе развертывания, мониторинга и резервного копирования.