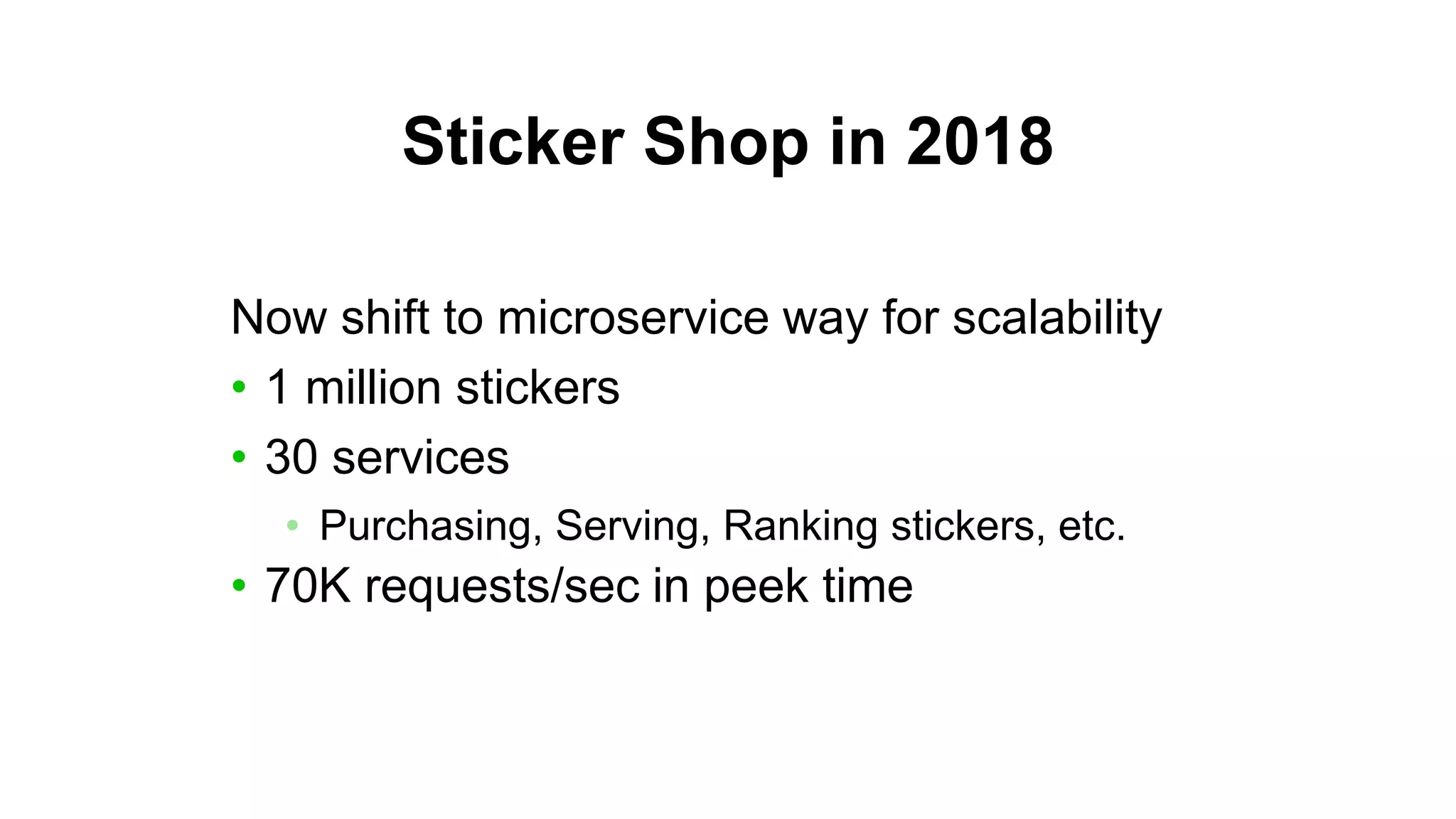

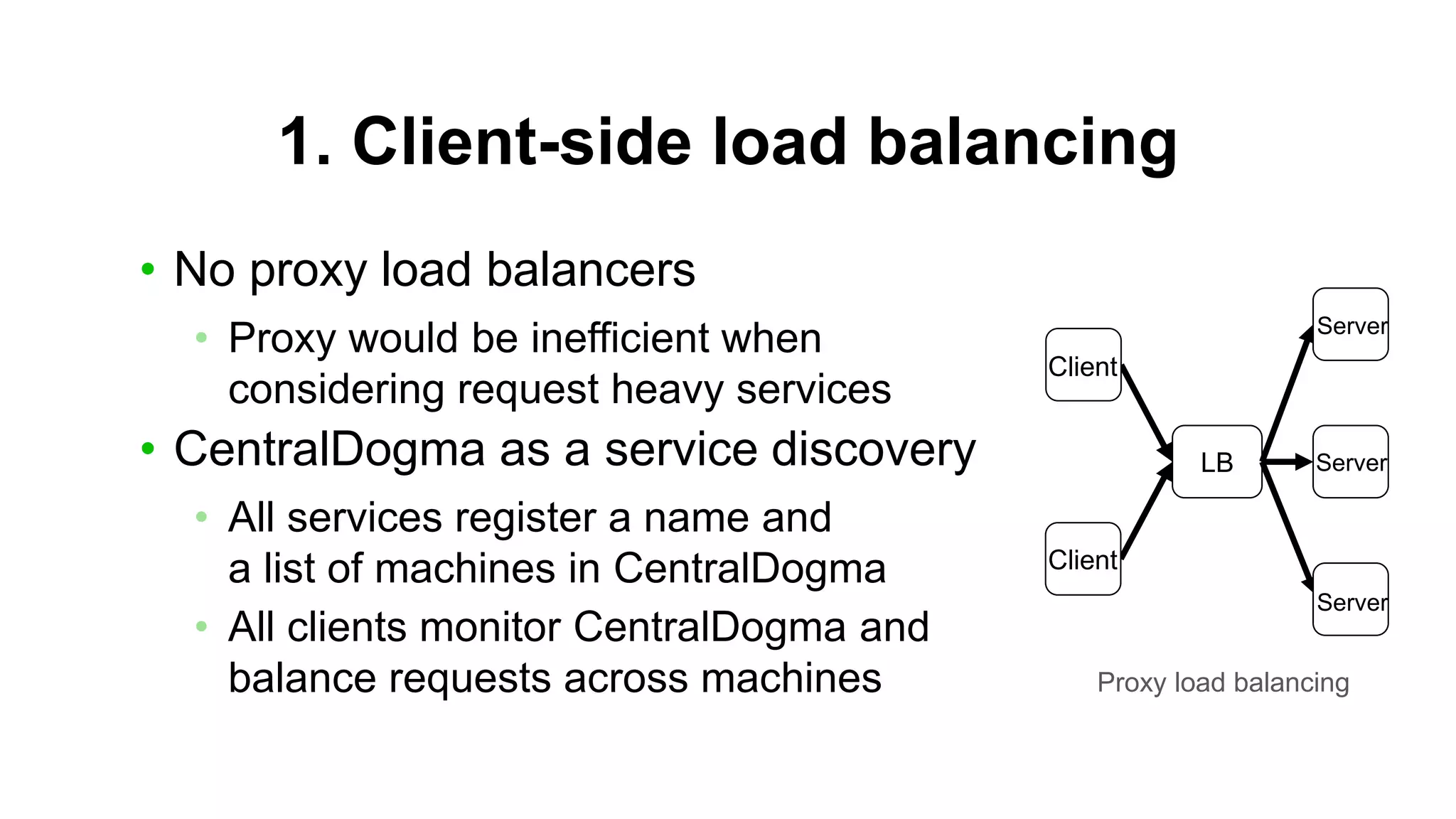

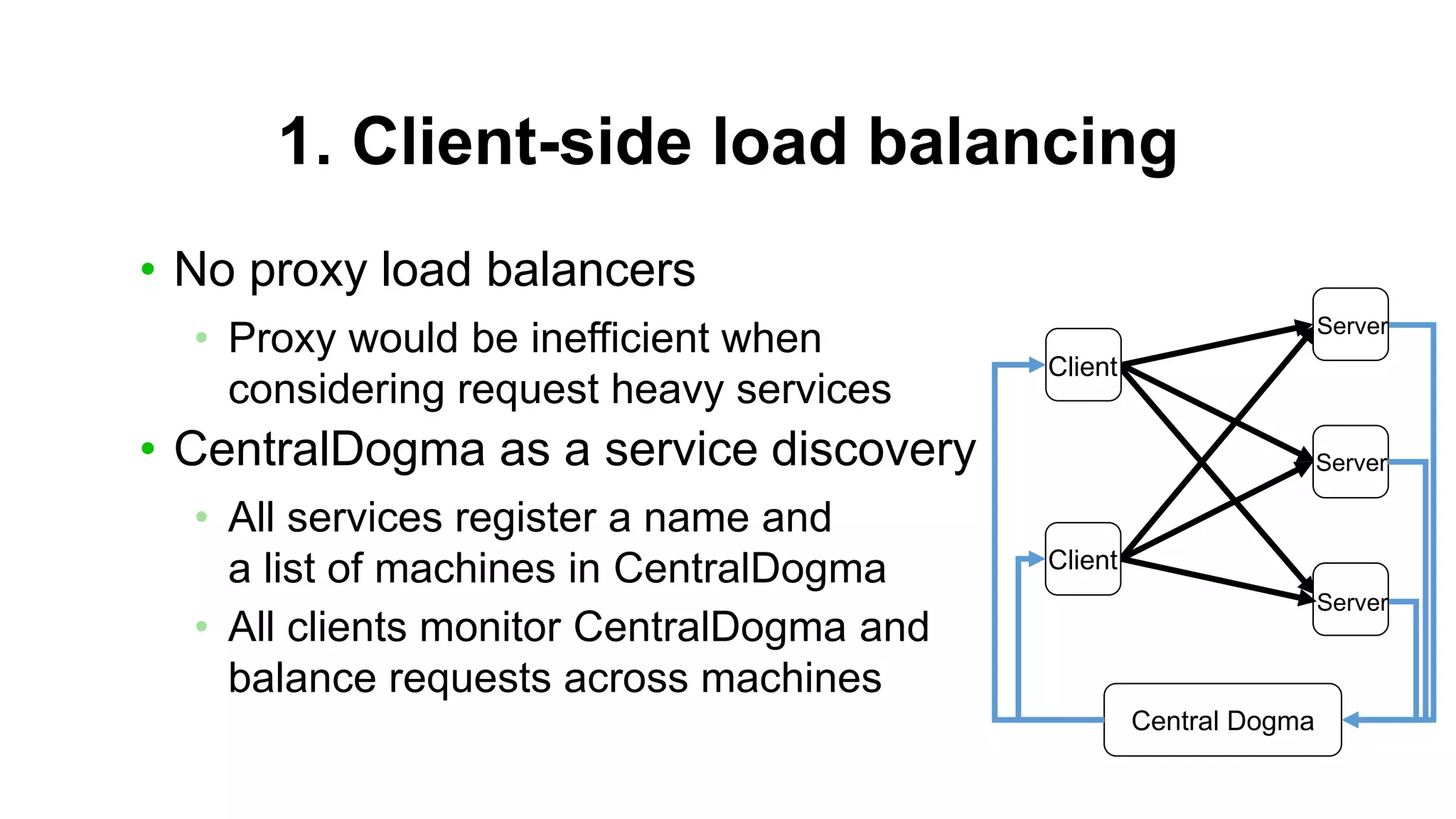

This document summarizes the architecture of LINE's Sticker Shop backend server. It discusses how the server has shifted from a monolithic Java application to a microservices architecture with 30 services using technologies like Armeria, Central Dogma, Zipkin, and others. Key aspects covered include client-side load balancing, circuit breakers to avoid cascading failures, distributed tracing with Zipkin, and using Central Dogma for stable feature rollouts in 10 minutes or less.