More Related Content

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PPTX

What's hot

PPTX

PDF

PDF

PDF

PDF

PDF

PDF

PPTX

PDF

PDF

PDF

PDF

PDF

PDF

PRML ベイズロジスティック回帰 4.5 4.5.2 PPTX

PDF

PPTX

PDF

PDF

[DL輪読会]Deep Learning 第15章 表現学習 PDF

Similar to PRML輪読#9

PDF

PDF

PDF

Bishop prml 9.3_wk77_100408-1504 PPTX

PDF

PDF

PDF

PDF

PDF

PDF

PPTX

PDF

PDF

PRML2.3.8~2.5 Slides in charge PPTX

PDF

[PRML] パターン認識と機械学習(第1章:序論) PPTX

[The Elements of Statistical Learning]Chapter8: Model Inferennce and Averaging PDF

Bishop prml 10.2.2-10.2.5_wk77_100412-0059 PDF

Data-Intensive Text Processing with MapReduce ch6.1 PDF

Pattern Recognition and Machine Learning study session - パターン認識と機械学習 勉強会資料 PPTX

PILCO - 第一回高橋研究室モデルベース強化学習勉強会 PRML輪読#9

- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

9.1 K-Meansアルゴリズム 〜アルゴリズムの数式化〜

•アルゴリズムの⽬的

– データ集合: 𝑥", 𝑥$, … , 𝑥& (𝑥&: 多次元ベクトルデータ)とするとき

– N個のデータ𝑥" ~ 𝑥&をK個のグループに分類する

• ⽬的関数J

– 1対K符号化法を⽤いて割り当てを表現すると⽬的関数は下の式

– 𝜇+はプロトタイプと呼ばれるD次元のベクトル. クラスターの中⼼を表現.

– 𝑟-+はデータ点のクラスターへの割り当てを表す.

– 歪み尺度とも呼ばれ, 各データ点からそれらが割り当てられるベクトル𝜇+までの⼆乗距

離の総和を表現する。

• アルゴリズム概要

– 最初に𝜇+の初期値を選ぶ。

– 𝜇+を固定しつつ𝑟-+についてJを最⼩化する。(EMアルゴリズムのEステップ)

– 𝑟-+を固定しつつ𝑢+についてJを最⼩化する。(EMアルゴリズムのMステップ)

6

- 7.

- 8.

9.1 K-meansアルゴリズム 〜アルゴリズムの詳細(2)〜

• (2) 𝑟-+を固定して𝜇+を最適化

– ⽬的関数は

– Jを𝜇+に関する2次関数なので𝜇+に関して偏微分し0と置くことで最⼩化できる。

8

Jについて展開:

偏微分して整理:

偏微分の式=0

𝜇+についてまとめる

k番⽬のクラスターに割り当てられた

全てのデータ点の平均値と解釈できる

- 9.

9.1 K-meansアルゴリズム 〜K-meansアルゴリズムの特徴〜

•K-meansアルゴリズムの特徴

– 各探索の繰り返しにおいて, 各データ点が1つのクラスターだけに割り当てられる

• = ハード割り当て

• データ点の割り当て

– ハード割り当て

• 各データ点を1つのクラスターだけに割り当てる

– ソフト割り当て

• データ点のクラスターへの割り当ての不明瞭さへの度合いを⽤いた曖昧性を含んだ割り当て

9

- 10.

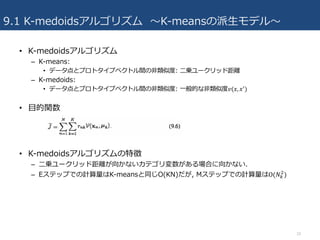

9.1 K-medoidsアルゴリズム 〜K-meansの派⽣モデル〜

•K-medoidsアルゴリズム

– K-means:

• データ点とプロトタイプベクトル間の⾮類似度: ⼆乗ユークリッド距離

– K-medoids:

• データ点とプロトタイプベクトル間の⾮類似度: ⼀般的な⾮類似度𝑣(𝑥, 𝑥1)

• ⽬的関数

• K-medoidsアルゴリズムの特徴

– ⼆乗ユークリッド距離が向かないカテゴリ変数がある場合に向かない.

– Eステップでの計算量はK-meansと同じO(KN)だが, Mステップでの計算量はΟ(𝑁+

$

)

10

- 11.

9.1.1 画像分割と画像圧縮 〜K-meansの実⽤例〜

•画像分割

– 任意のKに対して, 各画素ベクトルを割り当てられたクラスター中⼼𝜇+で与えられる

RGBの輝度の3つの組で置き換えることで画像の書き直し(画像分割ができる)

• 次ページの図9.3を参考に

• 画像圧縮

– K-meansアルゴリズムはN個のデータ点が割り当てられるクラスターのインデックスを

保存する形で画像圧縮に適⽤できる。

– 圧縮による情報量の差

• 元画像が{R, G, B}の各8ビットの値からなるN個の画素数を持つとき

• 圧縮しない場合の全ビット数: 24Nビット

• 圧縮する場合の全ビット数: 24K + Nlog$ 𝐾ビット

11

- 12.

- 13.

- 14.

- 15.

9.2 混合ガウス分布 〜潜在変数を⽤いた定式化(2)〜

•同時分布

• xの周辺分布

– zのすべての場合について和を取ると

– 𝑝 𝑥 = 𝜋" 𝑁(𝑥|𝜇", ∑ ) + ⋯ + 𝜋C 𝑁 𝑥 𝜇C, ∑ )C" = ∑𝜋+ 𝑁(𝑥|𝜇+, ∑ )+

• 周辺分布𝑝(𝑥)ではなく, 同時分布𝑝 𝑥, 𝑧 を使って議論できることが確認でき

た。

15

- 16.

- 17.

9.2.1 混合ガウス分布の最尤問題の課題

• 混合ガウス分布の最尤推定の特異性

–対数尤度関数が無限⼤に発散する問題が特異性が常に存在する

– 混合モデルにおいて⼀つの混合要素が特定のデータ点に収束, 分散が0に近くにつれて

対数尤度を増加させる⽅向に進み, 過学習の原因となる.

– 10章のベイジアンアプローチを適⽤すれば解決できる.

• 混合ガウスモデルの最尤問題の識別不可能性

– K個の各混合要素が順番の⼊れ替えに対して同等にK個ある場合並び替えの通りはK!通りある.

– 任意の点についてK!-1個の等価な別の点が存在するので12章で連続潜在変数を議論するとき

に問題となる

– 良い密度モデルを⾒つける上では等価な点において同等に良い密度モデルとなるので, 問題は

ない.

17

- 18.

9.2.1 混合ガウス分布の最尤推定

• 観測したデータ集合𝑋= {𝑥", … , 𝑥&}に混合ガウス分布を当てはめる問題を考

える.

• 各データ点が独⽴に観測されると仮定すると,対数尤度関数は以下の式

• 最尤推定法では, この尤度が最⼤になるように確率密度関数のパラメータ

𝜋, 𝜇, ∑を求める.

– 混合ガウス分布の対数尤度は, 対数がガウス分布に直接作⽤するのではなく,ガウス分布

の和の対数になるので, 対数尤度の最⼤化を陽に解くことは難しい。

– EMアルゴリズムと呼ばれる効率的な繰り返し計算⼿法を利⽤する

18

- 19.

- 20.

- 21.

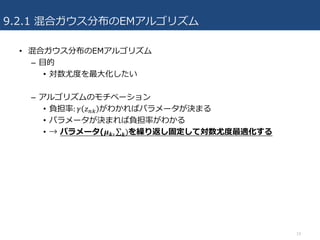

9.2.2 混合ガウス分布のEMアルゴリズム

• 同様に,共分散⾏列∑ に+ 関する偏微分を0とおいて

• 最後に, 混合係数𝜋+に関して最⼤化する

• ただし という制約条件を満たさなければいけないので

ラグランジュ未定乗数法を利⽤して, 以下の指標物を最⼤にする 𝜋+ を求める.

• (9.20)式を𝜋+で偏微分して0と置くと,

• これを𝜋+についてとくと

• すなわち, k番⽬の要素に関する混合係数は, その要素の全データ点に対する

負担率の平均で与えられる.

21

負担率による

重み付き共分散⾏列

対数尤度

制約条件

- 22.

9.2.2 混合ガウス分布のEMアルゴリズム 〜まとめ〜

•まとめると, 対数尤度を最⼤にする混合ガウス分布のパラメータは

• これらの式から負担率𝛾 𝑍-+ がわかればパラメータを求めることができるが,

負担率もパラメータに依存しているため⼀度に求めることができない。

• そこで負担率とパラメータを交互に繰り返し計算する。(EMアルゴリズム)

22

- 23.

- 24.

9.3 EMアルゴリズムのもう⼀つの解釈

• EMアルゴリズムの⽬的

–潜在変数を持つモデルについて最尤解(尤度が最⼤となる確率密度関数のパラメータ)を

求めること

• 𝑋: 観測データの集合

• 𝑍: 潜在変数データの集合

• 𝜃: 全ての確率密度関数のパラメータ組み

• 𝑝(𝑋, 𝑍|𝜃): パラメータ𝜃が与えられた元でのデータ組(X, Z)の尤度

– 対数尤度関数

• 完全集合と不完全集合

– Xの各観測に対して, 実際には⾒えない潜在変数Zの値がもらえるものと仮定するとき

– {X, Z}: 完全データ集合

– 実際の観測データX: 不完全

24

- 25.

9.3 EMアルゴリズムのもう⼀つの解釈 〜抽象的なEMアルゴリズム表現(2)〜

• 不完全データに対する対数尤度関数の最⼤化

– 実際には観測できない潜在変数Zの値が与えられた場合,

• {X, Z}: 完全データ集合,

• 𝑝(𝑋, 𝑍|𝜃): パラメータ𝜃が与えられた下でのデータ組(X, Z)の尤度

– 完全データの対数尤度ln 𝑝(𝑋, 𝑍|𝜃)の最⼤化は簡単にできると仮定する(最⼤にする𝜃が簡

単に求まる)

– しかし, 実際には不完全データXだけが与えられ、潜在変数Zについては事後確率

𝑝(𝑍|𝑋, 𝜃)だけがわかるので, 同時分布の対数尤度ln 𝑝(𝑋, 𝑍|𝜃)の代わりに, 𝑝(𝑍|𝑋, 𝜃)に関数

るln 𝑝(𝑍|𝑋, 𝜃)の期待値を考える。

25

- 26.

9.3 EMアルゴリズムのもう⼀つの解釈

• 不完全データに対する対数尤度関数の最⼤化アルゴリズム

–Eステップ

• 1. 現在のパラメータ推定値𝜃TUVを使って, 潜在変数の⾃⼰確率𝑝(𝑍|𝑋, 𝜃TUV)を求める.

• 2. 完全データ集合に対する対数尤度ln 𝑝(𝑋, 𝑍 |𝜃)の期待値を求める.

– Mステップ

• 3. 𝑄(𝜃)を最⼤にするパラメータ𝜃を求める⇨𝜃-XY

– 𝑙𝑛𝑝(𝑋, 𝑍| 𝜃) の最⼤化を簡単に計算できると仮定したので, その線形和で与えられる𝑄 𝜃

の最⼤化も簡単に計算できる。

• 9.3章では混合ガウス分布, 混合ベルヌーイ分布, ベイズ線計回帰, RVMを通

してEMアルゴリズムが多様な分布に適応できることを⽰す.

26

- 27.

9.3.1 混合ガウス分布再訪

• ⽬的

–混合ガウス分布のEMアルゴリズムを不完全データに対する対数尤度最⼤化で説明する。

• 混合ガウス分布における完全データ集合の尤度

– 混合ガウス分布

– 観測変数と潜在変数の同時分布

– 完全データ集合に対する尤度

27

- 28.

- 29.

- 30.

9.3.1 混合ガウス分布再訪(5)

• 混合ガウス分布のためのEMアルゴリズム

–1. 平均𝜇I, 分散 ∑ , 混合係数+ 𝜋+を初期化する

– 2. Eステップ: 現在のパラメータを使って負担率を計算する(潜在変数𝑍-+の

𝑝(𝑍-|𝑋-, 𝜇, ∑, 𝜋)に関する期待値)

– 3. Mステップ: 現在の負担率を使ってパラメータを更新する

• これらの更新式は, 完全データ集合対数尤度関数期待値はパラメータで偏微分して0と置くと

導出できる)

– 4. 収束基準を満たしていない場合, 2に戻って繰り返し計算する.

30

- 31.

9.3.2 K-meansとの関連

• 混合ガウス分布のモデルにおいて,各ガウス要素の共分散⾏列が𝜖𝐼で与えら

れる場合を考える.

• このとき, 負担率は

• 𝜖 → 0の極限を考えると, 分⺟は| 𝑥- − 𝜇` |が最⼩になるjに対して最も遠く0

に近づくため, 𝛾 𝑍-+ は| 𝑥- − 𝜇+ |が最⼩になるkに対して1に収束し, それ以

外に対しては0に収束する

• したがって, クラスへのハード割り当て(単⼀のガウス分布に各データを割

り当て)となり, K-meansクラスタリングと⼀致する(平均ベクトルの更新式

も⼀致とする)

– K-meansアルゴリズムをEMアルゴリズムの⾮確率的極限と解釈できる

31

- 32.

9.3.3 混合ベルヌーイ分布

• 混合ベルヌーイ分布(潜在クラス分析)

–混合ガウス分布: ガウス分布の線形和(連続値の分析)

– 混合ベルヌーイ分布: ベルヌーイの線形和(2値変数の分布)

• ベルヌーイ分布

– D個の2値変数からなるベクトル: 𝑥 = 𝑥", … , 𝑥a

b, 各変数は0/1のみとる

– ベルヌーイ分布のパラメータベクトル: 𝜇 = 𝜇", … , 𝜇a

b

– 𝜇が与えられているとき, 各変数𝑥cは独⽴である.(𝑝 𝑥 𝜇 が各変数の積で与えられるとき)

32

- 33.

- 34.

- 35.

- 36.

- 37.

- 38.

9.3.4 ベイズ線形回帰に関するEMアルゴリズム

• Eステップ

–𝛼と𝛽の現在の値に基づいてwの事後分布と期待完全データ対数尤度を計算する

• wの事後分布は

• 完全データ対数尤度は

• Mステップ

– wの事後分布について期待値をとって𝛼に関する微分を0とおくと,

– 𝛽についても同様の式が得られ, EMアルゴリズムによってベイズ線形回帰に関するエビ

デンス近似のパラメータを求められることを確認した。

38

- 39.

9.4 ⼀般のEMアルゴリズム

• 9.4章のゴール

–EMアルゴリズムが確かに尤度関数を極⼤化することを証明する

– 10章の変分推論の枠組みの基礎にもなる証明

• EMアルゴリズムの⽬的

– 観測されない潜在変数があるときの尤度関数最⼤化

– これを直接最適化することは難しいが, 完全データ対数尤度関数𝑙𝑛𝑝(𝑋, 𝑍|𝜃)の最適化は

容易であると仮定する。

• 尤度関数の分解

– ただし

39

- 40.

- 41.

- 42.

9.4 ⼀般のEMアルゴリズム

• EMアルゴリズム

–Eステップ

• 現在のパラメータ𝜃TUVを固定して𝑞(𝑍)について𝐿(𝑞, 𝜃)を最⼤化する.

• 下界を最⼤化するには𝐾𝐿(𝑞||𝑝)=0とすれば良い

• すなわち, 𝑞 𝑍 = 𝑝 𝑍 𝑋, 𝜃TUV)となる

– Mステップ

• 𝑞(𝑍)を固定して𝐿(𝑞, 𝜃)を𝜃について最⼤化し, 𝜃-XYを得る

• 𝑞(𝑍)は固定しているのでパラメータは𝜃TUVのままだが, 𝑝 𝑍 𝑋, 𝜃 のパラメータは𝜃-XYに更新す

る

• 対数尤度の期待値𝑄(𝜃, 𝜃TUV)が現れる.

– Mステップで⾏った𝐿(𝑞, 𝜃)の最⼤化= 𝑄(𝜃, 𝜃TUV)の最⼤化

42

- 43.

9.4 まとめ

• 混合ガウス分布に代表される潜在変数のモデルを説明した。

•潜在変数を⽤いたモデルの最尤推定を⾏うための効率的な⼿法がEMアルゴ

リズムである。

• EMアルゴリズムは, 混合ガウス分布だけでなく, 様々なモデルに適⽤できる

汎⽤的な⼿法である.

• Eステップ

– パラメータを固定し, 事後分布p(Z|X)を求める

• Mステップ

– 事後分布を固定し, 対数尤度関数の期待値を最⼤化するようにパラメータを決定

43

- 44.

参考資料

• パターン認識と機械学習 下

–C.M. ビショップ (著), 元⽥ 浩 (監訳), 栗⽥ 多喜夫 (監訳), 樋⼝ 知之 (監訳), 松本 裕治 (監訳), 村⽥ 昇 (監訳)

• 混合モデルとEMアルゴリズム (yamanaka, SlideShare)

– https://www.slideshare.net/takao-y/20131113-em

• PRML 第9章, 「混合モデルとEM」(菅原, SlideShare)

– https://www.slideshare.net/KeisukeSugawara/prml-em

44