出典:Ilya Tolstikhin, Neil Houlsby, Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Thomas Unterthiner, Jessica Yung, Andreas Steiner, Daniel Keysers, Jakob Uszkoreit, Mario Lucic, Alexey Dosovitskiy : Mlp-mixer: An all-mlp architecture for vision, Advances in Neural Information Processing Systems 34 (2021)

公開URL:https://arxiv.org/abs/2105.01601

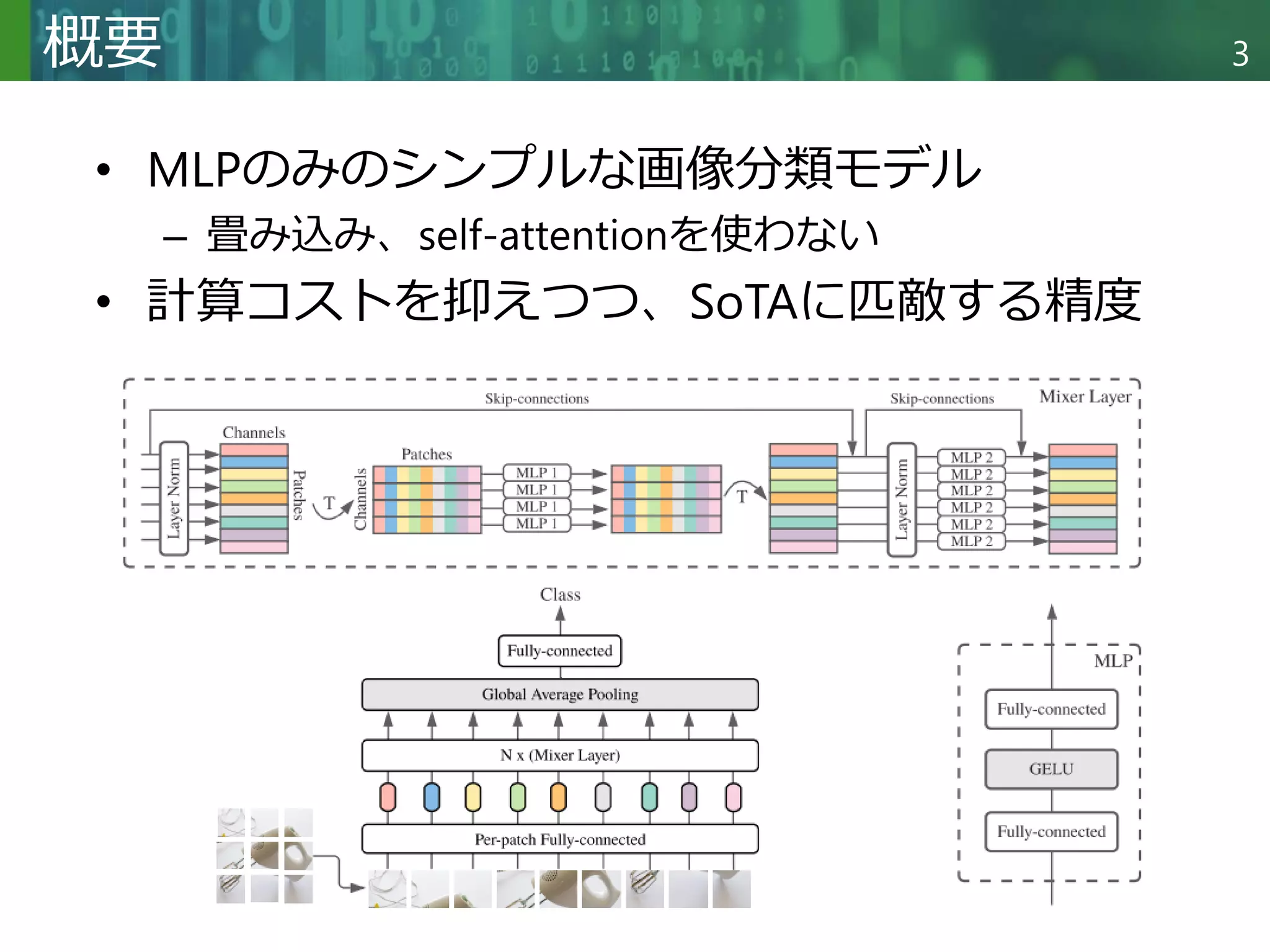

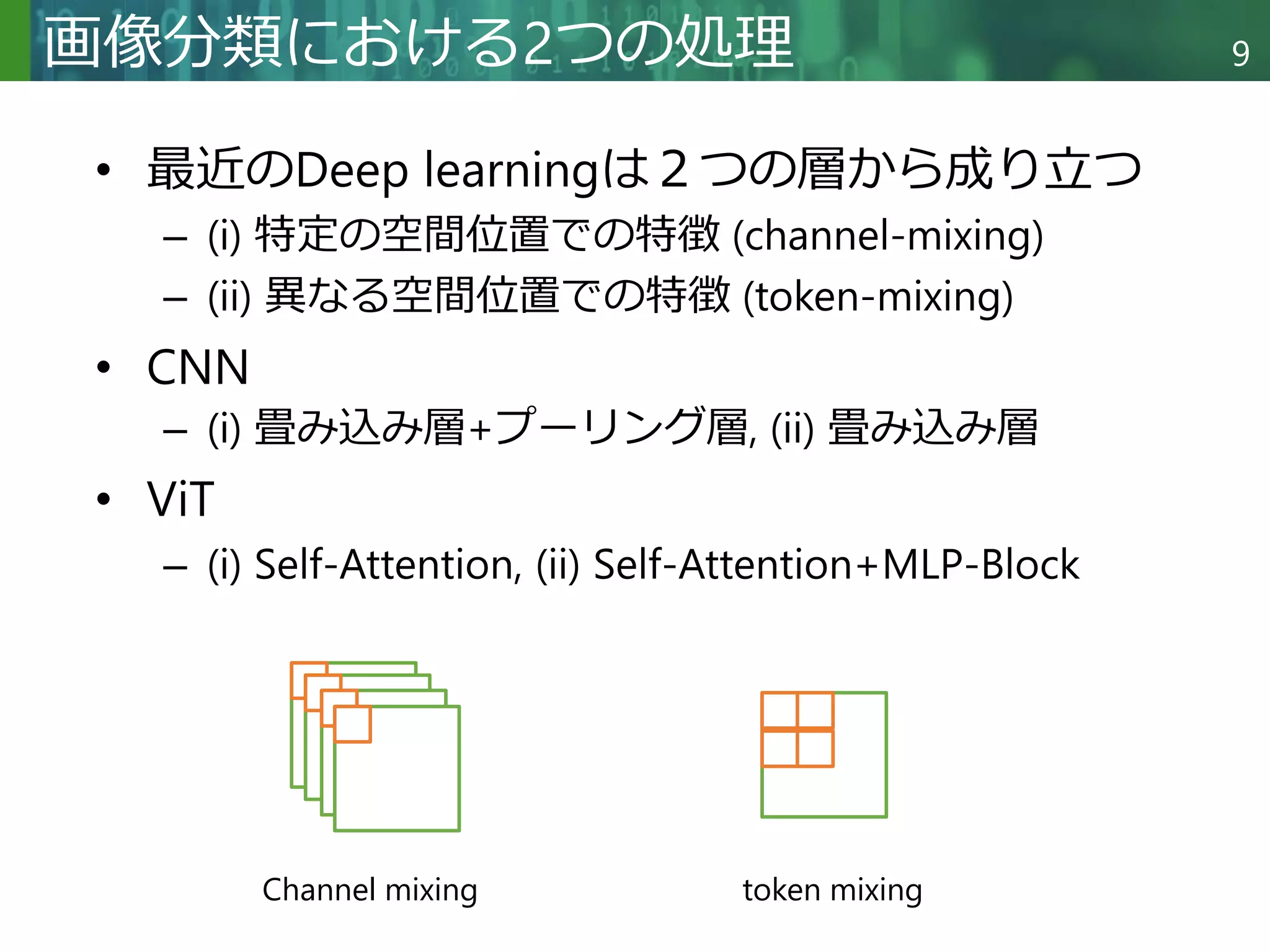

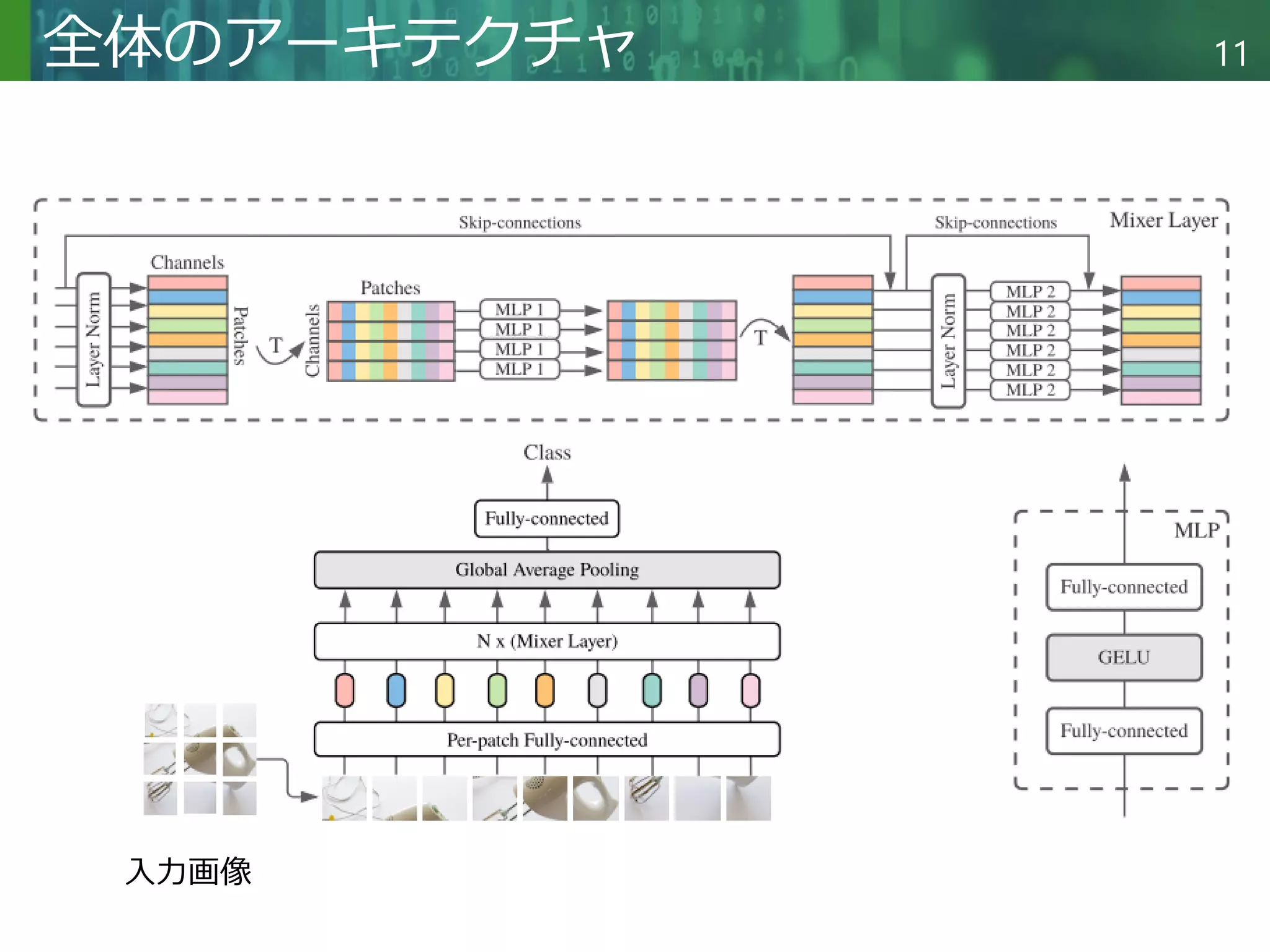

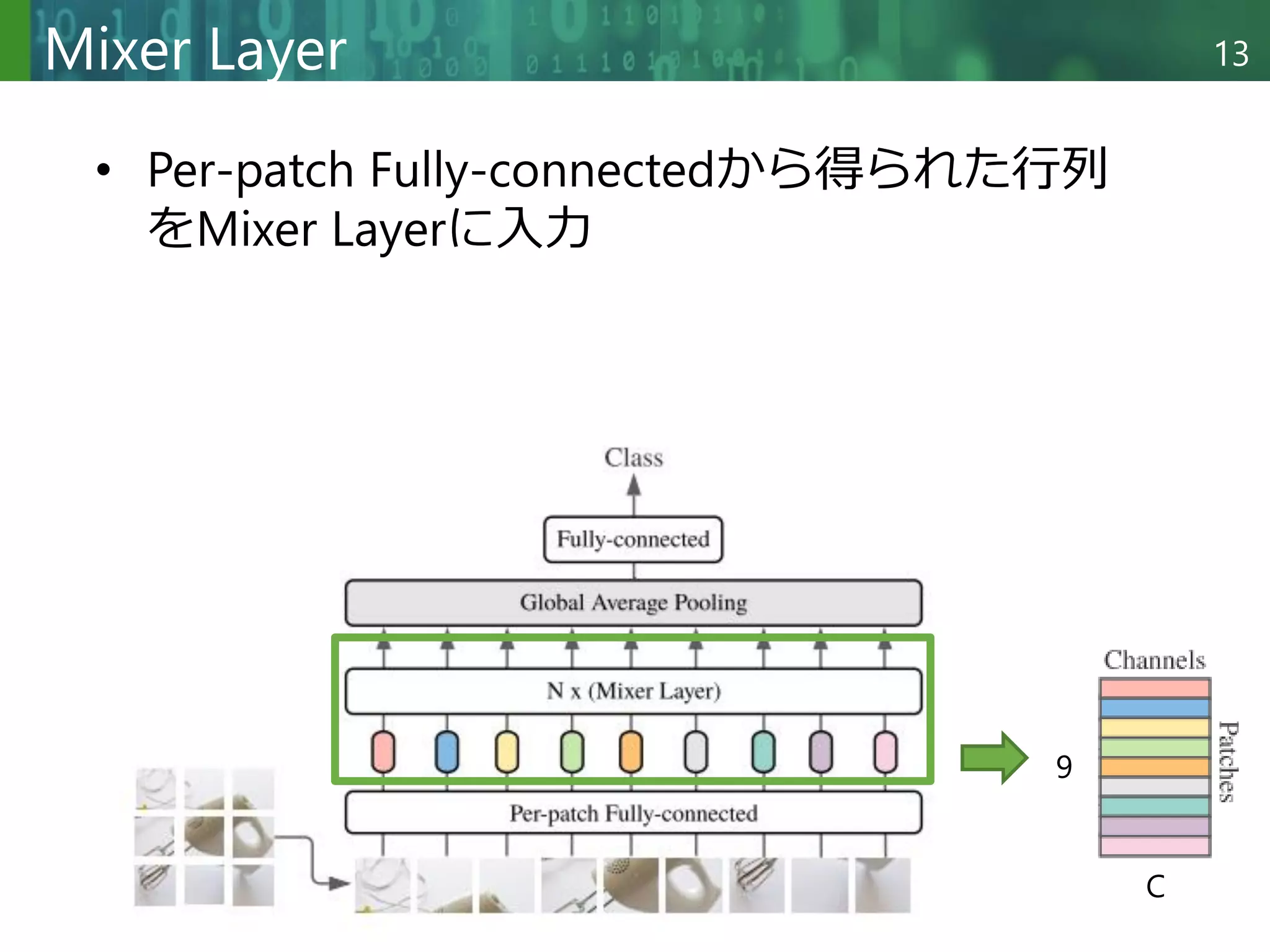

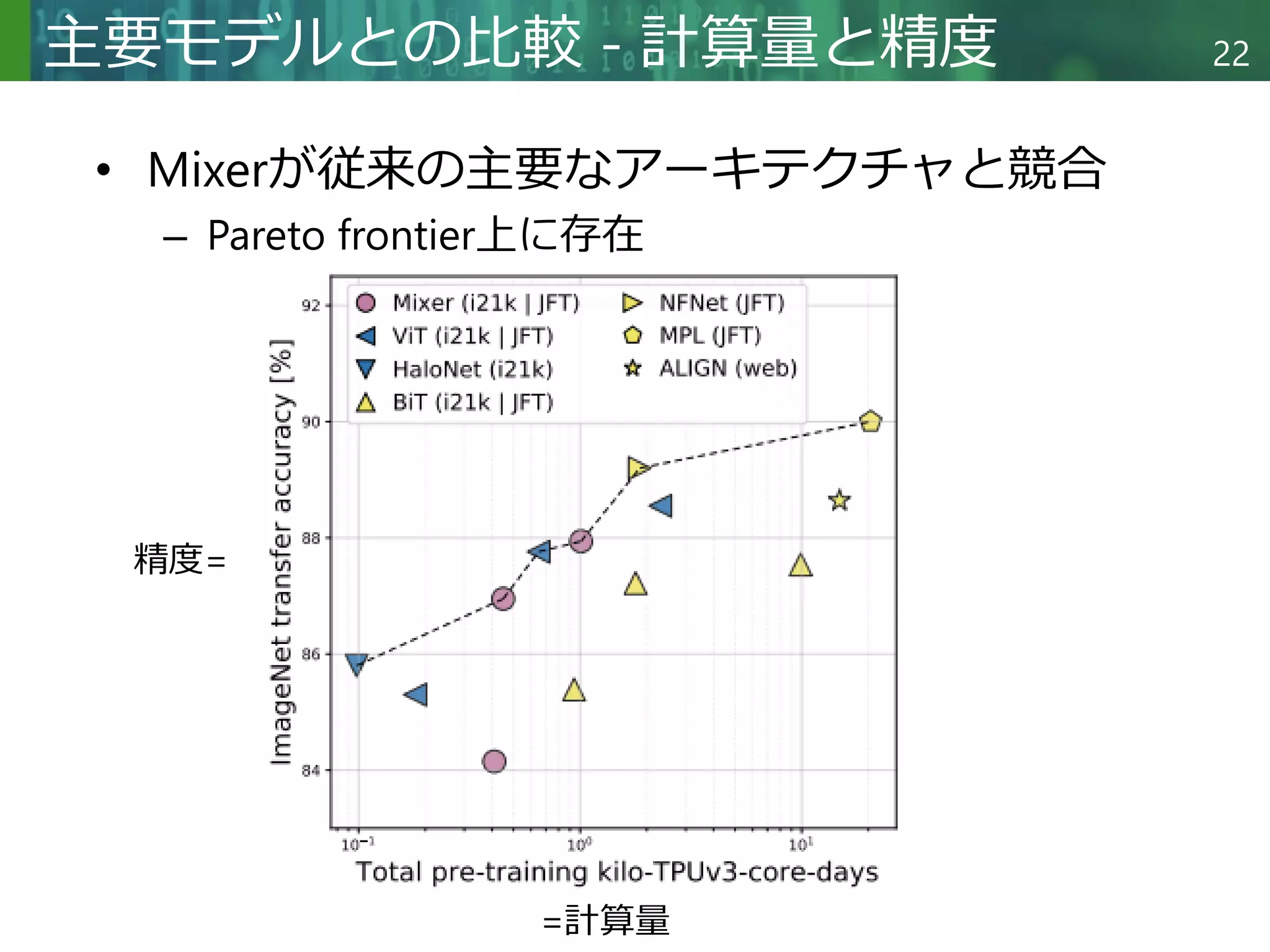

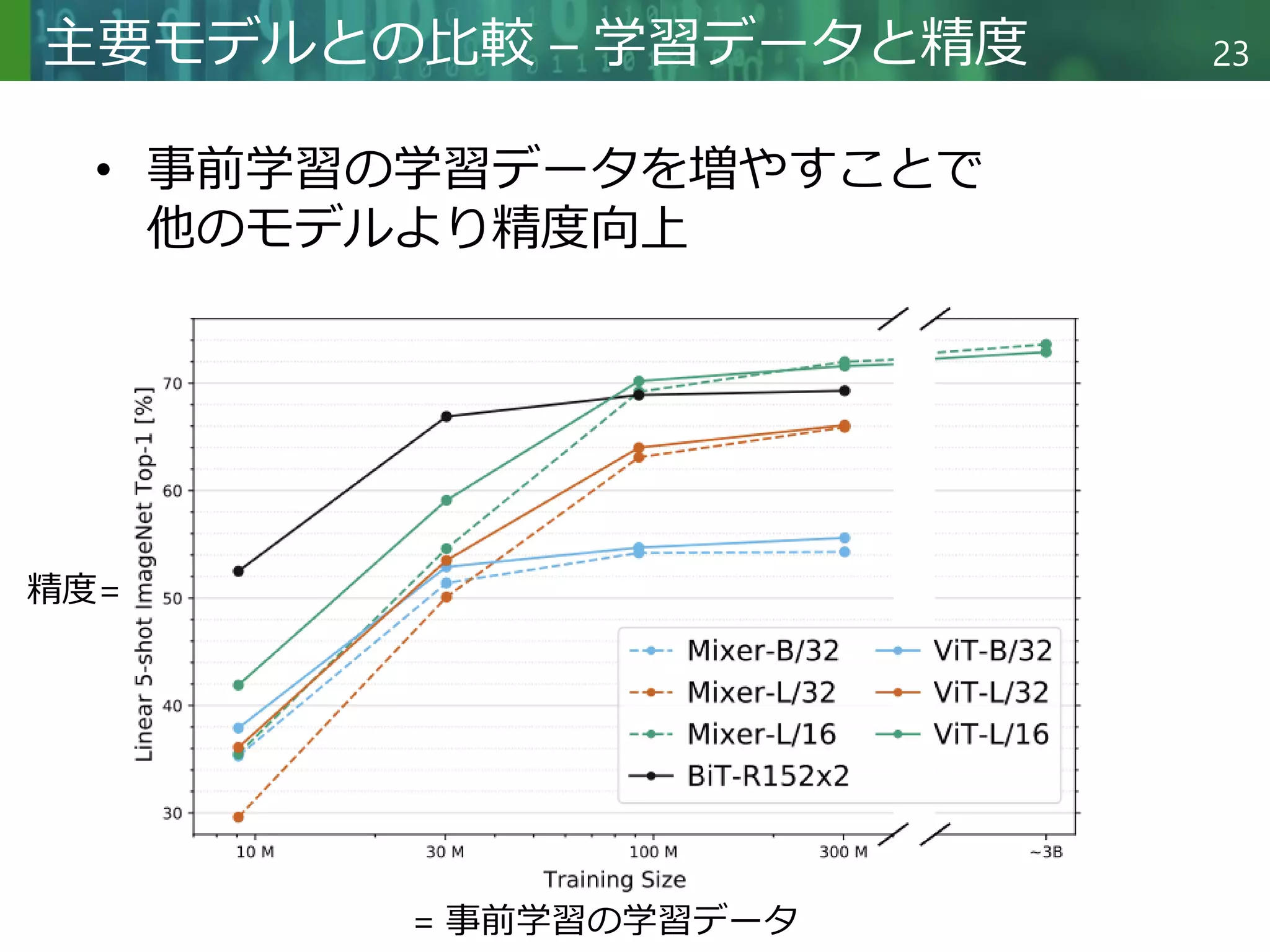

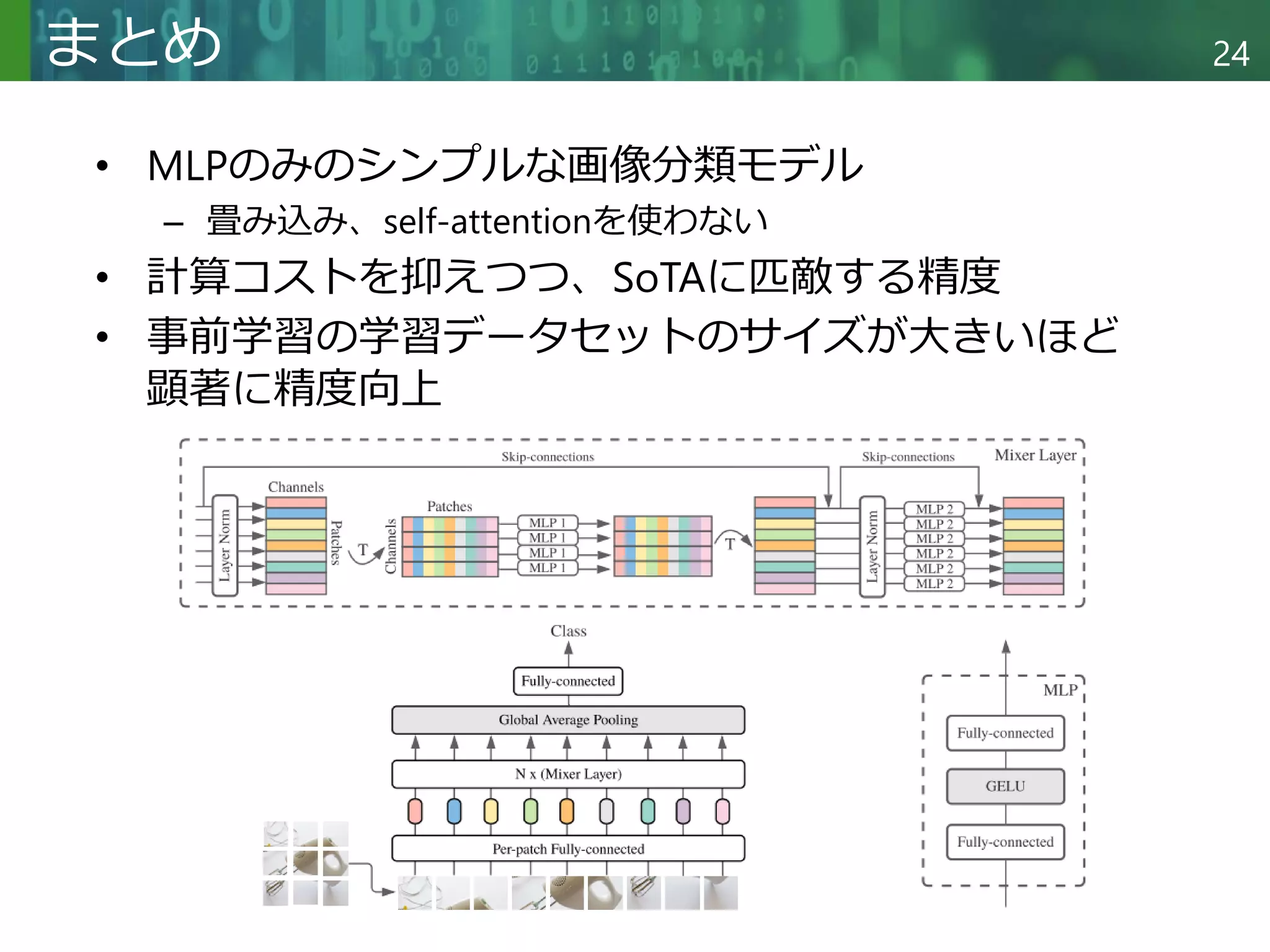

概要:最近の画像処理分野ではCNNやVision Transformerのようなネットワークが人気です。この論文では、多層パーセプトロン(MLP)のみで作成したアーキテクチャ"MLP-Mixer"を提案します。MLP-Mixerは2種類のレイヤーを保持しており、チャネルとトークン(位置)をそれぞれ別のMLPで学習しています。このモデルは画像分類ベンチマークにおいて、事前学習と推論コストが最新モデルに匹敵するスコアを達成しました

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

5

前提知識

• CNN: Convolutional Neural Network (畳み込

みニューラルネットワーク)

– 主なモデル: MobileNet, ResNet, EfficientNet

出典: https://cvml-expertguide.net/terms/dl/cnn/

一般的なCNNの処理内容

ResNetで使用される

残差ブロック(Residual Block)[1]

[1] He, Kaiming, et al. "Deep residual learning for image recognition." Proceedings

of the IEEE conference on computer vision and pattern recognition. 2016.](https://image.slidesharecdn.com/20220527dlseminarmori-220527044124-1f07b0c9/75/MLP-Mixer-An-all-MLP-Architecture-for-Vision-5-2048.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

6

前提知識

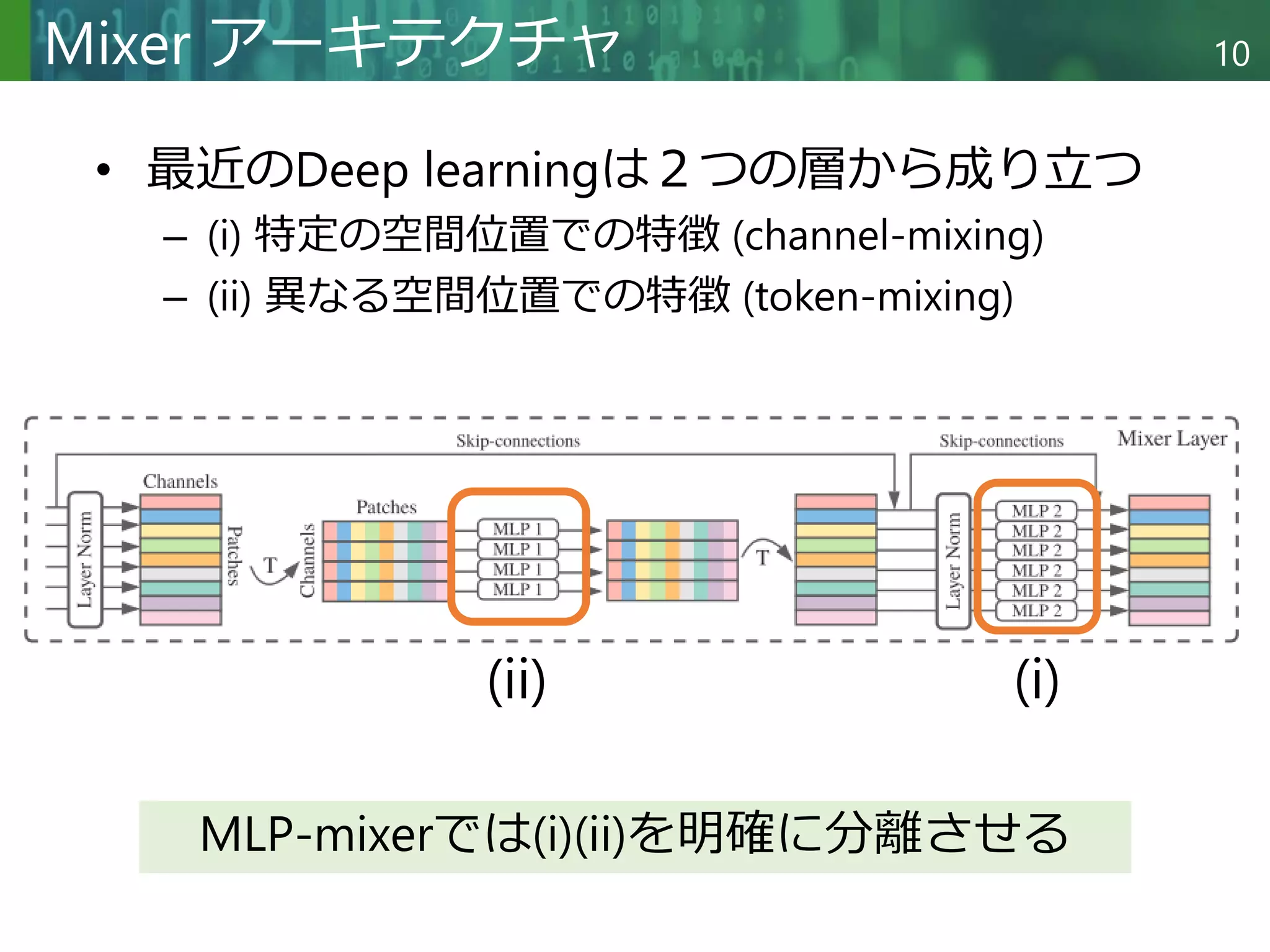

• ViT: Vision Transformer[2]

– Self-Attention[3]機構を画像分類に適用したもの

– 画像をパッチにして単語のように処理

[2] Dosovitskiy, Alexey, et al. "An image is worth 16x16 words: Transformers for image recognition at scale." arXiv preprint arXiv:2010.11929 (2020).

[3] Vaswani, Ashish, et al. "Attention is all you need." Advances in neural information processing systems 30 (2017).](https://image.slidesharecdn.com/20220527dlseminarmori-220527044124-1f07b0c9/75/MLP-Mixer-An-all-MLP-Architecture-for-Vision-6-2048.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

8

関連研究 – 画像分類の動向

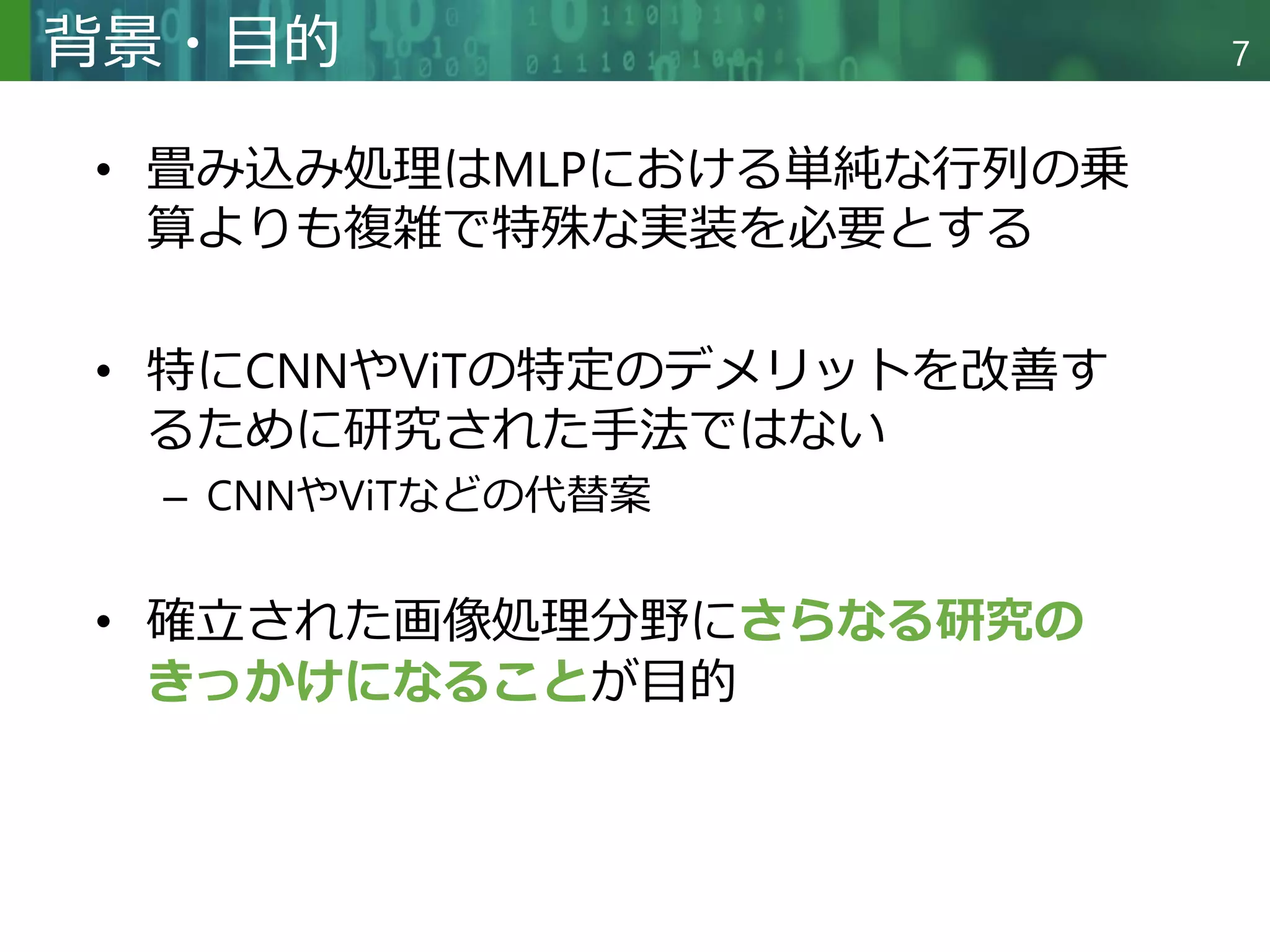

• CNN登場 (2012 - )

– 畳み込み機構を持ったモデルの研究が盛んに

– 最近の学習・オーグメンテーション戦略を用いれば以

前としてResNetが最先端の性能を持つ[4]

• ViTの登場 (2020 - )

– CNNの頑健性を保持しつつ、最先端の性能を達成

[4] Beyer, Lucas, et al. "Are we done with imagenet?." arXiv preprint arXiv:2006.07159 (2020).](https://image.slidesharecdn.com/20220527dlseminarmori-220527044124-1f07b0c9/75/MLP-Mixer-An-all-MLP-Architecture-for-Vision-8-2048.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

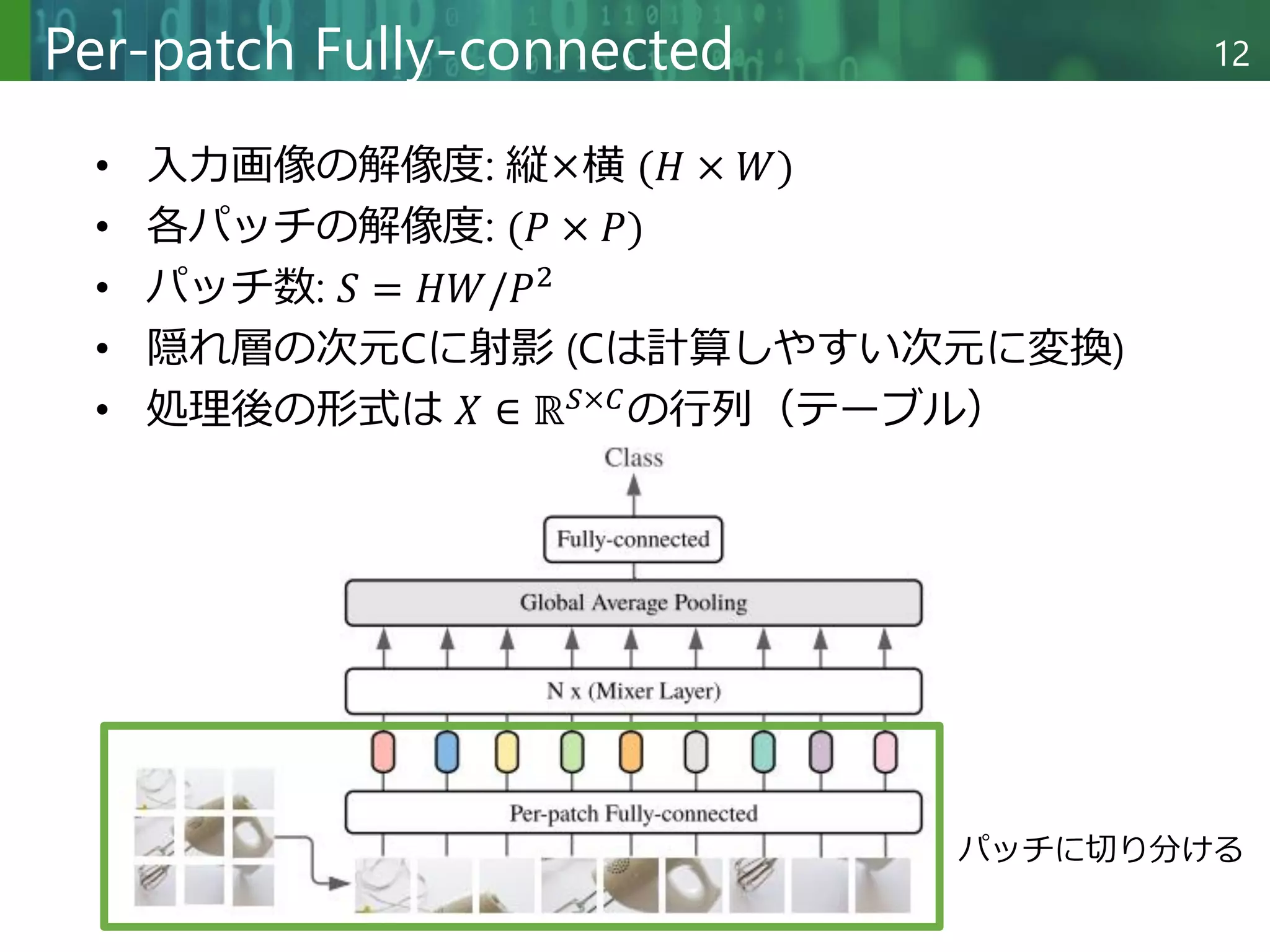

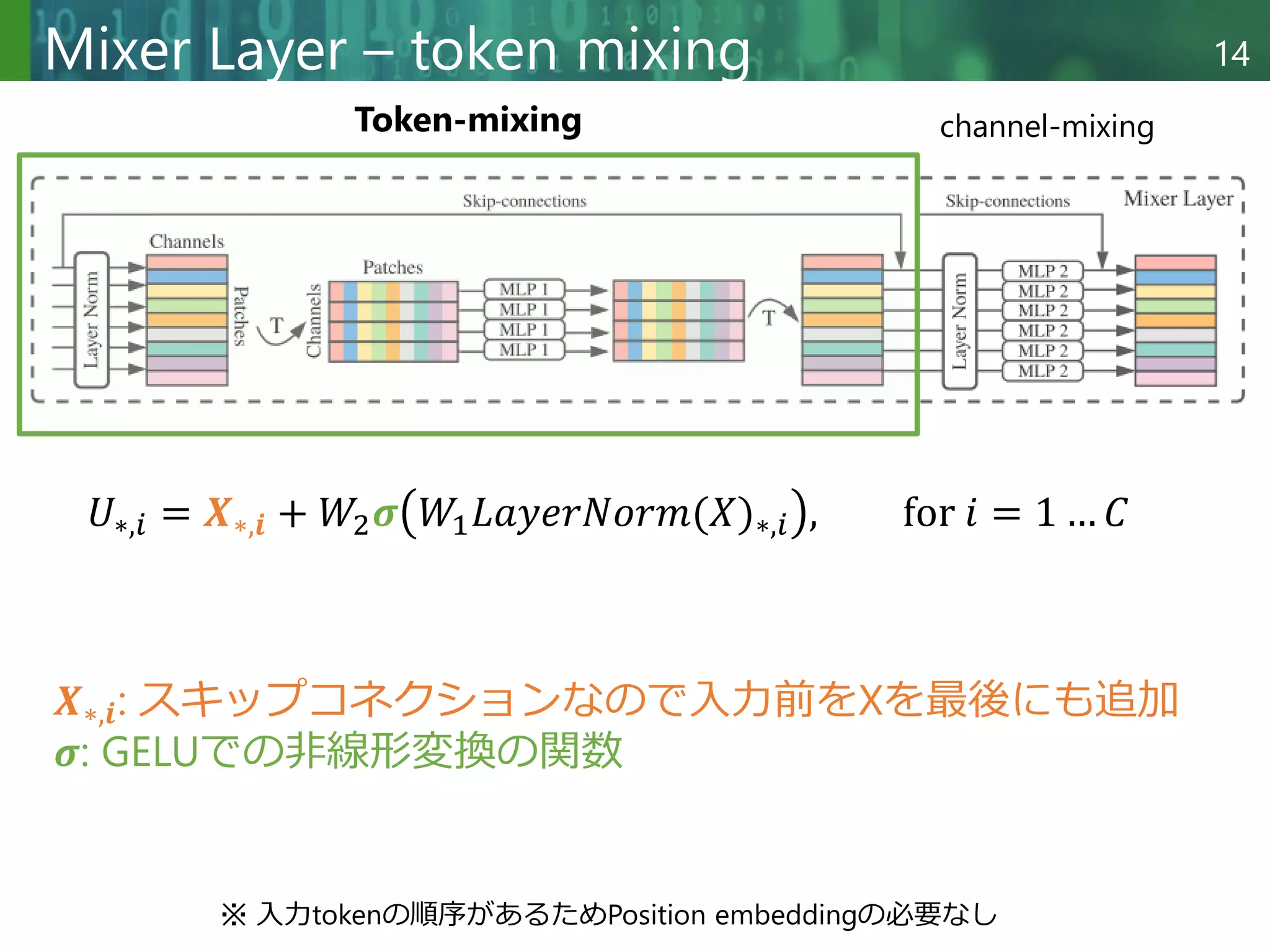

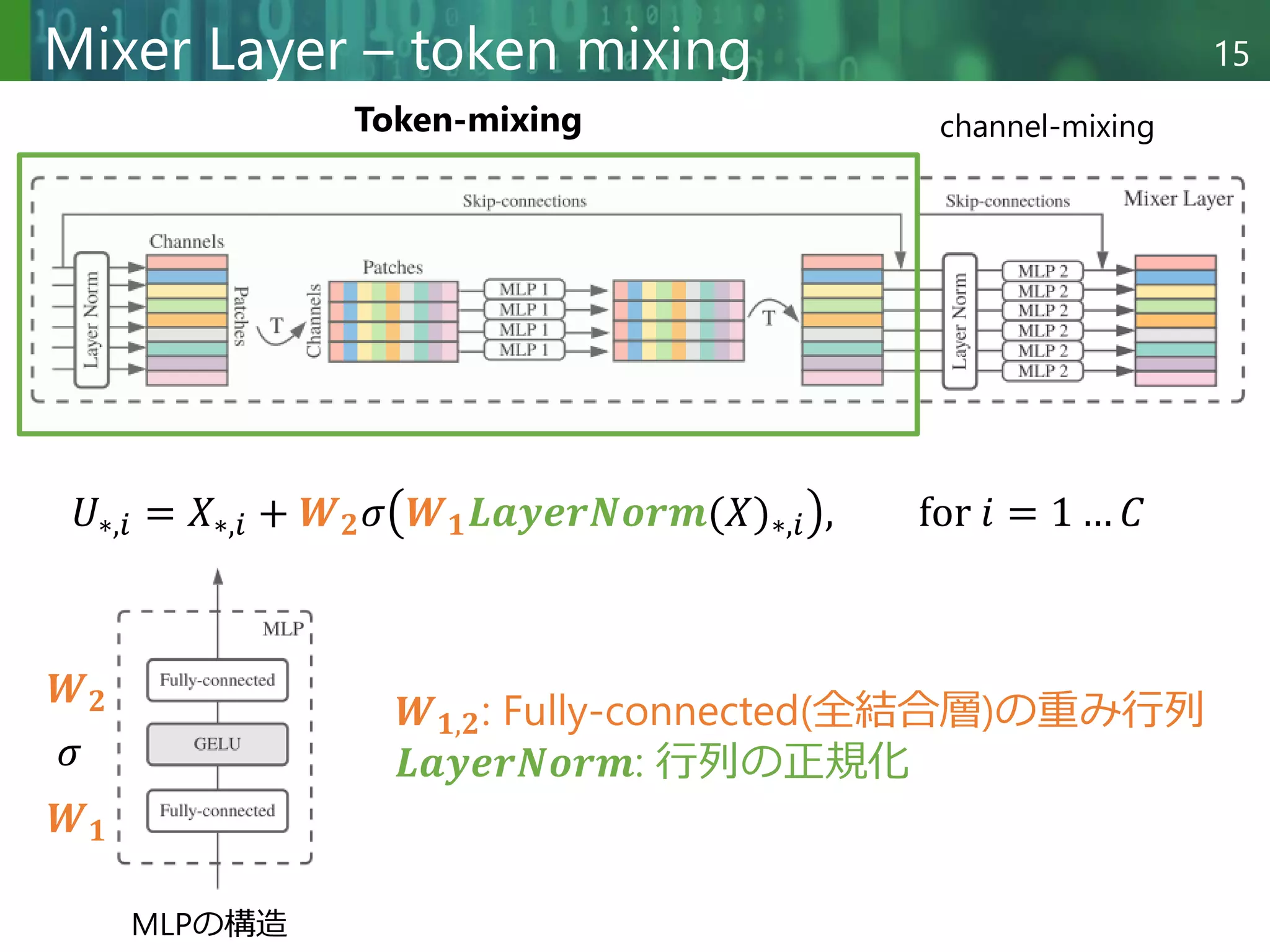

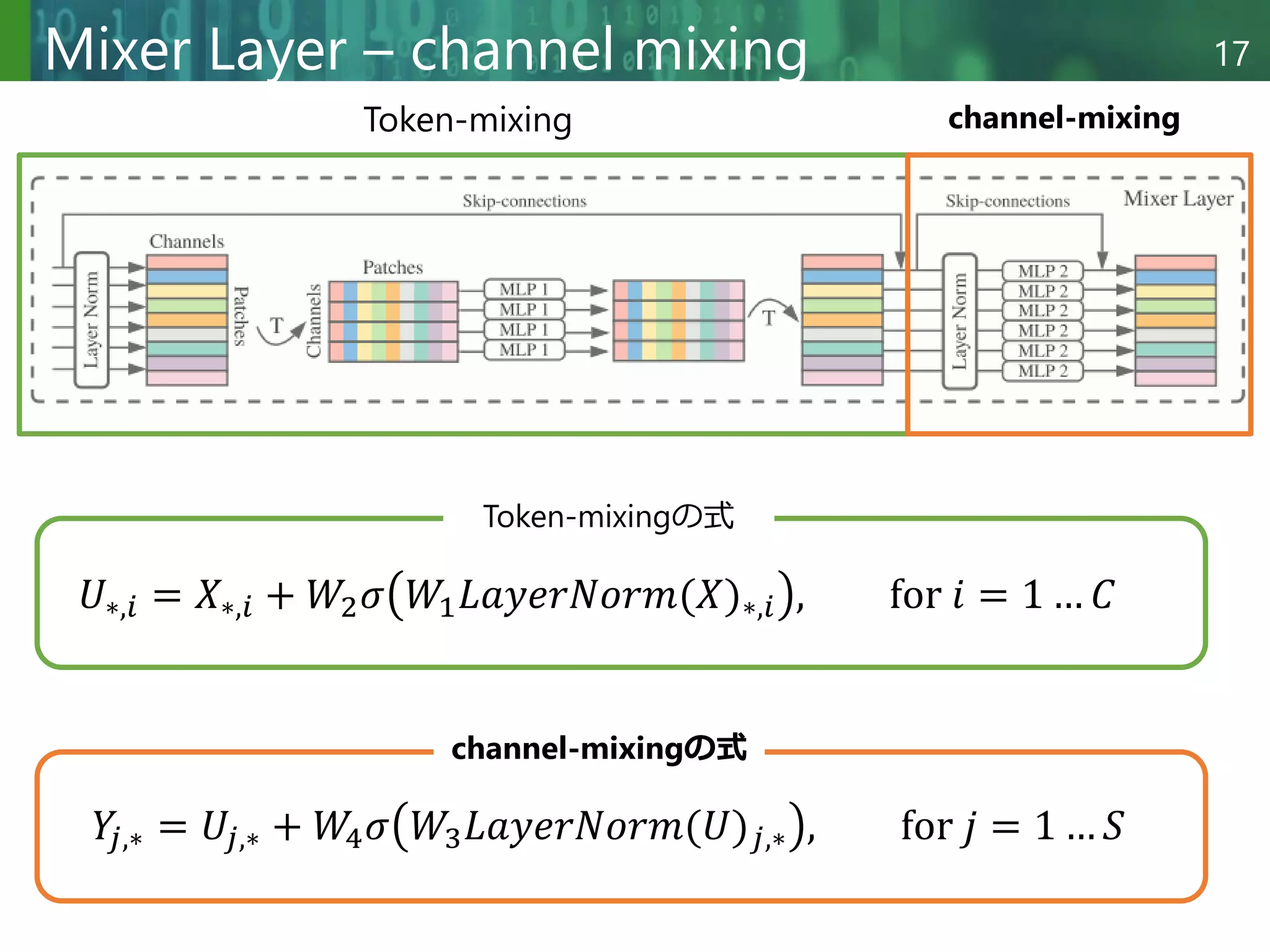

16

Mixer Layer – token mixing

𝑈∗,𝑖 = 𝑋∗,𝑖 + 𝑾𝟐𝜎 𝑾𝟏𝑳𝒂𝒚𝒆𝒓𝑵𝒐𝒓𝒎(𝑋)∗,𝑖 , 𝑓𝑜𝑟 𝑖 = 1 … 𝐶

𝑾𝟏,𝟐: Fully-connected(全結合層)の重み行列

𝐿𝑎𝑦𝑒𝑟𝑁𝑜𝑟𝑚: 行列の正規化

MLPの構造

𝑾𝟏

𝑾𝟐

𝜎

Token-mixing channel-mixing

GELU(Gaussian Error Linear Units)[5]

[5] Hendrycks, Dan, and Kevin Gimpel. "Gaussian error linear units (gelus)." arXiv preprint arXiv:1606.08415 (2016).](https://image.slidesharecdn.com/20220527dlseminarmori-220527044124-1f07b0c9/75/MLP-Mixer-An-all-MLP-Architecture-for-Vision-16-2048.jpg)

![Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

Copyright © 2020 調和系工学研究室 - 北海道大学 大学院情報科学研究院 情報理工学部門 複合情報工学分野 – All rights reserved.

25

最新の関連研究

• gMLP (Pay Attention to MLPs)[6]

– Mlp mixer と Transformer (attention)を融合

[6] Liu, Hanxiao, et al. "Pay attention to mlps." Advances in Neural Information Processing Systems 34 (2021): 9204-9215.](https://image.slidesharecdn.com/20220527dlseminarmori-220527044124-1f07b0c9/75/MLP-Mixer-An-all-MLP-Architecture-for-Vision-25-2048.jpg)