More Related Content

PDF

Transformerを多層にする際の勾配消失問題と解決法について PDF

PPTX

Swin Transformer (ICCV'21 Best Paper) を完璧に理解する資料 PDF

三次元点群を取り扱うニューラルネットワークのサーベイ PDF

PDF

モデルアーキテクチャ観点からのDeep Neural Network高速化 PPTX

【DL輪読会】ViT + Self Supervised Learningまとめ PPTX

What's hot

PPTX

近年のHierarchical Vision Transformer PDF

SSII2021 [OS2-02] 深層学習におけるデータ拡張の原理と最新動向 PDF

[DL輪読会]Understanding Black-box Predictions via Influence Functions PDF

[DL輪読会]data2vec: A General Framework for Self-supervised Learning in Speech,... PPTX

PPTX

【DL輪読会】SimCSE: Simple Contrastive Learning of Sentence Embeddings (EMNLP 2021) PPTX

【DL輪読会】Efficiently Modeling Long Sequences with Structured State Spaces PDF

最近のディープラーニングのトレンド紹介_20200925 PDF

[DL輪読会]Decision Transformer: Reinforcement Learning via Sequence Modeling PPTX

[DL輪読会]Wav2CLIP: Learning Robust Audio Representations From CLIP PDF

Contrastive learning 20200607 PDF

PPTX

[DL輪読会]Pay Attention to MLPs (gMLP) PPTX

[DL輪読会]NVAE: A Deep Hierarchical Variational Autoencoder PDF

【DL輪読会】Deep Transformers without Shortcuts: Modifying Self-attention for Fait... PDF

BlackBox モデルの説明性・解釈性技術の実装 PPTX

[DL輪読会] マルチエージェント強化学習と心の理論 PPTX

[DL輪読会]BERT: Pre-training of Deep Bidirectional Transformers for Language Und... PPTX

【DL輪読会】High-Resolution Image Synthesis with Latent Diffusion Models PPTX

強化学習の基礎と深層強化学習(東京大学 松尾研究室 深層強化学習サマースクール講義資料) Similar to Transformerを用いたAutoEncoderの設計と実験

PDF

PDF

attention_is_all_you_need_nips17_論文紹介 PDF

【DeepLearning研修】Transformerの基礎と応用 -- 第1回 Transformerの基本 PDF

PDF

Transformerについて解説!!(Encoder部分) PDF

SSII2022 [TS1] Transformerの最前線〜 畳込みニューラルネットワークの先へ 〜 PDF

transformer解説~Chat-GPTの源流~ PDF

PythonによるDeep Learningの実装 PPTX

PDF

Learning Deep Architectures for AI (第 3 回 Deep Learning 勉強会資料; 松尾) PDF

[DL輪読会]An Image is Worth 16x16 Words: Transformers for Image Recognition at S... PDF

文献紹介:Length-Controllable Image Captioning PDF

PDF

PDF

【DeepLearning研修】Transfomerの基礎と応用 --第4回 マルチモーダルへの展開 PDF

【DL輪読会】ConvNeXt V2: Co-designing and Scaling ConvNets with Masked Autoencoders PPTX

PPTX

東京大学2020年度深層学習(Deep learning基礎講座) 第9回「深層学習と自然言語処理」 PDF

PDF

DL Hacks輪読 Semi-supervised Learning with Deep Generative Models Recently uploaded

PDF

krsk_aws_re-growth_aws_devops_agent_20251211 PDF

音楽アーティスト探索体験に特化した音楽ディスカバリーWebサービス「DigLoop」|Created byヨハク技研 PPTX

君をむしばむこの力で_最終発表-1-Monthon2025最終発表用資料-.pptx PDF

2025/12/12 AutoDevNinjaピッチ資料 - 大人な男のAuto Dev環境 PDF

ソフトウェアエンジニアがクルマのコアを創る!? モビリティの価値を最大化するソフトウェア開発の最前線【DENSO Tech Night 第一夜】 PDF

ソフトとハードの二刀流で実現する先進安全・自動運転のアルゴリズム開発【DENSO Tech Night 第二夜】 ー高精度な画像解析 / AI推論モデル ... Transformerを用いたAutoEncoderの設計と実験

- 1.

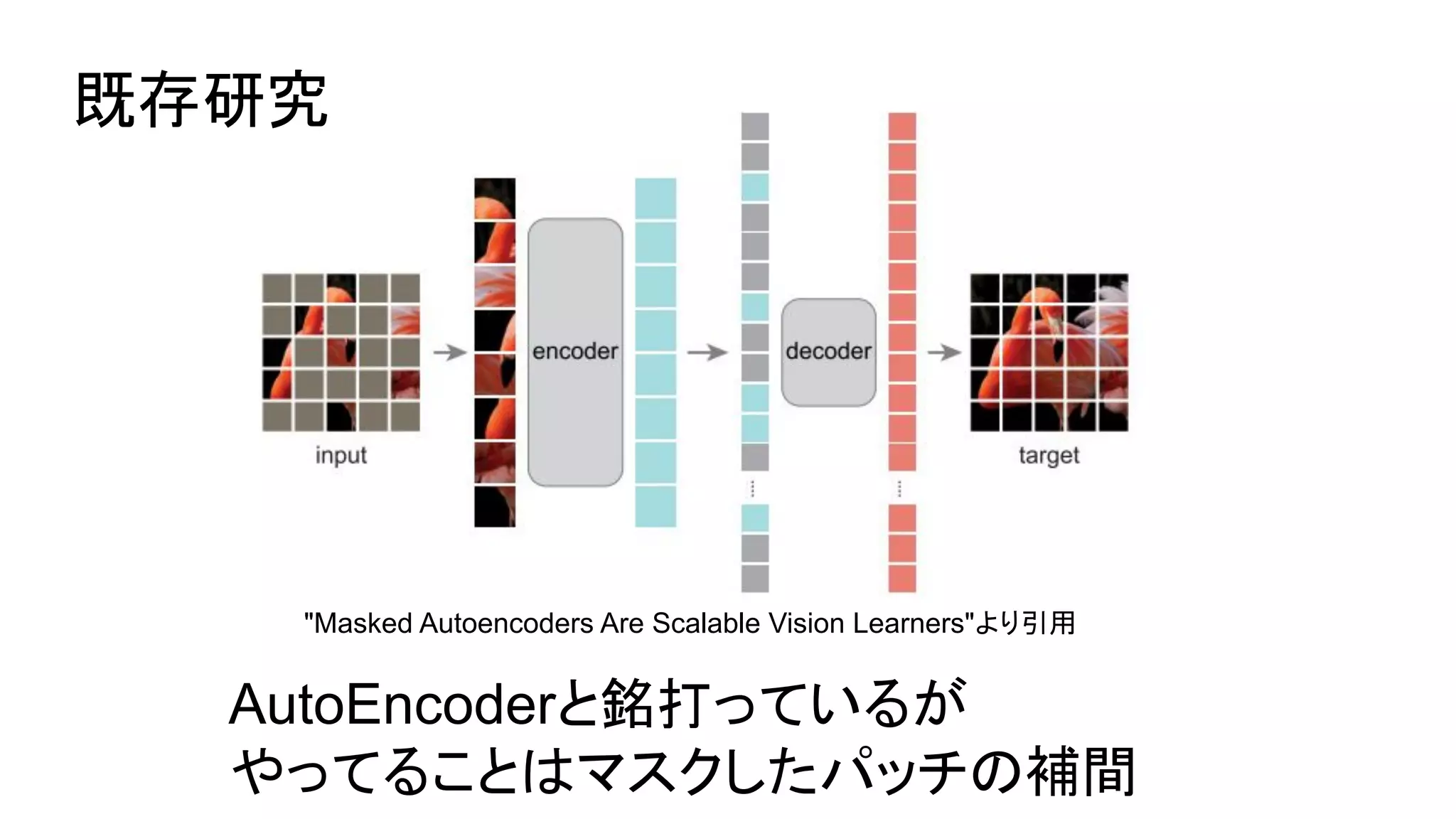

- 2.

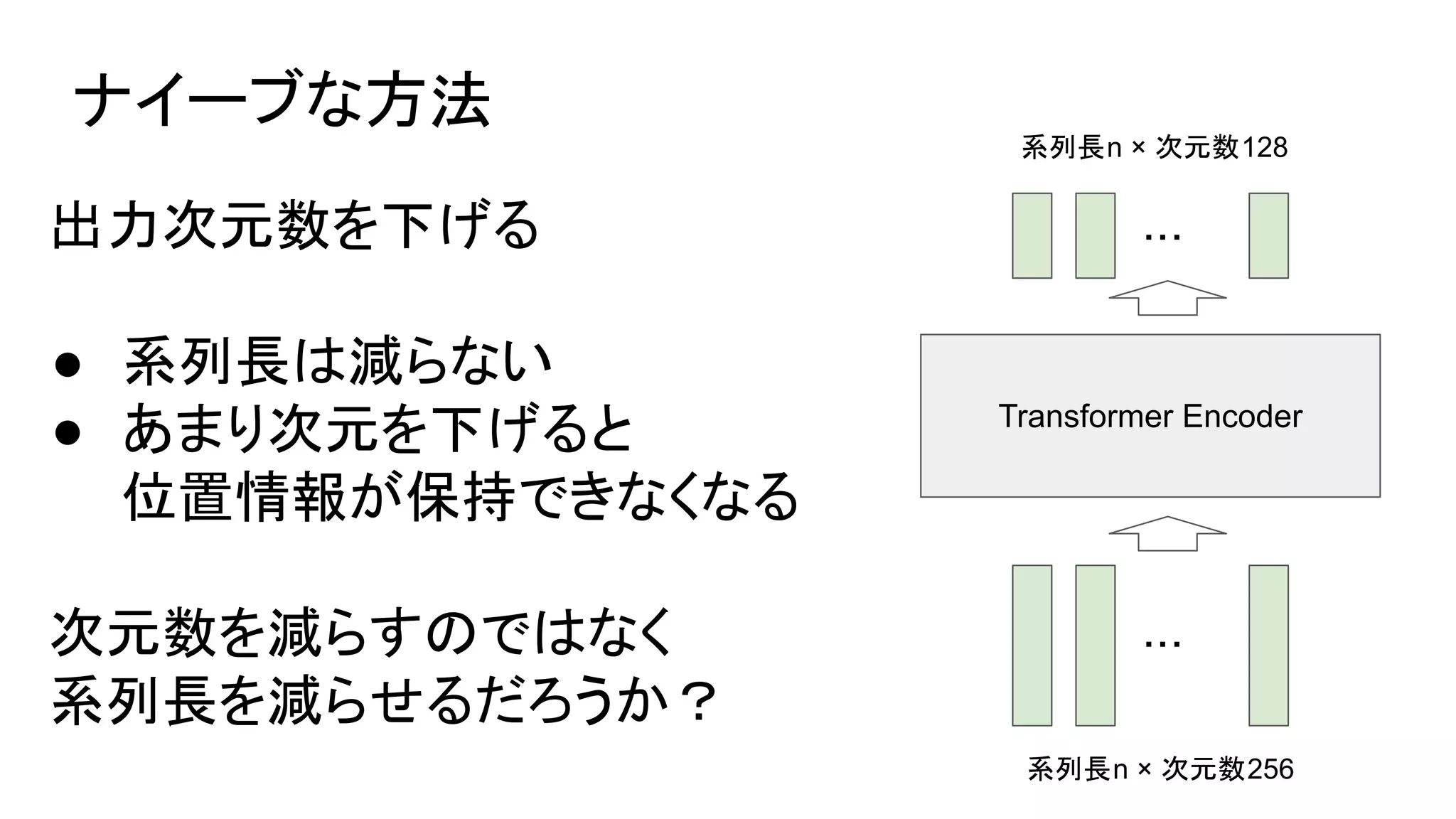

- 3.

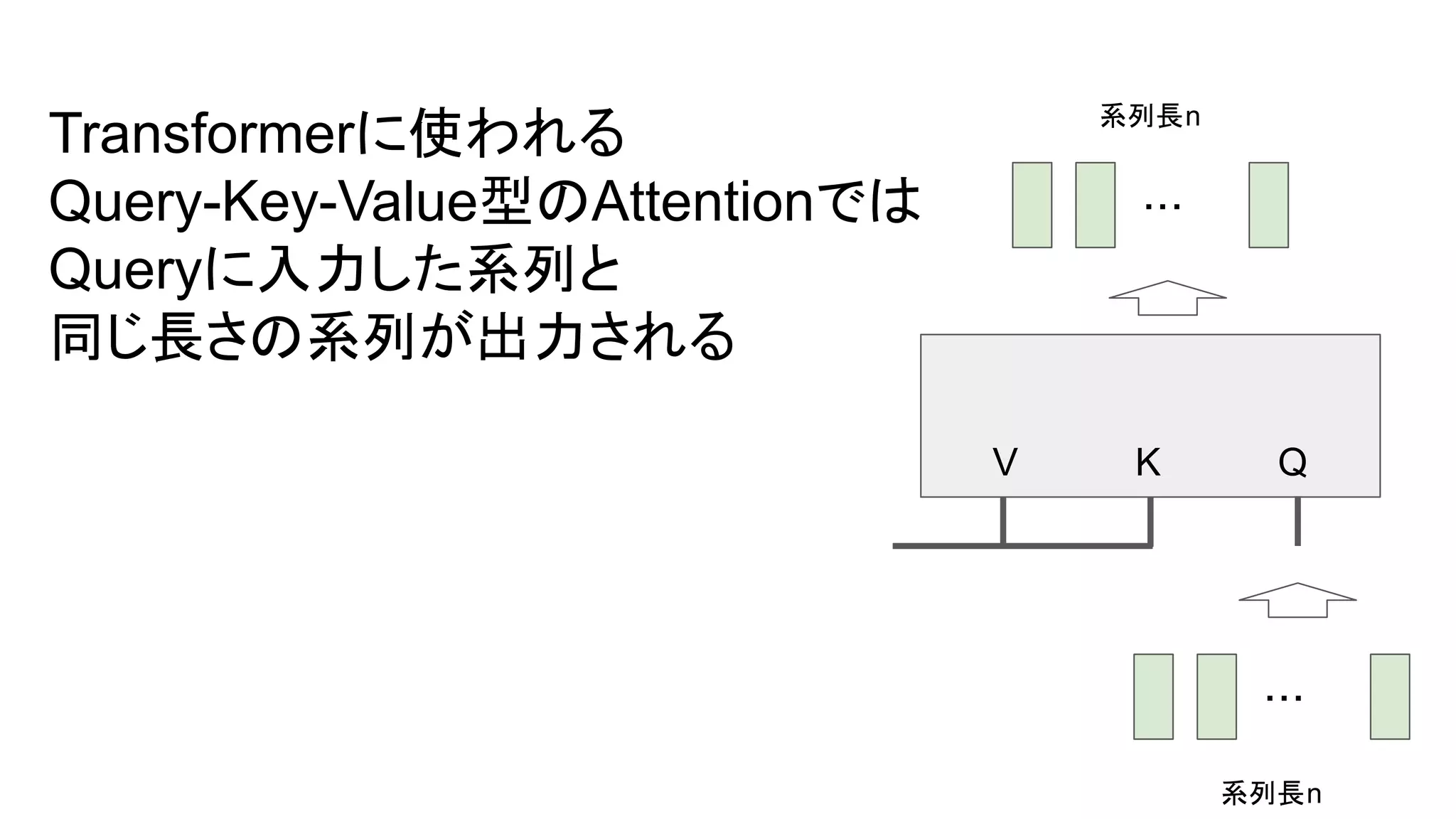

- 4.

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

- 12.

- 13.

- 14.

- 15.

- 16.

- 17.

- 18.