Recommended

PPTX

Hierarchical and Interpretable Skill Acquisition in Multi-task Reinforcement ...

PDF

DQNからRainbowまで 〜深層強化学習の最新動向〜

PPTX

Paper intoduction "Playing Atari with deep reinforcement learning"

PDF

論文紹介:Dueling network architectures for deep reinforcement learning

PDF

SSII2021 [TS2] 深層強化学習 〜 強化学習の基礎から応用まで 〜

PDF

深層強化学習の分散化・RNN利用の動向〜R2D2の紹介をもとに〜

PDF

Skip Connection まとめ(Neural Network)

PDF

論文紹介:”Playing hard exploration games by watching YouTube“

PDF

Introduction to A3C model

PDF

ICLR2018読み会@PFN 論文紹介:Intrinsic Motivation and Automatic Curricula via Asymmet...

PDF

Decision Transformer: Reinforcement Learning via Sequence Modeling

PPTX

ChainerでDeep Learningを試すために必要なこと

PDF

"Playing Atari with Deep Reinforcement Learning"

PPTX

PPTX

ChainerでDeep Learningを試す為に必要なこと

PDF

Introduction to Chainer (LL Ring Recursive)

PPTX

PPTX

PDF

ディープラーニング最近の発展とビジネス応用への課題

PDF

Generative adversarial nets

PPTX

【2017年】ディープラーニングのフレームワーク比較

PDF

PDF

自然言語処理に適した ニューラルネットのフレームワーク - - - DyNet - - -

PDF

PDF

SSII2021 [OS2-01] 転移学習の基礎:異なるタスクの知識を利用するための機械学習の方法

PPTX

[DL輪読会]QUASI-RECURRENT NEURAL NETWORKS

PPTX

Multi-agent Inverse reinforcement learning: 相互作用する行動主体の報酬推定

PPTX

PPTX

PDF

Rainbow: Combining Improvements in Deep Reinforcement Learning (AAAI2018 unde...

More Related Content

PPTX

Hierarchical and Interpretable Skill Acquisition in Multi-task Reinforcement ...

PDF

DQNからRainbowまで 〜深層強化学習の最新動向〜

PPTX

Paper intoduction "Playing Atari with deep reinforcement learning"

PDF

論文紹介:Dueling network architectures for deep reinforcement learning

PDF

SSII2021 [TS2] 深層強化学習 〜 強化学習の基礎から応用まで 〜

PDF

深層強化学習の分散化・RNN利用の動向〜R2D2の紹介をもとに〜

PDF

Skip Connection まとめ(Neural Network)

PDF

論文紹介:”Playing hard exploration games by watching YouTube“

What's hot

PDF

Introduction to A3C model

PDF

ICLR2018読み会@PFN 論文紹介:Intrinsic Motivation and Automatic Curricula via Asymmet...

PDF

Decision Transformer: Reinforcement Learning via Sequence Modeling

PPTX

ChainerでDeep Learningを試すために必要なこと

PDF

"Playing Atari with Deep Reinforcement Learning"

PPTX

PPTX

ChainerでDeep Learningを試す為に必要なこと

PDF

Introduction to Chainer (LL Ring Recursive)

PPTX

PPTX

PDF

ディープラーニング最近の発展とビジネス応用への課題

PDF

Generative adversarial nets

PPTX

【2017年】ディープラーニングのフレームワーク比較

PDF

PDF

自然言語処理に適した ニューラルネットのフレームワーク - - - DyNet - - -

PDF

PDF

SSII2021 [OS2-01] 転移学習の基礎:異なるタスクの知識を利用するための機械学習の方法

PPTX

[DL輪読会]QUASI-RECURRENT NEURAL NETWORKS

PPTX

Multi-agent Inverse reinforcement learning: 相互作用する行動主体の報酬推定

PPTX

Similar to Rainbow

PPTX

PDF

Rainbow: Combining Improvements in Deep Reinforcement Learning (AAAI2018 unde...

PDF

20180830 implement dqn_platinum_data_meetup_vol1

PDF

分散型強化学習手法の最近の動向と分散計算フレームワークRayによる実装の試み

PDF

強化学習とは (MIJS 分科会資料 2016/10/11)

PPTX

PPTX

PDF

論文紹介: Offline Q-Learning on diverse Multi-Task data both scales and generalizes

PPTX

Feature engineering for predictive modeling using reinforcement learning

PDF

introduction to double deep Q-learning

PPTX

Deep Recurrent Q-Learning(DRQN) for Partially Observable MDPs

PPTX

論文紹介 : Unifying count based exploration and intrinsic motivation

PPTX

[DL輪読会]Learning to Adapt: Meta-Learning for Model-Based Control

PPTX

Deep reinforcement learning for imbalanced classification

PDF

NeurIPS'21参加報告 tanimoto_public

PPTX

Efficient Deep Reinforcement Learning with Imitative Expert Priors for Autono...

PDF

PDF

introduction to Deep Q Learning

PPTX

Batch Reinforcement Learning

PDF

論文紹介-Multi-Objective Deep Reinforcement Learning

More from Takahiro Yoshinaga

PDF

PPTX

PDF

PPTX

A Deep Reinforcement Learning Chatbot

PPTX

Groups-Keeping Solution Path Algorithm For Sparse Regression

PDF

PPTX

「予測にいかす統計モデリングの基本」勉強会 第二章

PPTX

「予測にいかす統計モデリングの基本」勉強会 第一章

PDF

Rainbow 1. 2. もくじ 2

• ⾃⼰紹介

• 紹介論⽂概要

• 論⽂紹介

– 背景

– DQN概要

– Rainbowに使⽤されている各⼿法の概要

– 実験結果

• まとめ

3. ⾃⼰紹介 3

• 名前

– 吉永 尊洸(@tekenuko)

• 職業

– データサイエンティスト(仮)

• 素粒⼦論→データ分析コンサル→事業会社

• ブログ

– http://tekenuko.hatenablog.com

• 趣味

– リアル脱出ゲーム

4. 紹介論⽂概要 4

• 著者

– Hessel et al. (DeepMindの⼈たち)

• AAAI 2018

• 概要

– DQNまわりの発展を詰め込んだモデルを提案

• Double DQN, Prioritized replay, Dueling networks,

Multi-step learning, Distributed RL, Noisy Nets

– 2017/10時点でState of the Artを達成

– 各⼿法の寄与を実験的に評価

• Prioritized replay, Multi-step learningが重要そう

• 選定理由

– パフォーマンスの図にグッときた

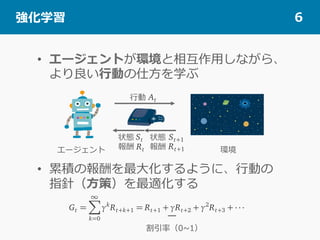

5. 背景 5

• 強化学習が近年多くの成功をおさめている

– きっかけは、Deep-Q Network(DQN)

– Atari2600といったレトロゲームでは、⼈間に

近い性能を獲得

– DQNをきっかけに、多くの拡張が提案され、

State of the Art(SoTA)の更新が続いている

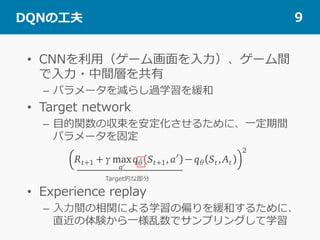

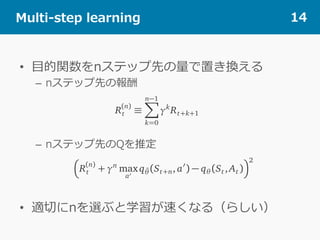

6. 7. 8. 9. 10. DQN以降の発展 10

• DQN(Mnih+ 2015)以降、様々な拡張が提案

– Double DQN(Hasselt+ 2016)

– Prioritized replay(Schaul+ 2015)

– Dueling network(Wang+ 2016)

– Multi-step learning(Sutton 1998, アイデアは前からあった)

– Distributed RL(Bellemare+ 2017)

– Noisy Nets(Fortunaro+ 2017)

• Rainbowでは上記の⼿法を合体

11. Double DQN 11

• 最適⾏動の決定と評価するQ関数を分ける

• ⾏動の過⼤評価を防ぐ働きがある

– 関数近似の近似誤差がある状態でmaxをとると、過⼤

評価される⾏動があるかもしれない

パラメータ を持つqで⾏動の決定と評価をおこなう

⾏動の決定はパラメータ を持つqでおこなう

評価はパラメータ をもつqでおこなう

12. 13. 14. 15. Distributional RL 15

• 報酬の期待値の代わりに報酬の分布を推定

– 通常のDQNは、累積報酬の期待値を推定

– 潜在的な要因によって報酬分布に差がある場合は、期

待値だけ⾒ていると状況を正しく反映できないかも

• 報酬をN個の値をもつ離散分布と考え、⾏動ごと

にN個の値を出⼒するように拡張

– DQNの出⼒層を(N×⾏動数)次元に変更

• 分布の推定は、Kulback-Leibler divergenceの

最⼩化問題に帰着させる

16. Noisy Nets 16

• ネットワークの重みにノイズを付与して、探索の

効果を⼊れる

– 例:全結合層

• 学習時に通常⾏われるε-greedy⽅策などの代わり

(DQN)

N(0,1)

要素積

学習パラメータ N(0,1)学習パラメータ

17. Rainbow 17

• 前述の⼿法を合体

– 報酬の分布の推定をおこなう

• ⽬的関数はKulback-Leibler divergence

– ⽬的関数でnステップ先の量を利⽤

– ⾏動選択と評価の関数を分ける

– ネットワーク構造はDueling network

– Noisy Netsでランダム性を持たせる

– 学習の際のサンプリングは、学習の余地の⼤きいもの

を優先的に選択

• Kulback-Leibler divergenceの⼤きさで評価

• Atari2600でパフォーマンスを評価

18. 実験結果1 18

• 単体の⼿法を圧倒

– パフォーマンスも良いし、学習も早い(+図がネタ的)

provements in Deep Reinforcement Learning

Hado van Hasselt

DeepMind

Tom Schaul

DeepMind

Georg Ostrovski

DeepMind

Bilal Piot

DeepMind

Mohammad Azar

DeepMind

David Silver

DeepMind

made sev-

hm. How-

mplemen-

examines

lly studies

combina-

Atari 2600

nal perfor-

tion study

verall per-

ment learn-

g problems

thm (DQN;

arning with

replay en-

many Atari

エキスパート(⼈間)

1秒=60フレーム

2億フレームだと40⽇くらい学習

19. 20. まとめ 20

• Rainbowという、近年のDQNの発展を詰め込

んだモデルを提案

– Double DQN, Prioritized replay, Dueling

networks, Multi-step learning, Distributed RL,

Noisy Nets

• 2017/10時点でState of the Artを達成

• 各⼿法の寄与を実験的に評価

– Prioritized replay, Multi-step learningが重要そう

21. その後の発展 Ape-X 21

• もうSoTAじゃないかも…

– 下記の論⽂で、Ape-Xというものが提案

• Distributed Prioritized Experimental Replay

– Hogan et al. (DeepMindの⼈たち)

– ICLR 2018(Poster)

– Double DQN, Prioritized replay, Dueling

networks, Multi-step learning

– 複数のActorを⽤意し、経験を共有メモリに貯め、

貯めた情報を⽤いてLearnerが学習

• Actorを分散させることで、Prioritized replayを効率化

22. その後の発展 Ape-X 22

• 既存⼿法よりも良い

– Raibowよりも良い

– 注意

• Ape-X:1GPU+360CPU

• 他:1GPU

• さらに並列化して⾼速化する

仕組みの提案が偉いのかも

• 発展についていくのも⼤変

– だけど…

Under review as a conference paper at ICLR 2018

0 50 100 150 200 250 300

Training Time (Hours)

50%

100%

150%

200%

250%

300%

350%

400%

450%

Human-normalizedScore

(MedianOver57Games)

Ape-X DQN (20hrs)

Ape-X DQN (70hrs)

Ape-X DQN (120hrs)

DQN

Rainbow

Prioritized DQN

C51

Gorila

EpisodeReturn

(Mean)

EpisodeReturn

1

1

EpisodeReturn

(Mean)

Figure 2: Left: Atari results aggregated across 57 ga

training curves for selected games, against baselines.