More Related Content

PDF

最近のDeep Learning (NLP) 界隈におけるAttention事情 PPTX

PPTX

【DL輪読会】ViT + Self Supervised Learningまとめ PDF

PPTX

[DL輪読会]Deep High-Resolution Representation Learning for Human Pose Estimation PPTX

【DL輪読会】SimCSE: Simple Contrastive Learning of Sentence Embeddings (EMNLP 2021) PDF

PPTX

【DL輪読会】Flamingo: a Visual Language Model for Few-Shot Learning 画像×言語の大規模基盤モ... What's hot

PDF

PPTX

PDF

PDF

Transformerを多層にする際の勾配消失問題と解決法について PDF

PDF

深層学習による自然言語処理入門: word2vecからBERT, GPT-3まで PPTX

[DL輪読会]BERT: Pre-training of Deep Bidirectional Transformers for Language Und... PDF

【メタサーベイ】基盤モデル / Foundation Models PPTX

【DL輪読会】An Image is Worth One Word: Personalizing Text-to-Image Generation usi... PPTX

【DL輪読会】ViTPose: Simple Vision Transformer Baselines for Human Pose Estimation PDF

SSII2019OS: 深層学習にかかる時間を短くしてみませんか? ~分散学習の勧め~ PDF

PDF

PDF

Layer Normalization@NIPS+読み会・関西 PPTX

PDF

PDF

深層学習の不確実性 - Uncertainty in Deep Neural Networks - PDF

SSII2022 [OS3-02] Federated Learningの基礎と応用 PDF

論文紹介 Pixel Recurrent Neural Networks PDF

自己教師学習(Self-Supervised Learning) Similar to Group normalization

PPTX

[DL輪読会]Batch Renormalization: Towards Reducing Minibatch Dependence in Batch-... PDF

Batch normalization effectiveness_20190206 PPTX

Large scale gan training for high fidelity natural PDF

PPTX

PDF

PDF

SSII2019TS: Shall We GANs? ~GANの基礎から最近の研究まで~ PDF

normalized online learning PPTX

Bayesian Uncertainty Estimation for Batch Normalized Deep Networks PDF

SSII2019TS: Shall We GANs? ~GANの基礎から最近の研究まで~ PDF

ICML2019@Long Beach 参加速報(5~6日目 Workshop) PDF

2014/5/29 東大相澤山崎研勉強会:パターン認識とニューラルネットワーク,Deep Learningまで PPTX

PDF

[DL輪読会]A Bayesian Perspective on Generalization and Stochastic Gradient Descent PDF

[DL輪読会] Spectral Norm Regularization for Improving the Generalizability of De... PPTX

Learning sparse neural networks through L0 regularization More from Ryutaro Yamauchi

PPTX

PPTX

[DeepLearning論文読み会] Dataset Distillation PPTX

PPTX

[論文解説]A Bayesian Perspective on Generalization and Stochastic Gradient Descent PPTX

[論文解説]Unsupervised monocular depth estimation with Left-Right Consistency PPTX

Hybrid computing using a neural network with dynamic Recently uploaded

PPTX

【Qlik 医療データ活用勉強会】医療の質可視化アプリの公開-その2- 20260128 PPTX

What's New In Qlik ~ 2025年12月&2026年1月リリース最新機能のご紹介 ~ PPTX

KNIMEは地味だが役に立つ_2026_0207_DojoMeeting_Kansai_#1.pptx PDF

研究資料ーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーーー PDF

EspressReport Enterprise Server ホワイトペーパー PPTX

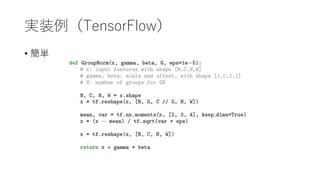

KNIMEで奈良の気温を調べてみた_2026_0207_KNIMEST.pptx Group normalization

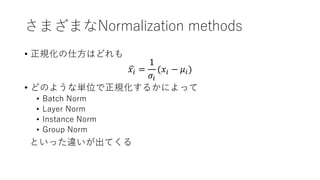

- 1.

- 2.

書誌情報

• Yuxin Wu,Kaiming He

• Facebook AI Research(FAIR)の人々

• Kaiming氏はいつもシンプルで力強いアイディアを出してきて凄い

• ResNetとかMask R-CNNとか

• https://arxiv.org/abs/1803.08494

- 3.

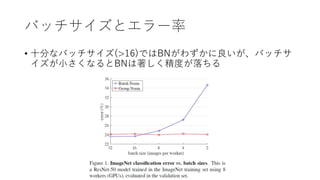

Batch Normalizationの問題点

• BatchNormalization(BN)はバッチサイズが小さい場合に著し

く精度が下がる

• バッチの統計量を正しく推定できなくなるため

• 高精細な画像を用いたDetectionやSegmentationの学習では、メモリ

の制約からバッチサイズを確保できないことが多い

• 2とか4とか

• 評価時には事前に計算された統計量を用いるが、データの分布

が変わると意味をなさない

• 転移学習する場合に困る

- 4.

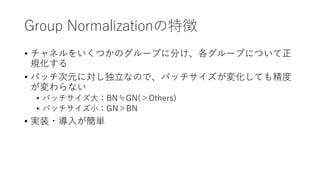

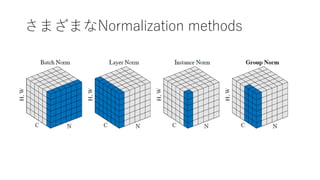

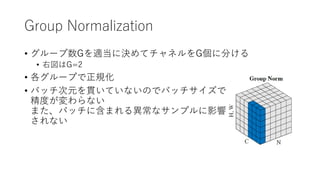

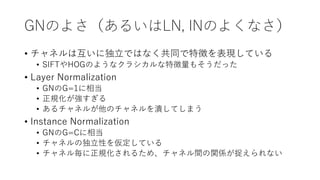

BNの問題点への対処

• 凄い計算機を使う

• 本質的ではない

•Batch Renormalization

• バッチではなく学習セット全体の統計量を推定する

• Weight Normalization

• filter weightの方を正規化

• Batch次元と独立なNormalization

• Layer Normalization

• Instance Normalization

• ↑この2つはRNN/LSTMやGANでは効果的だが、画像認識では微妙

• Group Normalization

• 今回提案するのはこれ

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

- 12.

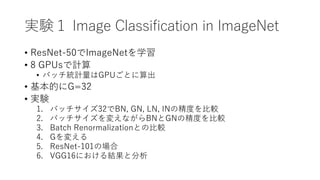

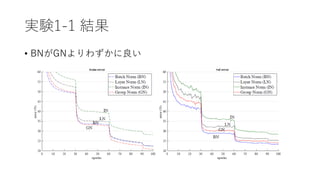

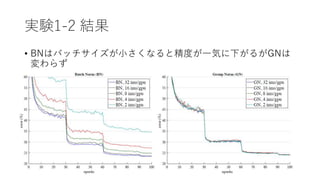

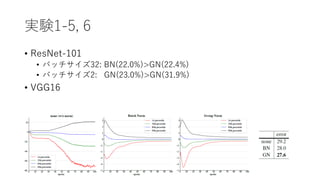

実験1 Image Classificationin ImageNet

• ResNet-50でImageNetを学習

• 8 GPUsで計算

• バッチ統計量はGPUごとに算出

• 基本的にG=32

• 実験

1. バッチサイズ32でBN, GN, LN, INの精度を比較

2. バッチサイズを変えながらBNとGNの精度を比較

3. Batch Renormalizationとの比較

4. Gを変える

5. ResNet-101の場合

6. VGG16における結果と分析

- 13.

- 14.

- 15.

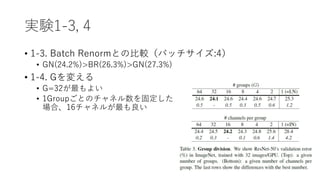

実験1-3, 4

• 1-3.Batch Renormとの比較(バッチサイズ:4)

• GN(24.2%)>BR(26.3%)>GN(27.3%)

• 1-4. Gを変える

• G=32が最もよい

• 1Groupごとのチャネル数を固定した

場合、16チャネルが最も良い

- 16.

- 17.

- 18.