More Related Content

PDF

Fisher線形判別分析とFisher Weight Maps PDF

PDF

PDF

PDF

PDF

PRML 4.1 Discriminant Function PDF

ICML2013読み会: Distributed training of Large-scale Logistic models PDF

What's hot

PPTX

PPTX

PDF

PPTX

PPTX

PPTX

Spatial Temporal Graph Convolutional Networks for Skeleton-Based Action Recog... PDF

PRML復々習レーン#2 2.3.6 - 2.3.7 PDF

PPTX

Learning Depthwise Separable Graph Convolution from Data Manifold PDF

Limits on Super-Resolution and How to Break them PDF

(文献紹介)Deep Unrolling: Learned ISTA (LISTA) PDF

(文献紹介)エッジ保存フィルタ:Side Window Filter, Curvature Filter PDF

PDF

(文献紹介) 画像復元:Plug-and-Play ADMM PPTX

PDF

PPTX

Locally Optimized Product Quantization for Approximate Nearest Neighbor Searc... PDF

PPTX

Parallel WaveNet: Fast High-Fidelity Speech Synthesis PDF

Similar to 画像認識4

PPTX

PDF

PDF

PDF

PDF

PDF

PDF

PFI Seminar 2012/03/15 カーネルとハッシュの機械学習 PDF

PDF

東京都市大学 データ解析入門 8 クラスタリングと分類分析 1 PDF

PDF

Math in Machine Learning / PCA and SVD with Applications PDF

PRML輪講用資料10章(パターン認識と機械学習,近似推論法) PDF

PDF

PDF

PDF

PDF

PDF

PDF

PPTX

Recently uploaded

PDF

krsk_aws_re-growth_aws_devops_agent_20251211 PDF

ソフトとハードの二刀流で実現する先進安全・自動運転のアルゴリズム開発【DENSO Tech Night 第二夜】 ー高精度な画像解析 / AI推論モデル ... PDF

ソフトウェアエンジニアがクルマのコアを創る!? モビリティの価値を最大化するソフトウェア開発の最前線【DENSO Tech Night 第一夜】 PDF

音楽アーティスト探索体験に特化した音楽ディスカバリーWebサービス「DigLoop」|Created byヨハク技研 PDF

2025/12/12 AutoDevNinjaピッチ資料 - 大人な男のAuto Dev環境 PPTX

君をむしばむこの力で_最終発表-1-Monthon2025最終発表用資料-.pptx 画像認識4

- 1.

- 2.

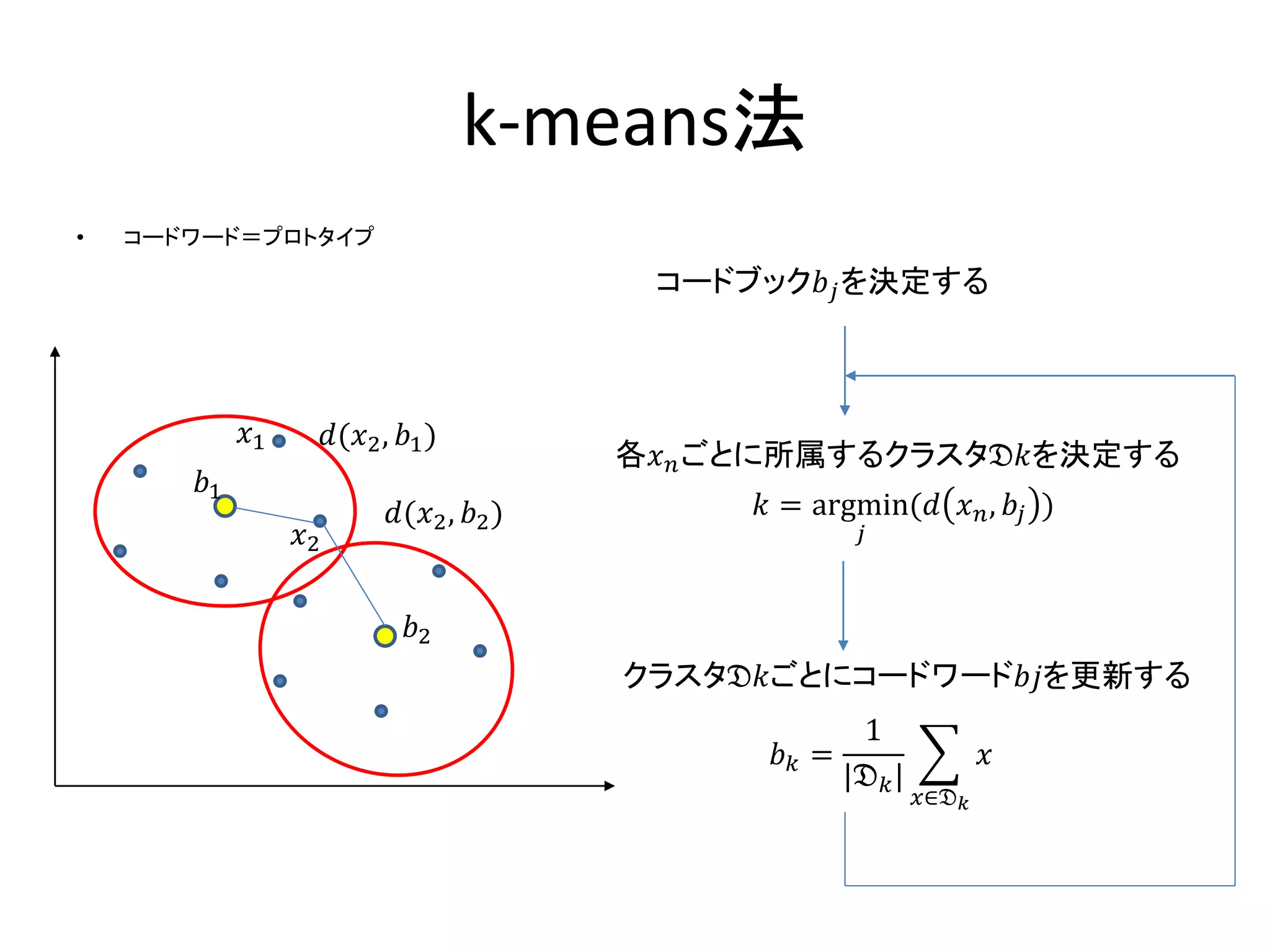

4.1.1 コーディング

• 原画像から特徴点を抽出

•特徴点から,新たな高次の特徴量へ変換=

コーディング

– 特徴点を別の高次のベクトルに変換

• ある画像領域の複数のコーディングベクトル

を1つのベクトルにまとめる=プーリング

– ベクトルの数は減るが,1ベクトルあたりの次元

は同じ

- 3.

- 4.

- 5.

- 6.

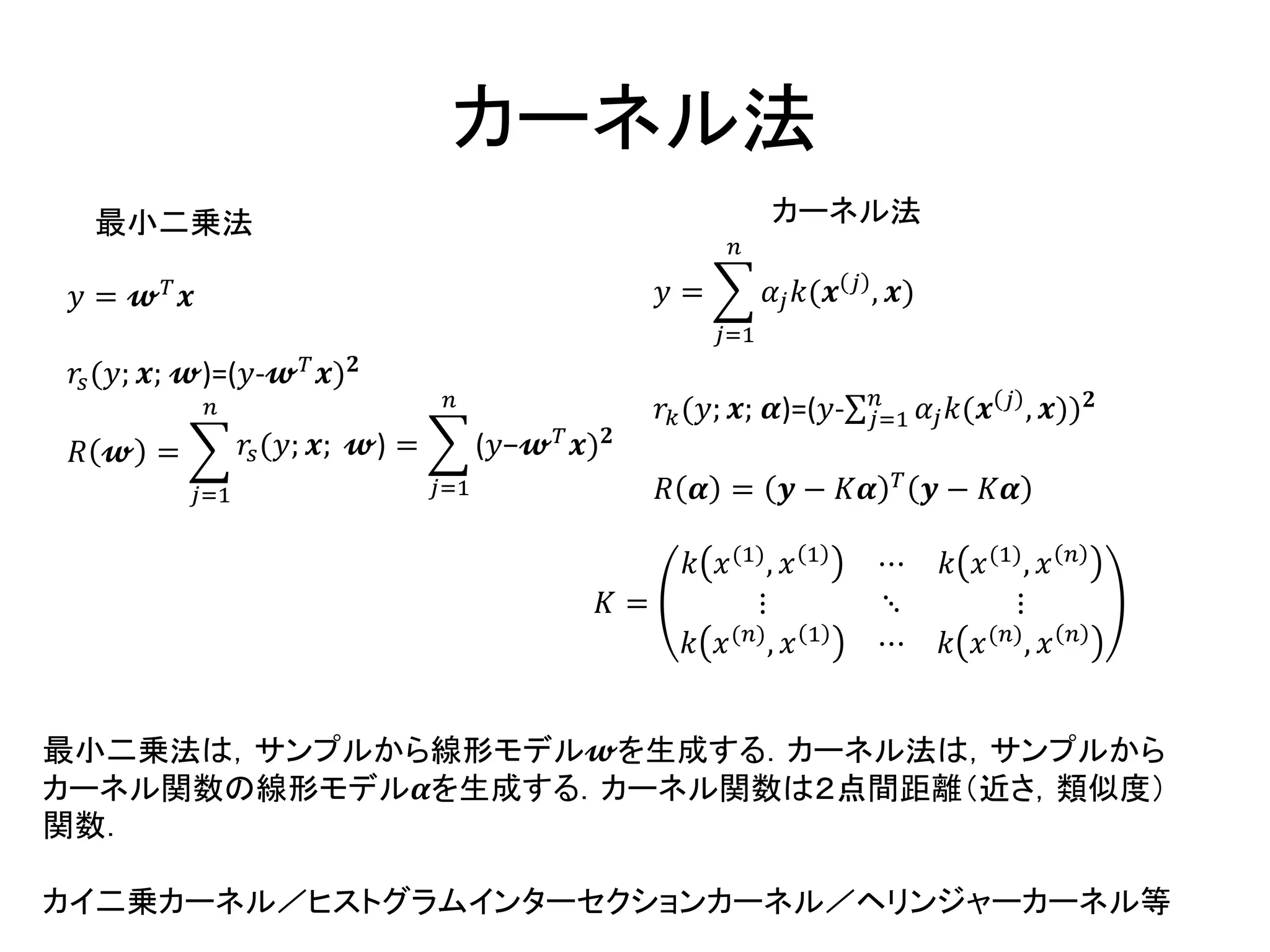

カーネル法

𝑦 = 𝔀𝑇

𝒙

𝑟𝑠(𝑦; 𝒙; 𝔀)=(𝑦-𝔀 𝑇 𝒙) 𝟐

𝑅 𝔀 =

𝑗=1

𝑛

𝑟𝑠(𝑦; 𝒙; 𝔀) =

𝑗=1

𝑛

(𝑦−𝔀 𝑇

𝒙) 𝟐

𝑦 =

𝑗=1

𝑛

𝛼𝑗 𝑘(𝒙 𝑗 , 𝒙)

𝑟𝑘(𝑦; 𝒙; 𝜶)=(𝑦- 𝑗=1

𝑛

𝛼𝑗 𝑘(𝒙 𝑗 , 𝒙)) 𝟐

𝑅 𝜶 = 𝒚 − 𝐾𝜶 𝑇

𝒚 − 𝐾𝜶

𝐾 =

𝑘 𝑥(1), 𝑥 1 ⋯ 𝑘 𝑥(1), 𝑥 𝑛

⋮ ⋱ ⋮

𝑘 𝑥(𝑛), 𝑥 1 ⋯ 𝑘 𝑥(𝑛), 𝑥 𝑛

最小二乗法 カーネル法

最小二乗法は,サンプルから線形モデル𝔀を生成する.カーネル法は,サンプルから

カーネル関数の線形モデル𝜶を生成する.カーネル関数は2点間距離(近さ,類似度)

関数.

カイ二乗カーネル/ヒストグラムインターセクションカーネル/ヘリンジャーカーネル等

- 7.

- 8.

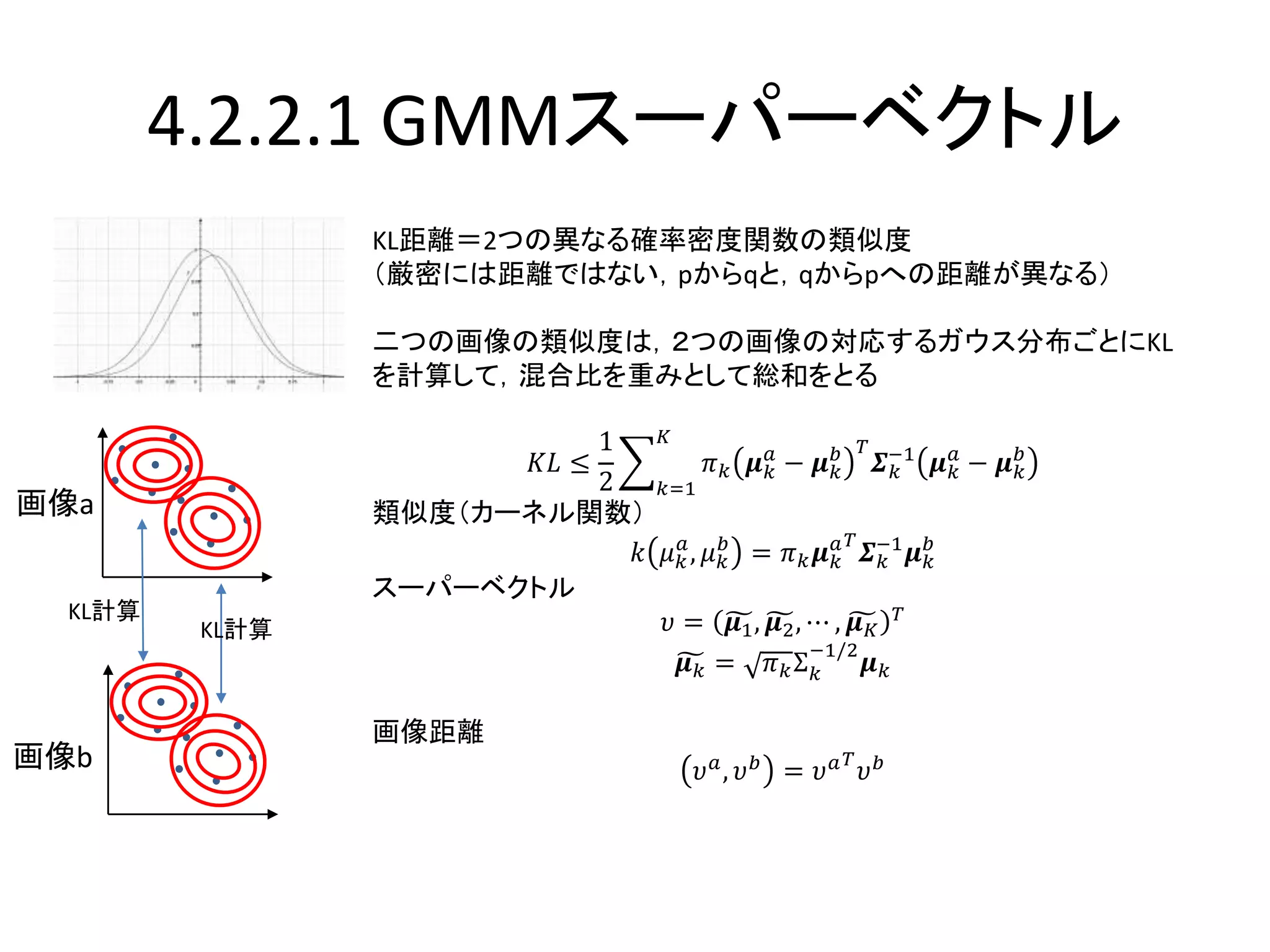

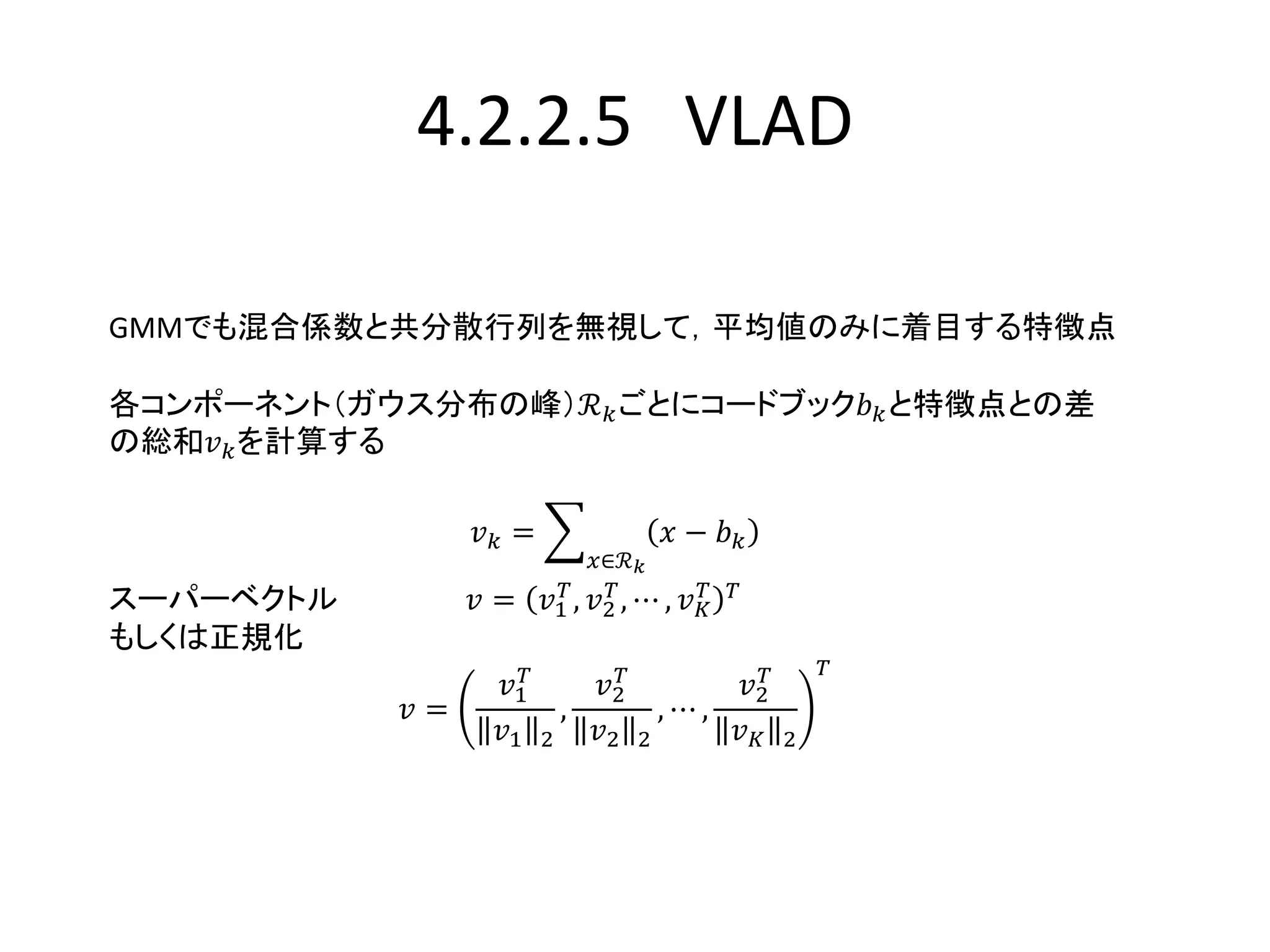

4.2.2.1 GMM混合ガウス分布モデル

特徴点をK個のガウス分布からなる確率モデルから生成されたサンプルと仮定して,ガ

ウス分布のパラメータを推定する

π2=0.3

𝑥 𝑛

0.7𝒩(𝑥|5,1)+ 0.3𝒩(𝑥|7,1)

0.7𝒩(6|5,1)

0.3𝒩(6|7,1)

π1=0.7

𝛾𝑛 1 =

0.7𝒩 6 5,1

0.7𝒩 6 5,1 + 0.3𝒩(6|7,1)

寄与率γの計算方法

𝜃 1

= 𝜋 𝑘

1

, 𝝁 𝑘

1

, 𝜮 𝑘

1

𝑘=1

𝐾

𝜋 𝑘

(𝑡+1)

=

𝑁𝑘

𝑁

, 𝑁𝑘 =

𝑛=1

𝑁

𝛾𝑛 𝑘

𝝁 𝒌

(𝒕+𝟏)

=

1

𝑁𝑘

𝑛=1

𝑁

𝛾𝑛 𝑘 𝒙 𝒏

𝜮 𝒌

(𝒕+𝟏)

=

1

𝑁𝑘

𝑛=1

𝑁

𝛾𝑛 𝑘 𝒙 𝒏 − 𝝁 𝒌

(𝒕+𝟏)

𝒙 𝒏 − 𝝁 𝒌

(𝒕+𝟏) 𝑇

各ガウス分布のパラメータを仮設定する

特徴点ごとに各分布への寄与率を計算

寄与率を盛り込んでパラメータを不偏推定

𝛾𝑛 𝑘 = 𝑝 𝑘 𝑥 𝑛, 𝜃(𝑡)

=

𝜋 𝑘

𝑡

𝒩 𝒙 𝒏 𝝁 𝑘

𝑡

, 𝜮 𝑘

𝑡

𝑗=1

𝐾

𝜋𝑗

𝑡

𝒩 𝒙 𝒏 𝝁 𝑗

𝑡

, 𝜮𝑗

𝑡

- 9.

- 10.

4.2.2.2 フィッシャーベクトル𝜕

𝜕𝜇

𝑓(𝑥|𝜇, 𝜎): 尤度の偏微分

𝜇をわずかに移動すると,尤度がどれくらい増加するか

=>密度関数の勾配の強さを表す(分散に似た尺度)

対数尤度で勾配ベクトルをとる

𝒄 𝜽, 𝒙 = 𝛻𝜃 log 𝑓 𝑥 𝜇, 𝜎

=

𝜕

𝜕𝜇

log𝑓 𝑥 𝜇, 𝜎 ,

𝜕

𝜕𝜎

log𝑓 𝑥 𝜇, 𝜎

𝑇

𝜇 𝑥

𝑭 = 𝔼 𝑥 𝑐 𝜽, 𝒙 𝑐 𝜽, 𝒙 𝑻

=

𝔼 𝑥

𝜕

𝜕𝜇

log𝑓 𝑥 𝜇, 𝜎

2

𝔼 𝑥

𝜕

𝜕𝜇

log𝑓 𝑥 𝜇, 𝜎

𝜕

𝜕𝜎

log𝑓 𝑥 𝜇, 𝜎

𝔼 𝑥

𝜕

𝜕𝜇

log𝑓 𝑥 𝜇, 𝜎

𝜕

𝜕𝜎

log𝑓 𝑥 𝜇, 𝜎 𝔼 𝑥

𝜕

𝜕𝜎

log𝑓 𝑥 𝜇, 𝜎

2

フィッシャーカーネル:𝑘 𝒙1, 𝒙2 = 𝑐 𝜽, 𝒙1

𝑇

𝑭−1

𝑐 𝜽, 𝒙2 = 𝑐 𝜽, 𝒙 𝑛

𝑇

𝑐 𝜽, 𝒙 𝑛

𝒄 𝜽, 𝒙 𝑛 = 𝐹−1/2

𝒄(𝜽, 𝒙 𝑛)

フィッシャーベクトル

𝝊 = 𝑛=1

𝑁

𝒄( 𝜽, 𝒙 𝑛)

フィッシャー情報量行列

- 11.

- 12.

- 13.