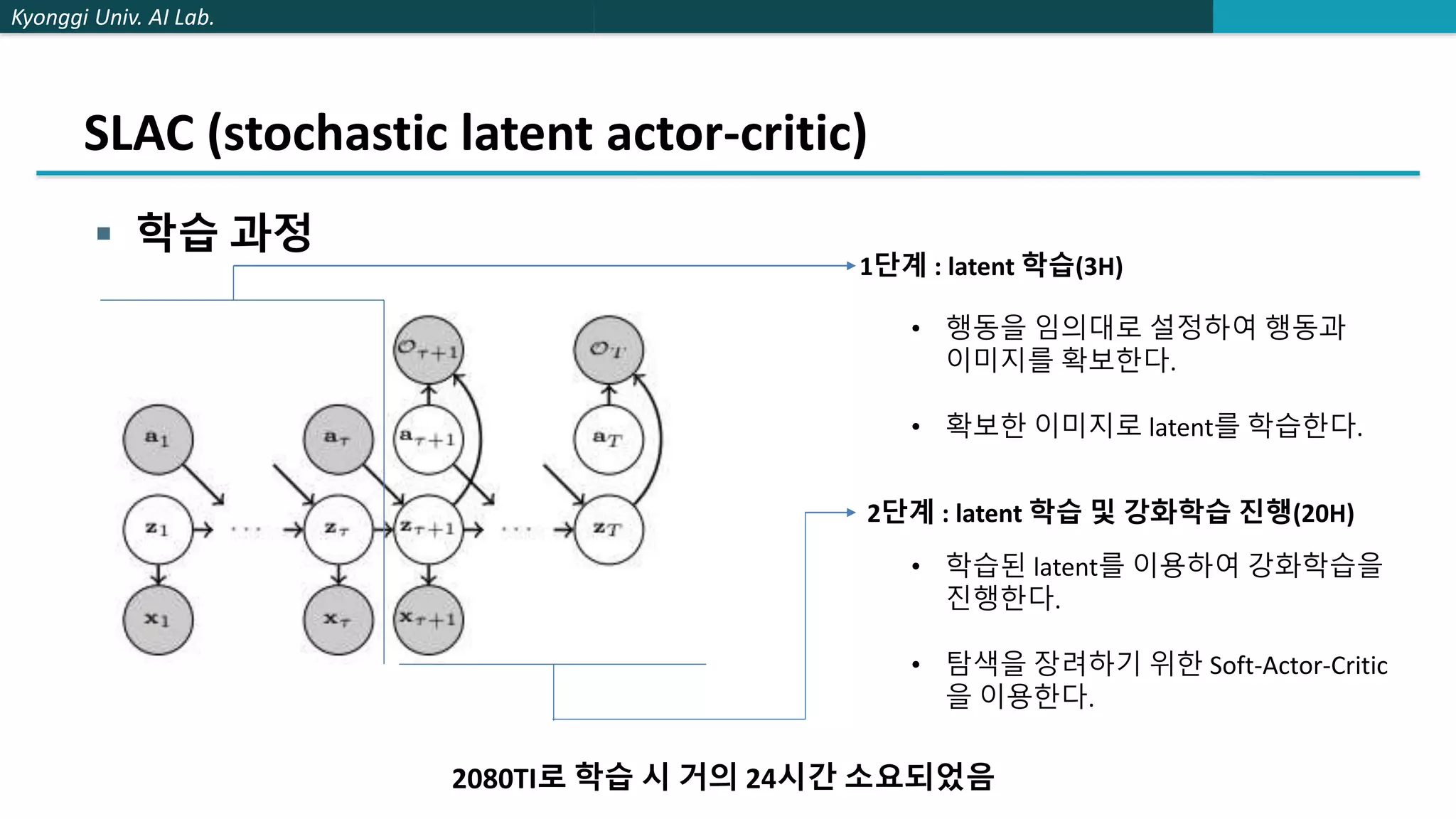

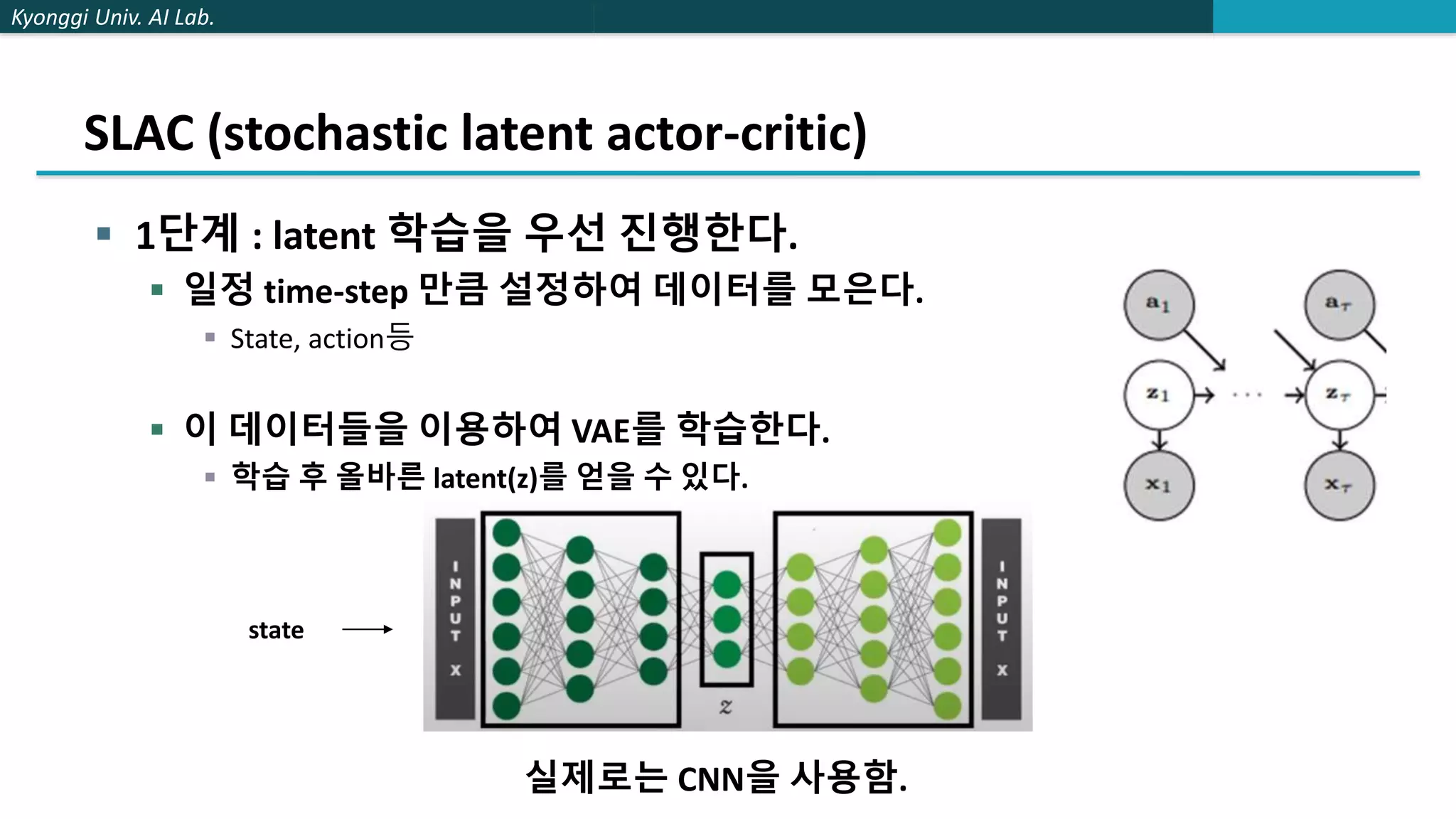

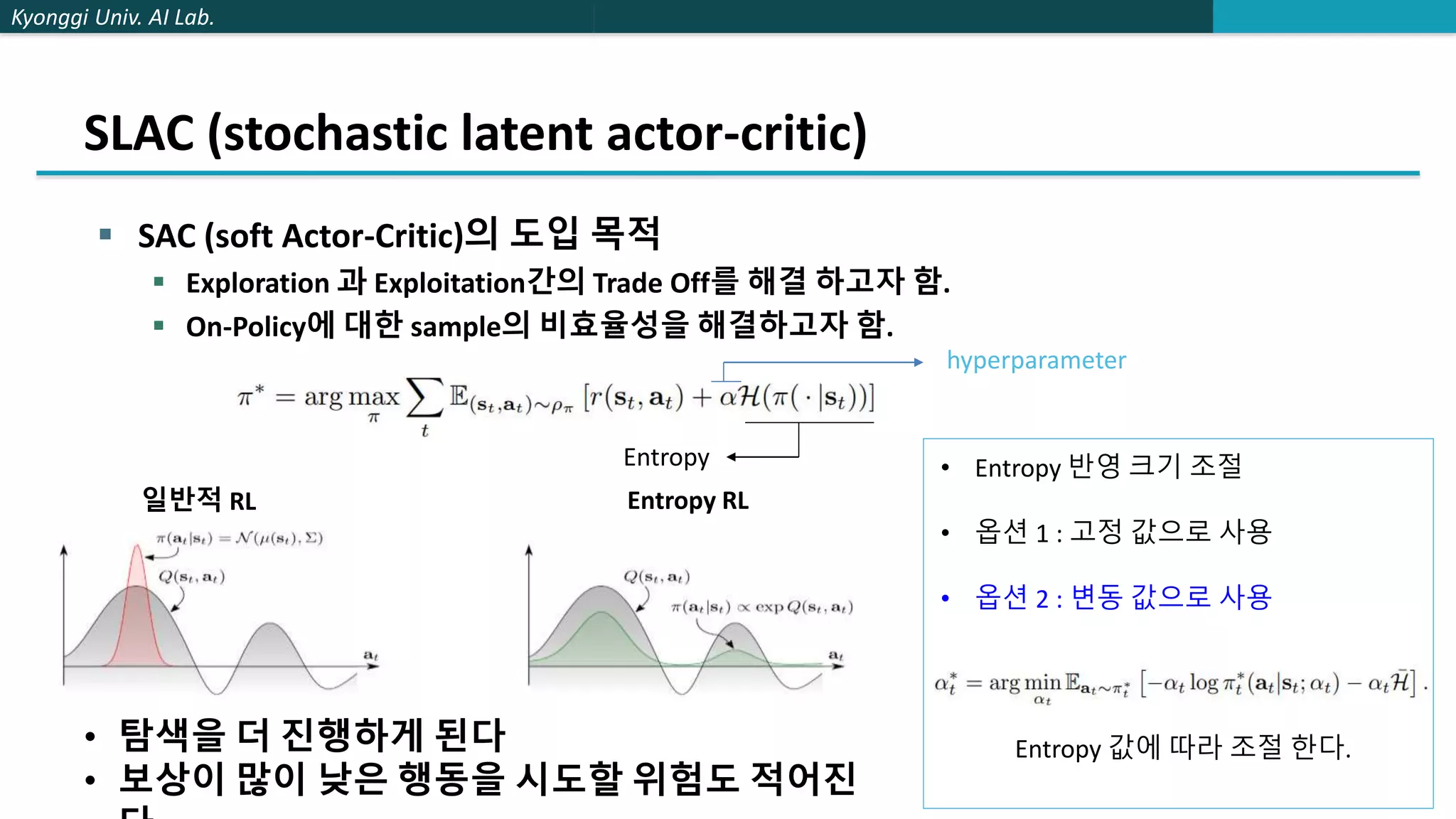

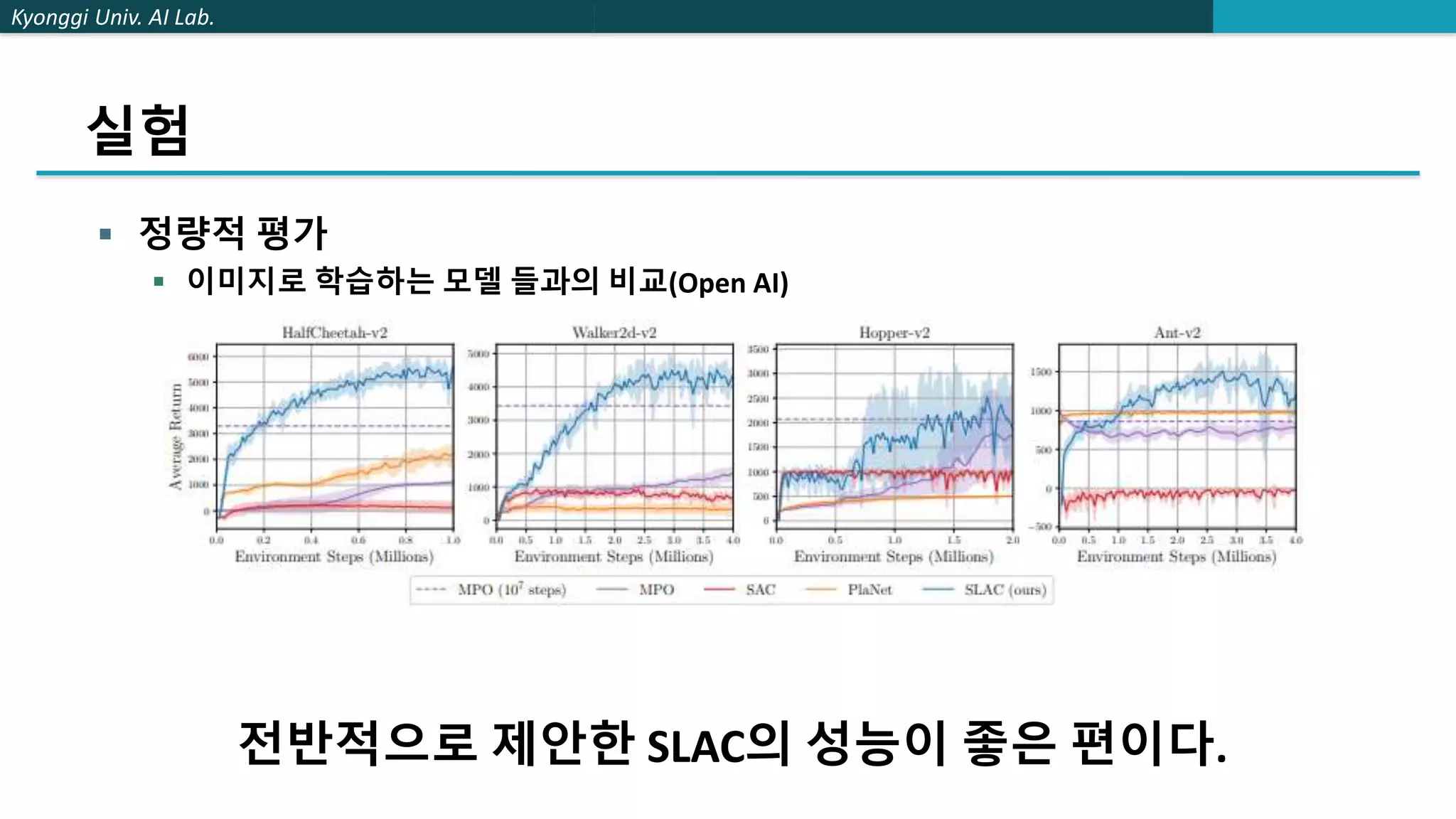

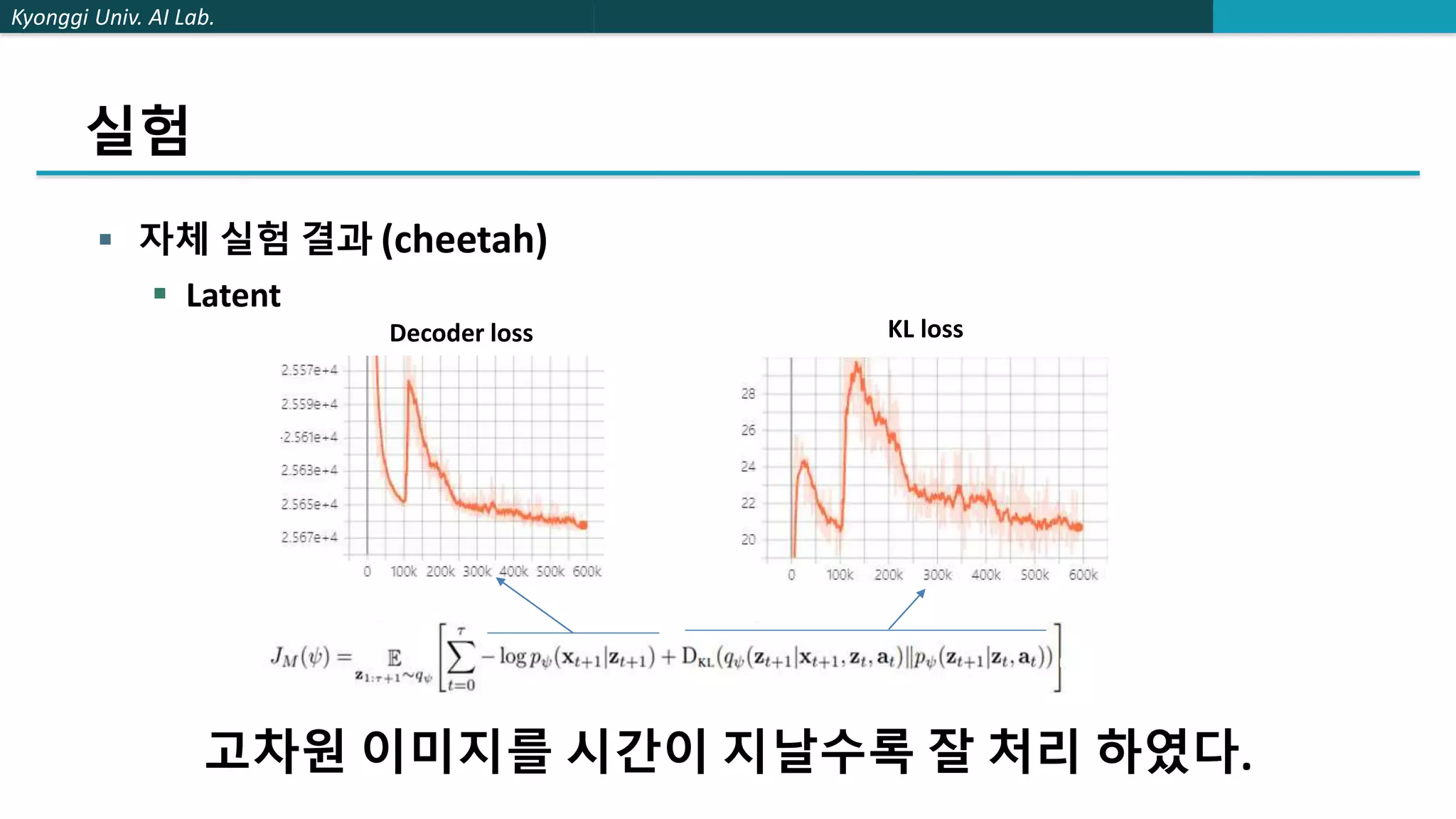

The document describes a method called stochastic latent actor-critic (SLAC) for deep reinforcement learning from high-dimensional images using a latent variable model. SLAC first learns a latent representation of images using a variational autoencoder, then performs reinforcement learning in the latent space using soft actor-critic. The method was tested on several control tasks from DeepMind and OpenAI and showed better performance than prior image-based deep RL methods. The author believes parallel training could improve the speed of SLAC, and that an adaptive entropy parameter may better balance exploration vs exploitation for complex tasks.