More Related Content

PDF

PDF

PDF

DID, Synthetic Control, CausalImpact PDF

Rにおける大規模データ解析(第10回TokyoWebMining) PPTX

PDF

PDF

PDF

What's hot

PPTX

PDF

PDF

PDF

PDF

はじめてのパターン認識 第8章 サポートベクトルマシン PDF

構造方程式モデルによる因果推論: 因果構造探索に関する最近の発展 PPTX

PDF

PDF

PPTX

PDF

PDF

PDF

PPTX

PPTX

PDF

PDF

PDF

最近のDeep Learning (NLP) 界隈におけるAttention事情 PPTX

KEY

Similar to HMM viterbi

PDF

DOCX

PDF

TokyoNLP#5 パーセプトロンで楽しい仲間がぽぽぽぽ~ん PDF

PPTX

PDF

PDF

PDF

PDF

PDF

PDF

PDF

テキストマイニングで発掘!? 売上とユーザーレビューの相関分析 PDF

ニュース・ツイッター間の対応を考慮したバースト・トピックの同定 PPTX

Text classification zansa PDF

PDF

ACL2011読み会: Query Weighting for Ranking Model Adaptation PDF

Appendix document of Chapter 6 for Mining Text Data PPTX

Tokyo nlp #8 label propagation PDF

PDF

2010 ase-tool support for essential use cases to better capture software requ... More from Koji Sekiguchi

PPTX

WikipediaからのSolr用類義語辞書の自動生成 PDF

20221209-ApacheSolrによるはじめてのセマンティックサーチ.pdf PPTX

Solr から使う OpenNLP の日本語固有表現抽出 PPTX

NLP4L - 情報検索における性能改善のためのコーパスの活用とランキング学習 PPTX

OpenNLP - MEM and Perceptron PPTX

系列パターンマイニングを用いた単語パターン学習とWikipediaからの組織名抽出 PPTX

Luceneインデックスの共起単語分析とSolrによる共起単語サジェスチョン PPTX

PDF

LUCENE-5252 NGramSynonymTokenizer PPTX

PDF

コーパス学習による Apache Solr の徹底活用 PDF

An Introduction to NLP4L (Scala by the Bay / Big Data Scala 2015) PPTX

Visualize terms network in Lucene index PPTX

PDF

PDF

Learning-to-Rank meetup Vol. 1 PDF

PDF

PPTX

Lucene 6819-good-bye-index-time-boost PDF

Recently uploaded

PDF

第25回FA設備技術勉強会_自宅で勉強するROS・フィジカルAIアイテム.pdf PDF

visionOS TC「新しいマイホームで過ごすApple Vision Proとの新生活」 PDF

安価な ロジック・アナライザを アナライズ(?),Analyze report of some cheap logic analyzers PDF

PCCC25(設立25年記念PCクラスタシンポジウム):東京大学情報基盤センター テーマ1/2/3「Society5.0の実現を目指す『計算・データ・学習... PDF

基礎から学ぶ PostgreSQL の性能監視 (PostgreSQL Conference Japan 2025 発表資料) PPTX

HMM viterbi

- 1.

- 2.

英語の品詞タグ付けでの利用例

2

入力

テキスト

HMM:

Hidden Markov Model

コーパス

HMM POS Viterbi

(教師あ 学習 Tagger Algorithm

り) モデル

出力

品詞タグ付

きテキスト

- 3.

系列ラベリング

3

データ系列の入力に対し、クラスの系列を出力

普通の分類問題とは異なる

普通の分類問題:F →c

系列ラベリング:F1F2…Fn → c1c2…cn

F1 F2 F3 F4 F5

Time flies like an allow.

c1 c2 c3 c4 c5

[名詞] [動詞] [前置詞] [冠詞] [名詞]

- 4.

系列ラベリング問題の解き方

4

通常の分類器の逐次適用

ciの推定に、Fi, Fi-1, Fi+1やci-1などを用いる

F1 F2 F3 F4 F5 …

c1 c2 c3 c4 c5 …

隠れマルコフモデル

条件付き確率場(CRF)

- 5.

マルコフ過程

5

マルコフ過程

ある記号の出力確率が、直前のN個の記号によって決

まるとする確率過程

隠れマルコフモデル

「システムがパラメータ未知のマルコフ過程」と仮定

し、観測可能な情報からその未知パラメータを推定

(Wikipedia)

外部で観測されるのは単語列であり、内部状態として

見えない品詞の遷移がある(参考文献[1], [2])

教師あり学習データを用いるのに「隠れ」とは違和感

あるが、NLPでは呼称が定着(参考文献[3])

- 6.

- 7.

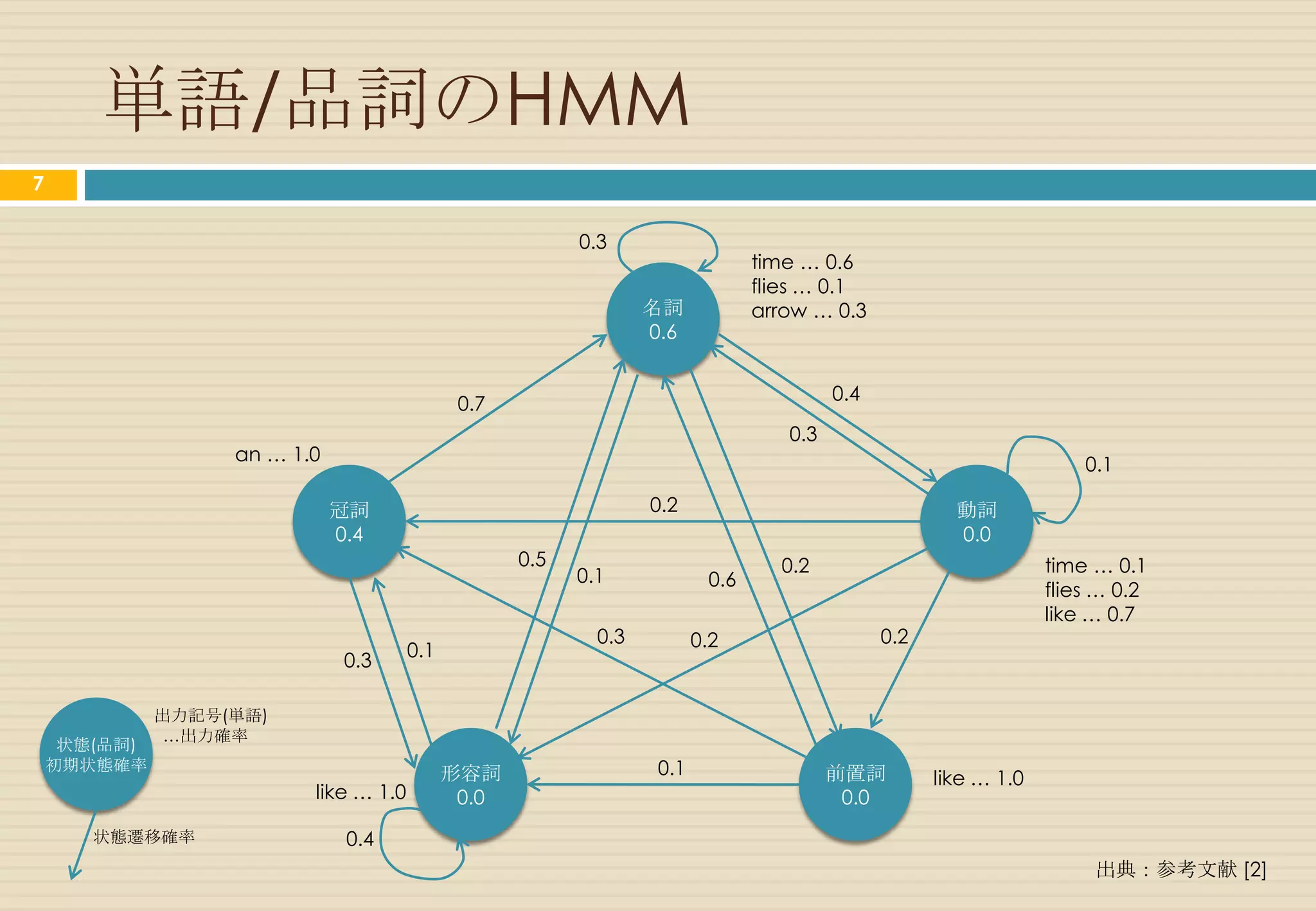

HMM=オートマトンの一種

7

隠れマルコフモデルは5項組 M=(Q, Σ, A, B, π) により定義される。

状態の有限集合

出力記号の有限集合

状態遷移確率分布

記号出力確率分布

初期状態確率分布

- 8.

単語/品詞のHMM

8

0.3

time … 0.6

flies … 0.1

名詞 arrow … 0.3

0.6

0.4

0.7

0.3

an … 1.0 0.1

冠詞 0.2 動詞

0.4 0.0

0.5 0.2 time … 0.1

0.1 0.6

flies … 0.2

like … 0.7

0.3 0.2 0.2

0.1

0.3

出力記号(単語)

…出力確率

状態(品詞)

初期状態確率

形容詞 0.1 前置詞 like … 1.0

like … 1.0 0.0 0.0

状態遷移確率 0.4

出典:参考文献 [2]

- 9.

HMMを適用する問題

9

評価問題 : 出力記号系列

P(o1T|M)を求める問題

素朴な方法(O(NT))

: 状態遷移系列

前向きアルゴリズム(O(N2T))

後向きアルゴリズム(O(N2T))

復号化問題

argmax{q1T}P(o1T,q1T|M)を求める問題

ビタビアルゴリズム

推定問題

argmax{M}P(o1T|M)を求める問題

前向き後向きアルゴリズム

EMアルゴリズム

- 10.

- 11.

- 12.

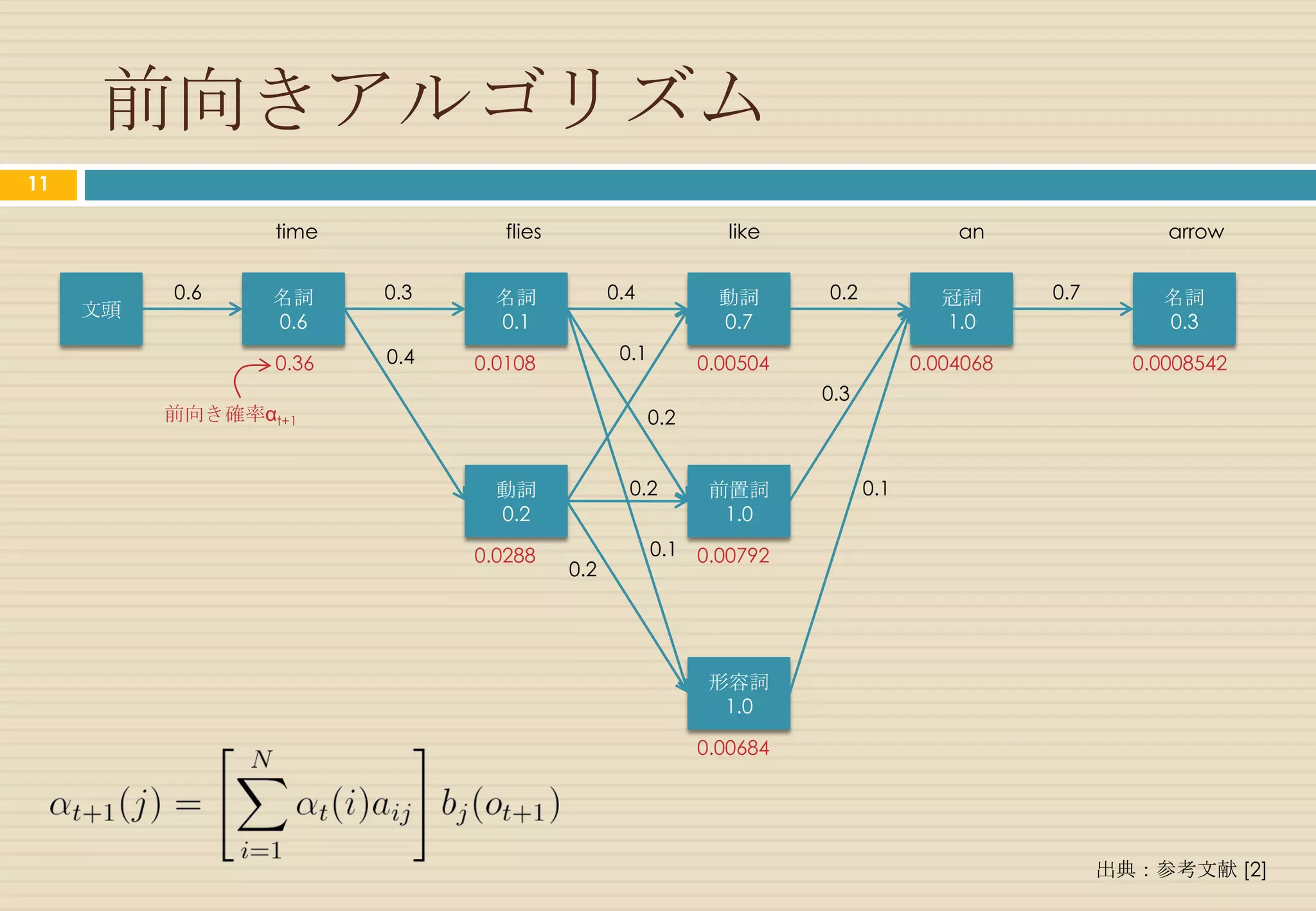

前向きアルゴリズム

12

time flies like an arrow

0.6 名詞 0.3 名詞 0.4 動詞 0.2 冠詞 0.7 名詞

文頭

0.6 0.1 0.7 1.0 0.3

0.4 0.1

0.36 0.0108 0.00504 0.004068 0.0008542

0.3

前向き確率αt+1 0.2

動詞 0.2 前置詞 0.1

0.2 1.0

0.0288 0.1 0.00792

0.2

形容詞

1.0

0.00684

出典:参考文献 [2]

- 13.

ビタビアルゴリズム

13

時刻tで状態qiに到達する状態遷移系列q1t-1に関し

て最大の確率値を記憶する

時刻t+1で最大の確率値を与える直前の時刻tの状

態iを記憶する

- 14.

ビタビアルゴリズム

14

1. 変数の初期化

2. 最大確率値と状態の再帰計算

3. 再帰計算の終了

4. バックトラックによる最適状態遷移系列の復元

- 15.

ビタビアルゴリズム

15

time flies like an arrow

0.6 名詞 0.3 名詞 0.4 動詞 0.2 冠詞 0.7 名詞

文頭

0.6 0.1 0.7 1.0 0.3

0.4 0.1

0.36 0.0108 0.003024 0.001728 0.0003628

0.3

最大の確率値 δt+1 0.2

動詞 0.2 前置詞 0.1

0.2 1.0

0.0288 0.1 0.00576

0.2

形容詞

1.0

0.00576

出典:参考文献 [2]

- 16.

参考文献

16

[1] 岩波講座ソフトウェア科学15自然言語処理長

尾真編岩波書店

[2] 言語と計算4確率的言語モデル北研二著東京大

学出版会

[3] 自然言語処理シリーズ1言語処理のための機械

学習入門奥村学監修コロナ社

[4] 自然言語処理の基礎奥村学著コロナ社

![系列ラベリング

3

データ系列の入力に対し、クラスの系列を出力

普通の分類問題とは異なる

普通の分類問題:F →c

系列ラベリング:F1F2…Fn → c1c2…cn

F1 F2 F3 F4 F5

Time flies like an allow.

c1 c2 c3 c4 c5

[名詞] [動詞] [前置詞] [冠詞] [名詞]](https://image.slidesharecdn.com/hmm-viterbi-120923075810-phpapp01/75/HMM-viterbi-3-2048.jpg)

![マルコフ過程

5

マルコフ過程

ある記号の出力確率が、直前のN個の記号によって決

まるとする確率過程

隠れマルコフモデル

「システムがパラメータ未知のマルコフ過程」と仮定

し、観測可能な情報からその未知パラメータを推定

(Wikipedia)

外部で観測されるのは単語列であり、内部状態として

見えない品詞の遷移がある(参考文献[1], [2])

教師あり学習データを用いるのに「隠れ」とは違和感

あるが、NLPでは呼称が定着(参考文献[3])](https://image.slidesharecdn.com/hmm-viterbi-120923075810-phpapp01/75/HMM-viterbi-5-2048.jpg)

![単語/品詞のHMM

8

0.3

time … 0.6

flies … 0.1

名詞 arrow … 0.3

0.6

0.4

0.7

0.3

an … 1.0 0.1

冠詞 0.2 動詞

0.4 0.0

0.5 0.2 time … 0.1

0.1 0.6

flies … 0.2

like … 0.7

0.3 0.2 0.2

0.1

0.3

出力記号(単語)

…出力確率

状態(品詞)

初期状態確率

形容詞 0.1 前置詞 like … 1.0

like … 1.0 0.0 0.0

状態遷移確率 0.4

出典:参考文献 [2]](https://image.slidesharecdn.com/hmm-viterbi-120923075810-phpapp01/75/HMM-viterbi-8-2048.jpg)

![状態遷移系列の生成確率

10

N: 名詞, V: 動詞, P: 前置詞, D: 冠詞 出典:参考文献 [2]](https://image.slidesharecdn.com/hmm-viterbi-120923075810-phpapp01/75/HMM-viterbi-10-2048.jpg)

![前向きアルゴリズム

12

time flies like an arrow

0.6 名詞 0.3 名詞 0.4 動詞 0.2 冠詞 0.7 名詞

文頭

0.6 0.1 0.7 1.0 0.3

0.4 0.1

0.36 0.0108 0.00504 0.004068 0.0008542

0.3

前向き確率αt+1 0.2

動詞 0.2 前置詞 0.1

0.2 1.0

0.0288 0.1 0.00792

0.2

形容詞

1.0

0.00684

出典:参考文献 [2]](https://image.slidesharecdn.com/hmm-viterbi-120923075810-phpapp01/75/HMM-viterbi-12-2048.jpg)

![ビタビアルゴリズム

15

time flies like an arrow

0.6 名詞 0.3 名詞 0.4 動詞 0.2 冠詞 0.7 名詞

文頭

0.6 0.1 0.7 1.0 0.3

0.4 0.1

0.36 0.0108 0.003024 0.001728 0.0003628

0.3

最大の確率値 δt+1 0.2

動詞 0.2 前置詞 0.1

0.2 1.0

0.0288 0.1 0.00576

0.2

形容詞

1.0

0.00576

出典:参考文献 [2]](https://image.slidesharecdn.com/hmm-viterbi-120923075810-phpapp01/75/HMM-viterbi-15-2048.jpg)

![参考文献

16

[1] 岩波講座ソフトウェア科学15自然言語処理長

尾真編岩波書店

[2] 言語と計算4確率的言語モデル北研二著東京大

学出版会

[3] 自然言語処理シリーズ1言語処理のための機械

学習入門奥村学監修コロナ社

[4] 自然言語処理の基礎奥村学著コロナ社](https://image.slidesharecdn.com/hmm-viterbi-120923075810-phpapp01/75/HMM-viterbi-16-2048.jpg)