Recommended

PDF

サポートベクターマシン(SVM)の数学をみんなに説明したいだけの会

PDF

はじめてのパターン認識 第5章 k最近傍法(k_nn法)

PPTX

PDF

BlackBox モデルの説明性・解釈性技術の実装

PDF

PDF

PDF

PDF

クラシックな機械学習入門:付録:よく使う線形代数の公式

PDF

PDF

パターン認識と機械学習 §6.2 カーネル関数の構成

PDF

PDF

PPTX

PDF

[DL輪読会]深層強化学習はなぜ難しいのか?Why Deep RL fails? A brief survey of recent works.

PDF

PDF

PDF

PDF

PDF

基礎からのベイズ統計学 輪読会資料 第4章 メトロポリス・ヘイスティングス法

PPTX

[DL輪読会]ドメイン転移と不変表現に関するサーベイ

PPTX

PDF

PDF

PDF

トピックモデルの評価指標 Perplexity とは何なのか?

PDF

PDF

Attentionの基礎からTransformerの入門まで

PDF

PDF

Word Tour: One-dimensional Word Embeddings via the Traveling Salesman Problem...

PDF

SVM実践ガイド (A Practical Guide to Support Vector Classification)

PDF

More Related Content

PDF

サポートベクターマシン(SVM)の数学をみんなに説明したいだけの会

PDF

はじめてのパターン認識 第5章 k最近傍法(k_nn法)

PPTX

PDF

BlackBox モデルの説明性・解釈性技術の実装

PDF

PDF

PDF

PDF

クラシックな機械学習入門:付録:よく使う線形代数の公式

What's hot

PDF

PDF

パターン認識と機械学習 §6.2 カーネル関数の構成

PDF

PDF

PPTX

PDF

[DL輪読会]深層強化学習はなぜ難しいのか?Why Deep RL fails? A brief survey of recent works.

PDF

PDF

PDF

PDF

PDF

基礎からのベイズ統計学 輪読会資料 第4章 メトロポリス・ヘイスティングス法

PPTX

[DL輪読会]ドメイン転移と不変表現に関するサーベイ

PPTX

PDF

PDF

PDF

トピックモデルの評価指標 Perplexity とは何なのか?

PDF

PDF

Attentionの基礎からTransformerの入門まで

PDF

PDF

Word Tour: One-dimensional Word Embeddings via the Traveling Salesman Problem...

Similar to はじパタ8章 svm

PDF

SVM実践ガイド (A Practical Guide to Support Vector Classification)

PDF

PDF

はじめてのパターン認識 第8章 サポートベクトルマシン

PDF

Tokyo.R 41 サポートベクターマシンで眼鏡っ娘分類システム構築

PDF

PDF

パターン認識 第12章 正則化とパス追跡アルゴリズム

PPTX

PPTX

PDF

ML: Sparse regression CH.13

PPT

PDF

PDF

Casual learning machine learning with_excel_no4

PDF

PPTX

PDF

Math in Machine Learning / PCA and SVD with Applications

PDF

PPTX

クラシックな機械学習の入門 5. サポートベクターマシン

PDF

PDF

修士論文発表:「非負値行列分解における漸近的Bayes汎化誤差」

PDF

More from tetsuro ito

PDF

PDF

20170912 data analyst meetup tokyo vol.5

PDF

PDF

20170207 bigdata analytics_tokyo講演資料

PDF

20161029 dots machine learning in money forward

PDF

PDF

PDF

20150531分析プラットホームとその技術(bizreach) cookpad ito #dcube_analysis

PDF

PDF

PDF

PDF

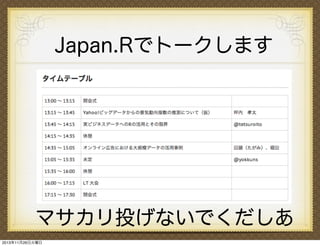

20140329 tokyo r lt 「カーネルとsvm」

PDF

PDF

Japan.r 2013 「実ビジネスデータへのrの活用とその限界」

PDF

PDF

PDF

PDF

PDF

KEY

集合知プログラミング勉強会キックオフMTG LT用資料

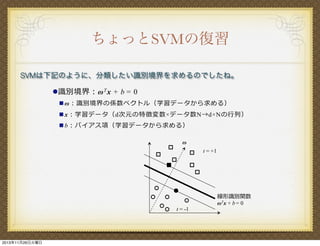

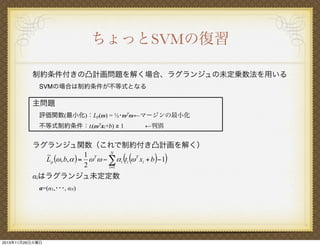

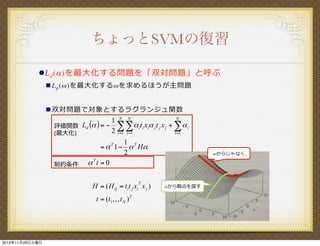

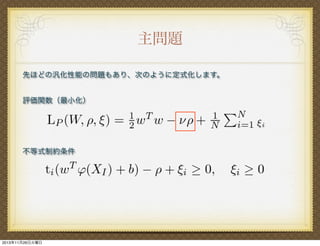

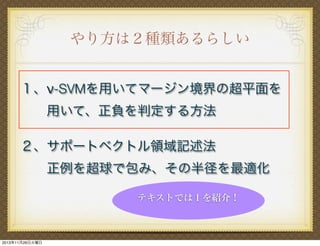

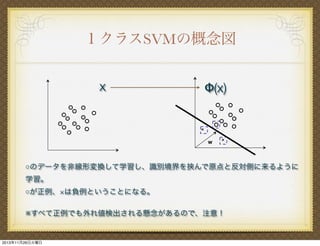

はじパタ8章 svm 1. 2. 3. 4. 5. 6. ちょっとSVMの復習

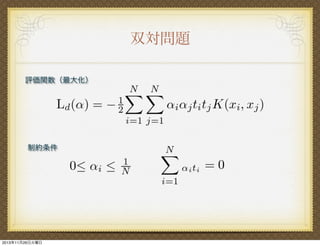

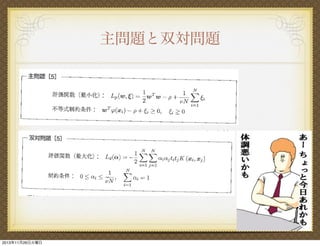

! L d (!)を最

" L p (#)を最

化する問題を「双対問題」と呼ぶ"

化する#を求めるほうが主問題!

" 双対問題で対象とするラグランジュ関数

N

1 N N

評価関数 Ld (# ) = ! "" # i ti xi# j t j x j + " # i

2 i =1 j =1

i =1

(最 化)

1 T

= # 1 ! # H#

2

#Tt = 0

T

制約条件

T

H = ( H ij = ti t j xi x j )

t = (t1 , , , t N )T

2013年11月26日火曜日

#からじゃなく、

!から鞍点を探す

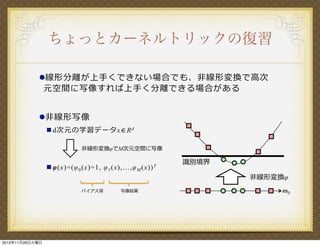

7. ちょっとカーネルトリックの復習

! 線 形分離が上 くできない場合でも、 線形変換で

元空間に写像すれば上 く分離できる場合がある

次

! 線形写像

" d次元の学習データx∈R d

線形変換!でM次元空間に写像

" !(x)=(! 0 (x)=1, ! 1 (x),…,! M

バイアス項

2013年11月26日火曜日

写像結果

(x)) T

識別境界

線形変換!

!0

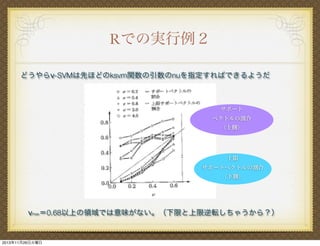

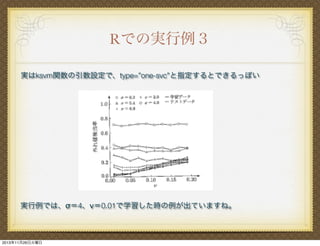

8. 9. 10. 11. Rでの実行例

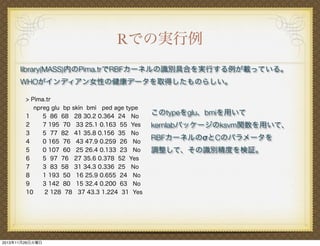

library(MASS)内のPima.trでRBFカーネルの識別具合を実行する例が載っている。

WHOがインディアン女性の健康データを取得したものらしい。

> Pima.tr

npreg glu bp skin bmi ped age type

1

5 86 68 28 30.2 0.364 24 No

2

7 195 70 33 25.1 0.163 55 Yes

3

5 77 82 41 35.8 0.156 35 No

4

0 165 76 43 47.9 0.259 26 No

5

0 107 60 25 26.4 0.133 23 No

6

5 97 76 27 35.6 0.378 52 Yes

7

3 83 58 31 34.3 0.336 25 No

8

1 193 50 16 25.9 0.655 24 No

9

3 142 80 15 32.4 0.200 63 No

10

2 128 78 37 43.3 1.224 31 Yes

2013年11月26日火曜日

このtypeをglu、bmiを用いて

kernlabパッケージのksvm関数を用いて、

RBFカーネルのσとCのパラメータを

調整して、その識別精度を検証。

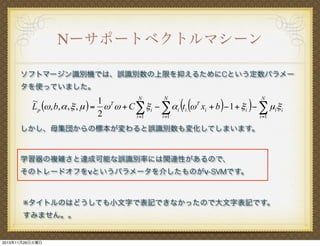

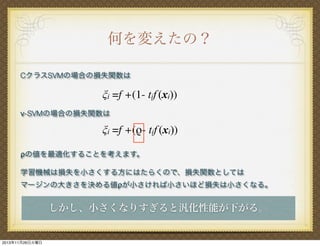

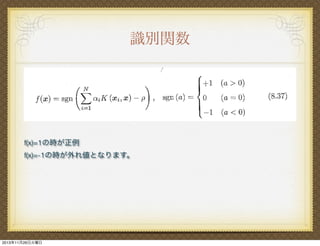

12. 13. 14. 何を変えたの?

CクラスSVMの場合の損失関数は

ξi =f +(1- tif (xi))

ν-SVMの場合の損失関数は

ξi =f +(ρ- tif (xi))

ρの値を最適化することを考えます。

学習機械は損失を小さくする方にはたらくので、損失関数としては

マージンの大きさを決める値ρが小さければ小さいほど損失は小さくなる。

しかし、小さくなりすぎると汎化性能が下がる。

2013年11月26日火曜日

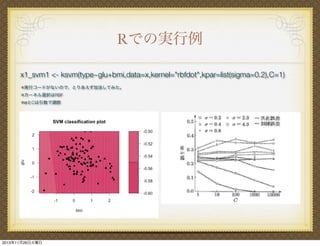

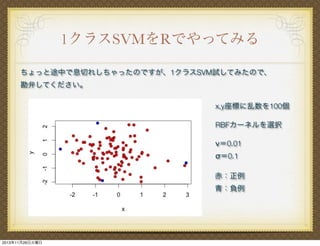

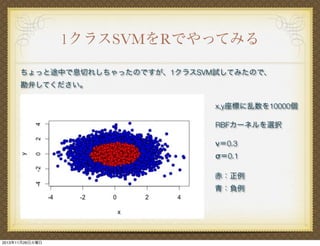

15. 16. 17. 18. 19. 20. 21. 22. 23. 24. 25. 26. 27. 28. 29. 30. コードも載せとくね

x <- rnorm(100)

y <- rnorm(100)

data <- data.frame(type=1, x, y)

library(kernlab)

data.ksvm<- ksvm(type~.,data=data,type="one-svc",kernel="rbfdot",kpar=list

(sigma=0.1),nu=0.01,cross=10)

data.ksvm.predict <- predict(data.ksvm)

data.ksvm.predict <- ifelse(data.ksvm.predict==TRUE, 1, 2)

data.result <- cbind(data,data.ksvm.predict)

plot(data.result[,2:3], pch=21, bg=c("red","blue")[data.result$data.ksvm.predict])

1万はちょっと時間かかったから、前者の例です

2013年11月26日火曜日

31. 32. 33.

![コードも載せとくね

x <- rnorm(100)

y <- rnorm(100)

data <- data.frame(type=1, x, y)

library(kernlab)

data.ksvm<- ksvm(type~.,data=data,type="one-svc",kernel="rbfdot",kpar=list

(sigma=0.1),nu=0.01,cross=10)

data.ksvm.predict <- predict(data.ksvm)

data.ksvm.predict <- ifelse(data.ksvm.predict==TRUE, 1, 2)

data.result <- cbind(data,data.ksvm.predict)

plot(data.result[,2:3], pch=21, bg=c("red","blue")[data.result$data.ksvm.predict])

1万はちょっと時間かかったから、前者の例です

2013年11月26日火曜日](https://image.slidesharecdn.com/8svm-131126053343-phpapp02/85/8-svm-30-320.jpg)