Recommended

PDF

AWS re:Invent レポート:AWS使いがいますぐすべき3つのこと

PDF

PPTX

20160404 jaws ugアーキテクチャ専門支部ハイブリッドクラウド分科会#4

PDF

PDF

Lambdaのscheduled eventで実現する運用視点のサーバレスパターン

PDF

PDF

PDF

PDF

Programming AWS with Perl at YAPC::Asia 2013

PPTX

node.jsでS3にバックアップを送り続けるコードを書いてみた話。Node s3maの紹介-jawsugさいたま

PDF

AWSでAPI Gatewayから非同期でLambdaを起動してS3にファイルアップロードしようとしたらハマった話。

PDF

Apache Arrow - A cross-language development platform for in-memory data

PDF

AWS LambdaとDynamoDBがこんなにツライはずがない #ssmjp

PPTX

Containers + EC2 Spot: AWS Batch による大規模バッチ処理でのスポットインスタンス活用

PPTX

PPTX

New Cloud Design Pattern using Amazon Aurora

PPTX

PPTX

AWS Batch Fargate対応は何をもたらすか

PDF

AWS Redshift Analyzeの必要性とvacuumの落とし穴

PDF

PDF

PDF

AWS Lambda のご紹介 2015 JAWS沖縄

PPTX

20141126 jaws-antipattern

PDF

PDF

AWS サービスアップデートまとめ 2013年9月

PDF

AWS Lambda を使ってみた話 at づや会Vol.3

PDF

PDF

AWS サービスアップデートまとめ 2014年3月

PDF

AWS初心者向けWebinar AWSではじめよう、IoTシステム構築(リピート開催用)

PDF

ユーザーからみたre:Inventのこれまでと今後

More Related Content

PDF

AWS re:Invent レポート:AWS使いがいますぐすべき3つのこと

PDF

PPTX

20160404 jaws ugアーキテクチャ専門支部ハイブリッドクラウド分科会#4

PDF

PDF

Lambdaのscheduled eventで実現する運用視点のサーバレスパターン

PDF

PDF

PDF

What's hot

PDF

Programming AWS with Perl at YAPC::Asia 2013

PPTX

node.jsでS3にバックアップを送り続けるコードを書いてみた話。Node s3maの紹介-jawsugさいたま

PDF

AWSでAPI Gatewayから非同期でLambdaを起動してS3にファイルアップロードしようとしたらハマった話。

PDF

Apache Arrow - A cross-language development platform for in-memory data

PDF

AWS LambdaとDynamoDBがこんなにツライはずがない #ssmjp

PPTX

Containers + EC2 Spot: AWS Batch による大規模バッチ処理でのスポットインスタンス活用

PPTX

PPTX

New Cloud Design Pattern using Amazon Aurora

PPTX

PPTX

AWS Batch Fargate対応は何をもたらすか

PDF

AWS Redshift Analyzeの必要性とvacuumの落とし穴

PDF

PDF

PDF

AWS Lambda のご紹介 2015 JAWS沖縄

PPTX

20141126 jaws-antipattern

PDF

PDF

AWS サービスアップデートまとめ 2013年9月

PDF

AWS Lambda を使ってみた話 at づや会Vol.3

PDF

PDF

AWS サービスアップデートまとめ 2014年3月

Viewers also liked

PDF

AWS初心者向けWebinar AWSではじめよう、IoTシステム構築(リピート開催用)

PDF

ユーザーからみたre:Inventのこれまでと今後

PDF

ほしいプロトコルはトンネルすればいいじゃない at JAWS DAYS 2014 Tech Deep Dive

PDF

これからのインフラエンジニアについて考えていること

PDF

PDF

20151016 soracom-araki-02

PDF

AWS初心者向けWebinar これで完璧、AWSの運用監視

PDF

Venture Scanner Artificial Intelligence 2016 Q4

PPTX

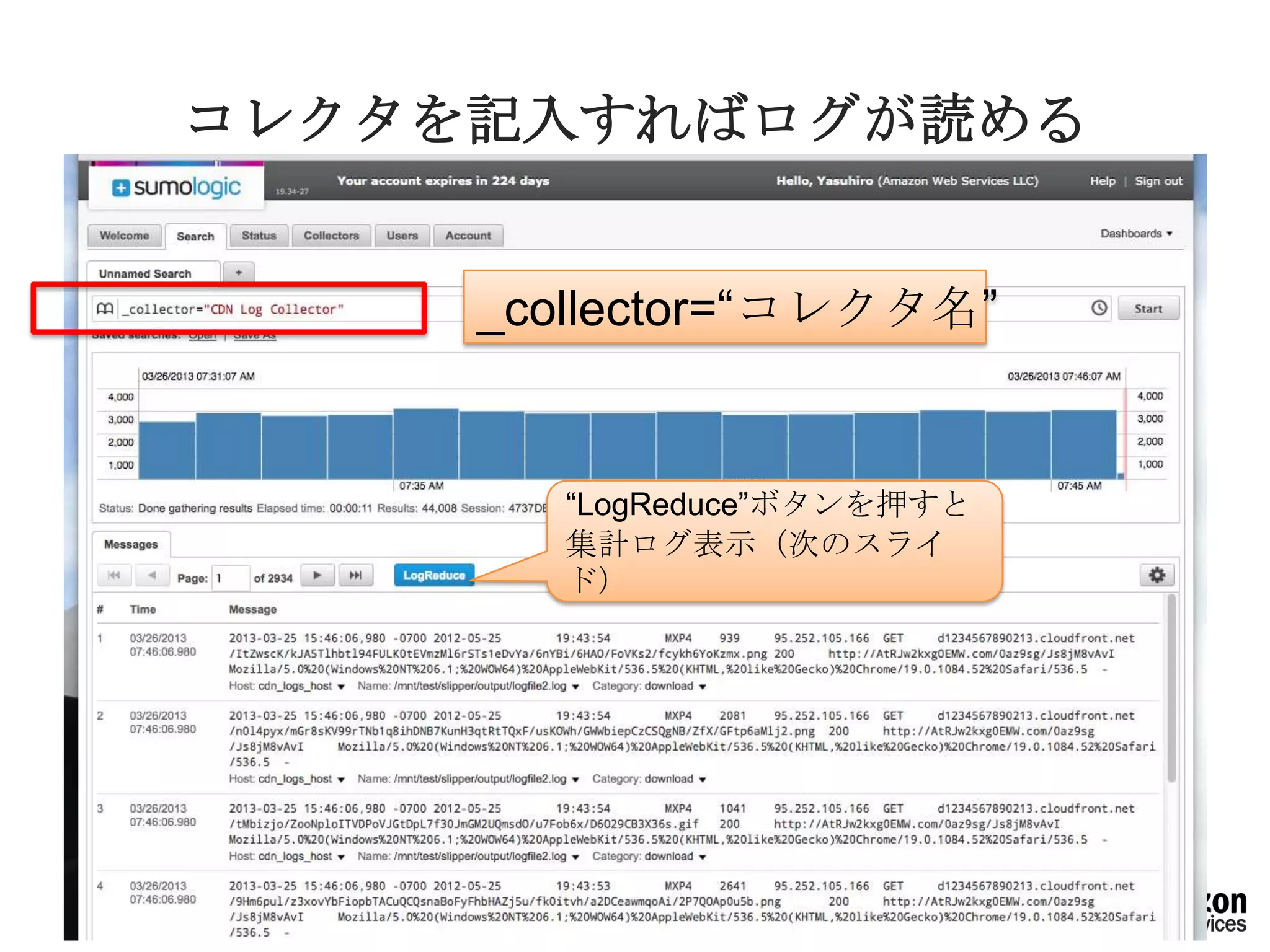

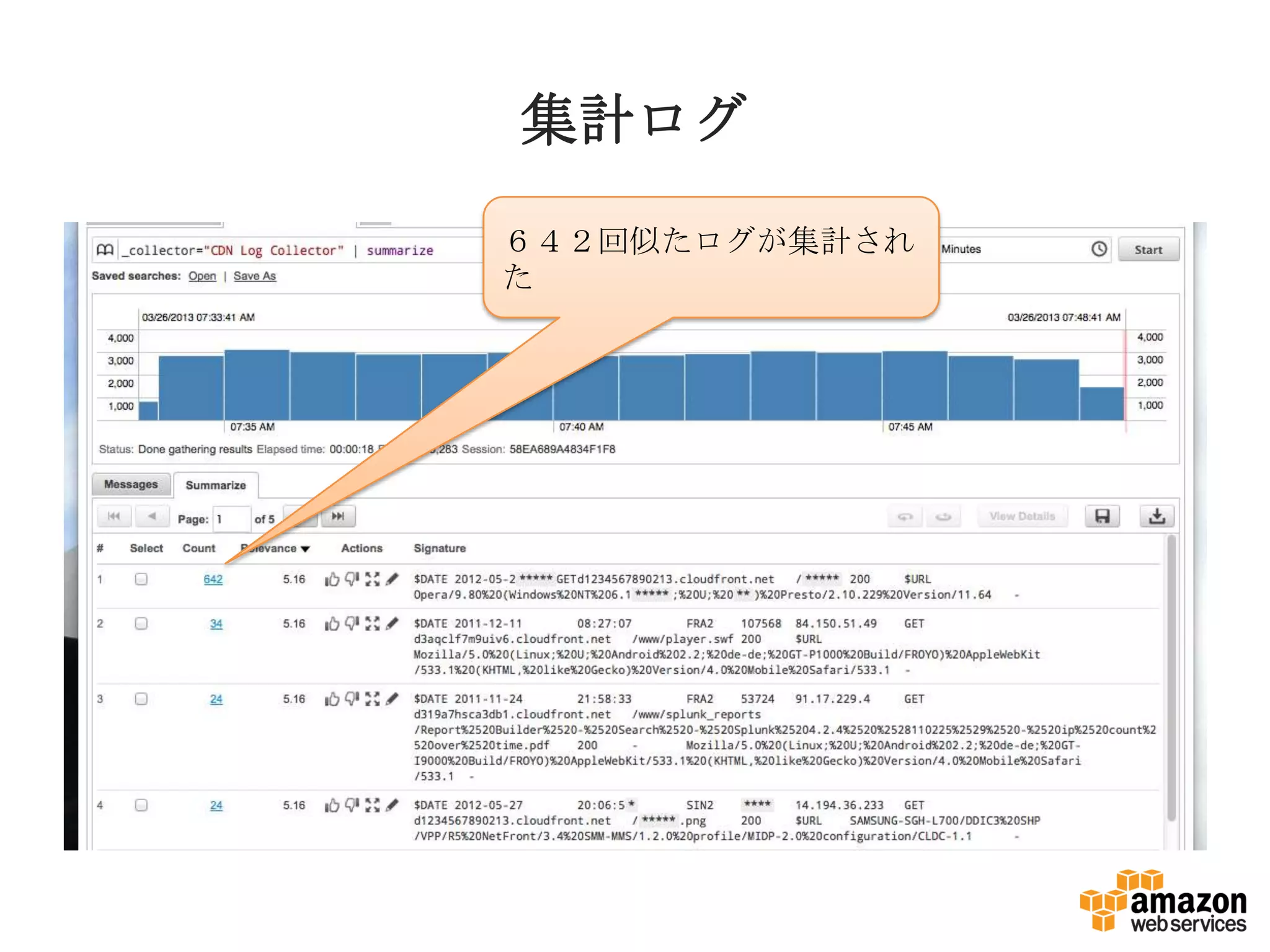

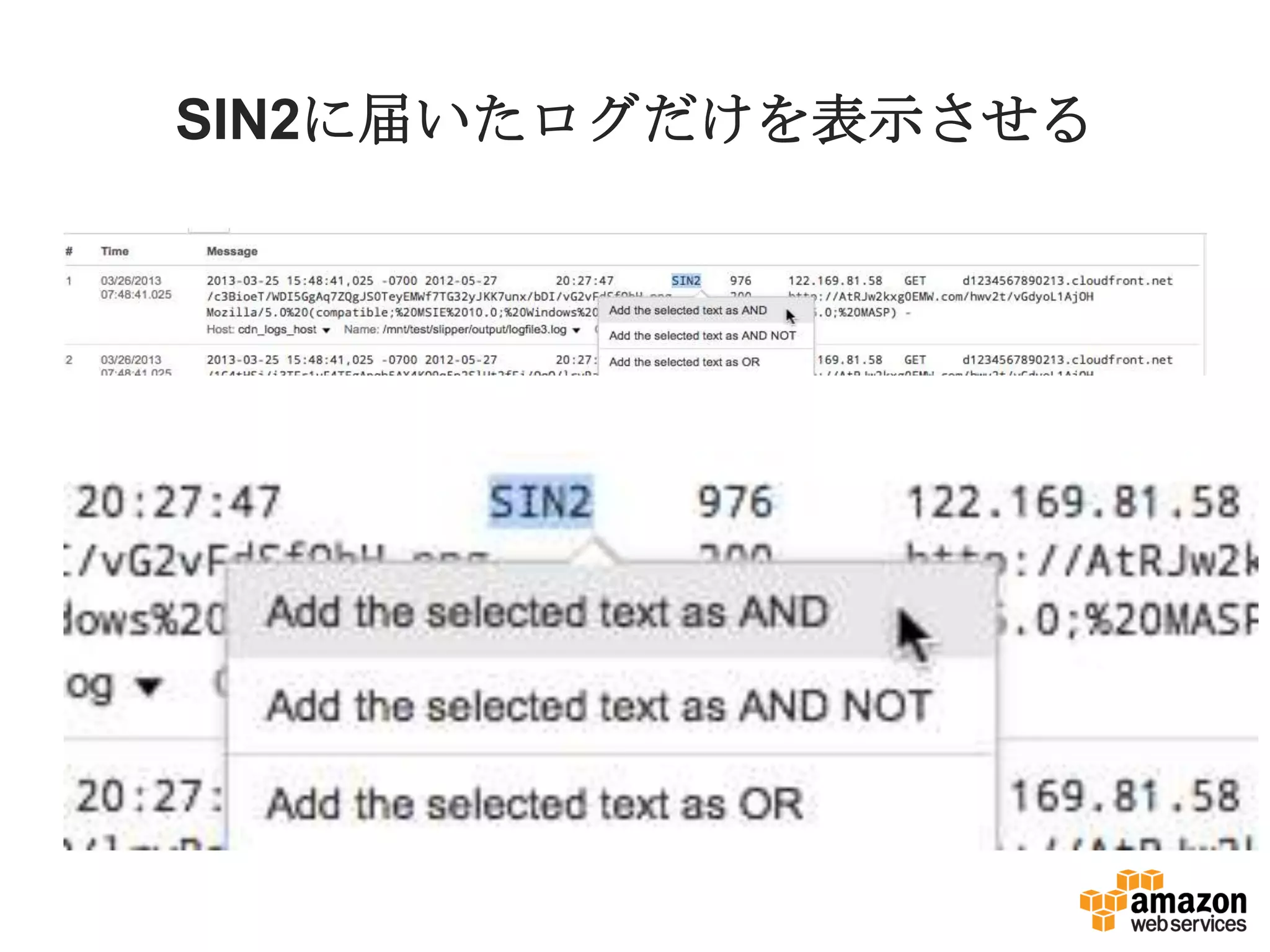

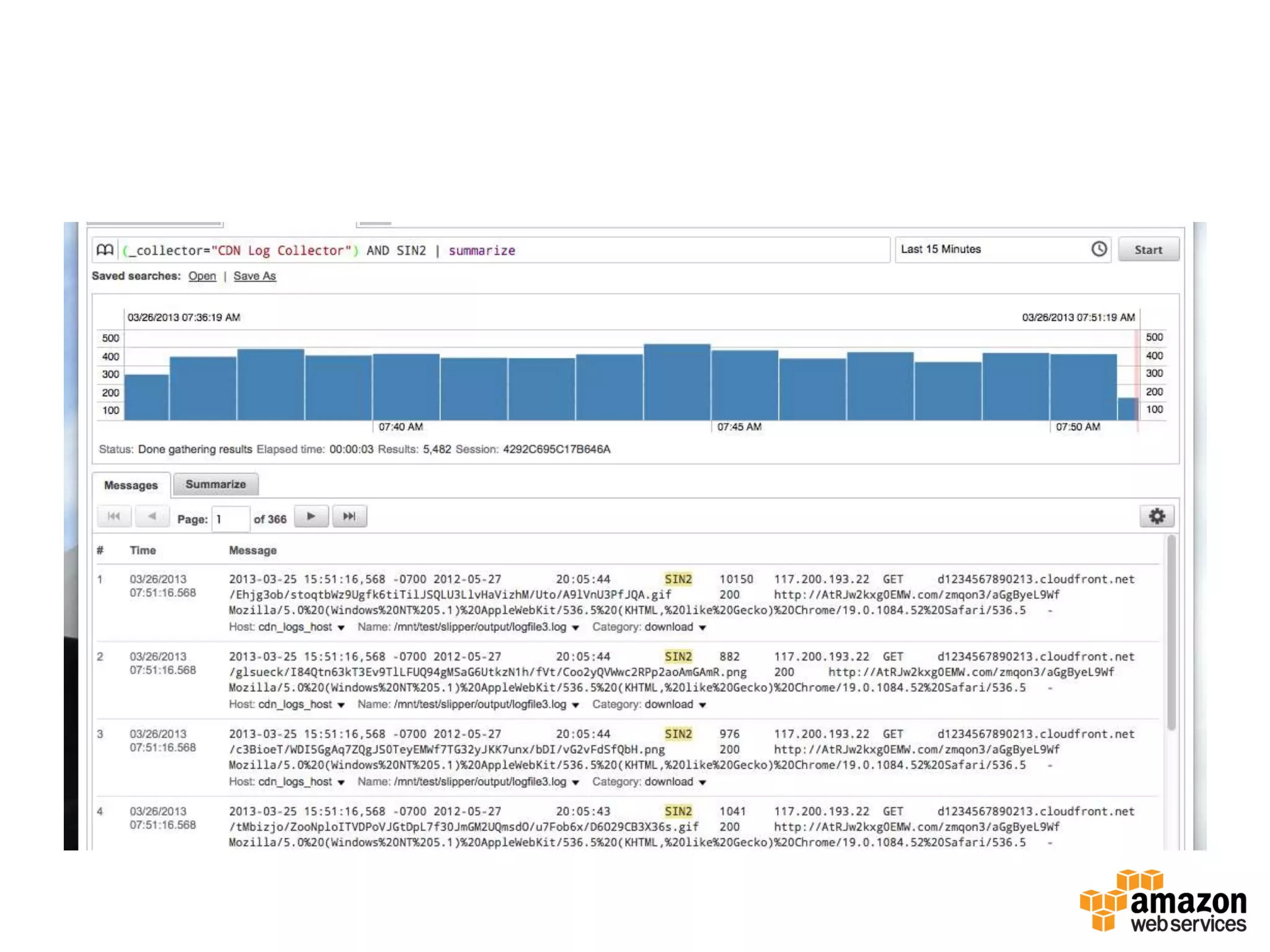

Amazon cloud trailご紹介とsumologicによる活用入門

PPTX

ログブラウズ、解析サービスSumologicの紹介

PDF

Webサービス向け、クラウドデザインパターン:アンチパターン紹介

Similar to ログ解析をあきらめない、あるいはSumoLogicの紹介

PDF

JAWS-UG CLI #25 LT - AWS Tools for Windows PowerShellでログを取得

PDF

PDF

【ウェブ セミナー】AI / アナリティクスを支えるビッグデータ基盤 Azure Data Lake [実践編]

PDF

PDF

インフラエンジニアのためのAWSサービスを利用したログ分析はじめの一歩

PDF

AWS Summit Tokyo 2019 - re:Mix refrain

PDF

PDF

[Sumo Logic x AWS 共催セミナー_20190829] Sumo Logic on AWS -AWS を活用したログ分析とセキュリティモニ...

PDF

20150523 operation jaws(JAWS-UG OSAKA #13)

PDF

20150603 AWS Summit Tokyo 2015 LT

PDF

【JAWS-UGコンテナ#14】ETL処理をServerlessにしてみた件

More from Yasuhiro Araki, Ph.D

PPTX

AWSつもり違い10箇条 at 201408 jaws高尾山ビアマウント

PPTX

PPTX

今だから!Amazon CloudFront 徹底活用

PPTX

PPTX

AWS 専用線アクセス体験ラボ紹介と�開催地立候補のお願い

PPTX

PPTX

20140628 AWSの2014前半のアップデートまとめ

PPTX

20140621 july techfesta (JTF2014) 突発**むけAWS

PPTX

PDF

20140418 aws-casual-network

PPTX

クラウドによる運用の計測と運用価値の表現、その未来

PPTX

20141202 jaws-osaka-hangeki

PDF

opsworks本番前提でopsworksを使わないで開発する話 at #jawsug #chibadan

PDF

Aws update jawstokyo-public

PDF

サービスをスケールさせるために AWSと利用者の技術

PDF

AWSにみる日本のクラウドのトレンド予測 20150321 jaws-tohoku

PDF

20140717 awssummit2014-cloud-operation

PPTX

20140906 jawsfesta-araki-lt

PPTX

20140906 jawsfesta-araki-public

PDF

1999年JUSメールサーバワークショップ@伊勢志摩

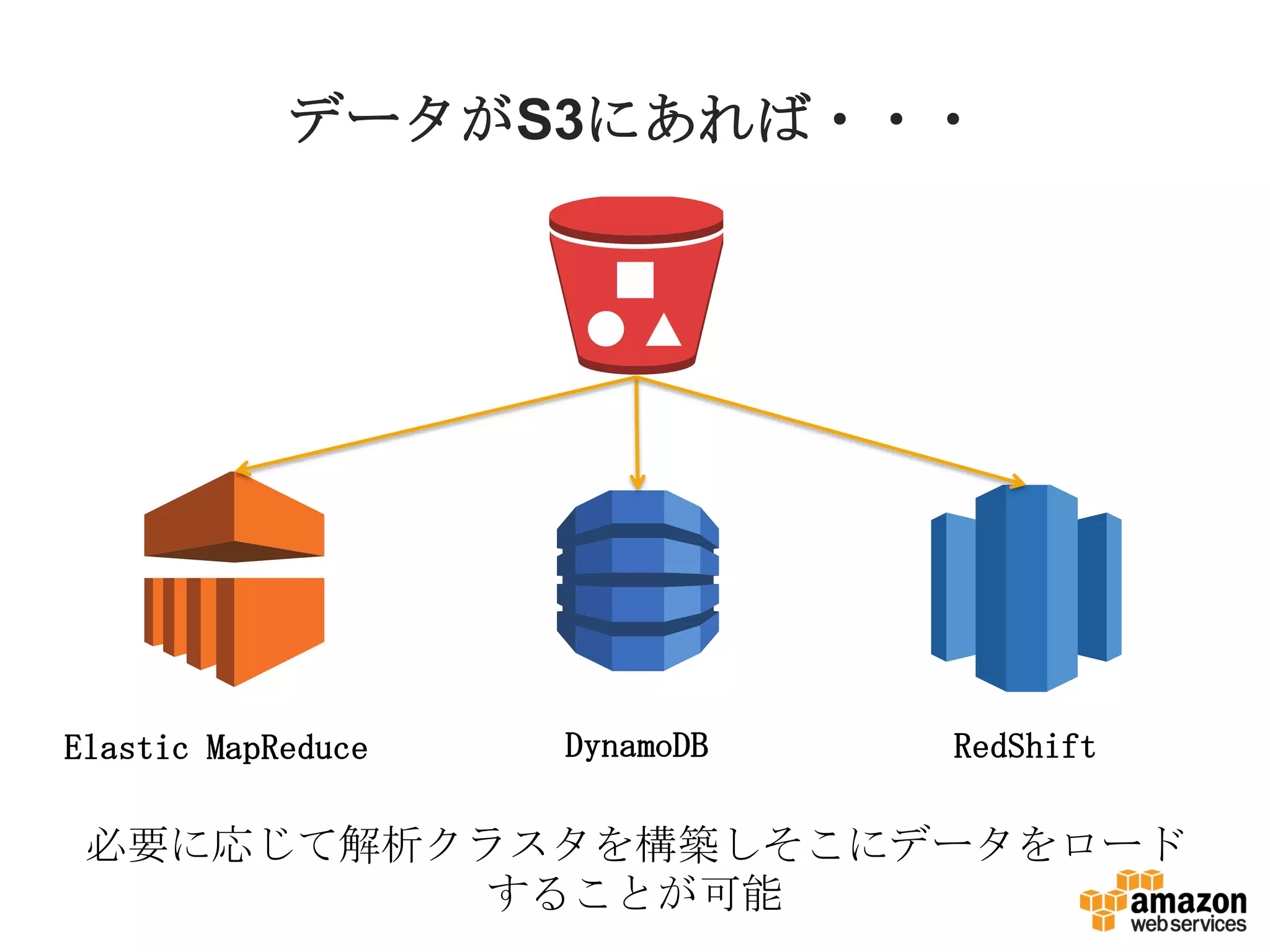

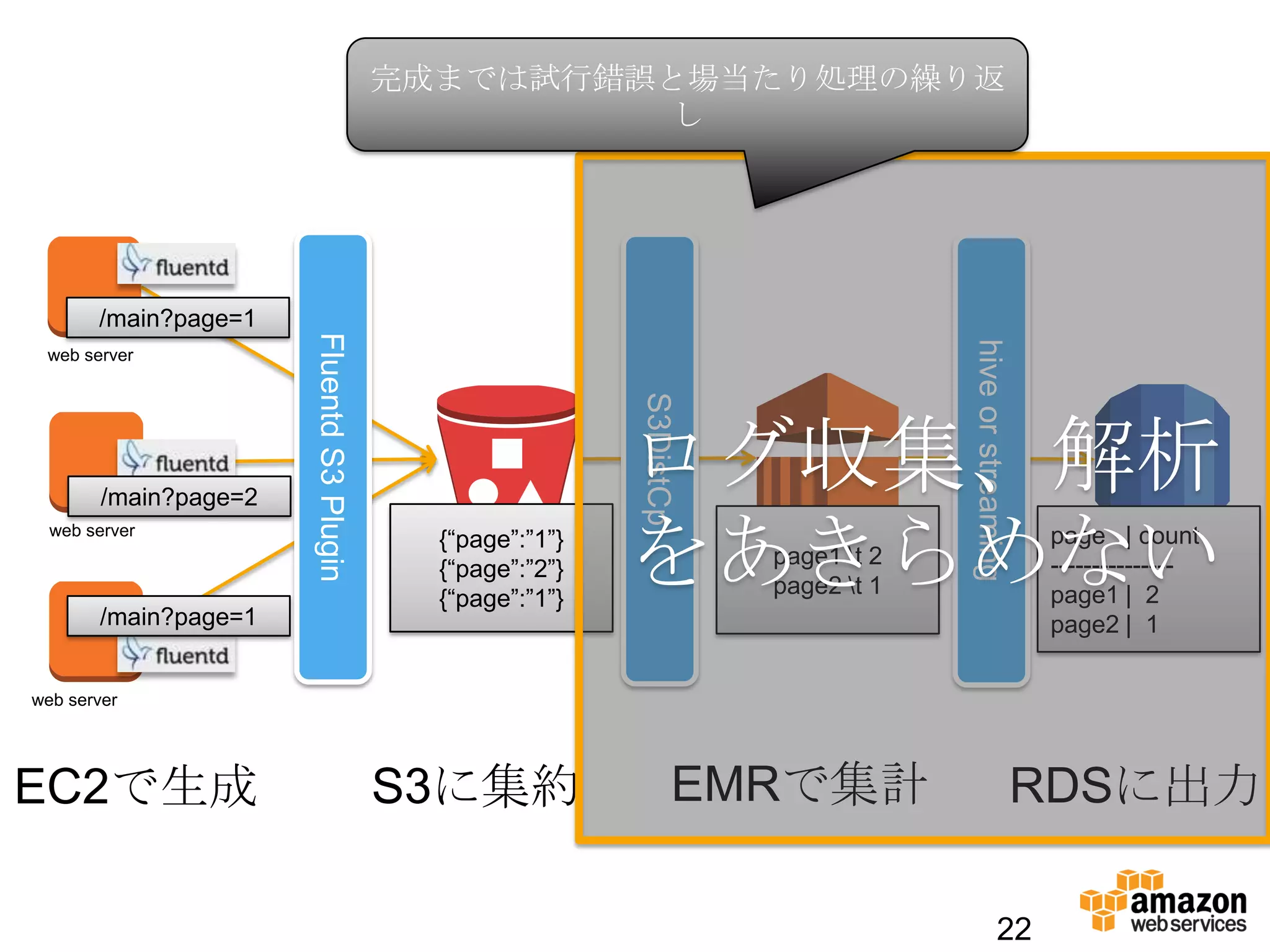

ログ解析をあきらめない、あるいはSumoLogicの紹介 1. 2. 3. 4. 4

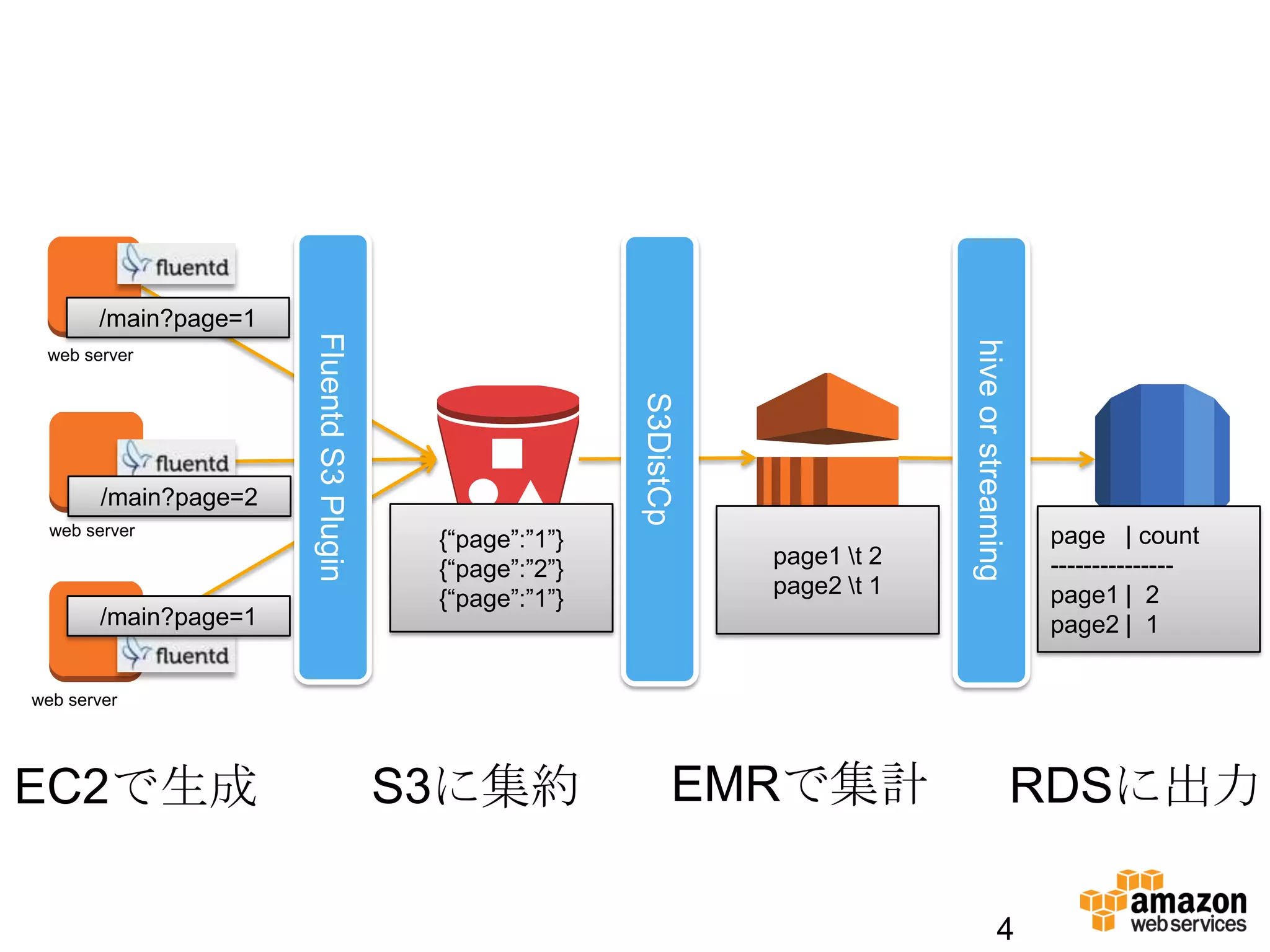

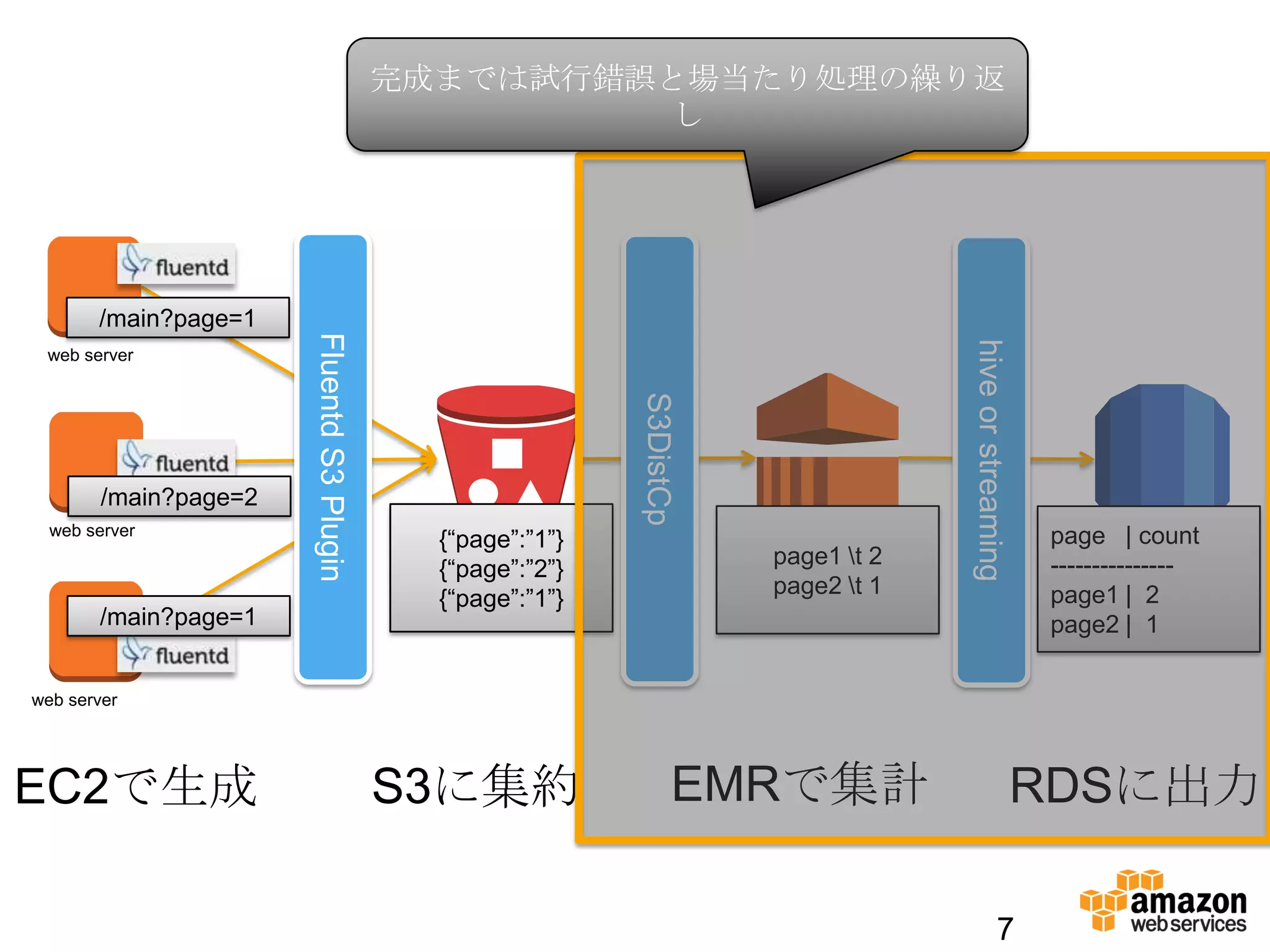

web server

web server

web server

EC2で生成 S3に集約 EMRで集計

FluentdS3Plugin

S3DistCp

hiveorstreaming

RDSに出力

/main?page=1

/main?page=2

/main?page=1

{“page”:”1”}

{“page”:”2”}

{“page”:”1”}

page1 t 2

page2 t 1

page | count

---------------

page1 | 2

page2 | 1

5. 6. 7. 7

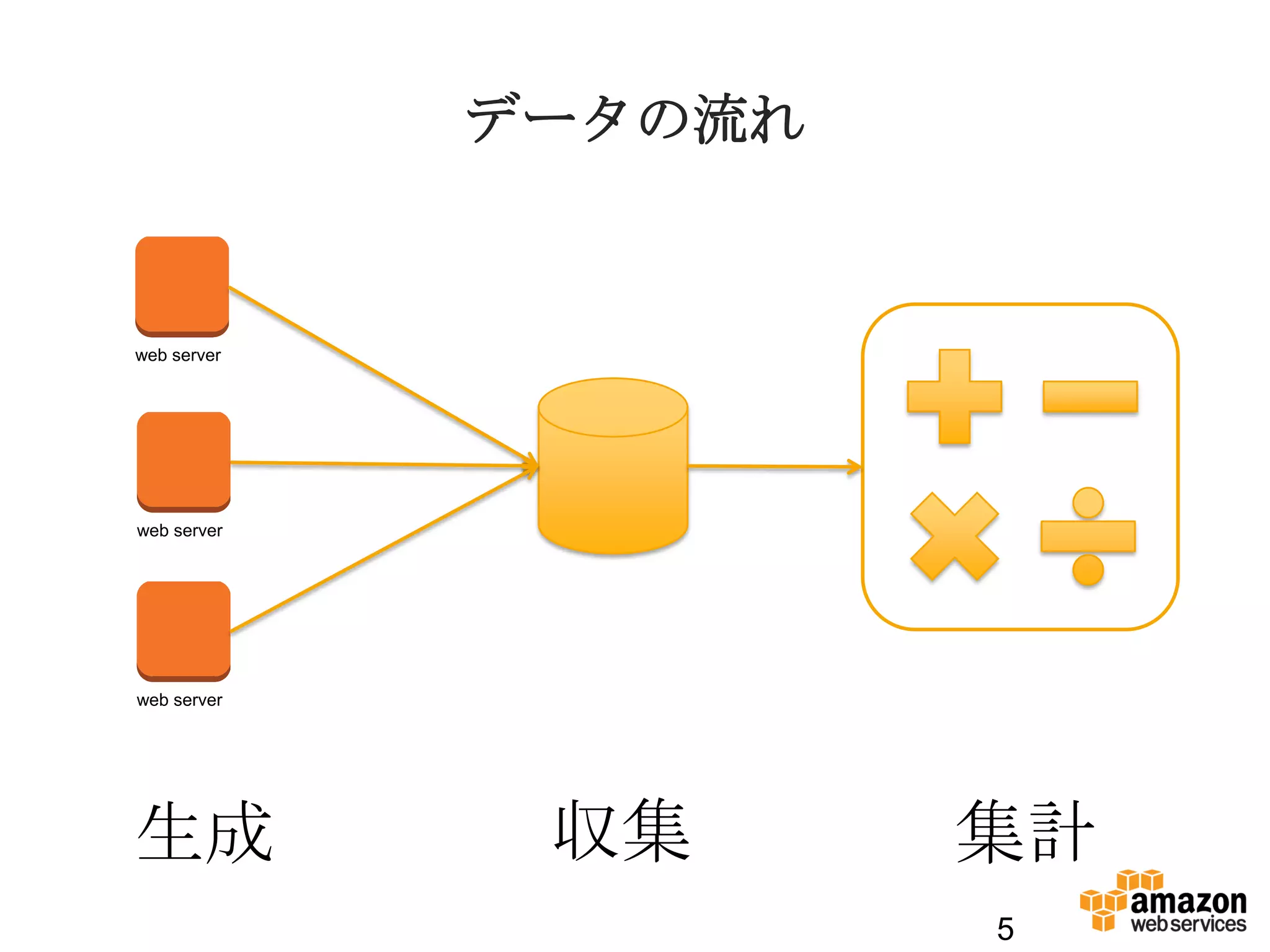

web server

web server

web server

EC2で生成 S3に集約 EMRで集計

FluentdS3Plugin

S3DistCp

hiveorstreaming

RDSに出力

/main?page=1

/main?page=2

/main?page=1

{“page”:”1”}

{“page”:”2”}

{“page”:”1”}

page1 t 2

page2 t 1

page | count

---------------

page1 | 2

page2 | 1

完成までは試行錯誤と場当たり処理の繰り返

し

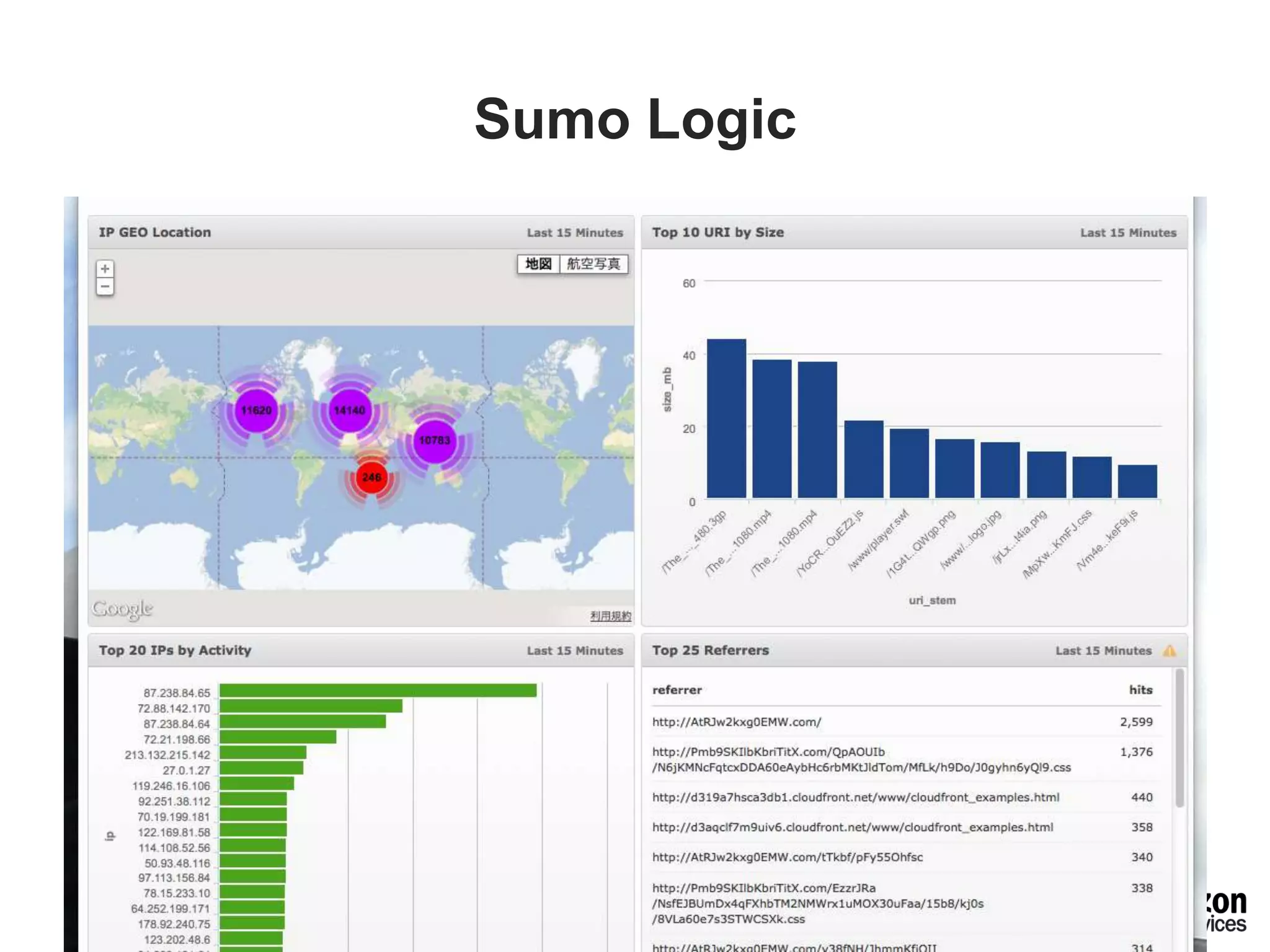

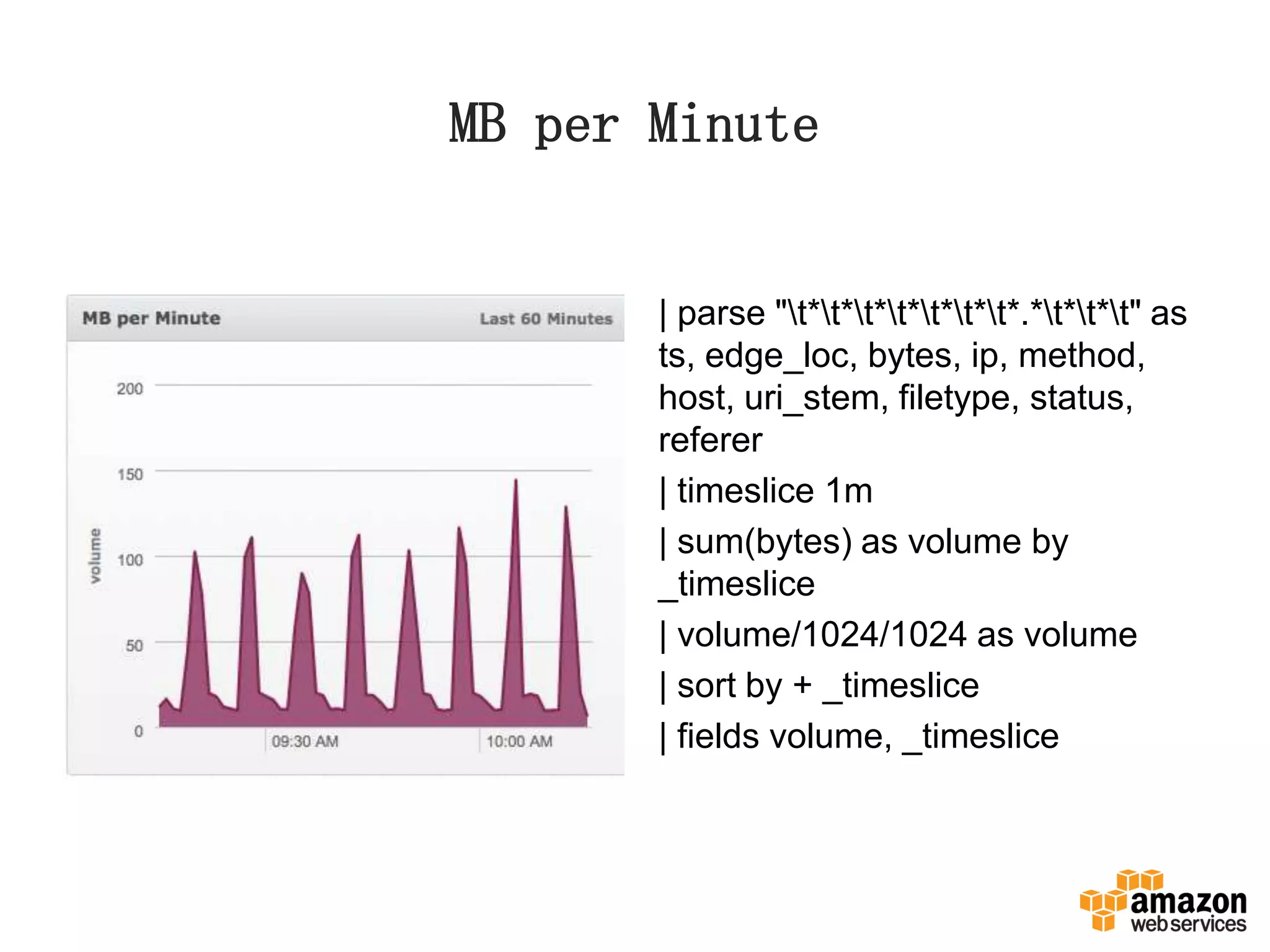

8. 9. 10. 11. 12. 13. 15. MB per Minute

| parse "t*t*t*t*t*t*t*.*t*t*t" as

ts, edge_loc, bytes, ip, method,

host, uri_stem, filetype, status,

referer

| timeslice 1m

| sum(bytes) as volume by

_timeslice

| volume/1024/1024 as volume

| sort by + _timeslice

| fields volume, _timeslice

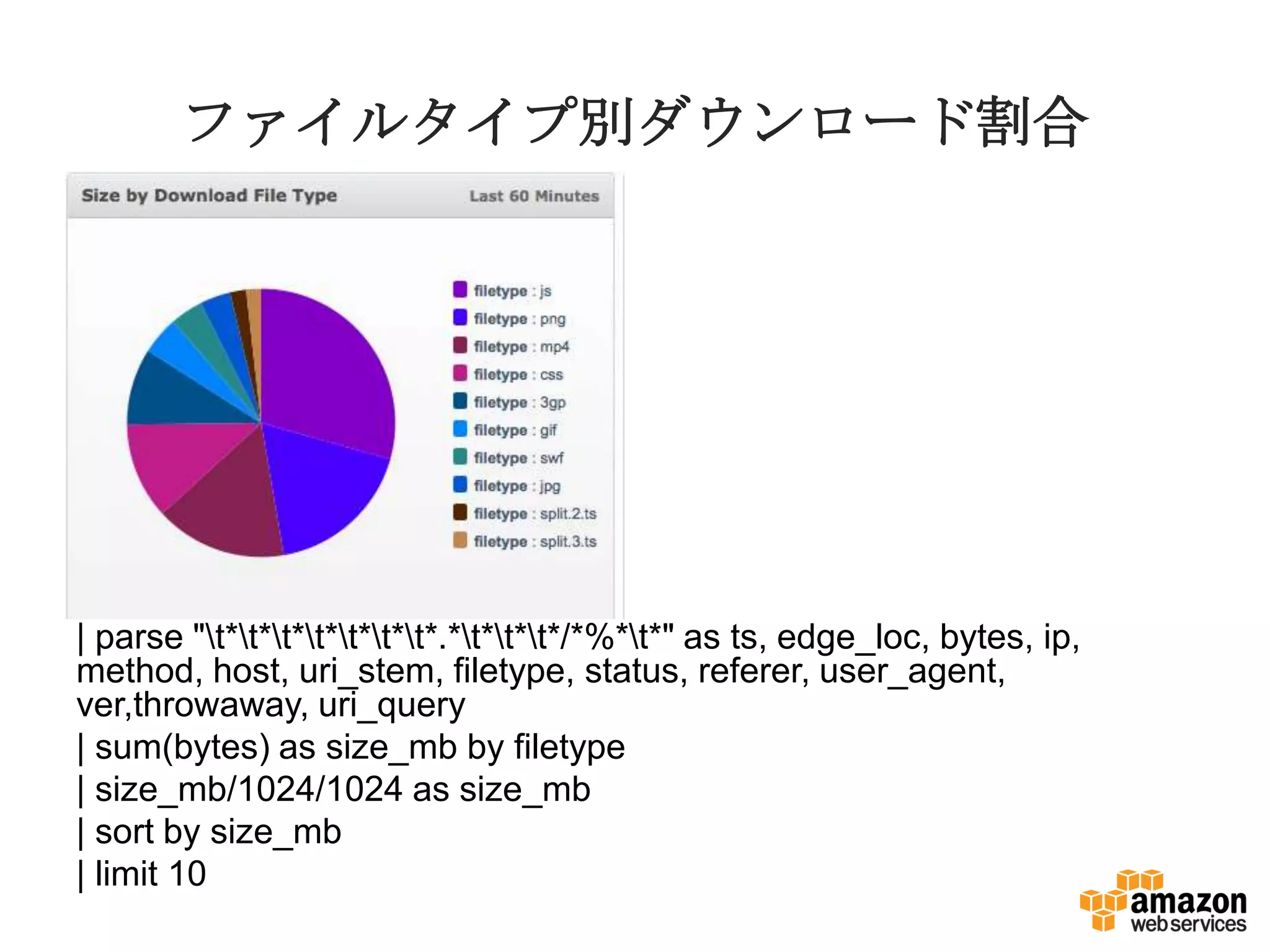

16. ファイルタイプ別ダウンロード割合

| parse "t*t*t*t*t*t*t*.*t*t*t*/*%*t*" as ts, edge_loc, bytes, ip,

method, host, uri_stem, filetype, status, referer, user_agent,

ver,throwaway, uri_query

| sum(bytes) as size_mb by filetype

| size_mb/1024/1024 as size_mb

| sort by size_mb

| limit 10

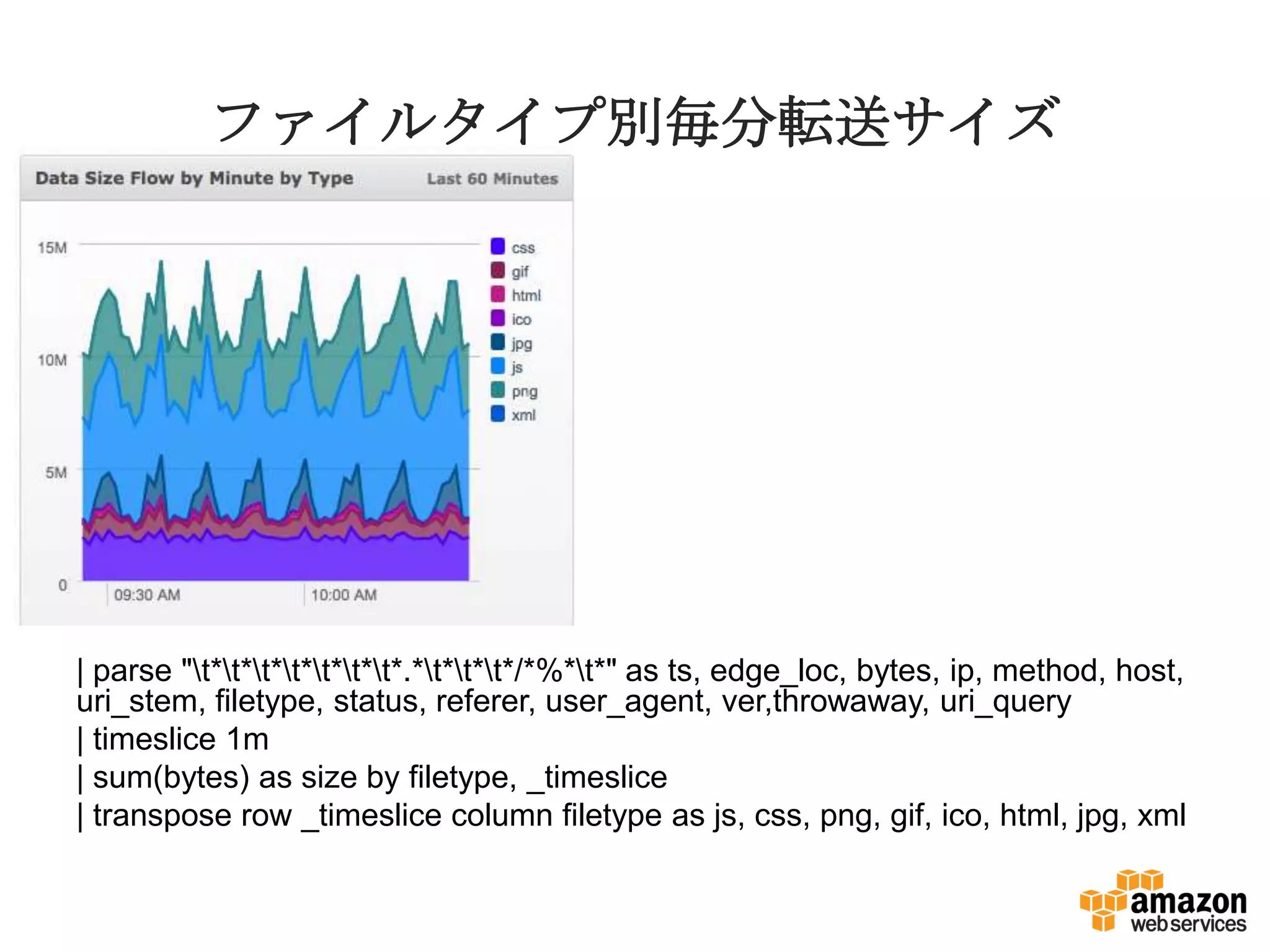

17. ファイルタイプ別毎分転送サイズ

| parse "t*t*t*t*t*t*t*.*t*t*t*/*%*t*" as ts, edge_loc, bytes, ip, method, host,

uri_stem, filetype, status, referer, user_agent, ver,throwaway, uri_query

| timeslice 1m

| sum(bytes) as size by filetype, _timeslice

| transpose row _timeslice column filetype as js, css, png, gif, ico, html, jpg, xml

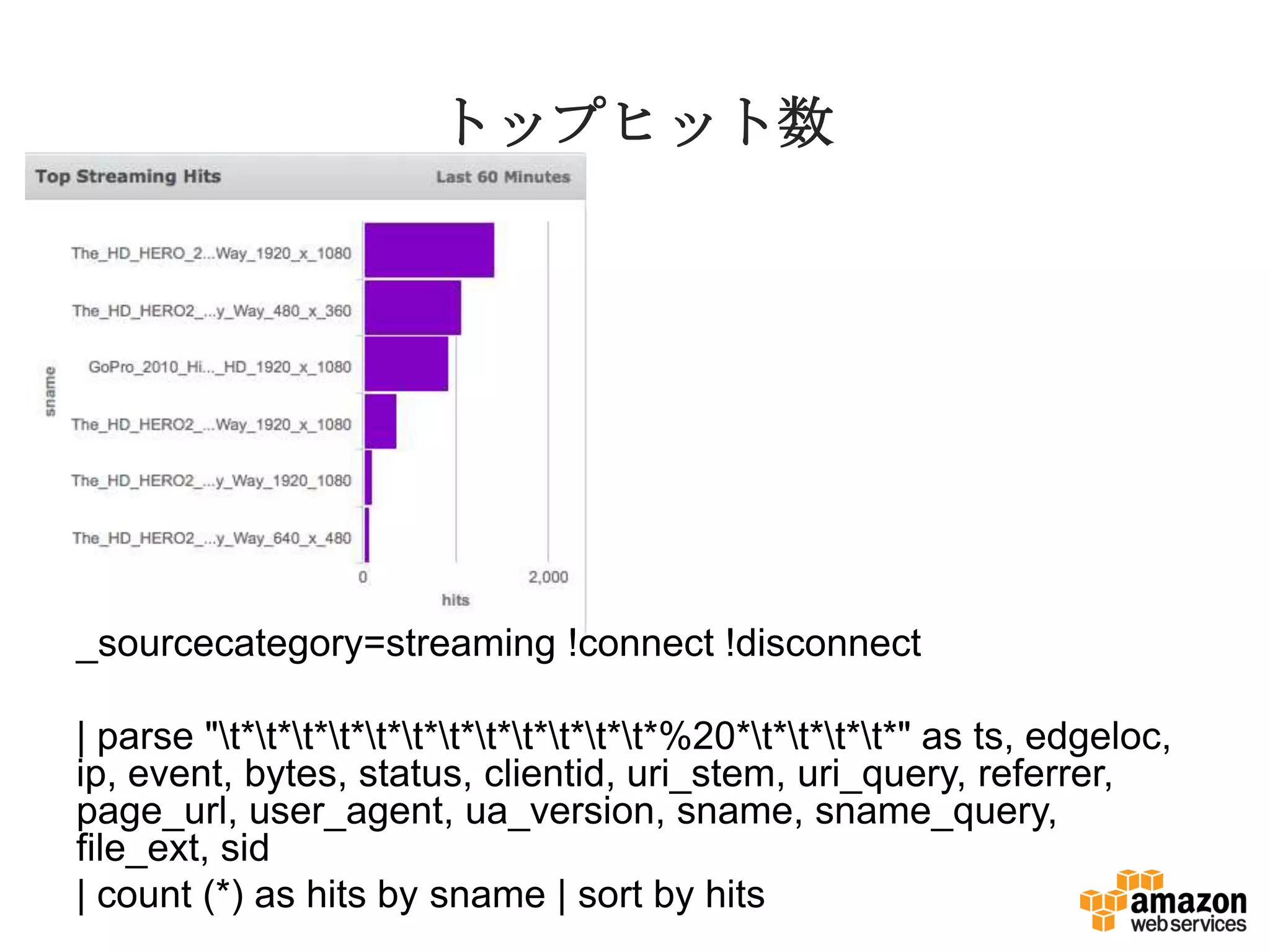

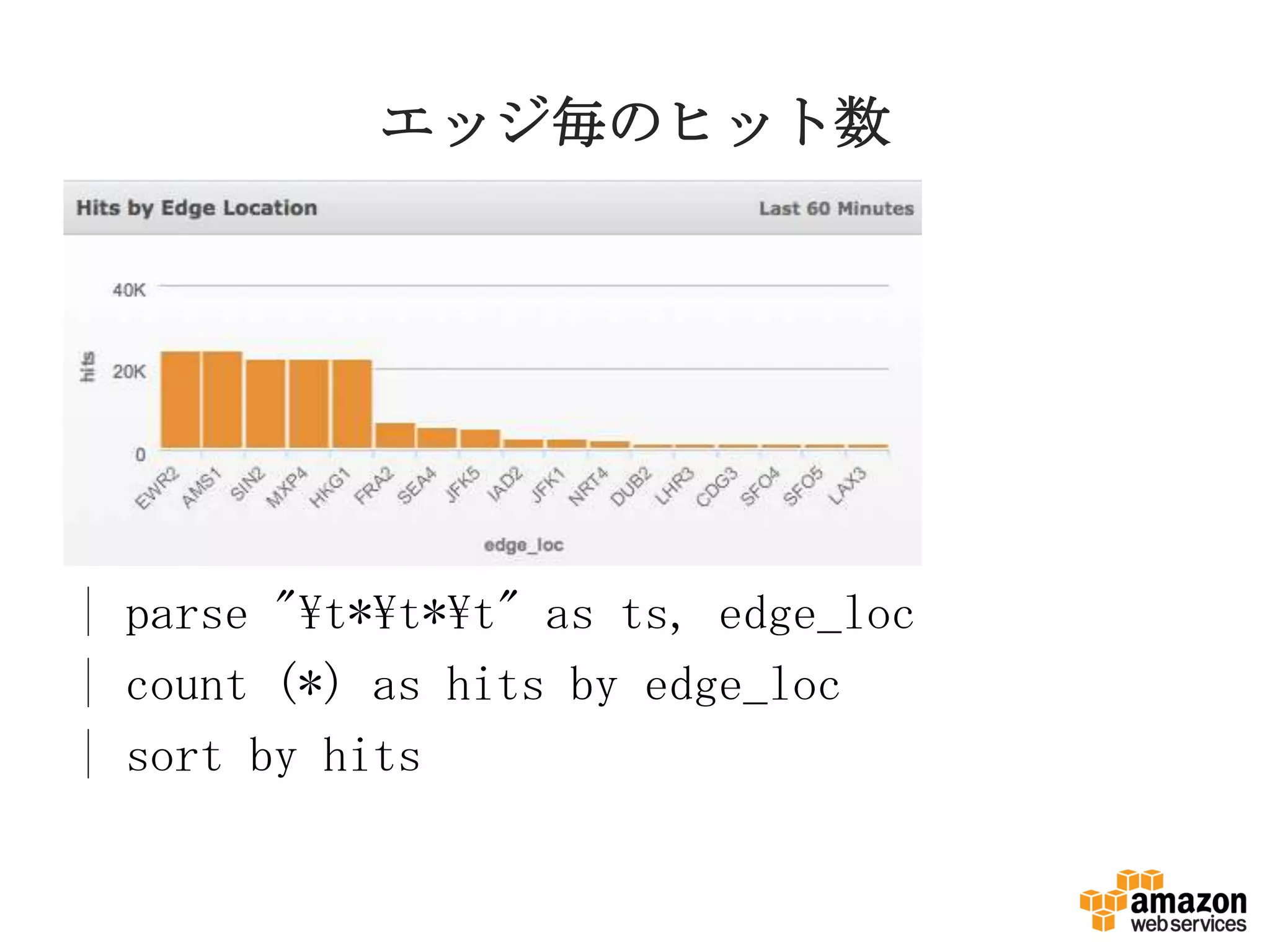

18. トップヒット数

_sourcecategory=streaming !connect !disconnect

| parse "t*t*t*t*t*t*t*t*t*t*t*t*%20*t*t*t*t*" as ts, edgeloc,

ip, event, bytes, status, clientid, uri_stem, uri_query, referrer,

page_url, user_agent, ua_version, sname, sname_query,

file_ext, sid

| count (*) as hits by sname | sort by hits

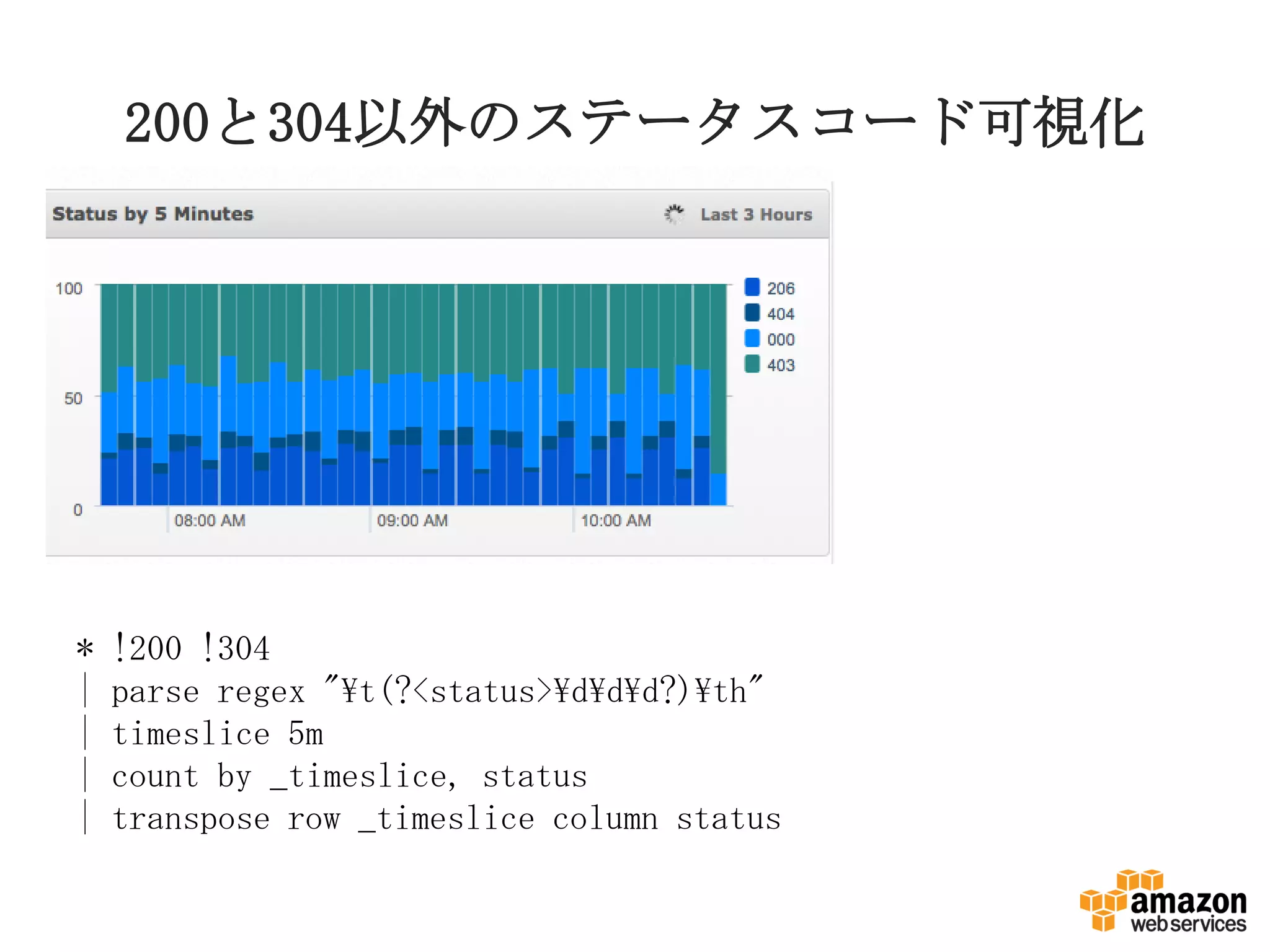

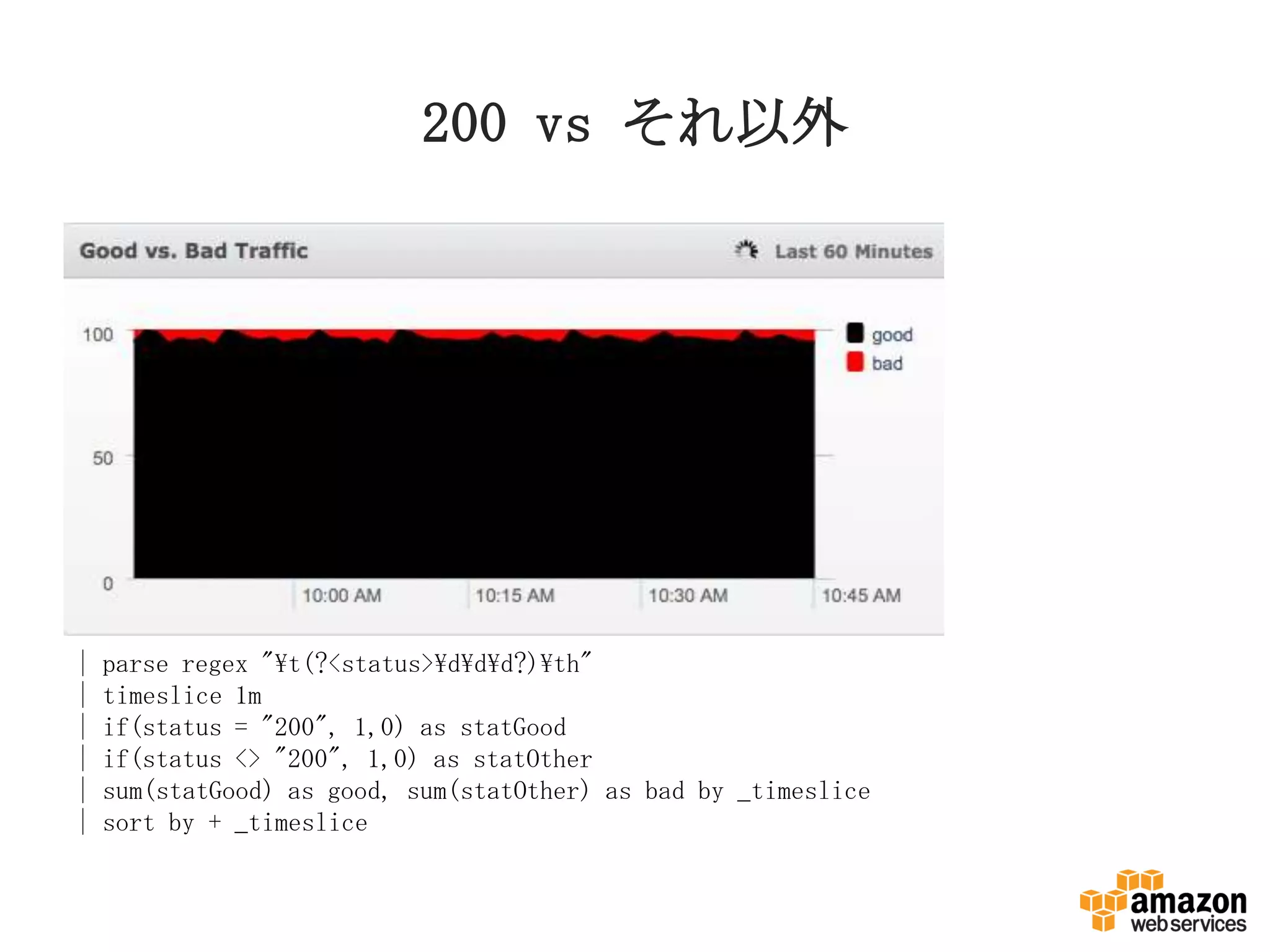

19. 20. 21. 200 vs それ以外

| parse regex "t(?<status>ddd?)th"

| timeslice 1m

| if(status = "200", 1,0) as statGood

| if(status <> "200", 1,0) as statOther

| sum(statGood) as good, sum(statOther) as bad by _timeslice

| sort by + _timeslice

22. 22

web server

web server

web server

EC2で生成 S3に集約 EMRで集計

FluentdS3Plugin

S3DistCp

hiveorstreaming

RDSに出力

/main?page=1

/main?page=2

/main?page=1

{“page”:”1”}

{“page”:”2”}

{“page”:”1”}

page1 t 2

page2 t 1

page | count

---------------

page1 | 2

page2 | 1

ログ収集、解析

をあきらめない

完成までは試行錯誤と場当たり処理の繰り返

し