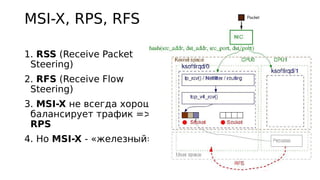

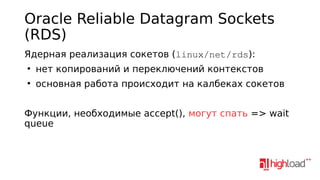

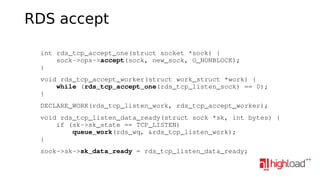

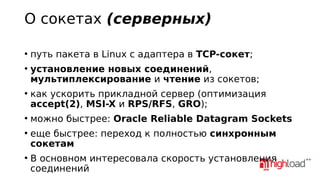

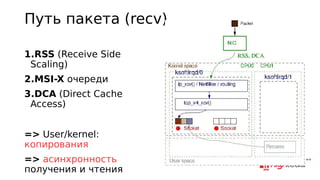

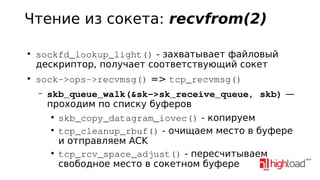

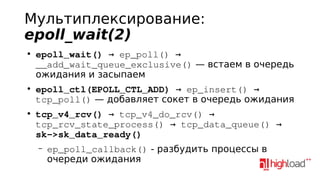

Документ рассматривает взаимодействие сокетов в Linux, включая установление соединений, мультиплексирование и оптимизацию производительности серверов. Обсуждаются различные технологии и методы, такие как RSS, MSI-X и реализация надёжных датаграммных сокетов Oracle. Также рассматриваются синхронные сокеты и их преимущества при работе с большим числом соединений.

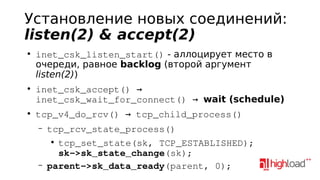

![Типовой сценарий

listen(listen_sd, 5);

epoll_ctl(wd, EPOLL_CTL_ADD, listen_sd, &ev);

while (1) {

n = epoll_wait(wd, ev, 64, 1);

for (int i = 0; i < n; ++i) {

if (ev[i].data.fd == listen_sd) {

new_sd = accept(listen_sd, NULL, NULL);

} else {

recv(ev[i].data.fd, msg, READ_SZ, 0);

}

}

}](https://image.slidesharecdn.com/5-131107072850-phpapp02/85/NatSys-Lab-4-320.jpg)

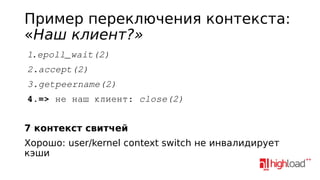

![Что если приходит сразу много

клиентов?

listen(listen_sd, 5);

epoll_ctl(wd, EPOLL_CTL_ADD, listen_sd, &ev);

while (1) {

n = epoll_wait(wd, ev, 64, 1);

for (int i = 0; i < n; ++i) {

if (ev[i].data.fd == listen_sd)

new_sd = accept(listen_sd, NULL, NULL);

}

}](https://image.slidesharecdn.com/5-131107072850-phpapp02/85/NatSys-Lab-10-320.jpg)

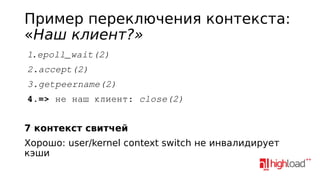

![Оптимизация accept(2)

BRECHT T., PARIAG D., GAMMO L. «accept()able strategies for improving web

server performance.»

listen(listen_sd, 1000);

fcntl(sd, F_SETFL, flags | O_NONBLOCK);

epoll_ctl(wd, EPOLL_CTL_ADD, listen_sd, &ev)

while (1) {

n = epoll_wait(wd, ev, 64, 1);

for (int i = 0; i < n; ++i) {

if (ev[i].data.fd == listen_sd)

do {

new_sd = accept(listen_sd, NULL, NULL);

} while (new_sd >= 0);

}

}](https://image.slidesharecdn.com/5-131107072850-phpapp02/85/NatSys-Lab-11-320.jpg)