More Related Content

PDF

PDF

PPTX

PDF

PDF

PPTX

PPTX

rstanで簡単にGLMMができるglmmstan()を作ってみた PDF

2012-1110「マルチレベルモデルのはなし」(censored) What's hot

PDF

PDF

PDF

StanとRでベイズ統計モデリング読書会 導入編(1章~3章) PDF

PDF

PDF

一般化線形モデル (GLM) & 一般化加法モデル(GAM) PDF

PPTX

PDF

PDF

PDF

PDF

PDF

PPTX

PDF

PDF

心理学者のためのJASP入門(操作編)[説明文をよんでください] PPTX

Rで因子分析 商用ソフトで実行できない因子分析のあれこれ PPTX

マルコフ連鎖モンテカルロ法 (2/3はベイズ推定の話) PDF

PDF

Viewers also liked

PDF

PDF

PPTX

PPTX

PDF

PPTX

PPTX

PDF

Similar to (実験心理学徒だけど)一般化線形混合モデルを使ってみた

PPTX

PDF

PDF

PDF

PDF

ICML2013読み会: Distributed training of Large-scale Logistic models PPTX

PDF

PDF

More from Takashi Yamane

PPTX

PPTX

DiagrammeRと仲良くなった話ーグラフィカルモデルのためのDiagrammeR速習ー PDF

PPTX

PPTX

PPTX

PPTX

PPT

PDF

(実験心理学徒だけど)一般化線形混合モデルを使ってみた

- 1.

- 2.

自己紹介

氏名 : 山根嵩史

所属 : 広島大学大学院 教育学研究科

教育人間科学専攻 学習心理学研究室

研究テーマ : メタ記憶,読解方略

R歴:5年程度

Mail : t.yamane1969@gmail.com

Twitter : @T_Yamane

最近ハマっていること:ねこあつめ(iPhoneアプリ)

- 3.

- 4.

- 5.

- 6.

- 7.

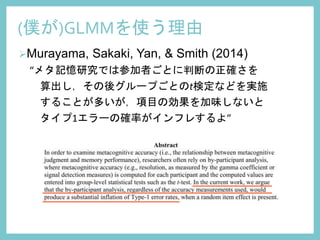

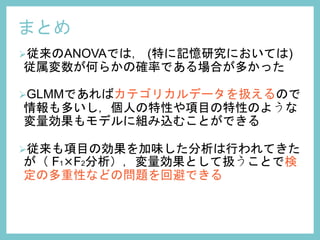

Murayama, Sakaki, Yan,& Smith (2014)

“メタ記憶研究では参加者ごとに判断の正確さを

算出し,その後グループごとのt検定などを実施

することが多いが,項目の効果を加味しないと

タイプ1エラーの確率がインフレするよ”

(僕が)GLMMを使う理由

- 8.

- 9.

- 10.

- 12.

- 13.

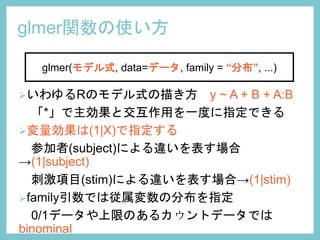

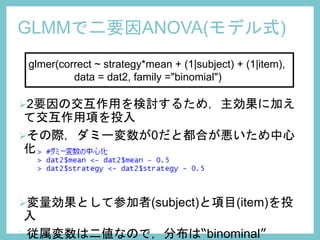

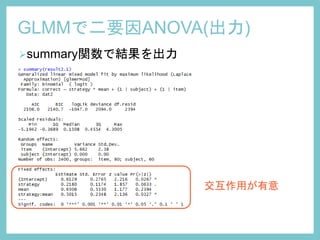

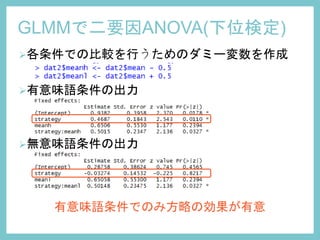

glmer関数の使い方

いわゆるRのモデル式の描き方 y ~A + B + A:B

「*」で主効果と交互作用を一度に指定できる

変量効果は(1|X)で指定する

参加者(subject)による違いを表す場合

→(1|subject)

刺激項目(stim)による違いを表す場合→(1|stim)

family引数では従属変数の分布を指定

0/1データや上限のあるカウントデータでは

binominal

glmer(モデル式, data=データ, family = “分布”, ...)

- 14.

- 15.

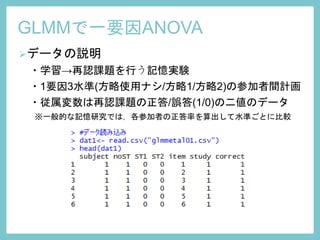

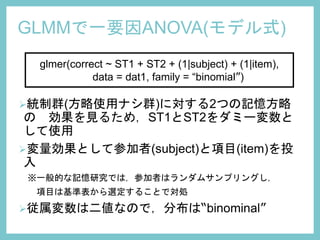

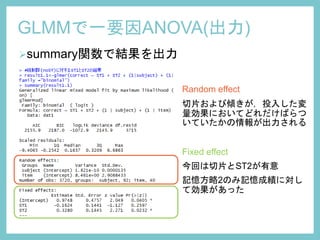

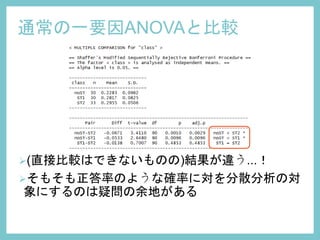

GLMMで一要因ANOVA(モデル式)

glmer(correct ~ ST1+ ST2 + (1|subject) + (1|item),

data = dat1, family = “binomial”)

統制群(方略使用ナシ群)に対する2つの記憶方略

の 効果を見るため,ST1とST2をダミー変数と

して使用

変量効果として参加者(subject)と項目(item)を投

入

※一般的な記憶研究では,参加者はランダムサンプリングし,

項目は基準表から選定することで対処

従属変数は二値なので,分布は“binominal”

- 16.

- 17.

- 18.

- 19.

- 20.

- 21.

- 22.

- 23.

- 24.

参考文献

・第2回日本社会心理学会春の方法論セミナー:GLMMが切り開く新たな統計

の世界

(http://www.socialpsychology.jp/sympo/seminar_150325.html)

・第7回DARM勉強会:混合モデルを使って反復測定分散分析をする

(https://sites.google.com/site/studygroup13csrm/activity)

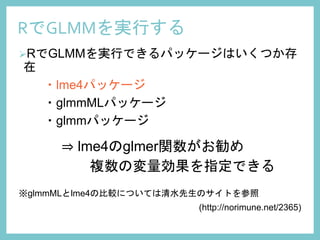

・Sunny side up!:GLMMをRで実行する方法

(http://norimune.net/2365)

・BatesDouglas, Maechler Martin, Bolker Ben, Walker Steven, Bojesen

Christensen Rune, Singmann Henrik, B. D. (2015). Package “lme4.”

・久保拓弥(著) (2012). データ解析のための統計モデリング入門―一般化線形

モデ

ル・階層ベイズモデル・MCMC 岩波書店

・Murayama, K., Sakaki, M., Yan, V. ., & Smith, G. (n.d.). Type-1 error inflation

in the traditional by-participant analysis to metamemory accuracy :

A generalized mixed-effects model perspective, Journal of Experimental

Psychology: Learning, Memory, & Cognition, 24

参考サイト