More Related Content

PDF

PDF

SSII2022 [OS3-02] Federated Learningの基礎と応用 PDF

PDF

SSII2021 [TS3] 機械学習のアノテーションにおける データ収集 〜 精度向上のための仕組み・倫理や社会性バイアス 〜 PPTX

PDF

PDF

SSII2022 [SS2] 少ないデータやラベルを効率的に活用する機械学習技術 〜 足りない情報をどのように補うか?〜 PDF

What's hot

PDF

レコメンドアルゴリズムの基本と周辺知識と実装方法 PDF

PPTX

[DL輪読会]BERT: Pre-training of Deep Bidirectional Transformers for Language Und... PDF

いろんなバンディットアルゴリズムを理解しよう PDF

SSII2022 [TS1] Transformerの最前線〜 畳込みニューラルネットワークの先へ 〜 PDF

PPTX

[DL輪読会]Dense Captioning分野のまとめ PDF

PDF

PDF

JDLA主催「CVPR2023技術報告会」発表資料 PPTX

近年のHierarchical Vision Transformer PDF

PDF

PPTX

【DL輪読会】時系列予測 Transfomers の精度向上手法 PDF

PPTX

【DL輪読会】Flamingo: a Visual Language Model for Few-Shot Learning 画像×言語の大規模基盤モ... PDF

PPTX

【LT資料】 Neural Network 素人なんだけど何とかご機嫌取りをしたい PPTX

Swin Transformer (ICCV'21 Best Paper) を完璧に理解する資料 PPTX

Similar to 自然言語処理 Word2vec

PDF

PDF

PPTX

【論文紹介】Distributed Representations of Sentences and Documents PPTX

PPTX

PPTX

PPTX

PPTX

Retrofitting Word Vectors to Semantic Lexicons PDF

More from naoto moriyama

PDF

論文紹介: Differentiable reasoning over a virtual knowledge base PPTX

PPTX

PPTX

PPTX

Differentiable neural conputers PPTX

PPTX

Recently uploaded

PPTX

PDF

100年後の知財業界-生成AIスライドアドリブプレゼン イーパテントYouTube配信 PDF

第21回 Gen AI 勉強会「NotebookLMで60ページ超の スライドを作成してみた」 PDF

2025→2026宙畑ゆく年くる年レポート_100社を超える企業アンケート総まとめ!!_企業まとめ_1229_3版 PDF

さくらインターネットの今 法林リージョン:さくらのAIとか GPUとかイベントとか 〜2026年もバク進します!〜 PDF

Starlink Direct-to-Cell (D2C) 技術の概要と将来の展望 PDF

PDF

Reiwa 7 IT Strategist Afternoon I Question-1 Ansoff's Growth Vector PDF

Reiwa 7 IT Strategist Afternoon I Question-1 3C Analysis 自然言語処理 Word2vec

- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

Bug-Of-Words(BOW)

※ここからベクトル(線形代数)の話が入ります

① 予め、処理する単語の総ユニーク数を算出

② ①の数字を次元としたゼロベクトル配列を用意

③各単語の出現順に、その単語が位置が1となるベクトルを付与

パソコン

インターネット

プログラミング

エンジニア

UNIX

CPU

②6次元のゼロベクトル[0, 0, 0, 0, 0, 0]

①6次元

⇒ [1, 0, 0, 0, 0, 0]

⇒ [0, 1, 0, 0, 0, 0]

⇒ [0, 0, 1, 0, 0, 0]

⇒ [0, 0, 0, 1, 0, 0]

⇒ [0, 0, 0, 0, 1, 0]

⇒ [0, 0, 0, 0, 0, 1]

※これの何がうれしいか

• 各ベクトルの値が違うにもかかわらず、

• すべて互いの距離が等しい(ノルム距離)!!

• つまり、独自性を保ちつつ、無駄な相対関係を

持たない

• 機械学習で自然言語以外でもよく使われる

③

7

例)

- 8.

- 9.

- 10.

- 11.

- 12.

- 13.

- 14.

- 15.

- 16.

![Bug-Of-Words(BOW)

※ここからベクトル(線形代数)の話が入ります

① 予め、処理する単語の総ユニーク数を算出

② ①の数字を次元としたゼロベクトル配列を用意

③ 各単語の出現順に、その単語が位置が1となるベクトルを付与

パソコン

インターネット

プログラミング

エンジニア

UNIX

CPU

②6次元のゼロベクトル[0, 0, 0, 0, 0, 0]

①6次元

⇒ [1, 0, 0, 0, 0, 0]

⇒ [0, 1, 0, 0, 0, 0]

⇒ [0, 0, 1, 0, 0, 0]

⇒ [0, 0, 0, 1, 0, 0]

⇒ [0, 0, 0, 0, 1, 0]

⇒ [0, 0, 0, 0, 0, 1]

※これの何がうれしいか

• 各ベクトルの値が違うにもかかわらず、

• すべて互いの距離が等しい(ノルム距離)!!

• つまり、独自性を保ちつつ、無駄な相対関係を

持たない

• 機械学習で自然言語以外でもよく使われる

③

7

例)](https://image.slidesharecdn.com/word2vec-160904040458/85/Word2vec-7-320.jpg)

![次にすることは?

8

• 前述のBOWを日本語に対して行うと、日本語の単語が約25万(広辞苑)の

ため各単語がそれぞれ25万次元のベクトル配列となる

⇒意味を持たない

• 一方、BOWはのベクトルは、1つのが[1]でそれ以外はすべて[0]

⇒これを圧縮したい

⇒⇒でも、中途半端な方法では、計算を妨げるベクトルになってしまう

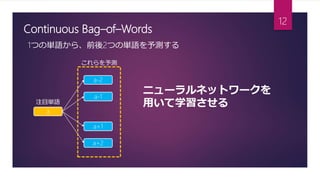

• 以降、continuous Bog-of-Wordsと呼ばれるアルゴリズムを用いて、

意味のある、かつ短いベクトルにする方法を考える](https://image.slidesharecdn.com/word2vec-160904040458/85/Word2vec-8-320.jpg)