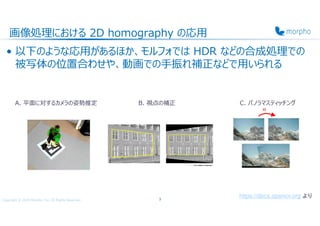

モルフォでは、学術論文の輪講を行う「ジャーナルクラブ」という有志による活動があります。今回は、このジャーナルクラブで発表した内容をご紹介いたします。画像処理では、複数の画像を入力としたときに「それらを映したカメラの動き」を推定する問題がさまざまな用途で重要になります。ある幾何的性質を満たした画像間でカメラの動きを記述するモデルはありますが、実際に我々が推定に用いる画像は、そのようなきれいな性質を満たしているとは限りません。難しい設定の最たる例が「動いている被写体を動いているカメラで映す」場合です。今回ご紹介する論文は、今年の CVPR で発表された、動被写体が映っているシーンでもきれいにカメラの動きを推定する深層学習手法について論じたものです。

この続きはモルフォのTech Blogをご覧ください→ https://techblog.morphoinc.com/

Morpho, Inc.

Website: https://www.morphoinc.com/

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

対応点検出

• SIFT 特徴量([2], 2004)

– 拡⼤縮小・回転を伴う画像間でも局所的に保存される特徴量

– 主要な4ステップ

1. 特徴点候補検出

2. 特徴点サブピクセル配置

3. 方向決定

4. 特徴ベクトル構成

– 2020 年まで一部のアルゴリズムが特許で

保護されていたが現在は使用可能

• SIFT により検出した特徴点を

画像間で対応させる

7

https://docs.opencv.org より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-8-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

アラインメント誤差最小化問題

• RANSAC([3], 1981)

– 外れ値を含むようなデータを使って線形モデル

を fit させる場合に用いられる

1. モデルを決定する最小の数の点を選択し、そ

れらでモデルを決定

ℎ 0

で ℎ の⾃由度が 8 なので 4 対応点選択

2. 求めたモデルに沿うデータを inlier, 沿わない

データを outlier とする

3. 1,2 を適当に繰り返す

4. 最⼤個数の inlier を使ってモデルを決定

8

https://scikit-learn.org より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-9-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

アラインメント誤差最小化問題

• MAGSAC([4], 2019)

– RANSAC の inlier/outlier 判定に用いる閾値を指定しない手法

– 理論的にはパラメタで周辺化するアイデア

!, #, $% & !, #, $

' !, #, $ ∑ 1

)* +,,- +,.,/

0/2.*

, +,.,/

3

' 4 !, $ 5 !, #, $ 6 # 7#

.89:

5 ln < !, $ #%7#

– 処理が重いので、実用的には RANSAC の後処理として近似的に実装可能9

$:入力データ点の集合

!:モデルパラメタ

#:入力データ点のノイズ強度(inlier 判定するための残差の閾値)

関数:モデル選択を行う際に用いる指標(値が大きい方を選択)

& 関数:inlier データ点の集合

< 関数:入力データ点の集合の尤度(背後に確率モデルを過程)](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-10-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

MHN (提案手法)の DNN アーキテクチャ

• ⼊⼒︓128x128 のグレースケール画像 2 枚 > >

• 出⼒︓摂動させた 4 隅の座標の差分 >

⋅ ⋅ ︓ ⋅

> をそれぞれ ½ , ¼ にスケールした画像

• Base network( Net0, Net1, Net2 )は VGG のような感じ

– Convolution︓3x3, batch normalization, ReLU

13 [1] 図 3,4 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-14-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

多重解像度

• 元画像を縮小した画像で homography を求め、それをもとに元画像

の homography を求める

– 画像間の全体的な⼤きい動きをとらえやすい

– 通常縮小を多重に⾏って coarse to fine で homography を求める

– 従来手法および deep learning 系の手法で取り⼊れられている

• Deep learning 系での例︓CLKN([5], 2017)

14

Lucas-Kanade Layer

Reference imageTemplate image

[5] 図 1,2 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-15-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

MHN の DNN アーキテクチャ

• 多重解像度(Coarse ⋅ to Fine ⋅

> )

• Cascade 処理

– ½ 解像度で求めた ?B=C

と元の解像度で求めた ?B=

から ?=

を求める処理

– ?=

?B=

D@

?B=C

D

• D, D@

はそれぞれ座標を ½ , 2 倍にスケールする⾏列

• >

?B>

D@

?B D@

?B DD >

が期待される

15 [1] 図 3,4 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-16-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

Dynamic Scene 検出

• 動被写体がある場合のロバスト性をあげたい

• 動被写体のマスク(dynamics mask)を同時に推定するようなモデ

ルにし、マルチタスク学習を⾏う

– 主タスク︓homography 探索

– 副タスク︓dynamics mask 推定

• Dynamics mask の ground truth は optical flow を

用いて計算

– Optical flow は PWC-Net([6], 2018)を用いて推定

16](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-17-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

MHN の DNN アーキテクチャ(マルチタスク版)

• ⼊⼒︓128x128 のグレースケール画像 2 枚 > >

• 出⼒︓ > と dynamics mask > >

• Base network は VGG に decoder を足して(U-net のような感

じ)dynamics mask を出⼒する

– さらに差分を学習するように skip connection を追加

– 最粗の E , E % の与え方は書かれていない17 [1] 図 5 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-18-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

実験結果

• 動画内で 10 フレーム離

れた画像間で求めた

homography を適用し

アラインした結果の例

– 提案手法では背景でゴース

ト無し・前景でゴースト有り

、となっている

• 背景の homography を

正しく推定できている

– Dynamics mask を正し

く推定し、前景を外れ値とし

ているから

20 [1] 図 11 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-21-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

実験結果

• 視差画像でのアラインメントの

結果の例

– 視差があるので depth が小さ

いほど optical flow が⼤きい

元画像

– アラインの結果、背景の optical

flow が低減した

– やはり dynamics mask が正

しく推定され、前景を外れ値とし

ているから

– 学習データにはもちろん視差画

像は含まれていないが、ある程

度推定できた21

[1] 図 12 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-22-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

精度⽐較

• Static scene での精度

– MS-COCO での⽴ち上がり(⾼精度域)は CLKN が最も⾼い

– CLKN と提案手法(MHN)は⾼いが、必ずしも deep learning 系が非

deep learning 系より⾼いという訳ではない

– MS-COCO / VidSets での結果はほぼ変化なし

22

Static video

clip の中で完全

に static なもの

提案手法

[1] 図 6 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-23-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

精度⽐較

• Dynamic scene での精度

– 全体的に精度は低下した

– MHN の学習セットを static → dynamic にすると精度向上

– 同じ dynamic な学習セットでも MHN → MHNm にしたことで精度向上

– MHN を MS-COCO と VidSets のどちらで学習しても相違なし

23

Static video clip の中

で dynamics を含むもの

CLKN は︖

→ コードが非公開なので新し

データセットで学習できない

[1] 図 7 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-24-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

精度⽐較

• 各 deep learning 系手法の学習セットと dynamic scene での精

度との関係

– データセットを変えただけで、ほとんどのモデルで向上した

– データセット単体での貢献がある 24 [1] 図 8 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-25-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

精度⽐較

• 多重解像度のレイヤー数と精度の関係

– 図は MHN on MS-COCO でレイヤー数を 1〜4 と変化させたもの

– 最粗画像が小さすぎると homography 探索が不安定になるようだ

• CLKN の著者らの報告と一致

25 [1] 図 10 より](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-26-320.jpg)

![Copyright © 2020 Morpho, Inc. All Rights Reserved.

参考⽂献

[1] 主論⽂︓Le, Hoang, et al. "Deep Homography Estimation for Dynamic Scenes."

Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.

2020.

[2] SIFT︓Lowe, David G. "Distinctive image features from scale-invariant

keypoints." International journal of computer vision 60.2 (2004): 91-110.

[3] RANSAC︓Fischler, Martin A., and Robert C. Bolles. "Random sample consensus: a

paradigm for model fitting with applications to image analysis and automated

cartography." Communications of the ACM 24.6 (1981): 381-395.

[4] MAGSAC︓Barath, Daniel, Jiri Matas, and Jana Noskova. "Magsac: marginalizing sample

consensus." Proceedings of the IEEE Conference on Computer Vision and Pattern

Recognition. 2019.

[5] CLKN︓Chang, Che-Han, Chun-Nan Chou, and Edward Y. Chang. "Clkn: Cascaded lucas-

kanade networks for image alignment." Proceedings of the IEEE Conference on

Computer Vision and Pattern Recognition. 2017.

[6] PWC-Net︓Sun, Deqing, et al. "Pwc-net: Cnns for optical flow using pyramid, warping,

and cost volume." Proceedings of the IEEE conference on computer vision and pattern

recognition. 2018.

28](https://image.slidesharecdn.com/deephomographyestimationfor-201117015546/85/slide-29-320.jpg)