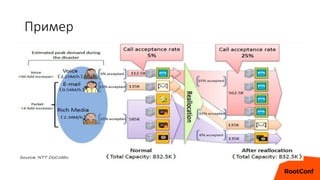

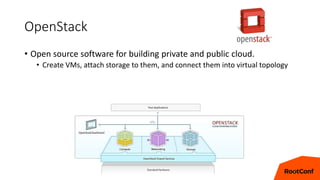

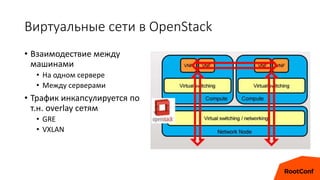

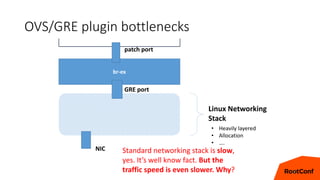

Документ обсуждает виртуализированные сетевые сервисы и их производительность в серверных окружениях, упоминая технологии, такие как DPDK и Open vSwitch. Рассматриваются проблемы сетевого взаимодействия в виртуальном окружении, а также предлагаются решения для повышения эффективности. Обсуждаются преимущества виртуализации сетевых функций, включая снижение затрат и упрощение развертывания сервисов.

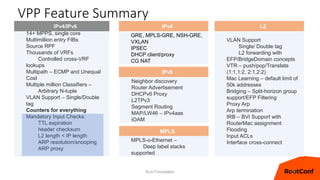

![VPP technology in a nutshell

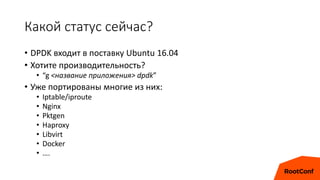

• VPP data plane throughput not impacted by large FIB size

• OVSDPDK data plane throughput heavily impacted by FIB size

• VPP and OVSDPDK tested on Haswell x86 platform with E5-2698v3

2x16C 2.3GHz (Ubuntu 14.04 trusty)

OVSDPDK

VPP

0

5

10

15

20

2 MACs

2k MACs

20k MACs

NDR rates for 2p10GE, 1 core, L2 NIC-to-NIC

[IMIX Gbps]

OVSDPDK

VPP

0.0

20.0

40.0

60.0

80.0

100.0

120.0

12 routes

1k routes 100k

routes

500k

routes

1M

routes

2M

routes

NDR rates for 12 port 10GE, 12 cores, IPv4

[IMIX Gbps]](https://image.slidesharecdn.com/linerate-160607213941/85/line-rate-19-320.jpg)