More Related Content

PDF

計算機アーキテクチャを考慮した高能率画像処理プログラミング PDF

続・PFN のオンプレML基盤の取り組み / オンプレML基盤 on Kubernetes 〜PFN、ヤフー〜 #2 PDF

Statistical Semantic入門 ~分布仮説からword2vecまで~ PDF

PDF

PFN のオンプレML基盤の取り組み / オンプレML基盤 on Kubernetes 〜PFN、ヤフー〜 PDF

KubeCon + CloudNativeCon Europe 2022 Recap / Kubernetes Meetup Tokyo #51 / #k... PDF

PDF

What's hot

PDF

Topology Managerについて / Kubernetes Meetup Tokyo 50 PDF

TensorRT Inference Serverではじめる、 高性能な推論サーバ構築 PDF

CDNのトラフィックエンジニアリング:CDNの現状とSDNの可能性 PDF

MRU : Monobit Reliable UDP ~5G世代のモバイルゲームに最適な通信プロトコルを目指して~ PPTX

YJTC18 A-1 データセンタネットワークの取り組み PDF

PPTX

Ponanzaにおける強化学習とディープラーニングの応用 PDF

[Track2-2] 最新のNVIDIA AmpereアーキテクチャによるNVIDIA A100 TensorコアGPUの特長とその性能を引き出す方法 PDF

CyberAgent における OSS の CI/CD 基盤開発 myshoes #CICD2021 PDF

Tensorflow Liteの量子化アーキテクチャ PDF

PDF

AbemaTVの動画配信を支えるサーバーサイドシステム PDF

PPTX

PDF

wakamonog6 インターネットの裏側の仕組み PDF

ネットワークOS野郎 ~ インフラ野郎Night 20160414 PPTX

PDF

PPTX

PPTX

Similar to GPUサーバーたくさん使うのいいけど置く場所とかどうするの?的なお話

PDF

GPU Container as a Service を実現するための最新OSS徹底比較 PDF

PPTX

PDF

GPU Container as a Serviceを実現するための最新OSS徹底比較 - OpenStack最新情報セミナー 2017年7月 PDF

[db analytics showcase Sapporo 2017] B14: GPU コンピューティング最前線 by エヌビディア 佐々木邦暢 PDF

PDF

第162回情報処理学会ハイパフォーマンスコンピューティング研究発表会 PPTX

【たぶん日本初導入!】Azure Stack Hub with GPUの性能と機能紹介 PDF

PDF

PDF

PDF

PDF

20171122 altair converge2017publish PDF

Singularity Containers for Enterprise Use PPTX

2016 06-30-deep-learning-archi PDF

PDF

NVIDIA GRID が実現する GPU 仮想化テクノロジー PDF

PDF

PDF

【A-1】AIを支えるGPUコンピューティングの今 More from Deep Learning Lab(ディープラーニング・ラボ)

PDF

Edge AI ソリューションを支える Azure IoT サービス PDF

DLLAB Healthcare Day 2021 Event Report PPTX

ICTを用いた健康なまちづくりの 取り組みとAI活用への期待 PDF

PDF

Intel AI in Healthcare 各国事例からみるAIとの向き合い方 PDF

PDF

PDF

AIによる細胞診支援技術の紹介と、AI人材が考える医療バイオ領域における参入障壁の乗り越え方 PDF

PDF

PDF

PDF

Azure ML 強化学習を用いた最新アルゴリズムの活用手法 PDF

Jetson x Azure ハンズオン DeepStream With Azure IoT 事前準備 PDF

Jetson x Azure ハンズオン DeepStream With Azure IoT PDF

Jetson x Azure ハンズオン DeepStream Azure IoT PDF

PDF

[Track 4-6] ディープラーニングxものづくりが日本を強くする ~高専DCONの挑戦~ PDF

[Track3-2] AI活用人材の社内育成に関する取り組みについて ~ダイキン情報技術大学~ PDF

[Track1-1] AIの売上予測を発注システムに組み込んだリンガーハットのデータ活用戦略 PDF

[Track1-2] ディープラーニングを用いたワインブドウの収穫量予測 Recently uploaded

PDF

Machine Tests Benchmark Suite. Explain github.com/alexziskind1/machine_tests #2 PDF

エンジニアが選ぶべきAIエディタ & Antigravity 活用例@ウェビナー「触ってみてどうだった?Google Antigravity 既存IDEと... PDF

流行りに乗っかるClaris FileMaker 〜AI関連機能の紹介〜 by 合同会社イボルブ PDF

Machine Tests Benchmark Suite. Explain github.com/alexziskind1/machine_tests #1 PPTX

楽々ナレッジベース「楽ナレ」3種比較 - Dify / AWS S3 Vector / Google File Search Tool PDF

20251210_MultiDevinForEnterprise on Devin 1st Anniv Meetup GPUサーバーたくさん使うのいいけど置く場所とかどうするの?的なお話

- 1.

Copyright © NTTCommunications Corporation. All rights reserved.

ntt.com

Transform your business, transcend expectations with our technologically advanced solutions.

GPUサーバたくさん使うのいいけど

置場所とかどうするの︖的なお話

NTTコミュニケーションズ株式会社 深⼭健司

- 2.

Copyright © NTTCommunications Corporation. All rights reserved.

About Me

深⼭ 健司(みやま けんじ)

NTTコミュニケーションズ株式会社

クラウドサービス部

HPC向けPrivate Cloud 企画開発担当

略歴

学⽣時代 : ⾃然⾔語処理(固有表現抽出とか)

2015 NTTCom ⼊社

2018 クラウドサービス部に異動 今に⾄る

趣味

燻製始めてみました

ベーコン->

- 3.

Copyright © NTTCommunications Corporation. All rights reserved.

2

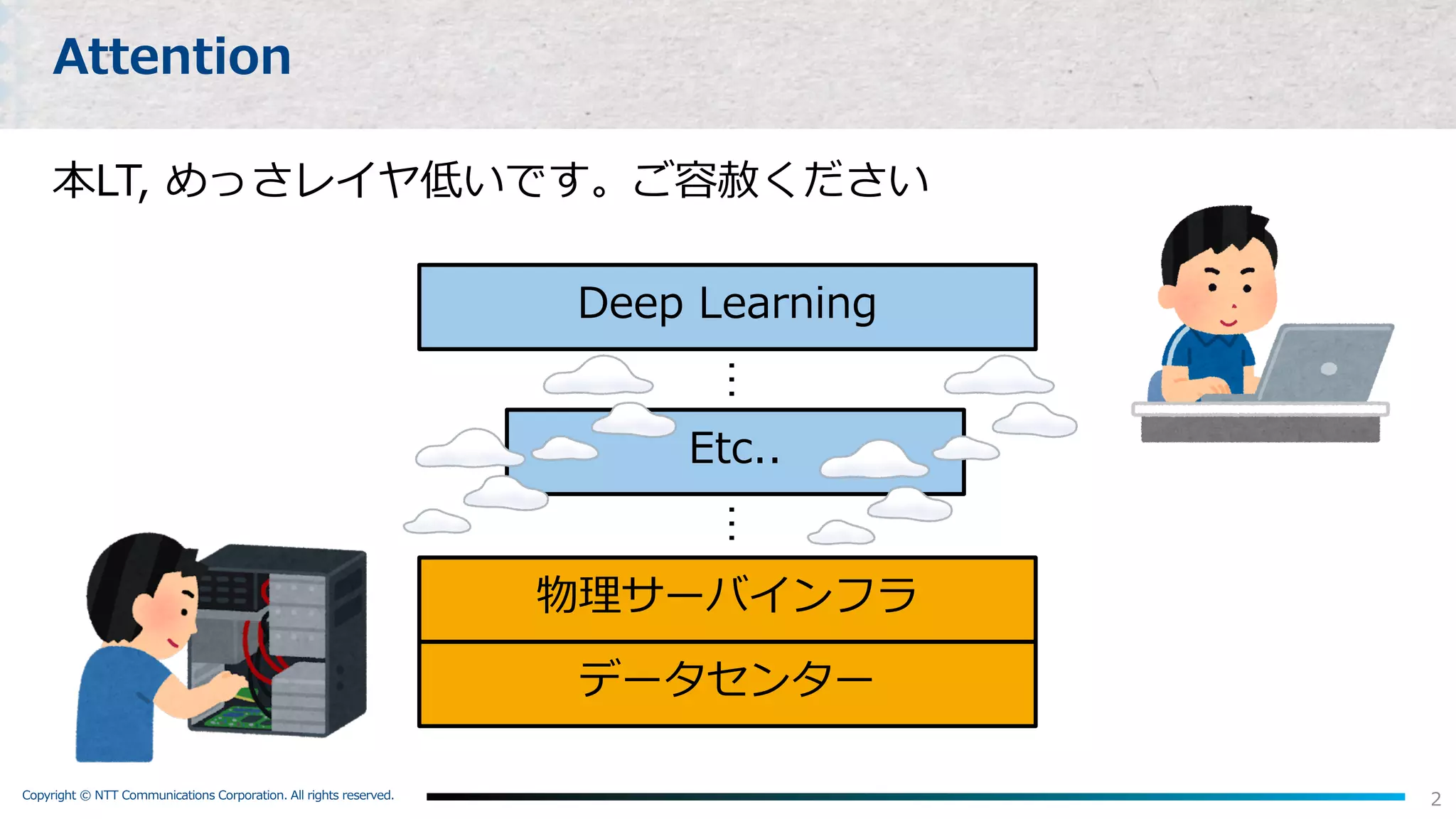

Attention

本LT, めっさレイヤ低いです。ご容赦ください

物理サーバインフラ

データセンター

Etc..

Deep Learning

……

- 4.

Copyright © NTTCommunications Corporation. All rights reserved.

3

Agenda

1. Deep LearningとComputing Power

2. 物理インフラ運⽤してみてわかったGPUサーバのツラミ

3. 今後の取組み

1. GPUを更にしっかり冷やすために

2. もっと⼿軽に⼤規模GPU環境をTryしてもらうために

4. Summary

(もとい、NTT⽬線での “DeepLearningの社会実装を拒むもの”)

- 5.

- 6.

Copyright © NTTCommunications Corporation. All rights reserved.

5

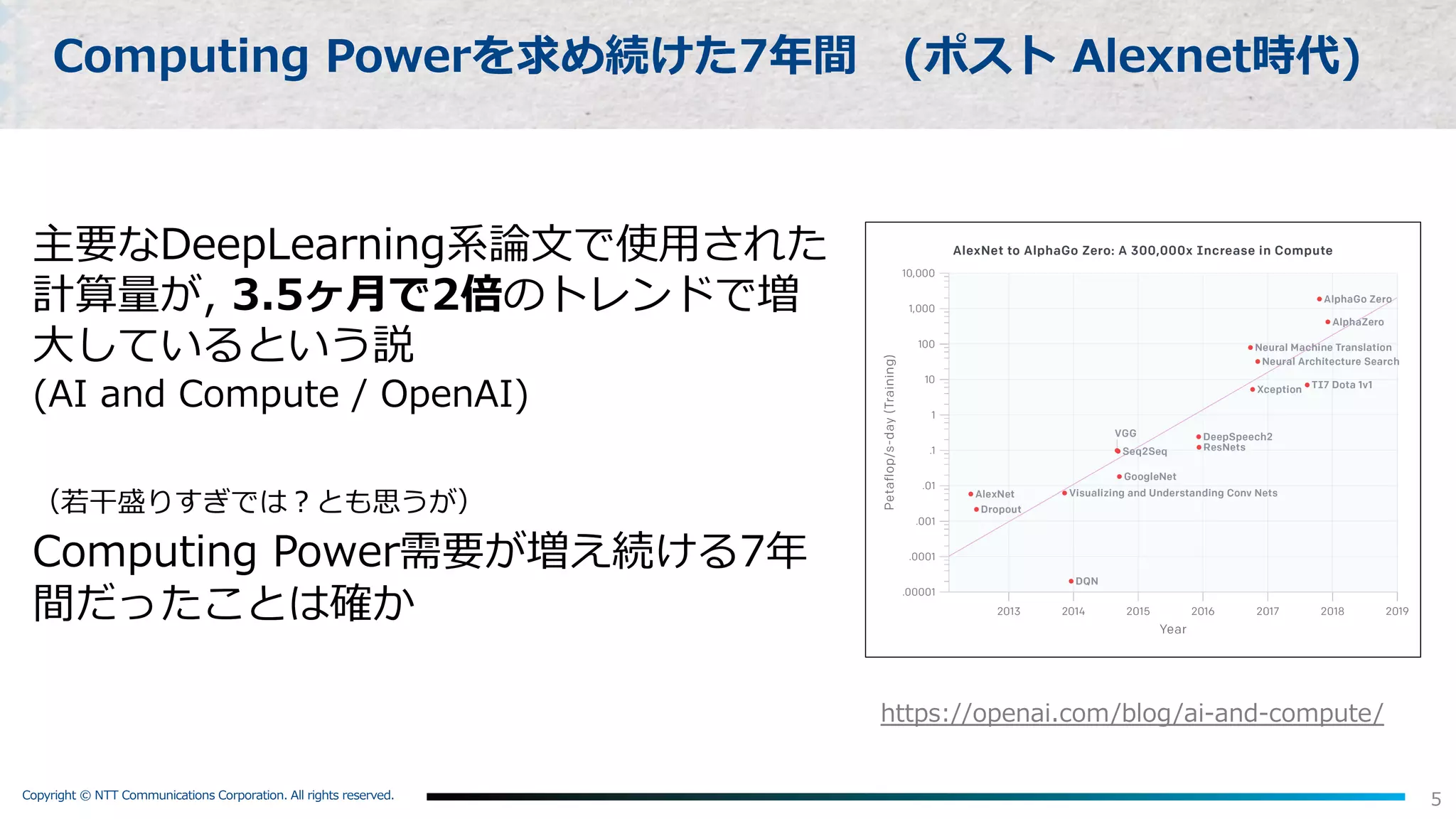

Computing Powerを求め続けた7年間 (ポスト Alexnet時代)

主要なDeepLearning系論⽂で使⽤された

計算量が, 3.5ヶ⽉で2倍のトレンドで増

⼤しているという説

(AI and Compute / OpenAI)

(若⼲盛りすぎでは︖とも思うが)

Computing Power需要が増え続ける7年

間だったことは確か

https://openai.com/blog/ai-and-compute/

- 7.

Copyright © NTTCommunications Corporation. All rights reserved.

6

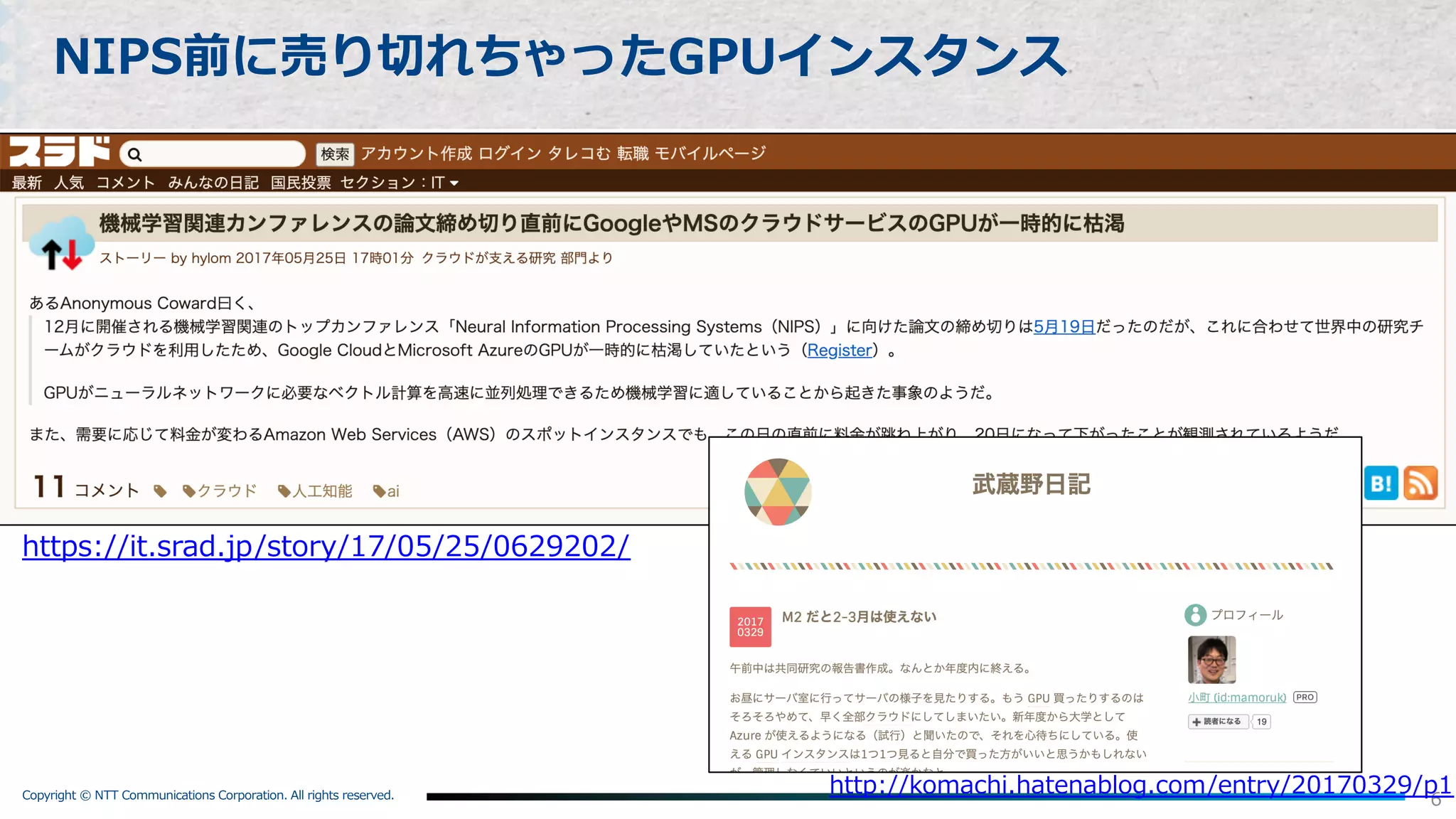

NIPS前に売り切れちゃったGPUインスタンス

http://komachi.hatenablog.com/entry/20170329/p1

https://it.srad.jp/story/17/05/25/0629202/

- 8.

Copyright © NTTCommunications Corporation. All rights reserved.

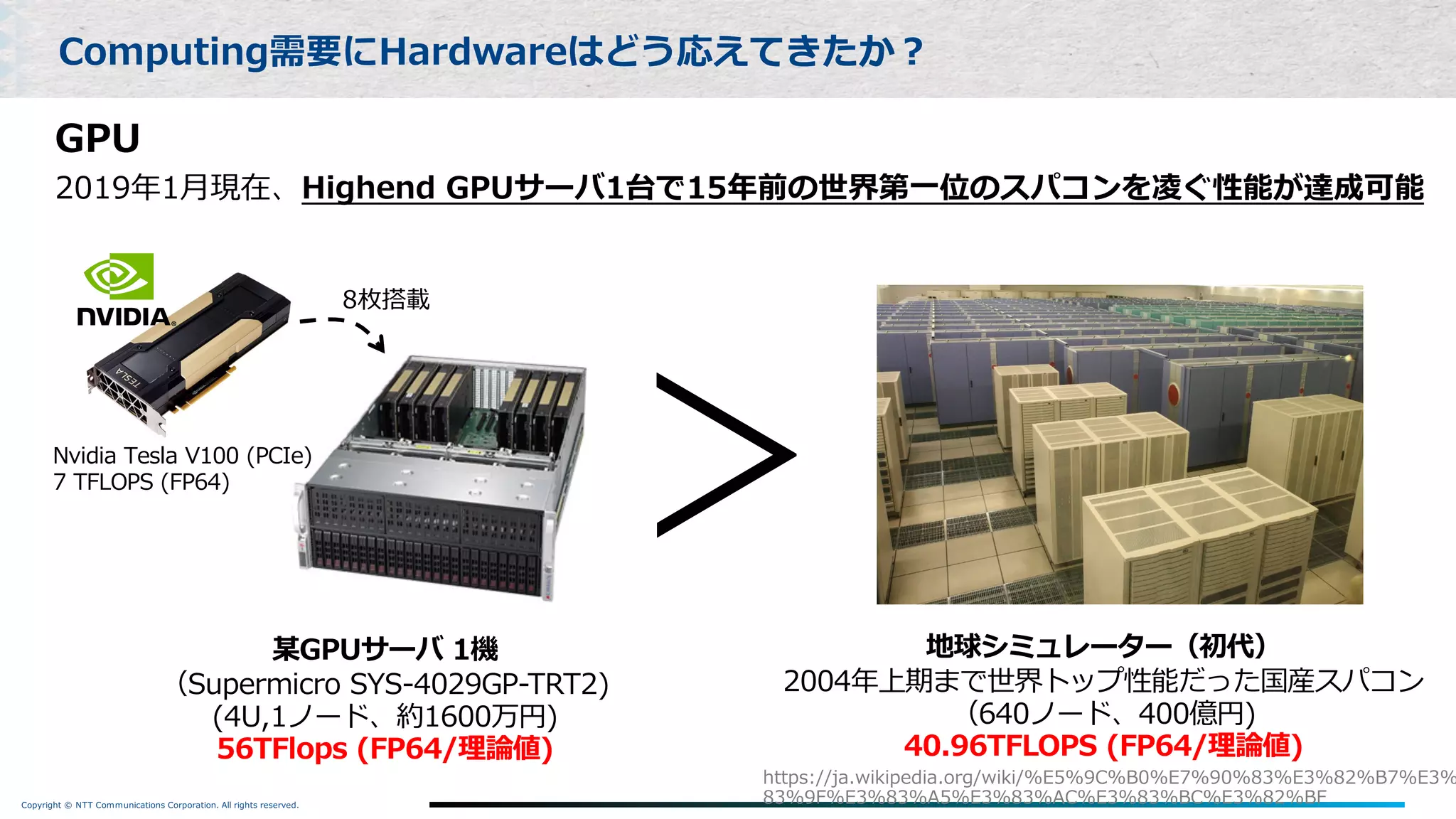

GPU

2019年1⽉現在、Highend GPUサーバ1台で15年前の世界第⼀位のスパコンを凌ぐ性能が達成可能

Computing需要にHardwareはどう応えてきたか︖

某GPUサーバ 1機

(Supermicro SYS-4029GP-TRT2)

(4U,1ノード、約1600万円)

56TFlops (FP64/理論値)

Nvidia Tesla V100 (PCIe)

7 TFLOPS (FP64)

8枚搭載

地球シミュレーター(初代)

2004年上期まで世界トップ性能だった国産スパコン

(640ノード、400億円)

40.96TFLOPS (FP64/理論値)

>

https://ja.wikipedia.org/wiki/%E5%9C%B0%E7%90%83%E3%82%B7%E3%

83%9F%E3%83%A5%E3%83%AC%E3%83%BC%E3%82%BF

- 9.

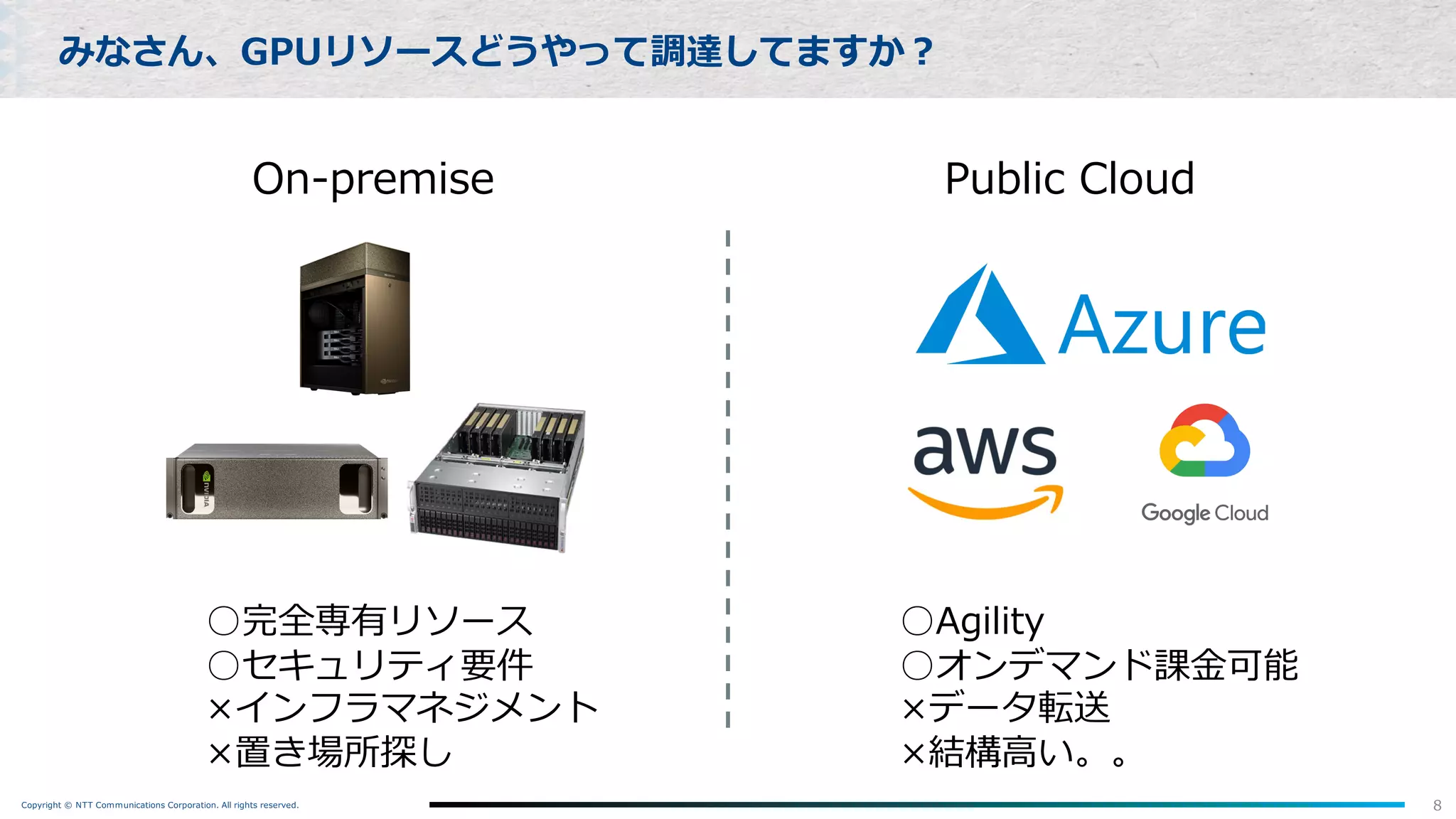

Copyright © NTTCommunications Corporation. All rights reserved. 8

みなさん、GPUリソースどうやって調達してますか︖

On-premise Public Cloud

○完全専有リソース

○セキュリティ要件

×インフラマネジメント

×置き場所探し

○Agility

○オンデマンド課⾦可能

×データ転送

×結構⾼い。。

- 10.

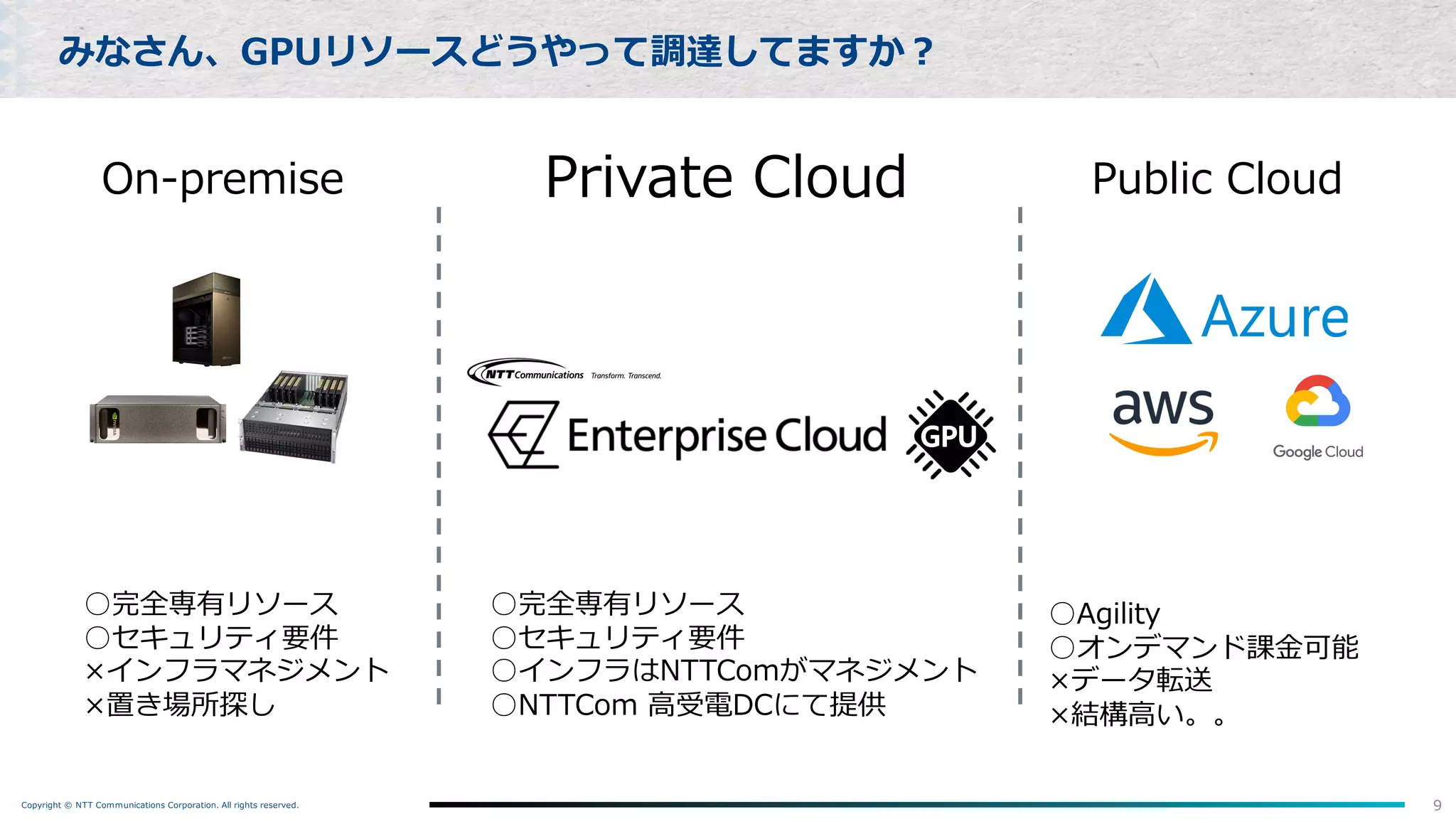

Copyright © NTTCommunications Corporation. All rights reserved. 9

みなさん、GPUリソースどうやって調達してますか︖

On-premise Public Cloud

○完全専有リソース

○セキュリティ要件

×インフラマネジメント

×置き場所探し

○Agility

○オンデマンド課⾦可能

×データ転送

×結構⾼い。。

Private Cloud

○完全専有リソース

○セキュリティ要件

○インフラはNTTComがマネジメント

○NTTCom ⾼受電DCにて提供

- 11.

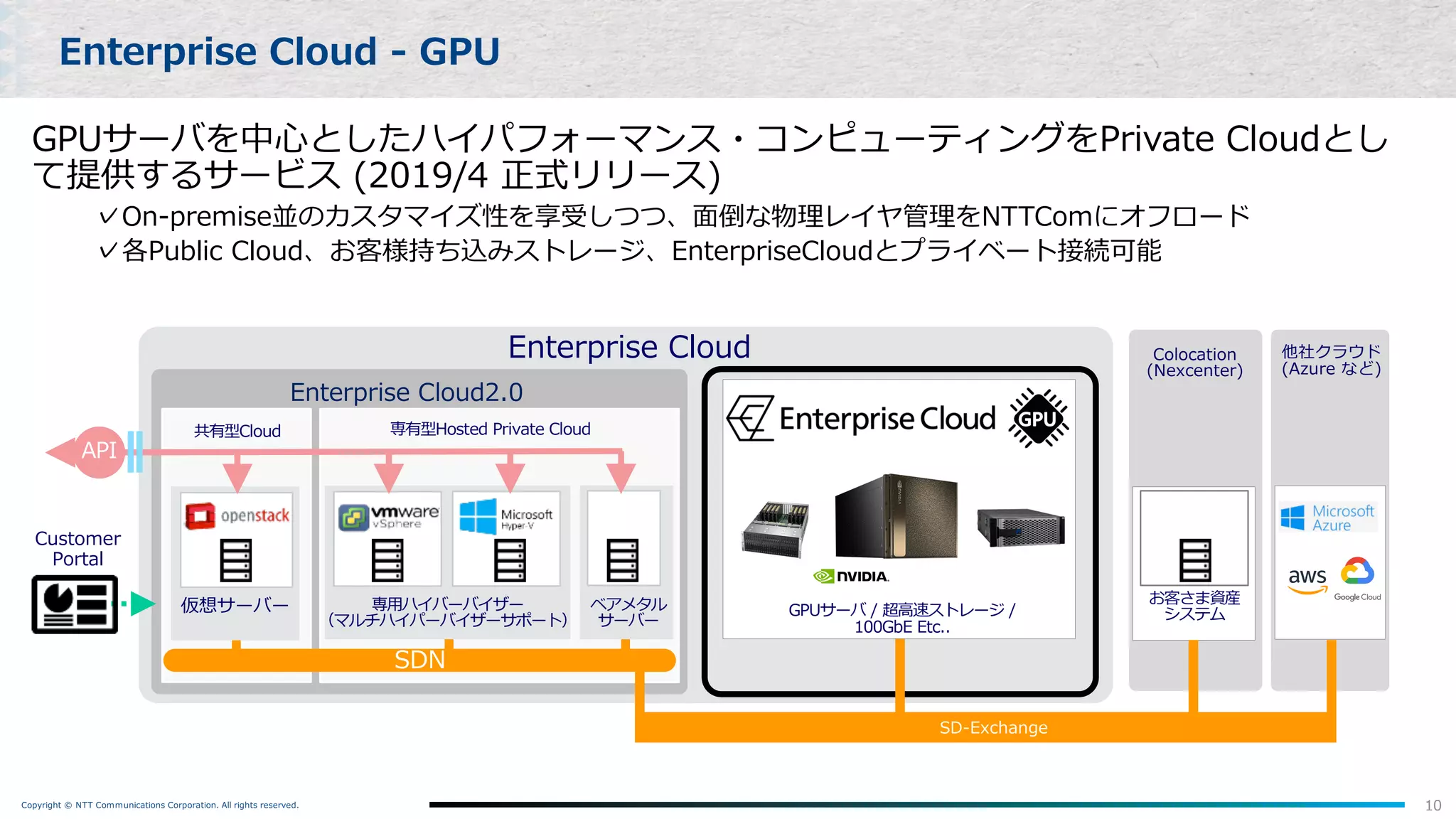

Copyright © NTTCommunications Corporation. All rights reserved. 10

Enterprise Cloud - GPU

SDN

Enterprise Cloud2.0

ベアメタル

サーバー

専⽤ハイバーバイザー

(マルチハイパーバイザーサポート)

共有型Cloud 専有型Hosted Private Cloud

仮想サーバー

Colocation

(Nexcenter)

API

Enterprise Cloud

GPUサーバ / 超⾼速ストレージ /

100GbE Etc..

Customer

Portal

お客さま資産

システム

他社クラウド

(Azure など)

SD-Exchange

GPUサーバを中⼼としたハイパフォーマンス・コンピューティングをPrivate Cloudとし

て提供するサービス (2019/4 正式リリース)

✓On-premise並のカスタマイズ性を享受しつつ、⾯倒な物理レイヤ管理をNTTComにオフロード

✓各Public Cloud、お客様持ち込みストレージ、EnterpriseCloudとプライベート接続可能

- 12.

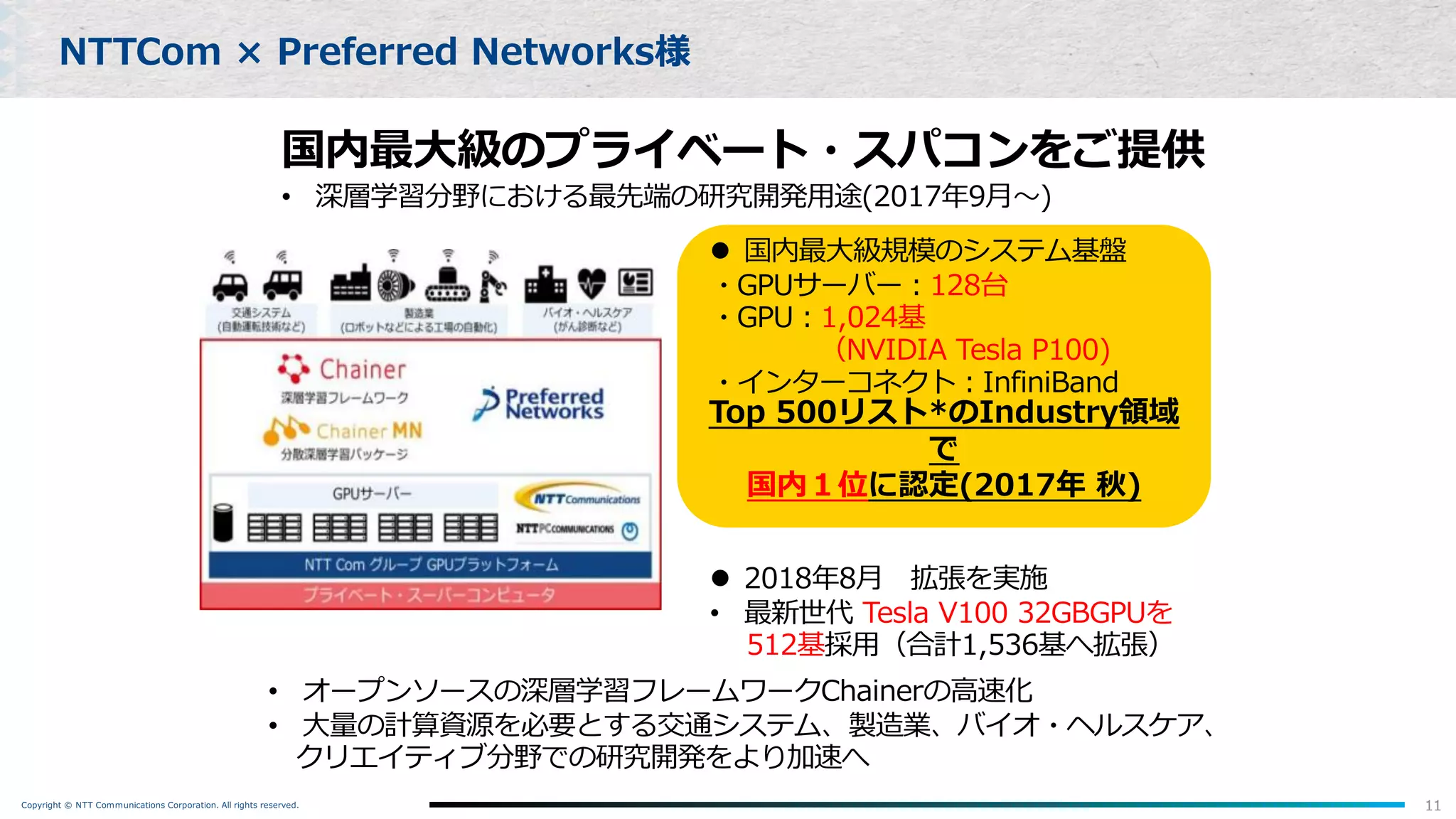

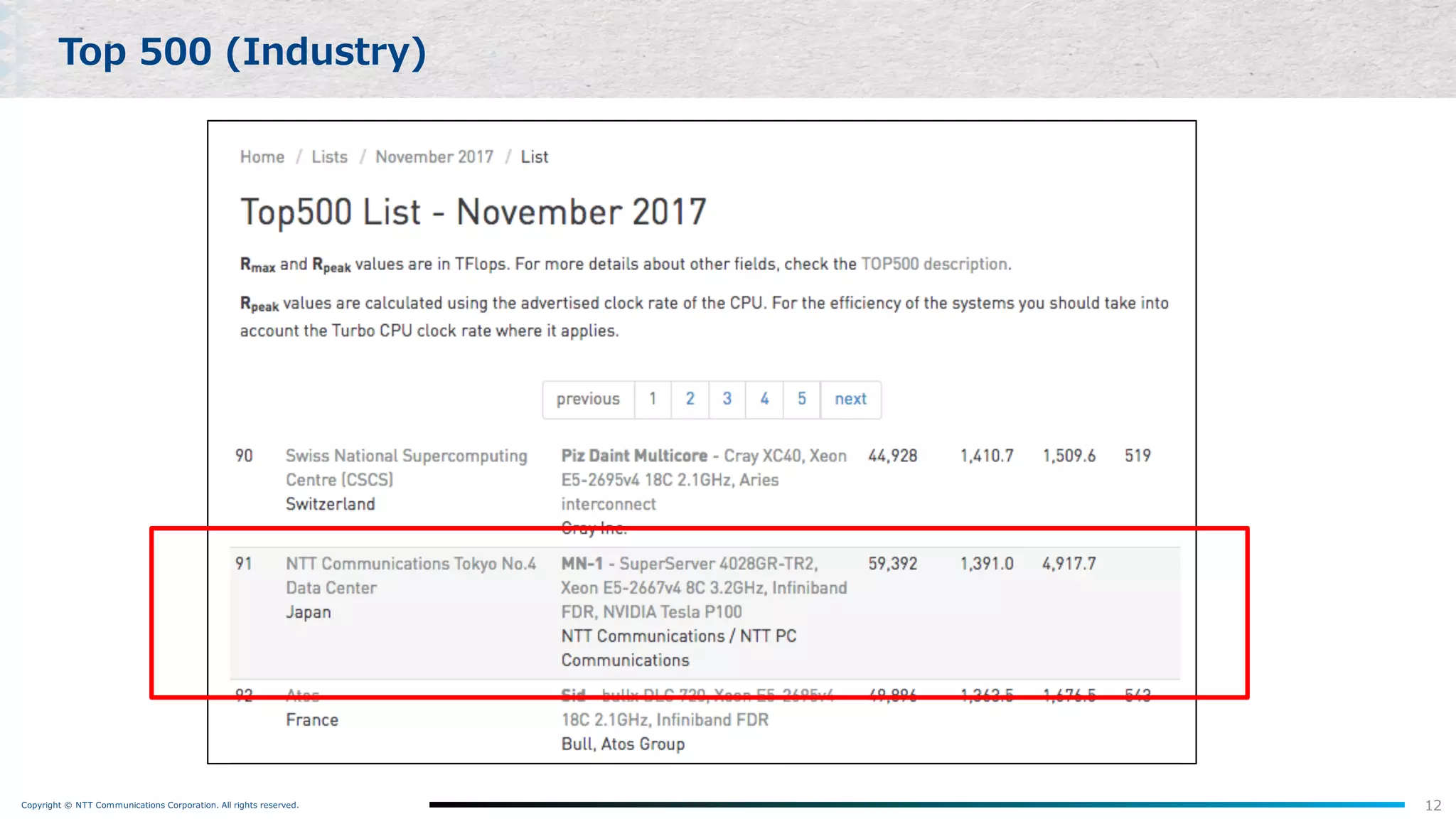

Copyright © NTTCommunications Corporation. All rights reserved. 11

NTTCom × Preferred Networks様

Top 500リスト*のIndustry領域

で

国内1位に認定(2017年 秋)

国内最⼤級のプライベート・スパコンをご提供

• 深層学習分野における最先端の研究開発⽤途(2017年9⽉〜)

l 国内最⼤級規模のシステム基盤

・GPUサーバー︓128台

・GPU︓1,024基

(NVIDIA Tesla P100)

・インターコネクト︓InfiniBand

l 2018年8⽉ 拡張を実施

• 最新世代 Tesla V100 32GBGPUを

512基採⽤(合計1,536基へ拡張)

• オープンソースの深層学習フレームワークChainerの⾼速化

• ⼤量の計算資源を必要とする交通システム、製造業、バイオ・ヘルスケア、

クリエイティブ分野での研究開発をより加速へ

- 13.

Copyright © NTTCommunications Corporation. All rights reserved. 12

Top 500 (Industry)

- 14.

- 15.

Copyright © NTTCommunications Corporation. All rights reserved.

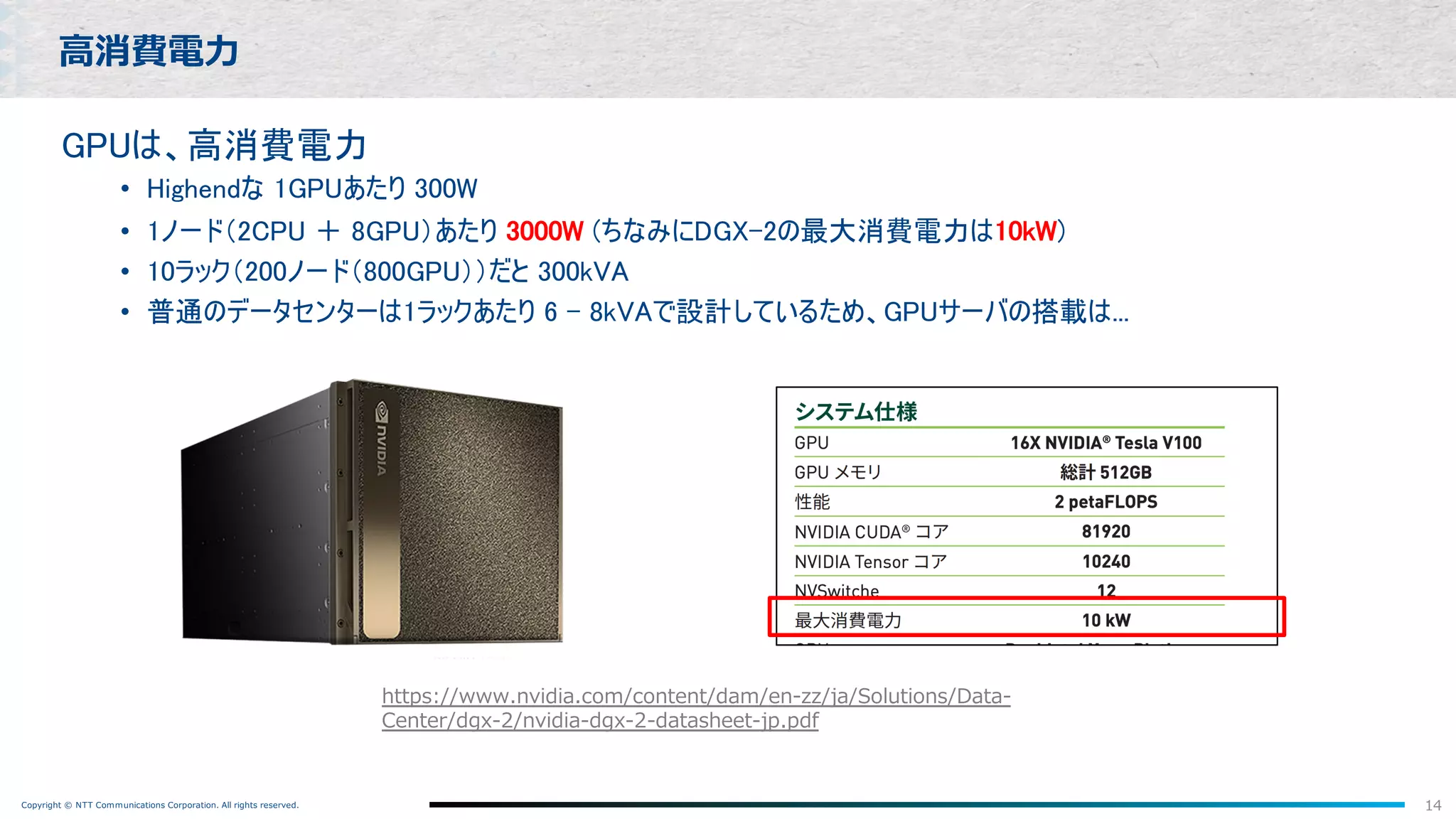

GPUは、高消費電力

• Highendな 1GPUあたり 300W

• 1ノード(2CPU + 8GPU)あたり 3000W (ちなみにDGX-2の最大消費電力は10kW)

• 10ラック(200ノード(800GPU))だと 300kVA

• 普通のデータセンターは1ラックあたり 6 - 8kVAで設計しているため、GPUサーバの搭載は...

14

⾼消費電⼒

https://www.nvidia.com/content/dam/en-zz/ja/Solutions/Data-

Center/dgx-2/nvidia-dgx-2-datasheet-jp.pdf

- 16.

Copyright © NTTCommunications Corporation. All rights reserved. 15

⾼消費電⼒ ->ラックに詰め込めない

ラックがスカスカになったの図

- 17.

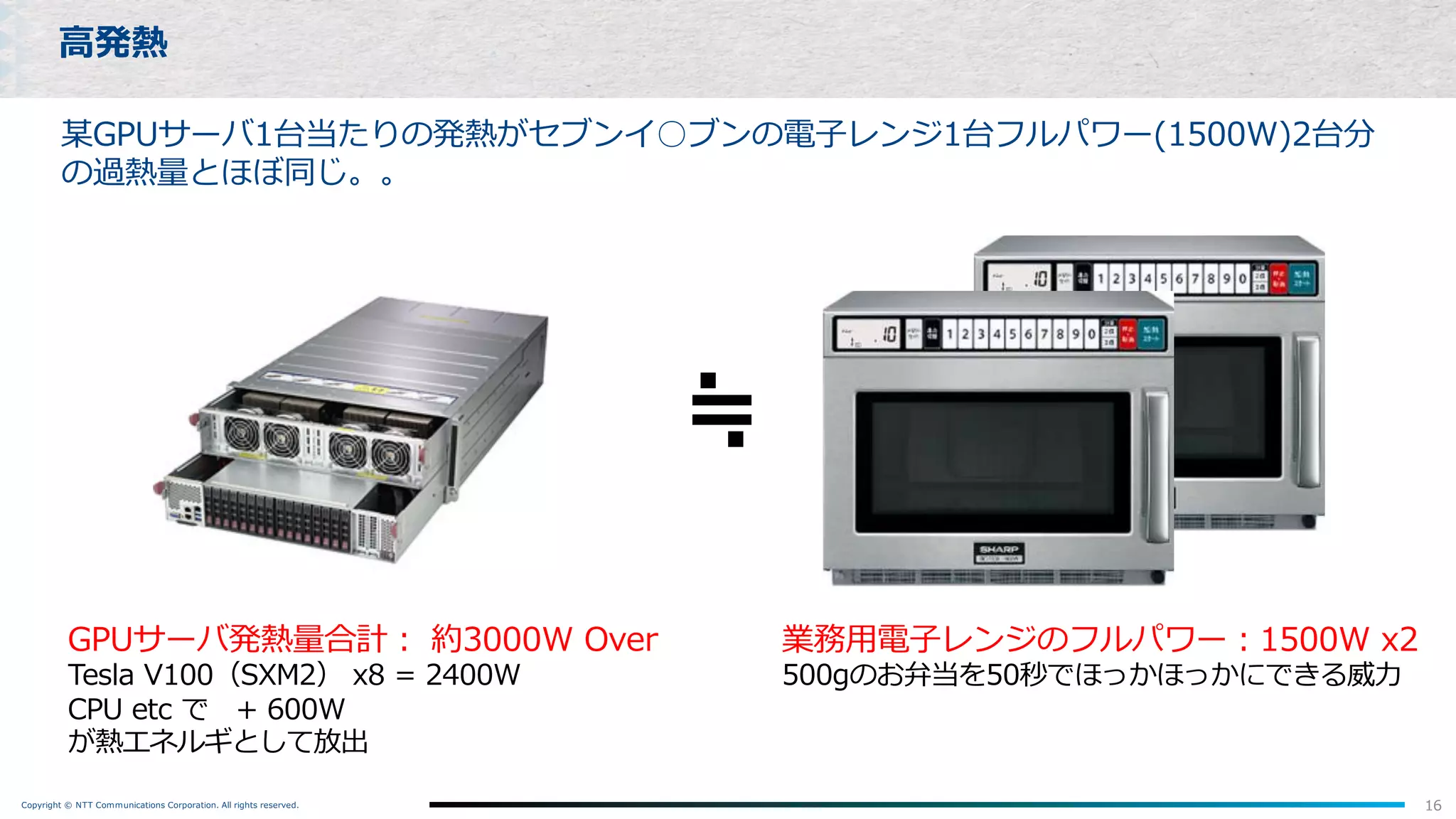

Copyright © NTTCommunications Corporation. All rights reserved.

某GPUサーバ1台当たりの発熱がセブンイ○ブンの電⼦レンジ1台フルパワー(1500W)2台分

の過熱量とほぼ同じ。。

⾼発熱

16

GPUサーバ発熱量合計︓ 約3000W Over

Tesla V100(SXM2) x8 = 2400W

CPU etc で + 600W

が熱エネルギとして放出

≒

業務⽤電⼦レンジのフルパワー︓1500W x2

500gのお弁当を50秒でほっかほっかにできる威⼒

- 18.

Copyright © NTTCommunications Corporation. All rights reserved.

17

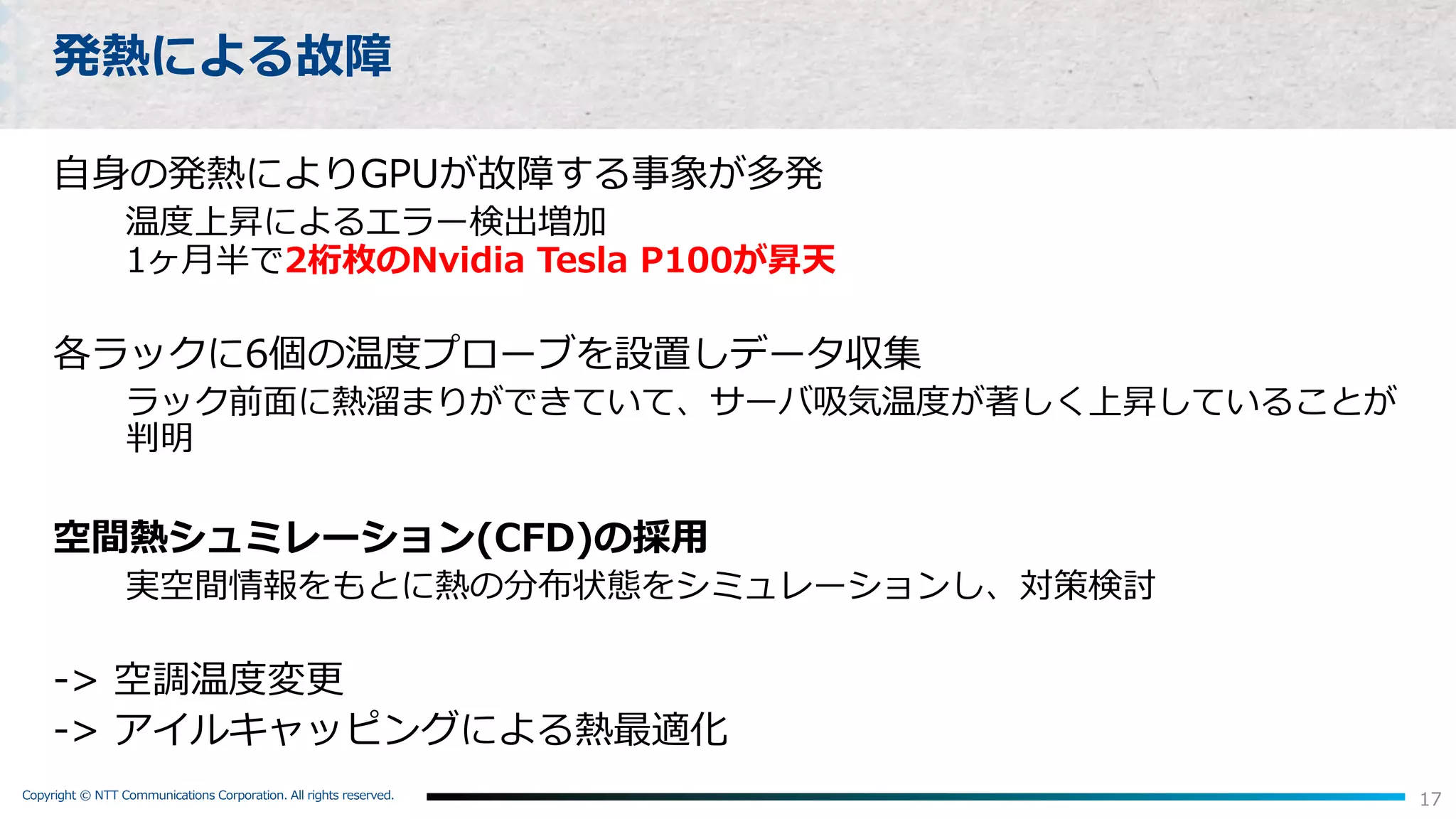

発熱による故障

⾃⾝の発熱によりGPUが故障する事象が多発

温度上昇によるエラー検出増加

1ヶ⽉半で2桁枚のNvidia Tesla P100が昇天

各ラックに6個の温度プローブを設置しデータ収集

ラック前⾯に熱溜まりができていて、サーバ吸気温度が著しく上昇していることが

判明

空間熱シュミレーション(CFD)の採⽤

実空間情報をもとに熱の分布状態をシミュレーションし、対策検討

-> 空調温度変更

-> アイルキャッピングによる熱最適化

- 19.

Copyright © NTTCommunications Corporation. All rights reserved.

18

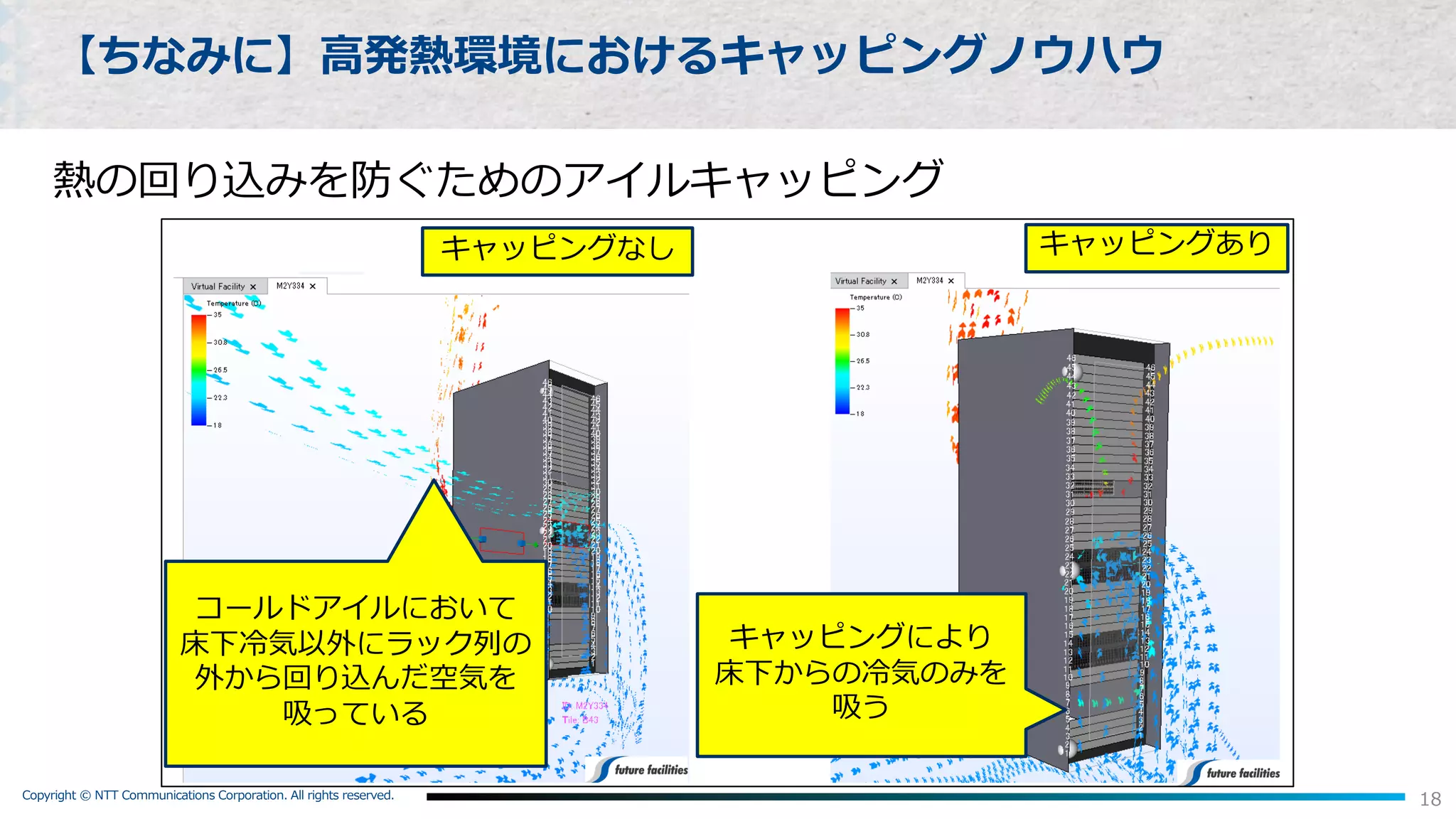

【ちなみに】⾼発熱環境におけるキャッピングノウハウ

熱の回り込みを防ぐためのアイルキャッピング

- 20.

Copyright © NTTCommunications Corporation. All rights reserved.

19

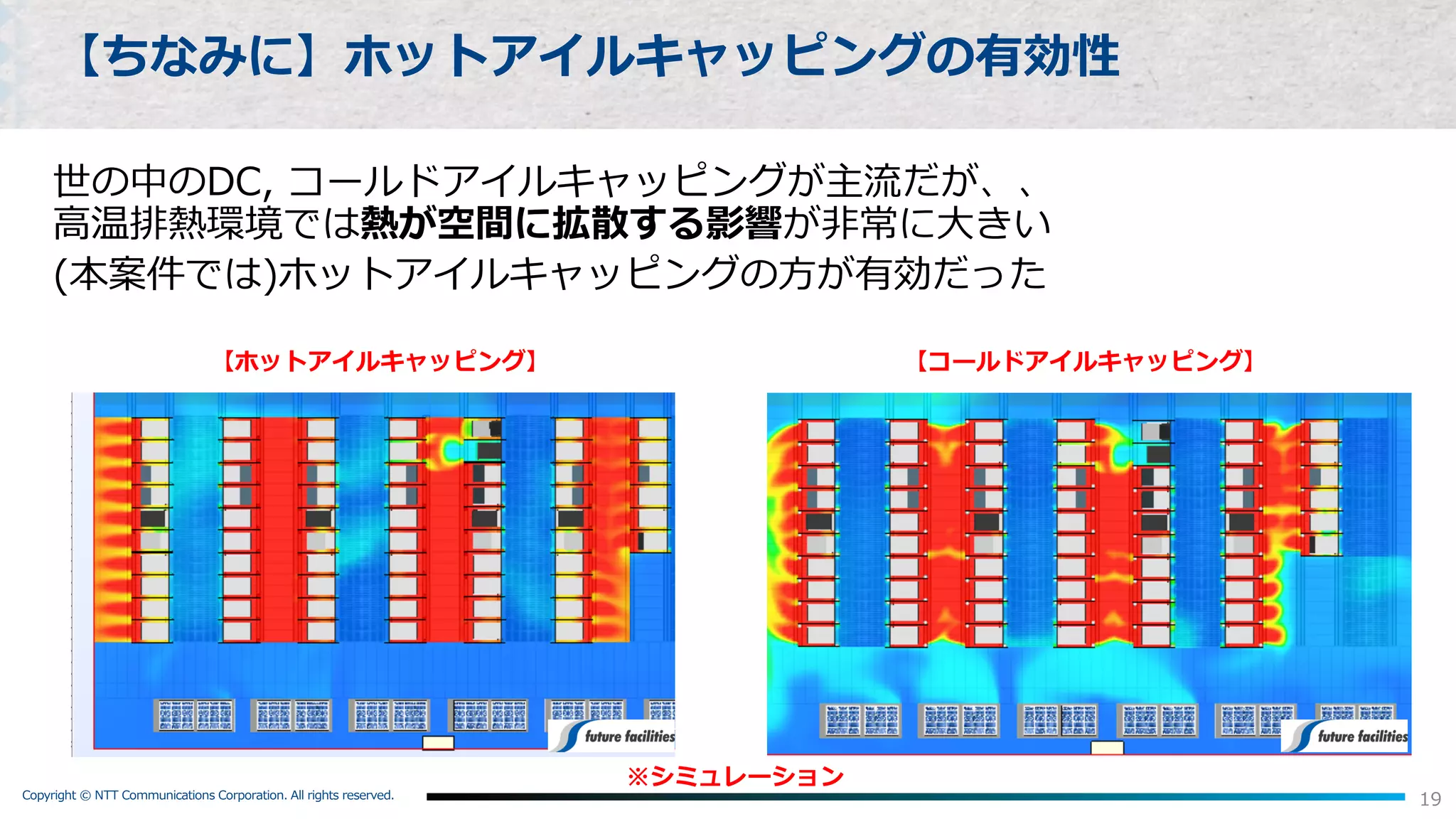

【ちなみに】ホットアイルキャッピングの有効性

世の中のDC, コールドアイルキャッピングが主流だが、、

⾼温排熱環境では熱が空間に拡散する影響が⾮常に⼤きい

(本案件では)ホットアイルキャッピングの⽅が有効だった

【コールドアイルキャッピング】【ホットアイルキャッピング】

※シミュレーション

- 21.

Copyright © NTTCommunications Corporation. All rights reserved.

今後に向けて (Nexcenter Lab)

1. GPUを更にしっかり冷やすために

2. もっと⼿軽に⼤規模コンピュートインフラを利⽤するために

- 22.

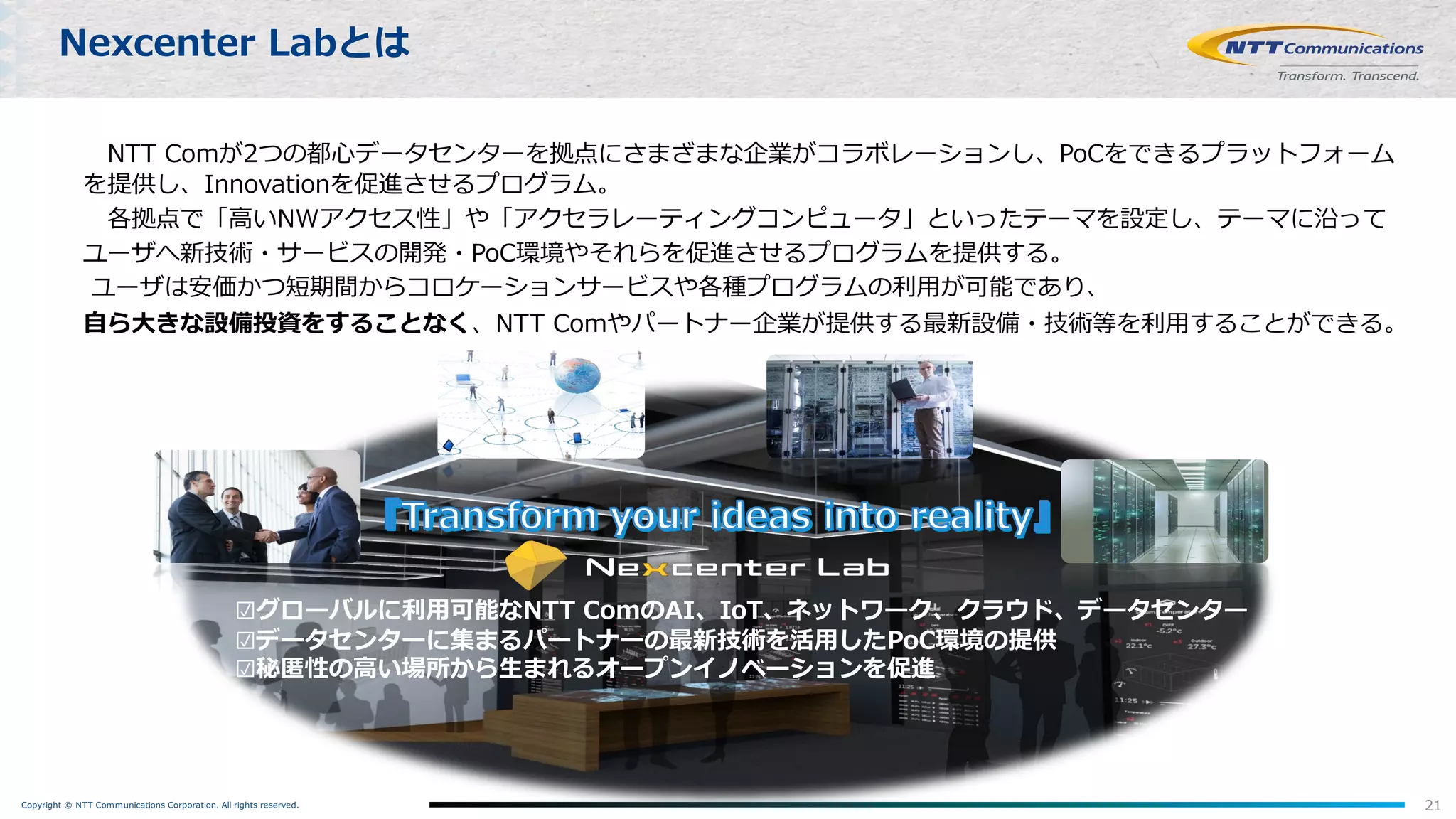

Copyright © NTTCommunications Corporation. All rights reserved. 21

Nexcenter Labとは

NTT Comが2つの都⼼データセンターを拠点にさまざまな企業がコラボレーションし、PoCをできるプラットフォーム

を提供し、Innovationを促進させるプログラム。

各拠点で「⾼いNWアクセス性」や「アクセラレーティングコンピュータ」といったテーマを設定し、テーマに沿って

ユーザへ新技術・サービスの開発・PoC環境やそれらを促進させるプログラムを提供する。

ユーザは安価かつ短期間からコロケーションサービスや各種プログラムの利⽤が可能であり、

⾃ら⼤きな設備投資をすることなく、NTT Comやパートナー企業が提供する最新設備・技術等を利⽤することができる。

☑グローバルに利⽤可能なNTT ComのAI、IoT、ネットワーク、クラウド、データセンター

☑データセンターに集まるパートナーの最新技術を活⽤したPoC環境の提供

☑秘匿性の⾼い場所から⽣まれるオープンイノベーションを促進

- 23.

Copyright © NTTCommunications Corporation. All rights reserved.

1.GPUをもっとしっかり冷やすために

- 24.

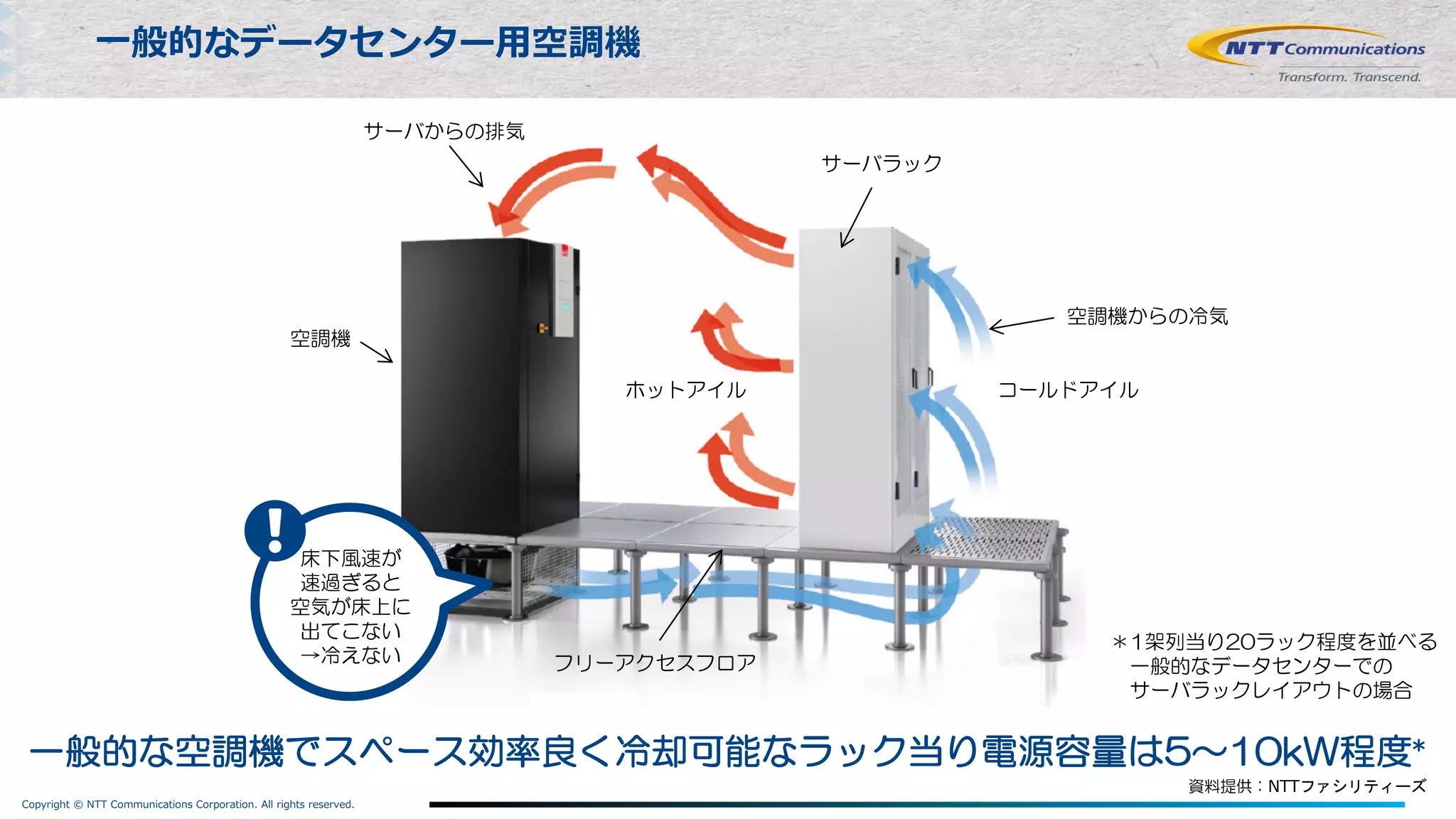

Copyright © NTTCommunications Corporation. All rights reserved.

サーバラック

空調機

空調機からの冷気

サーバからの排気

フリーアクセスフロア

一般的な空調機でスペース効率良く冷却可能なラック当り電源容量は5~10kW程度*

⼀般的なデータセンター⽤空調機

*1架列当り20ラック程度を並べる

一般的なデータセンターでの

サーバラックレイアウトの場合

コールドアイルホットアイル

床下風速が

速過ぎると

空気が床上に

出てこない

→冷えない

資料提供:NTTファシリティーズ

- 25.

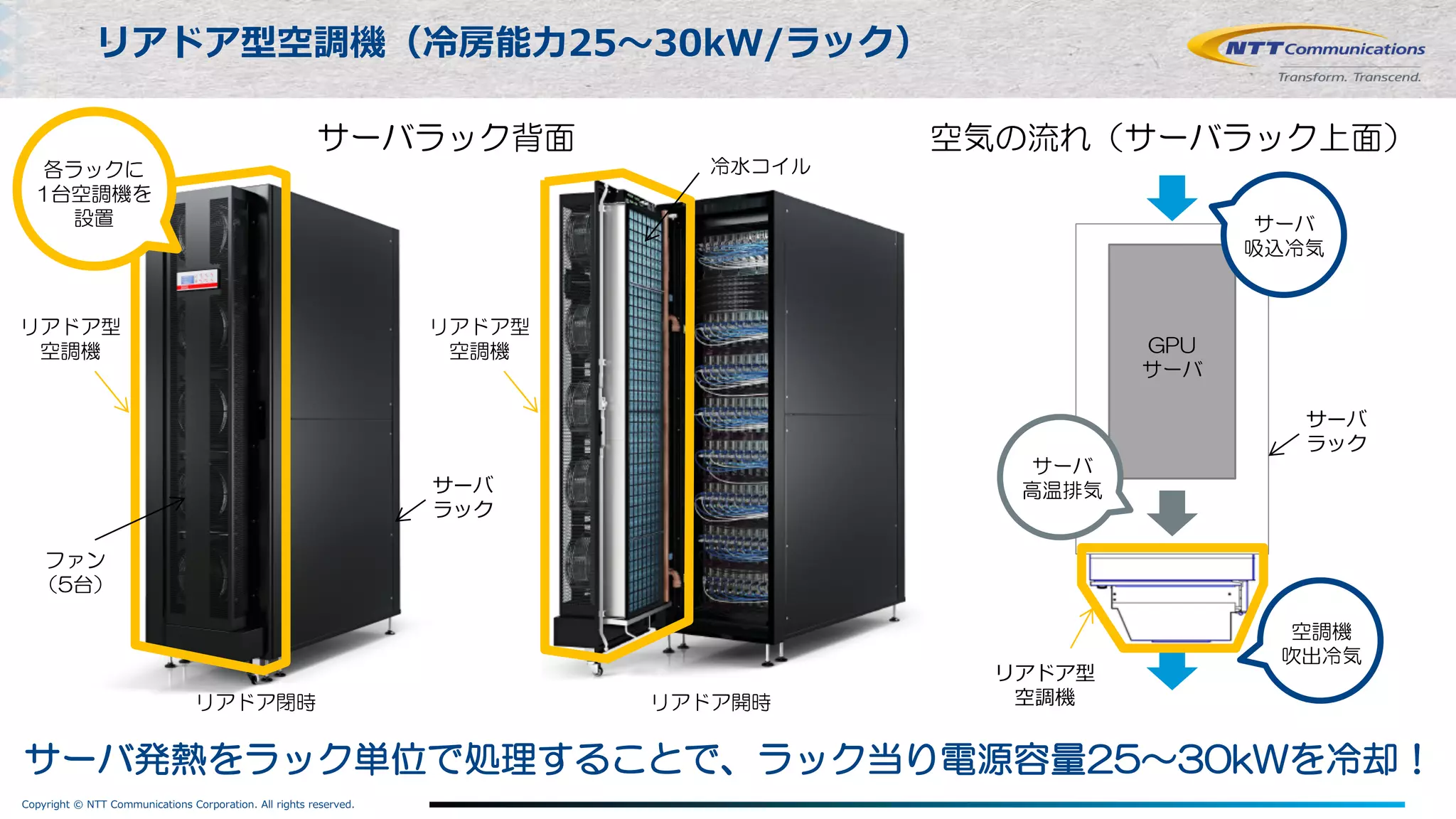

Copyright © NTTCommunications Corporation. All rights reserved.

リアドア型空調機(冷房能⼒25〜30kW/ラック)

サーバ発熱をラック単位で処理することで、ラック当り電源容量25~30kWを冷却!

GPU

サーバ

リアドア型

空調機

サーバ

ラック

空調機

吹出冷気

サーバ

吸込冷気

サーバ

高温排気

リアドア閉時 リアドア開時

冷水コイル

ファン

(5台)

リアドア型

空調機

サーバラック背面 空気の流れ(サーバラック上面)

リアドア型

空調機

サーバ

ラック

各ラックに

1台空調機を

設置

- 26.

Copyright © NTTCommunications Corporation. All rights reserved.

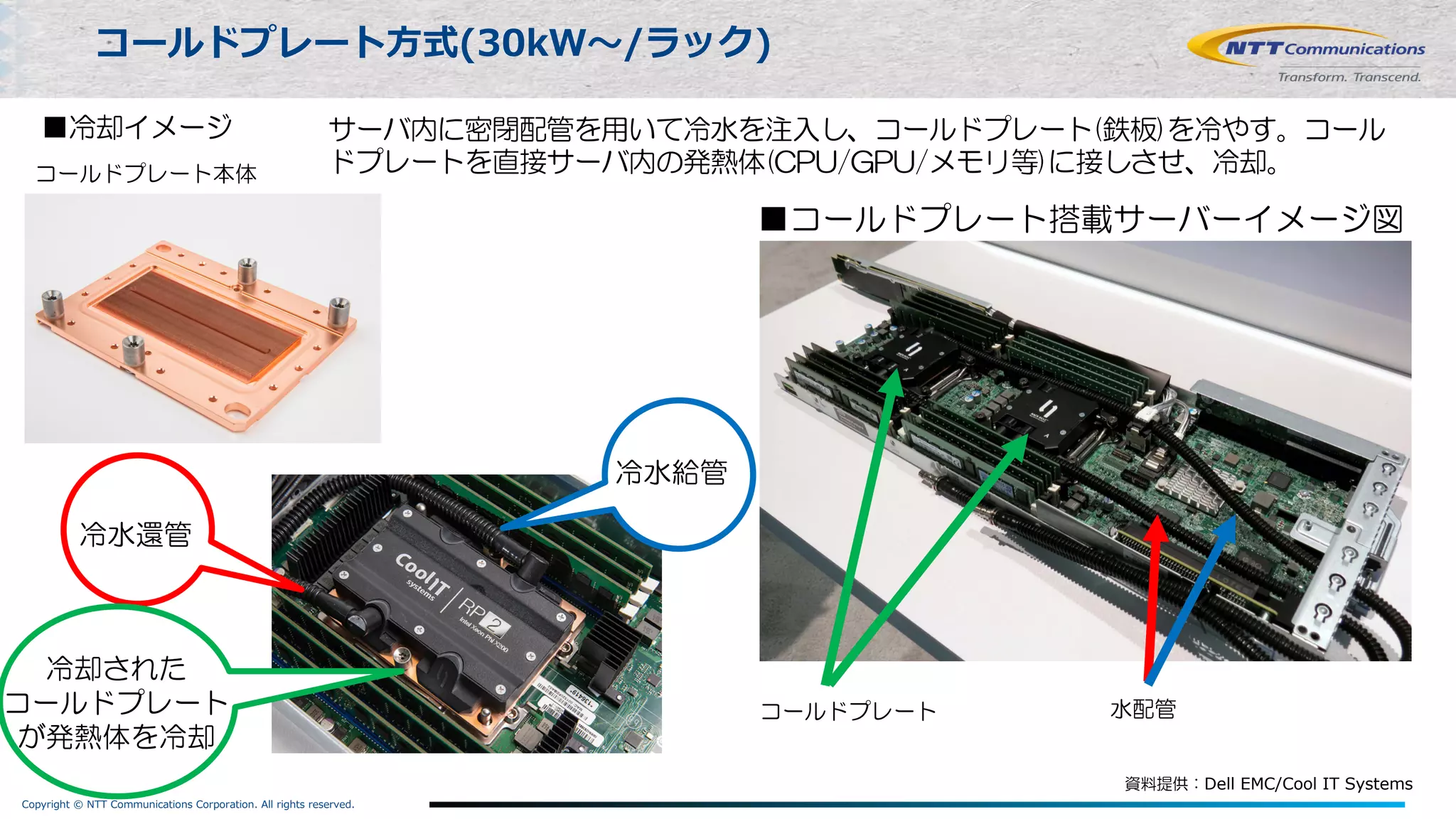

コールドプレート⽅式(30kW〜/ラック)

■コールドプレート搭載サーバーイメージ図

■冷却イメージ

冷水給管

冷水還管

冷却された

コールドプレート

が発熱体を冷却

コールドプレート本体

コールドプレート 水配管

サーバ内に密閉配管を用いて冷水を注入し、コールドプレート(鉄板)を冷やす。コール

ドプレートを直接サーバ内の発熱体(CPU/GPU/メモリ等)に接しさせ、冷却。

資料提供:Dell EMC/Cool IT Systems

- 27.

Copyright © NTTCommunications Corporation. All rights reserved.

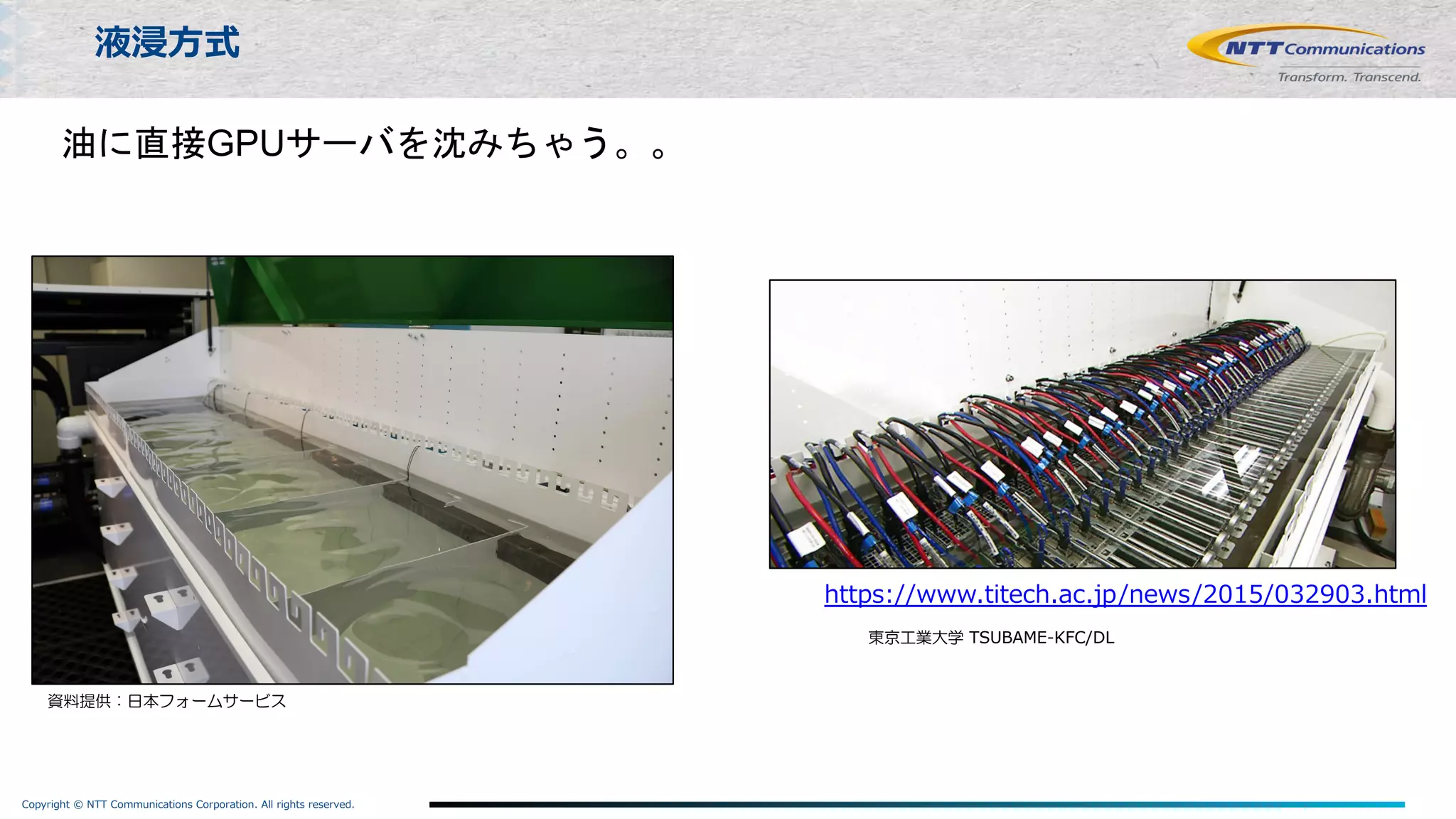

液浸⽅式

資料提供:日本フォームサービス

https://www.titech.ac.jp/news/2015/032903.html

東京工業大学 TSUBAME-KFC/DL

油に直接GPUサーバを沈みちゃう。。

- 28.

Copyright © NTTCommunications Corporation. All rights reserved.

リアドア式、コールドプレート⽅式(※)、液浸ラック(※)がTry可能

27

Nexcenter Lab Facility

※ 2019年内提供予定

- 29.

Copyright © NTTCommunications Corporation. All rights reserved.

2. もっと⼿軽に

⼤規模コンピュートインフラにTryしてもらうために

- 30.

Copyright © NTTCommunications Corporation. All rights reserved.

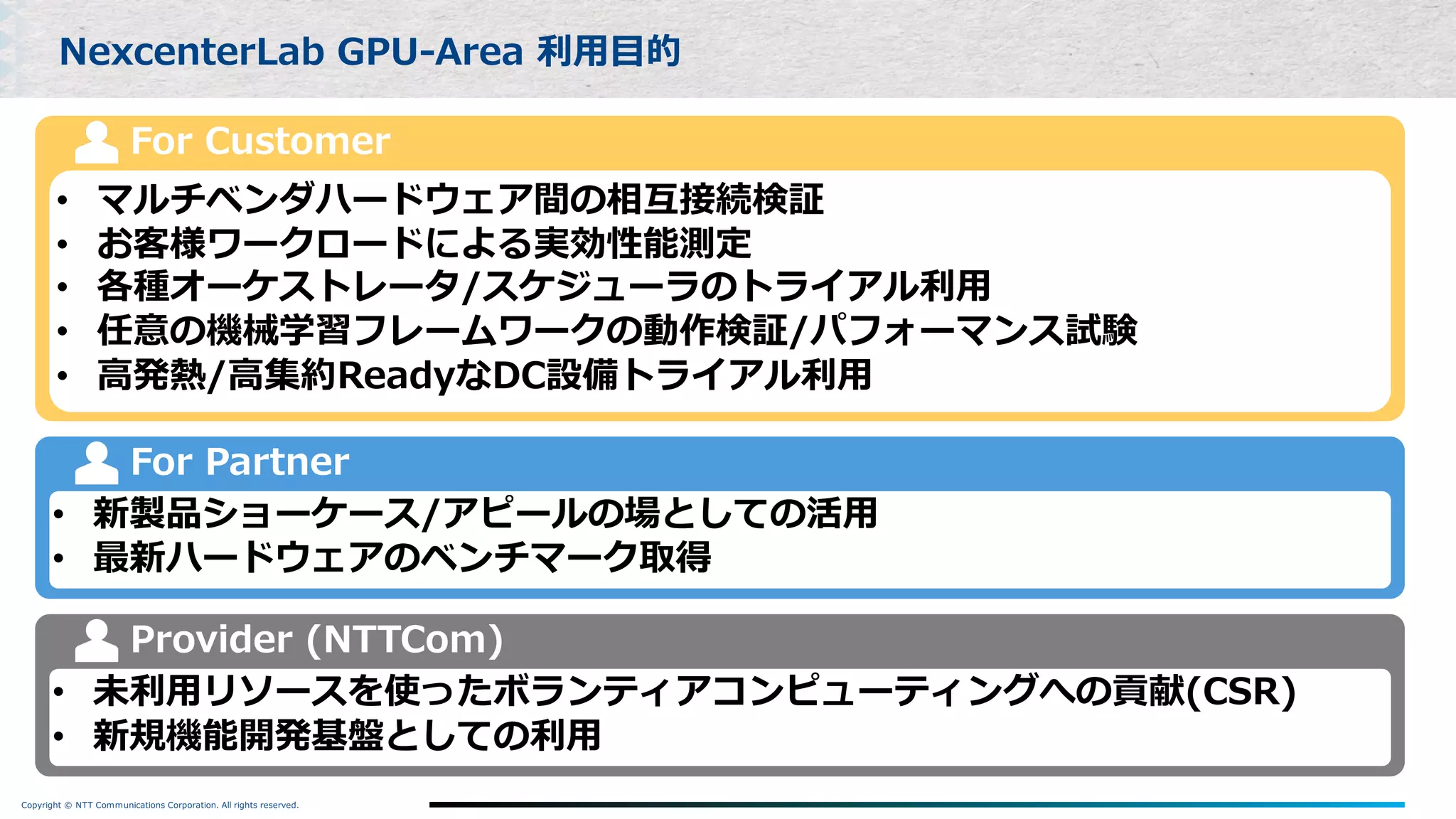

NexcenterLab GPU-Area 利⽤⽬的

• マルチベンダハードウェア間の相互接続検証

• お客様ワークロードによる実効性能測定

• 各種オーケストレータ/スケジューラのトライアル利⽤

• 任意の機械学習フレームワークの動作検証/パフォーマンス試験

• ⾼発熱/⾼集約ReadyなDC設備トライアル利⽤

For Customer

• 新製品ショーケース/アピールの場としての活⽤

• 最新ハードウェアのベンチマーク取得

For Partner

• 未利⽤リソースを使ったボランティアコンピューティングへの貢献(CSR)

• 新規機能開発基盤としての利⽤

Provider (NTTCom)

- 31.

Copyright © NTTCommunications Corporation. All rights reserved.

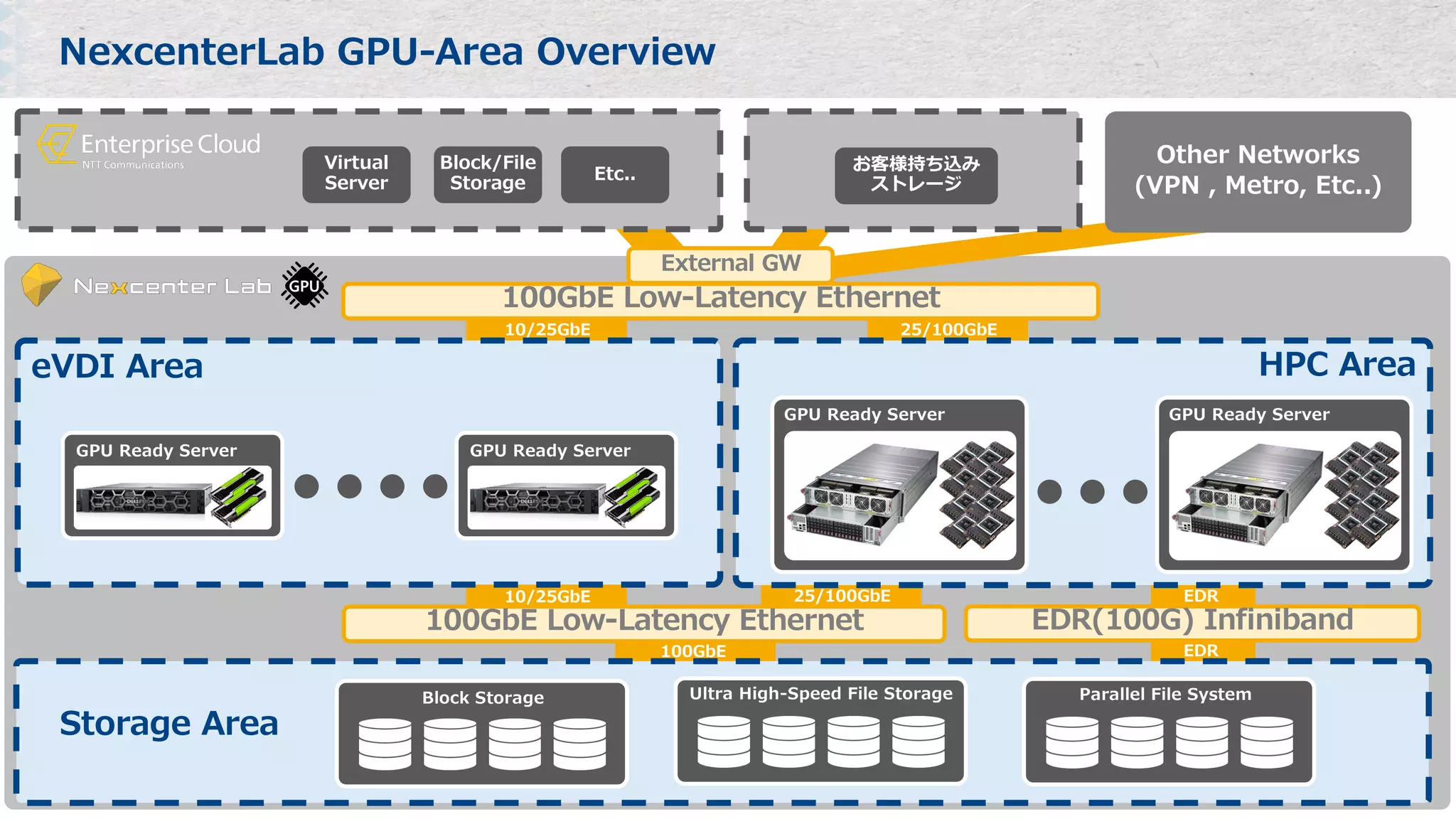

EDR100GbE

EDR25/100GbE10/25GbE

25/100GbE10/25GbE

NexcenterLab GPU-Area Overview

eVDI Area HPC Area

GPU Ready Server

100GbE Low-Latency Ethernet

Other Networks

(VPN , Metro, Etc..)

GPU Ready Server

GPU Ready Server

GPU Ready Server

EDR(100G) Infiniband

Storage Area

Ultra High-Speed File StorageBlock Storage Parallel File System

External GW

Virtual

Server

Block/File

Storage

Etc..

お客様持ち込み

ストレージ

100GbE Low-Latency Ethernet

- 32.

- 33.

Copyright © NTTCommunications Corporation. All rights reserved.

32

Summary

Deep Learningを実世界に適⽤するには、

それ相応のComputing Powerが必要

でも(物理的に)Computing Powerをたくさん⽤意するって結構⼤変

NTT⽬線での “DeepLearningの社会実装を拒むもの”

-> Ex) GPUサーバって結構 ⾼発熱 / ⾼電⼒ どこにでも置けるものではない

みなさんがDeep Learning がしがし回して社会実装できるように

インフラ強化頑張ります︕︕

+ Nexcenter Lab ご興味ある⽅は個別にお声がけくださいませ〜