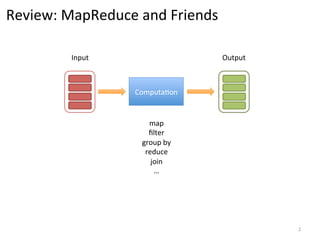

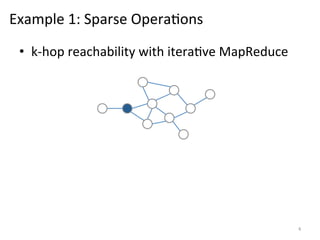

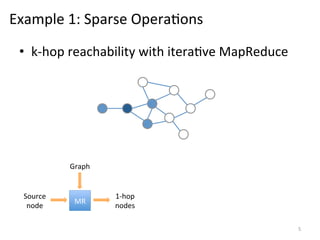

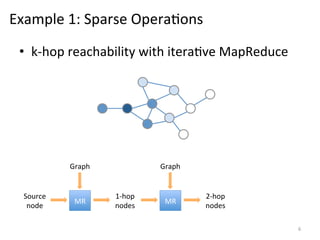

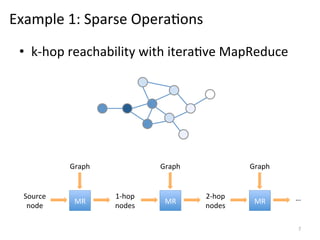

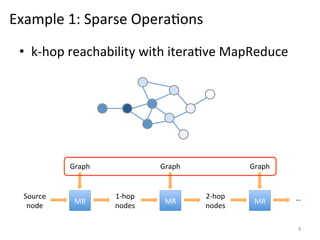

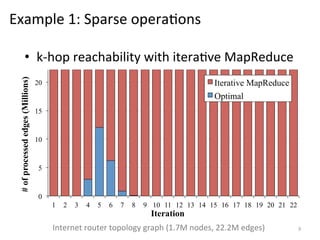

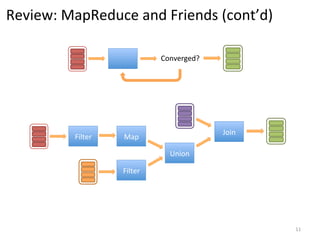

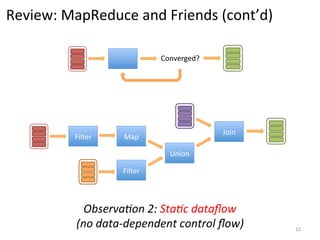

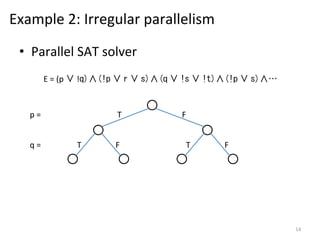

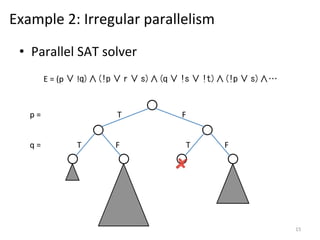

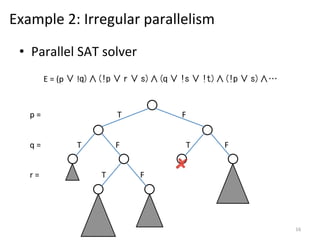

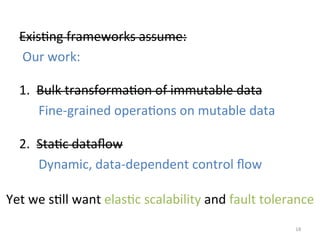

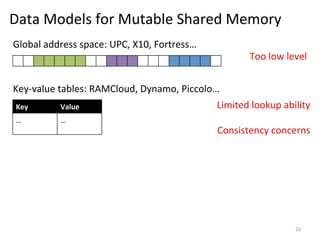

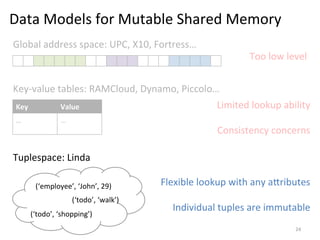

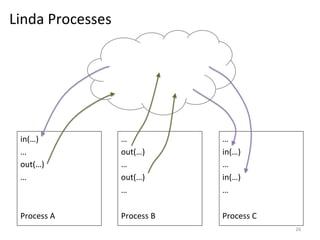

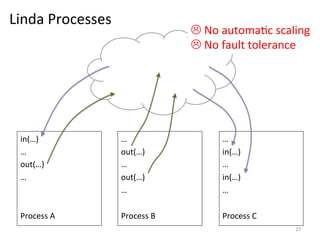

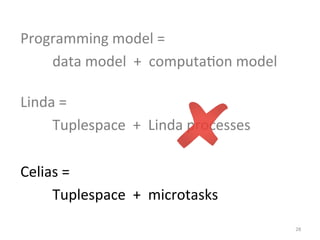

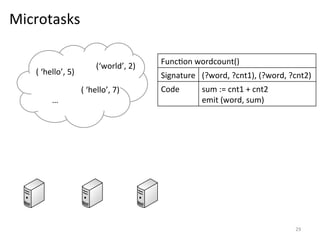

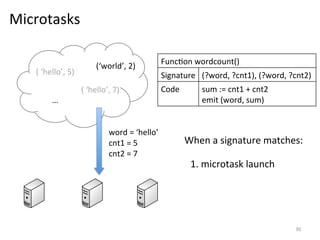

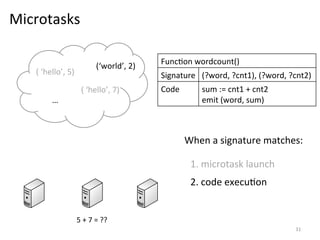

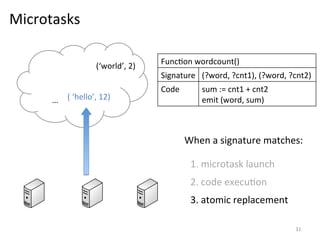

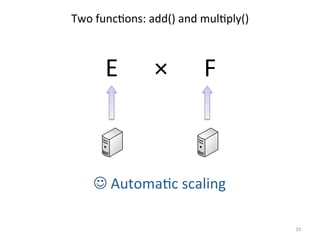

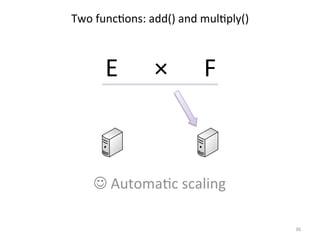

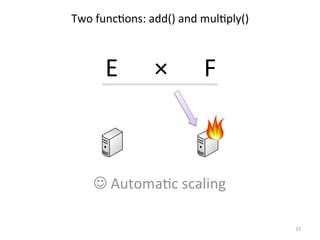

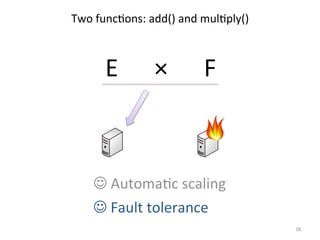

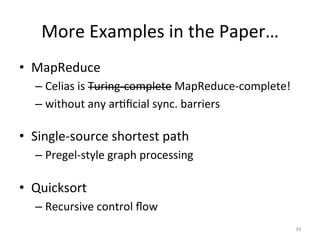

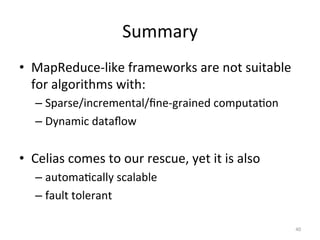

The document discusses the limitations of traditional MapReduce frameworks, particularly in handling sparse and dynamic data operations, and introduces a new programming model called Celias that supports fine-grained operations on mutable data with elastic scalability and fault tolerance. Celias incorporates a tuplespace model and microtasks to enhance expressiveness while maintaining performance. The paper raises questions about the practicality of microtask abstraction and its potential applications.