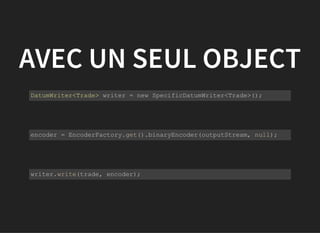

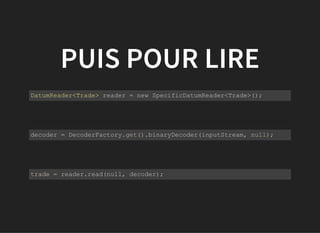

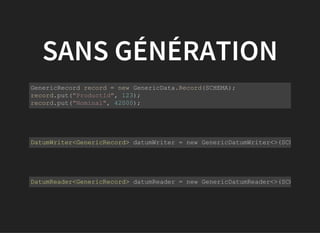

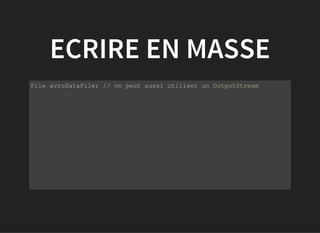

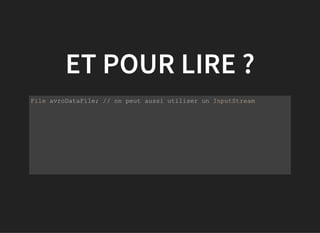

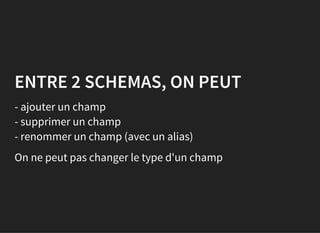

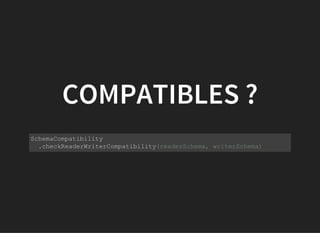

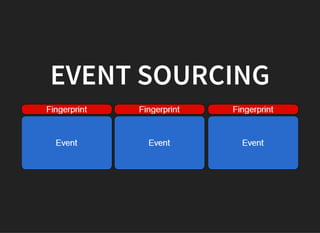

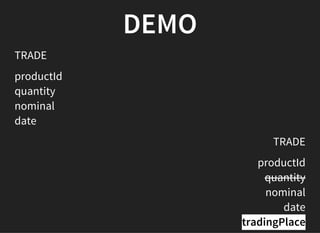

This document discusses Apache Avro, a data serialization system. It provides an example Avro schema for a trade record with fields like client ID, amount, and date. It then demonstrates how to write and read Avro data files containing records that match the schema, including writing single records with specific schemas or bulk writing generic records. The key feature discussed is Avro's ability to read data written with a different but compatible schema through schema resolution. Event sourcing is also mentioned as another use case for Avro.

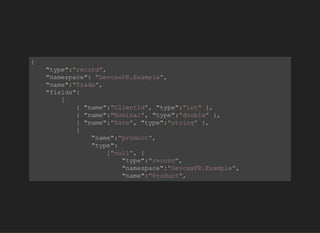

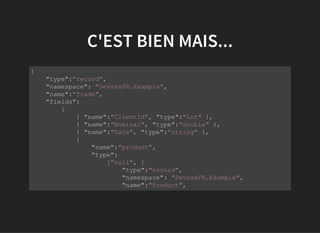

![{

"type":"record",

"namespace": "DevoxxFR.Example",

"name":"Trade",

"fields":

[

{ "name":"ClientId", "type":"int" },

{ "name":"Nominal", "type":"double" },

{ "name":"Date", "type":"string" }

]

}](https://image.slidesharecdn.com/avro-devoxx-080415-150411094231-conversion-gate01/85/Avro-la-puissance-du-binaire-la-souplesse-du-JSON-7-320.jpg)