本講演では、まず深層学習フレームワーク Chainer の特長およびその基本的な使い方を解説します。次に Azure を含む Microsoft のプラットフォーム上等の様々な環境で Chainer を動かす方法、またそれによって広がる応用と、今後の展望について述べます。

受講対象: Deep Learning の基礎を理解し、最新状況を理解したい方。あるいは既に Chainer をご利用の方は是非ご参加ください。

製品/テクノロジ: AI (人工知能)/Deep Learning (深層学習)/Machine Learning (機械学習)

齋藤 俊太

株式会社Preferred Networks

リサーチャー

![Convolutional Networkを書く方法2

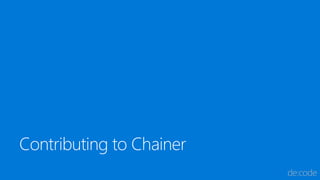

class LeNet5(chainer.Chain):

def __init__(self):

super(LeNet5, self).__init__()

net = [('conv1', L.Convolution2D(1, 6, 5, 1))]

net += [('_sigm1', F.Sigmoid())]

net += [('_mpool1', F.MaxPooling2D(2, 2))]

net += [('conv2', L.Convolution2D(6, 16, 5, 1))]

net += [('_sigm2', F.Sigmoid())]

net += [('_mpool2', F.MaxPooling2D(2, 2))]

net += [('conv3', L.Convolution2D(16, 120, 4, 1))]

net += [('_sigm3', F.Sigmoid())]

net += [('_mpool3', F.MaxPooling2D(2, 2))]

net += [('fc4', L.Linear(None, 84))]

net += [('_sigm4', F.Sigmoid())]

net += [('fc5', L.Linear(84, 10))]

net += [('_sigm5', F.Sigmoid())]

for name, layer in net:

if not name.startswith('_'):

with self.init_scope():

setattr(self, name, layer)

self.forward = net

def __call__(self, x):

for n, f in self.forward:

if not n.startswith('_'):

x = getattr(self, n)(x)

else:

x = f(x)

return x

※V2対応コードへ変更したため発表

時の資料とは若干異なります](https://image.slidesharecdn.com/ai08-170705031536/85/AI08-Chainer-x-Microsoft-19-320.jpg)

![モデルの学習

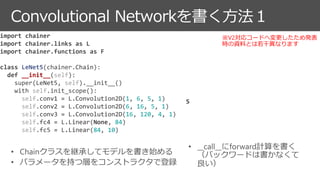

model = LeNet5()

model = L.Classifier(model)

# データセットはリスト([]でアクセスでき、__len__を持てば良い)

dataset = [(x1, t1), (x2, t2), ...]

# データセットから batchsize 個のデータを束ねて返してくれるイテレータ

it = iterators.SerialIterator(dataset, batchsize=32)

# 最適化手法 (SGDをMomentumSGD, Adam, RMSplop, AdaGradなどに変えれば、容易に色々な

# 最適化手法を試すことが可

opt = optimizers.SGD(lr=0.01)

opt.setup(model)

updater = training.StandardUpdater(it, opt, device=0) # CPUで計算する場合はdevice=-1

trainer = training.Trainer(updater, stop_trigger=(100, 'epoch'))

trainer.run()

https://github.com/pfnet/chainer/tree/master/examples](https://image.slidesharecdn.com/ai08-170705031536/85/AI08-Chainer-x-Microsoft-20-320.jpg)