More Related Content

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

はじめてのパターン認識 第5章 k最近傍法(k_nn法) What's hot

ZIP

PDF

PDF

PDF

PDF

Sliced Wasserstein Distance for Learning Gaussian Mixture Models PDF

PDF

PDF

PPTX

Swin Transformer (ICCV'21 Best Paper) を完璧に理解する資料 PDF

[第2回3D勉強会 研究紹介] Neural 3D Mesh Renderer (CVPR 2018) PPTX

PDF

パターン認識と機械学習 §6.2 カーネル関数の構成 PDF

PDF

PDF

PDF

ICLR2020の異常検知論文の紹介 (2019/11/23) PPTX

PDF

Sparse Codingをなるべく数式を使わず理解する(PCAやICAとの関係) PPTX

PPTX

勾配ブースティングの基礎と最新の動向 (MIRU2020 Tutorial) Similar to わかりやすいパターン認識_3章

PDF

PDF

PPTX

PDF

PRML 4.1 Discriminant Function PDF

PDF

オンライン凸最適化と線形識別モデル学習の最前線_IBIS2011 PPTX

PDF

PATTERN RECOGNITION AND MACHINE LEARNING (1.1) PDF

PPTX

PPTX

PDF

PDF

PRML 5.2.1-5.3.3 ニューラルネットワークの学習 (誤差逆伝播) / Training Neural Networks (Backpropa... PDF

PDF

PDF

PDF

PDF

PDF

PDF

わかりやすいパターン認識_3章

- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

7

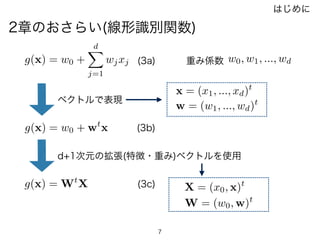

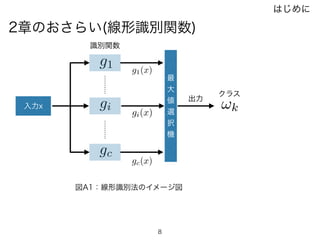

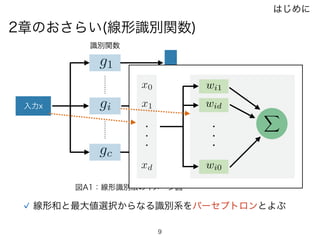

2章のおさらい(線形識別関数)

はじめに

g(x) = w0+

dX

j=1

wjxj

g(x) = w0 + wt

x

g(x) = Wt

X

w0, w1, ..., wd重み係数

ベクトルで表現

d+1次元の拡張(特徴・重み)ベクトルを使用

w = (w1, ..., wd)t

x = (x1, ..., xd)t

W = (w0, w)t

X = (x0, x)t

(3a)

(3b)

(3c)

- 8.

- 9.

- 10.

- 11.

- 12.

12

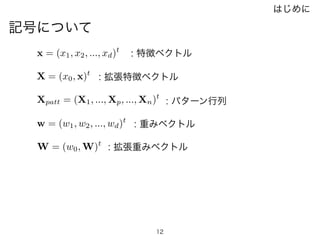

記号について

w = (w1,w2, ..., wd)t

x = (x1, x2, ..., xd)t

X = (x0, x)t

W = (w0, W)t

Xpatt = (X1, ..., Xp, ..., Xn)t

: 特徴ベクトル

: 拡張特徴ベクトル

: 重みベクトル

: 拡張重みベクトル

: パターン行列

はじめに

- 13.

- 14.

- 15.

- 16.

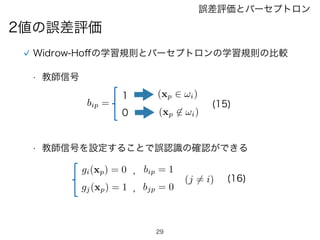

16

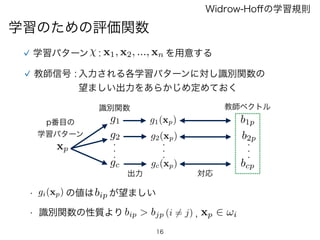

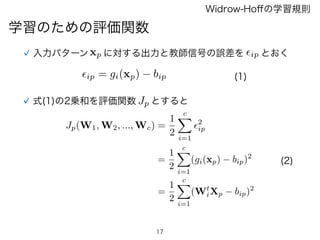

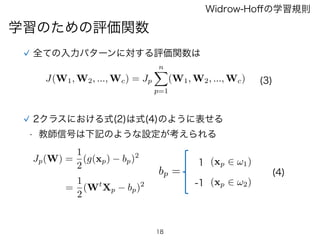

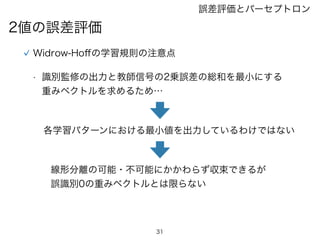

学習のための評価関数

Widrow-Hoffの学習規則

学習パターン : x1,x2, ..., xn を用意する

教師信号 : 入力される各学習パターンに対し識別関数の

望ましい出力をあらかじめ定めておく

xp

g1

g2

gc gc(xp)

g2(xp)

g1(xp) b1p

b2p

bcp

p番目の

学習パターン

識別関数

・・・

・・・

・・・

教師ベクトル

対応

gi(xp) の値はbip が望ましい•

• 識別関数の性質より bip > bjp (i 6= j) xp 2 !i,

出力

- 17.

- 18.

- 19.

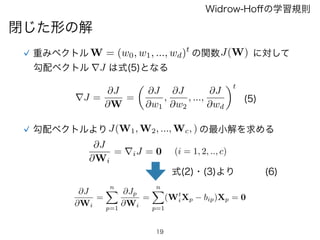

19

閉じた形の解

Widrow-Hoffの学習規則

重みベクトル W =(w0, w1, ..., wd)t

の関数J(W) に対して

勾配ベクトル rJ は式(5)となる

(5)rJ =

@J

@W

=

✓

@J

@w1

,

@J

@w2

, ...,

@J

@wd

◆t

勾配ベクトルよりJ(W1, W2, ..., Wc, ) の最小解を求める

@J

@Wi

= riJ = 0 (i = 1, 2, .., c)

(6)

@J

@Wi

=

nX

p=1

@Jp

@Wi

=

nX

p=1

(Wt

iXp bip)Xp = 0

式(2)・(3)より

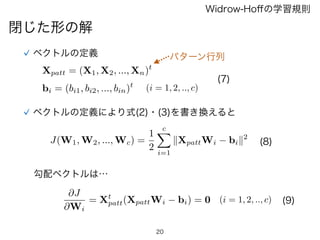

- 20.

20

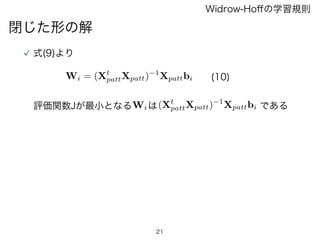

閉じた形の解

Widrow-Hoffの学習規則

ベクトルの定義

Xpatt = (X1,X2, ..., Xn)t

(i = 1, 2, .., c)bi = (bi1, bi2, ..., bin)t

(7)

ベクトルの定義により式(2)・(3)を書き換えると

J(W1, W2, ..., Wc) =

1

2

cX

i=1

kXpattWi bik2

勾配ベクトルは…

@J

@Wi

= Xt

patt(XpattWi bi) = 0 (i = 1, 2, .., c)

(8)

(9)

パターン行列

- 21.

- 22.

22

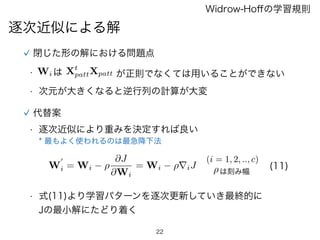

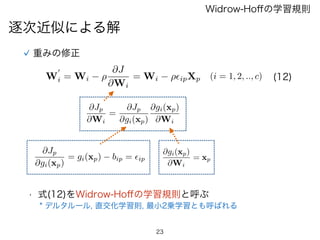

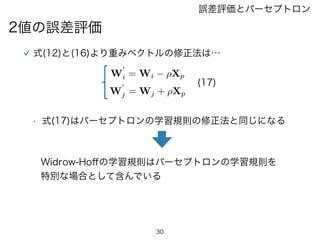

逐次近似による解

Widrow-Hoffの学習規則

閉じた形の解における問題点

• Wi はXt

pattXpatt が正則でなくては用いることができない

• 次元が大きくなると逆行列の計算が大変

代替案

• 逐次近似により重みを決定すれば良い

* 最もよく使われるのは最急降下法

W

0

i = Wi ⇢

@J

@Wi

= Wi ⇢riJ

(i = 1, 2, .., c)

(11)

• 式(11)より学習パターンを逐次更新していき最終的に

Jの最小解にたどり着く

⇢は刻み幅

- 23.

- 24.

- 25.

- 26.

- 27.

- 28.

- 29.

- 30.

- 31.

- 32.

- 33.

- 34.

- 35.

35

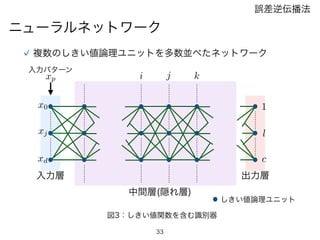

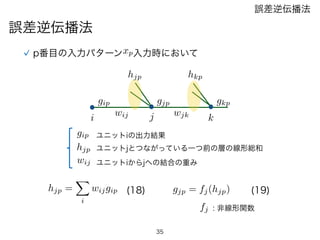

ji k

xp

gip

hjp hkp

gjpgkp

wij

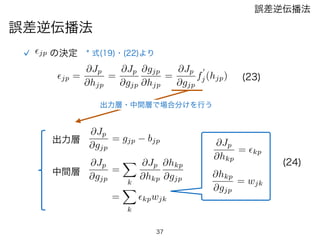

誤差逆伝播法

誤差逆伝播法

wjk

p番目の入力パターン 入力時において

ユニットiの出力結果gip

ユニットjとつながっている一つ前の層の線形総和

ユニットiからjへの結合の重み

hjp

wij

hjp =

X

i

wijgip gjp = fj(hjp)(18) (19)

fj : 非線形関数

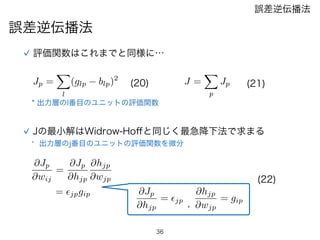

- 36.

- 37.

- 38.

- 39.

39

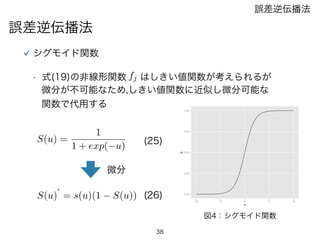

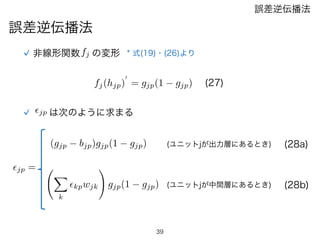

誤差逆伝播法

誤差逆伝播法

非線形関数fj の変形 *式(19)・(26)より

fj(hjp)

0

= gjp(1 gjp) (27)

✏jp は次のように求まる

X

k

✏kpwjk

!

gjp(1 gjp)

(gjp bjp)gjp(1 gjp)

✏jp =

(ユニットjが出力層にあるとき)

(ユニットjが中間層にあるとき)

(28a)

(28b)

- 40.