Il documento esplora il problema della profilazione e della soggezione dell'azione amministrativa all'intelligenza artificiale, con un focus su come queste pratiche possono influenzare la tutela dei dati personali. Viene trattata l'evoluzione dei sistemi di profilazione, collegando esempi come il 'social credit system' cinese con la normativa europea GDPR, evidenziando i diritti degli interessati e i rimedi contro l'automazione decisionale. Le conclusioni mettono in guardia sui rischi di distorsione e sulle implicazioni etiche che le decisioni automatizzate possono avere sulle fasce vulnerabili della popolazione.

![7

(3) Il riferimento alla profilazione nell’azione amministrativa

tradizionale

Dalle origini ad oggi (breve fenomenologia)

Stato moderno = machina machinarum

-> CARL SCHMITT, "Der Staat Als Mechanismus Bei Hobbes Und Descartes.” Archiv für Rechts- und Sozialphilosophie 30 (1936/37), 4, 158.

-> NATALINO IRTI, Nichilismo giuridico, Roma-Bari, GLF editori Laterza (Sagittari Laterza; 144), 2004, p. 43.

Società contemporanea = megamacchina

-> Cfr. SERGE LATOUCHE, La mégamachine. Raison technoscientifique, raison économique et mythe du progrès. Essais à la mémoire de

Jacques Ellul, tr. it. di Alfredo Salsano, La megamacchina. Ragione tecnoscientifica, ragione economica e mito del progresso. Saggi in

memoria di Jacques Ellul, Torino, Bollati Boringhieri (Temi; 48), 1995 (1995).

«Non si potrebbe dunque più raffigurare lo Stato secondo l’immagine

tradizionale di un organismo vivente (…) esso è oggi inteso come un sistema

di relazioni, che possono essere programmate diversamente sulla base di un

sistema di informazioni e di decisioni, come avviene nei sistemi di

automazione informatica»

-> VITTORIO FROSINI, Riflessi sociali dell’informazione, in Aa. Vv., Studi in onore di M.S. Giannini, vol. I, 351, Milano: Giuffrè, 1988 comparso in

traduzione inglese come The social implications of the computer revolution, in «Informatica e diritto» (1987), 3, 7, poi raccolto in Id. Informatica,

diritto e società, cit., 321].](https://image.slidesharecdn.com/20181012-smartcitiesveneziacopia-181016092551/75/20181012-Intelligenza-artificiale-e-soggezione-all-azione-amministrativa-il-problema-della-tutela-dei-dati-personali-tra-profilazione-e-processi-decisionali-automatizzati-7-2048.jpg)

![10

(4) GDPR, profilazione e decisioni automatizzate

Cenni alla nuova disciplina europea

Lo stato attuale della «profilazione» (propriamente intesa)

(2) Ambito assistenziale: «centri per l’impiego» art. 19, D. Lgs. 14 settembre 2015,

n. 150

[…]

5. Sulla base delle informazioni fornite in sede di registrazione, gli utenti dei

servizi per l'impiego vengono assegnati ad una classe di profilazione, allo

scopo di valutarne il livello di occupabilita', secondo una procedura automatizzata

di elaborazione dei dati in linea con i migliori standard internazionali.

[…]](https://image.slidesharecdn.com/20181012-smartcitiesveneziacopia-181016092551/75/20181012-Intelligenza-artificiale-e-soggezione-all-azione-amministrativa-il-problema-della-tutela-dei-dati-personali-tra-profilazione-e-processi-decisionali-automatizzati-10-2048.jpg)

![11

(4) GDPR, profilazione e decisioni automatizzate

Cenni alla nuova disciplina europea

Lo stato attuale della «profilazione» (propriamente intesa)

(3) Ambito sanitario: divieto

DELIBERAZIONE DEL GARANTE PER LA PROTEZIONE DEI DATI PERSONALI 5 maggio 2011, n.

182 (in Gazz. Uff., 25 maggio 2011, n. 120). - Linee guida in tema di trattamento di dati per lo

svolgimento di indagini di customer satisfaction in ambito sanitario. (Deliberazione n. 182 ).

[…] Infine, il trattamento di dati personali, nell’ambito di indagini di gradimento, deve essere finalizzato

esclusivamente al monitoraggio e alla valutazione della qualità percepita dei servizi sanitari. In

particolare, è vietato utilizzare tali dati per perseguire finalità di profilazione degli utenti, anche al

fine di invio di materiale promozionale relativo a prodotti o servizi correlati a quelli erogati (art. 11,

comma 1, lett. b) del Codice; cfr. anche provv. del 7 dicembre 2006, doc. web n. 1379101).](https://image.slidesharecdn.com/20181012-smartcitiesveneziacopia-181016092551/75/20181012-Intelligenza-artificiale-e-soggezione-all-azione-amministrativa-il-problema-della-tutela-dei-dati-personali-tra-profilazione-e-processi-decisionali-automatizzati-11-2048.jpg)

![17

(4) GDPR, profilazione e decisioni automatizzate

Cenni alla nuova disciplina europea

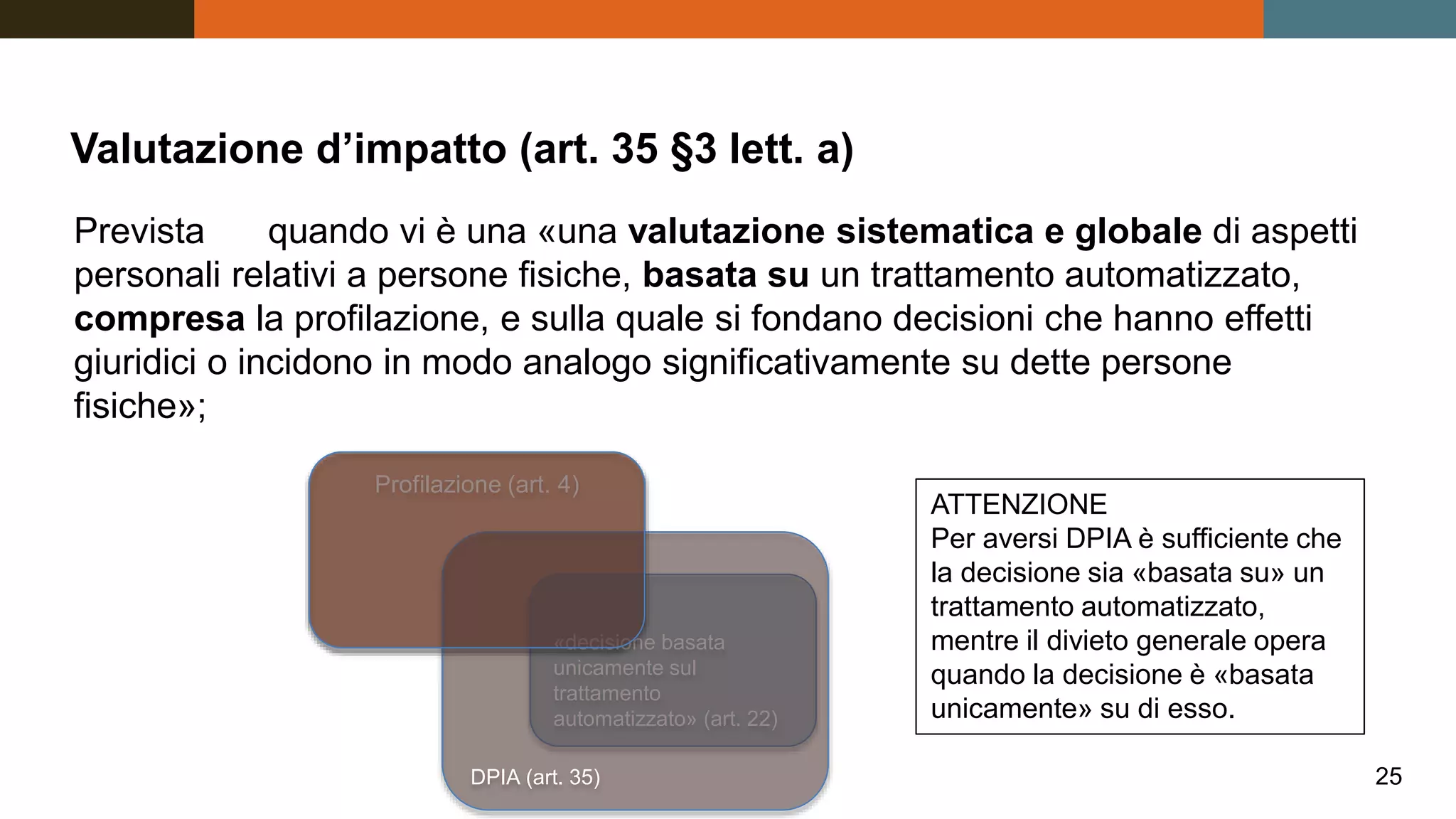

Art. 22 GDPR Processo decisionale automatizzato

relativo alle persone fisiche, compresa la profilazione

1. L'interessato ha il diritto di non essere sottoposto a

una decisione basata unicamente sul trattamento

automatizzato, compresa la profilazione, che produca

effetti giuridici che lo riguardano o che incida in modo

analogo significativamente sulla sua persona.

2. Il paragrafo 1 non si applica nel caso in cui la decisione:

a) sia necessaria per la conclusione o l'esecuzione di un

contratto tra l'interessato e un titolare del trattamento;

b) sia autorizzata dal diritto dell'Unione o dello Stato

membro cui è soggetto il titolare del trattamento, che precisa

altresì misure adeguate a tutela dei diritti, delle libertà e dei

legittimi interessi dell'interessato;

c) si basi sul consenso esplicito dell'interessato.[…]

Art. 14 Preleggi (Codice

Civile) Dell'applicazione

della legge in generale

Le leggi penali e quelle che

fanno eccezione a regole

generali o ad altre leggi non

si applicano oltre i casi e i

tempi in esse considerati

Art. 22 §.1 GDPR

DIVIETO

GENERALE

Art. 22 §. 2 GDPR

ECCEZIONI](https://image.slidesharecdn.com/20181012-smartcitiesveneziacopia-181016092551/75/20181012-Intelligenza-artificiale-e-soggezione-all-azione-amministrativa-il-problema-della-tutela-dei-dati-personali-tra-profilazione-e-processi-decisionali-automatizzati-17-2048.jpg)

![23

Grazie per l’attenzione

federico.costantini[@]uniud.it](https://image.slidesharecdn.com/20181012-smartcitiesveneziacopia-181016092551/75/20181012-Intelligenza-artificiale-e-soggezione-all-azione-amministrativa-il-problema-della-tutela-dei-dati-personali-tra-profilazione-e-processi-decisionali-automatizzati-23-2048.jpg)