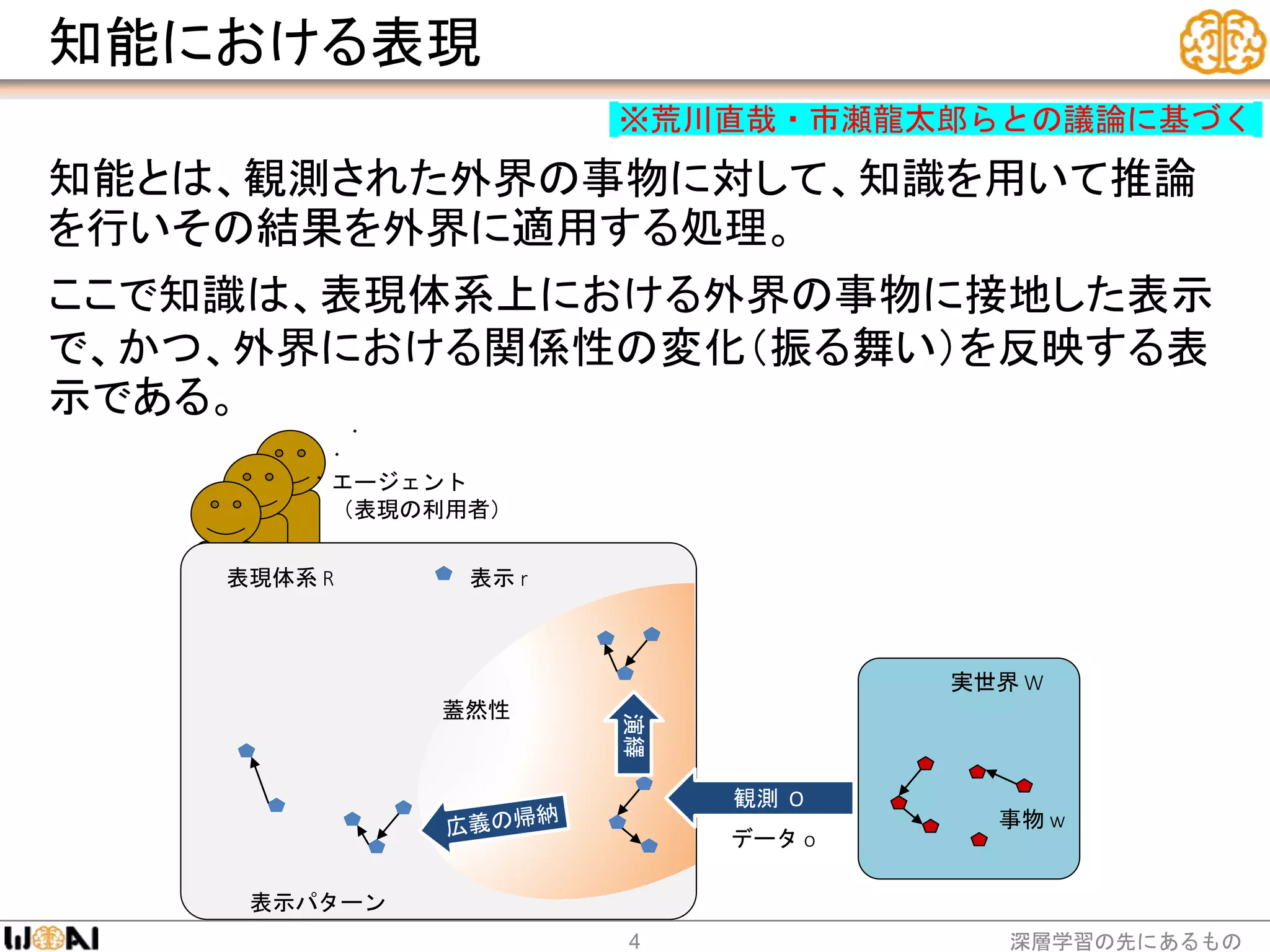

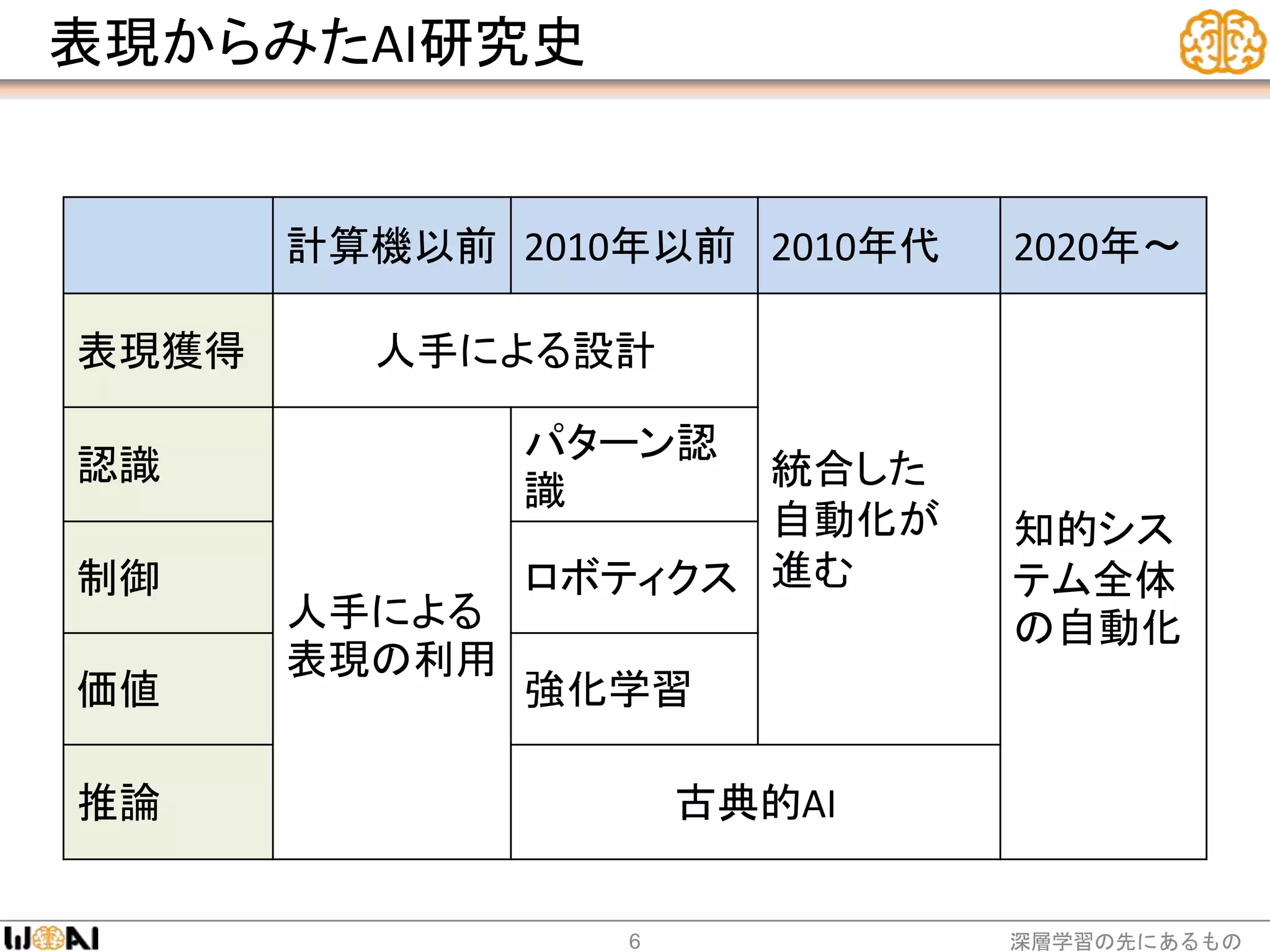

Representations are base of intelligent process in AI and is grounded to the outside world. In old days, they are designed by hand, but they are learned from data in today.

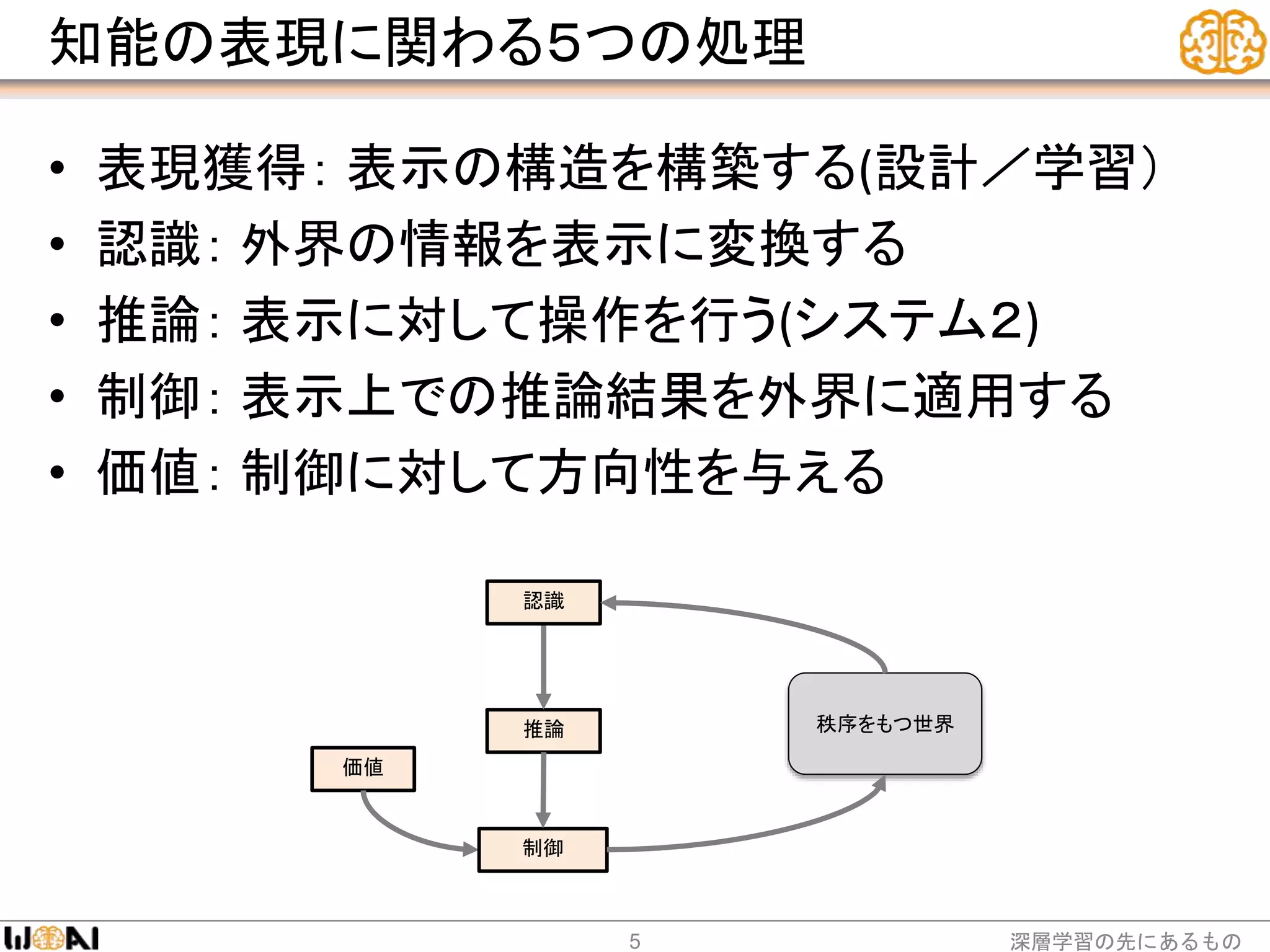

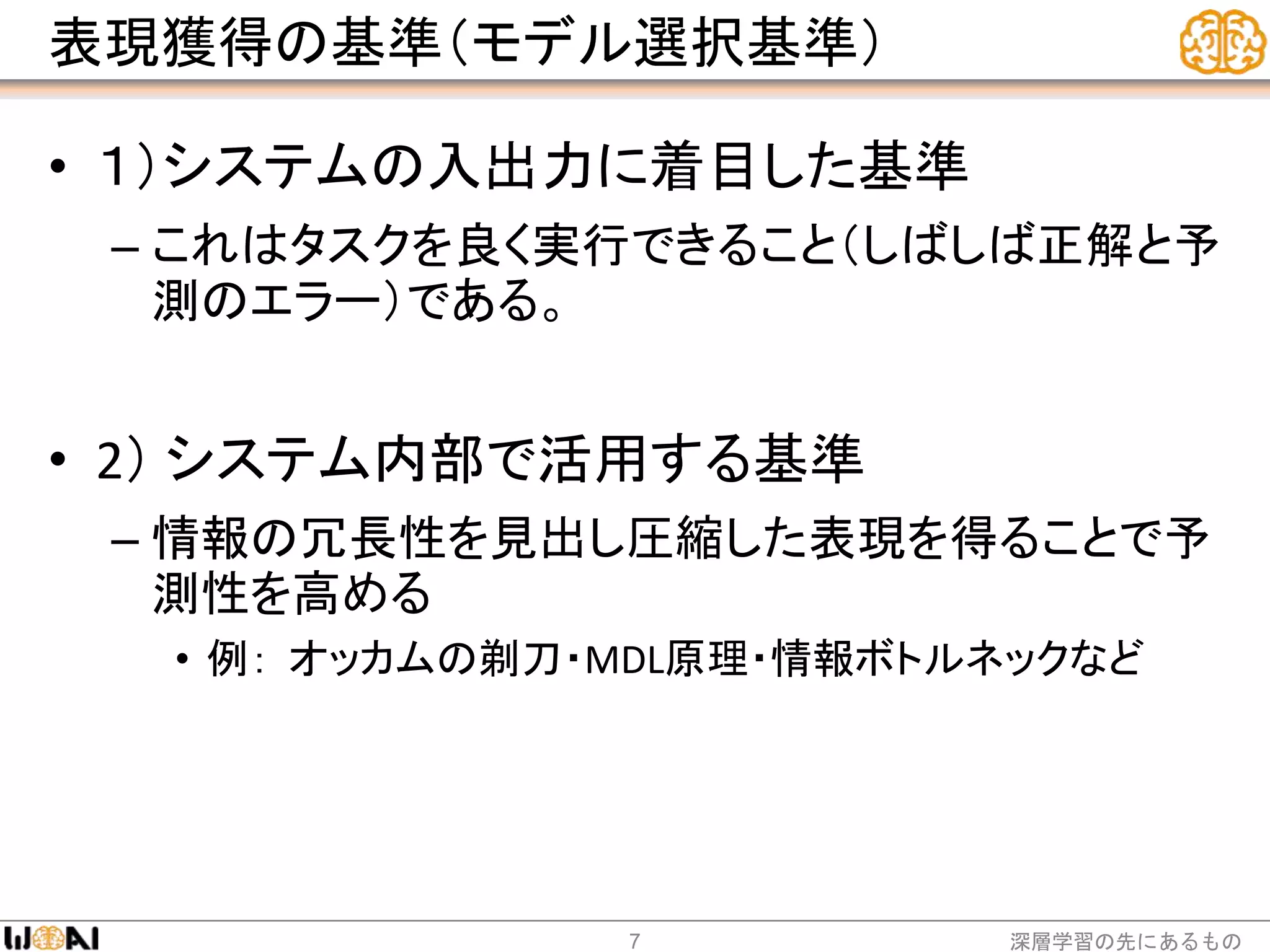

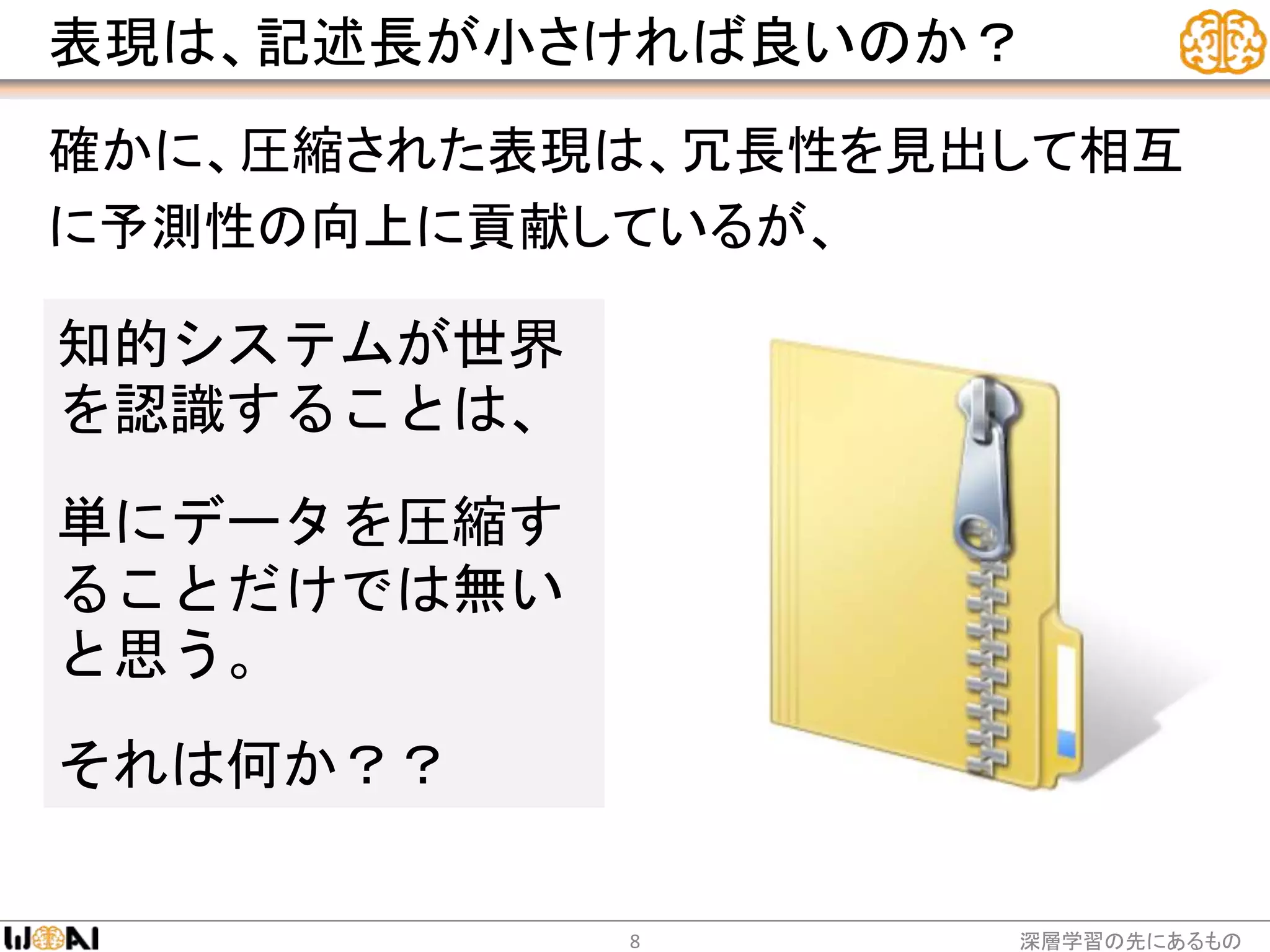

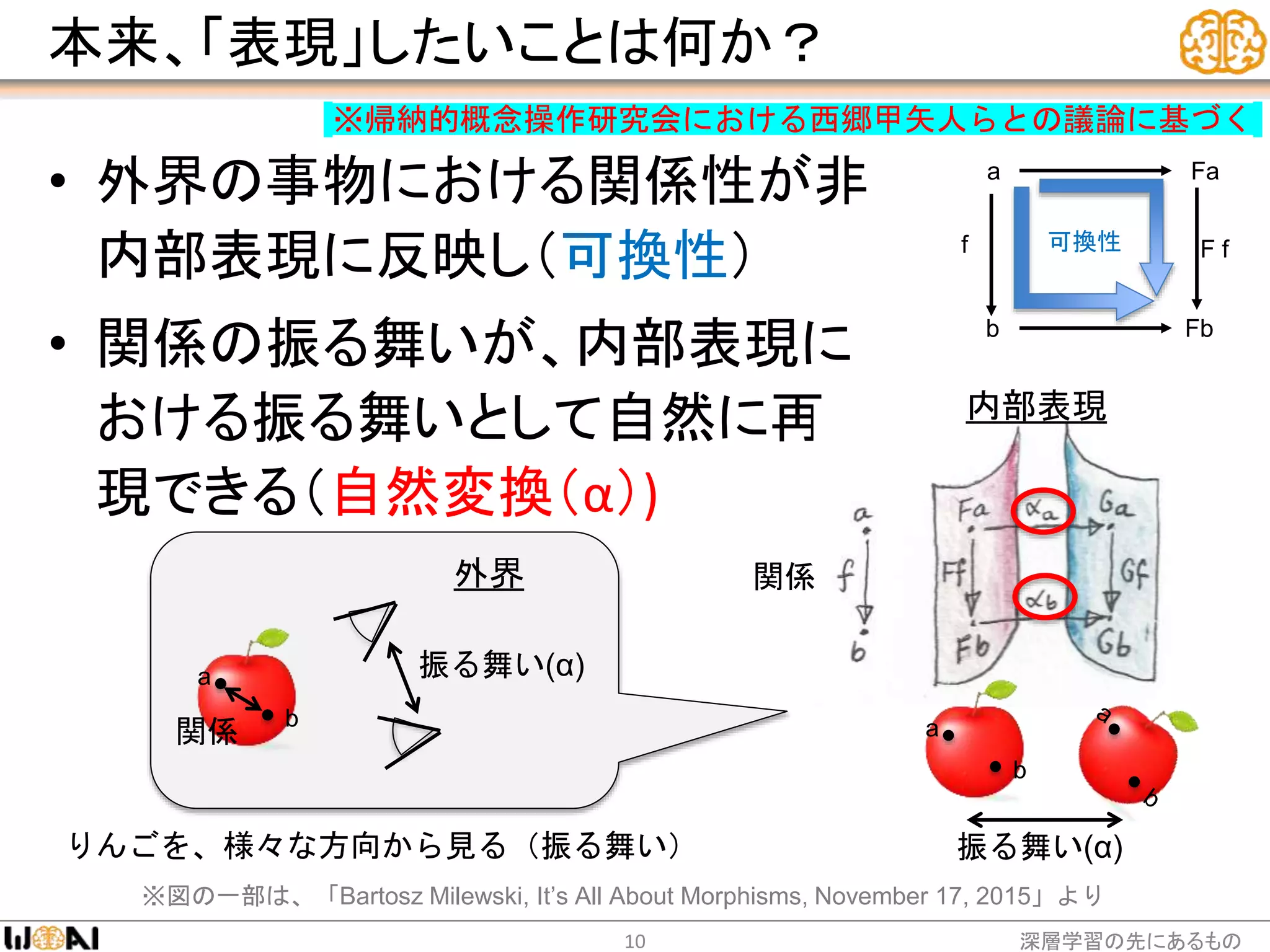

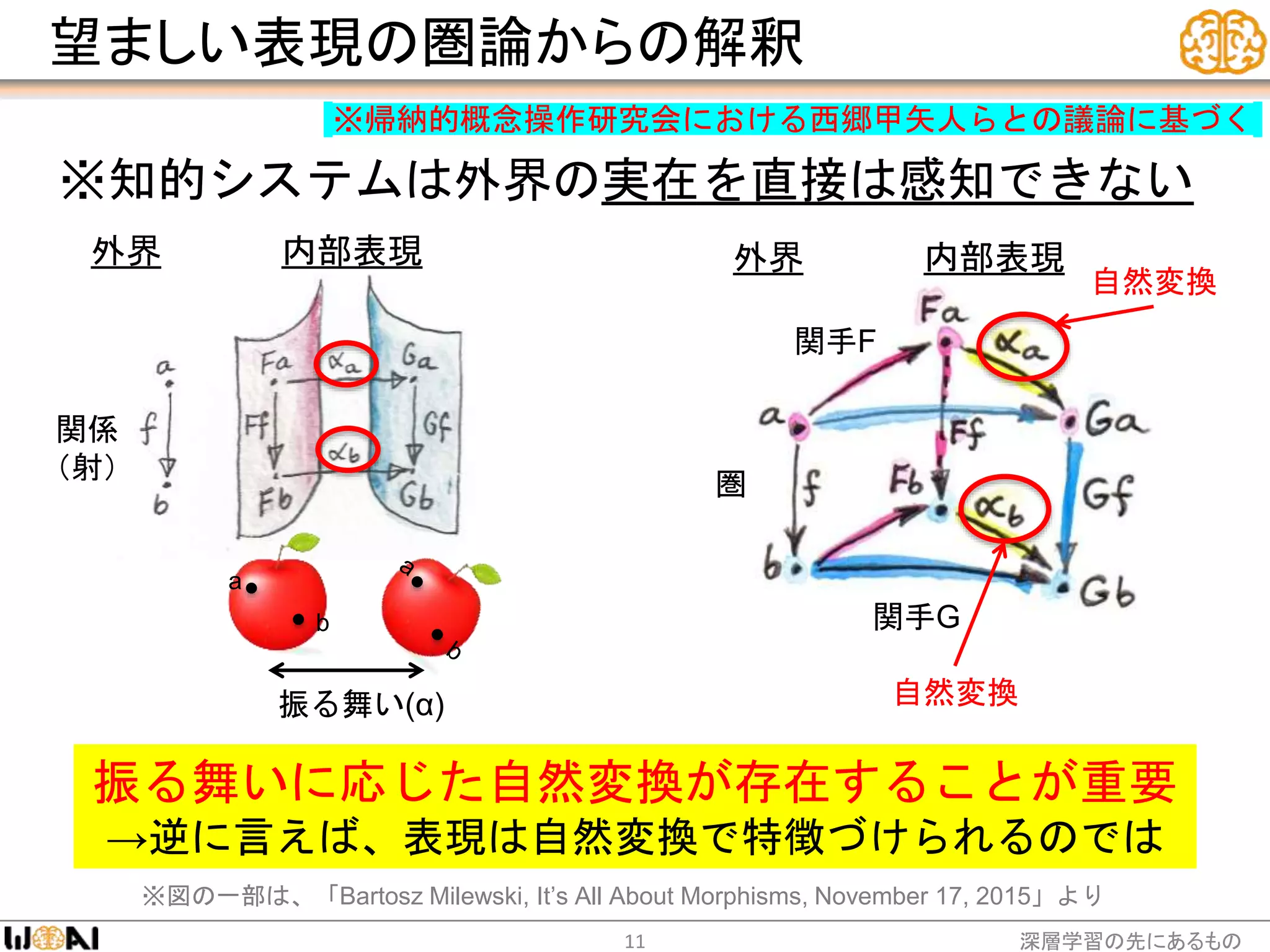

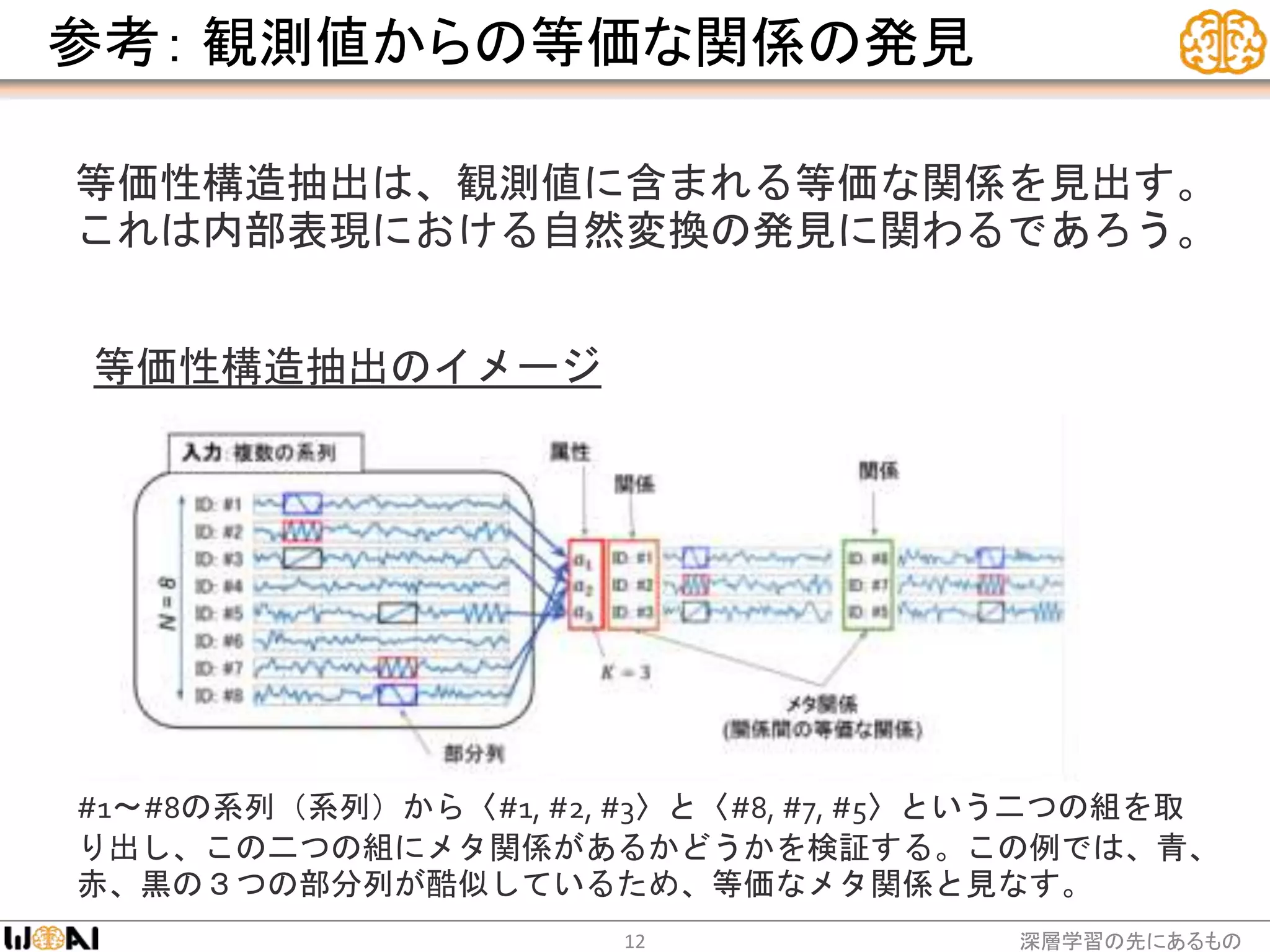

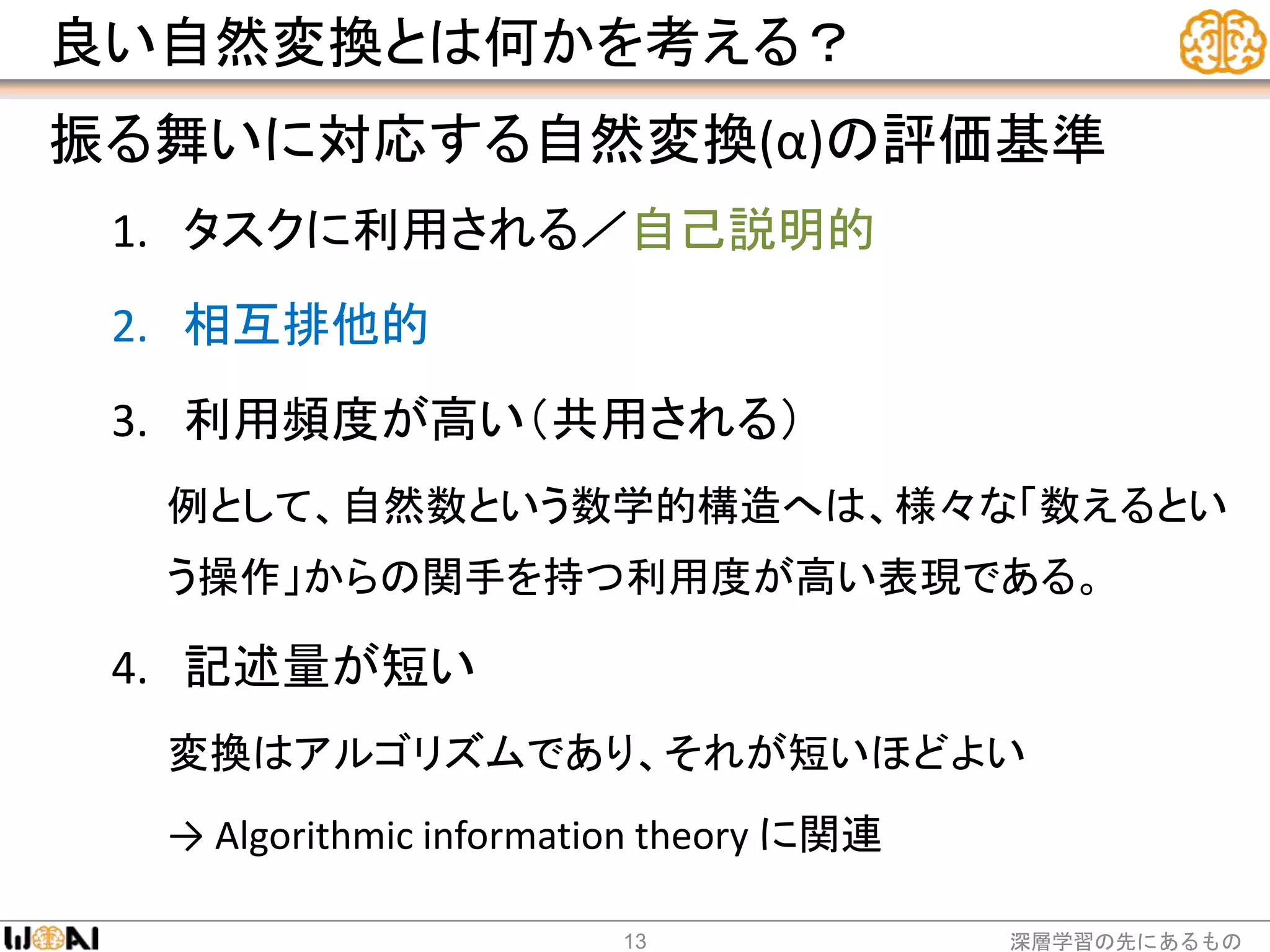

So, we need the new technical base for handling learned representations. We need to understand and to formulate them. We need to study construction / learning method and utilization method. I started to call this field Representation Engineering.

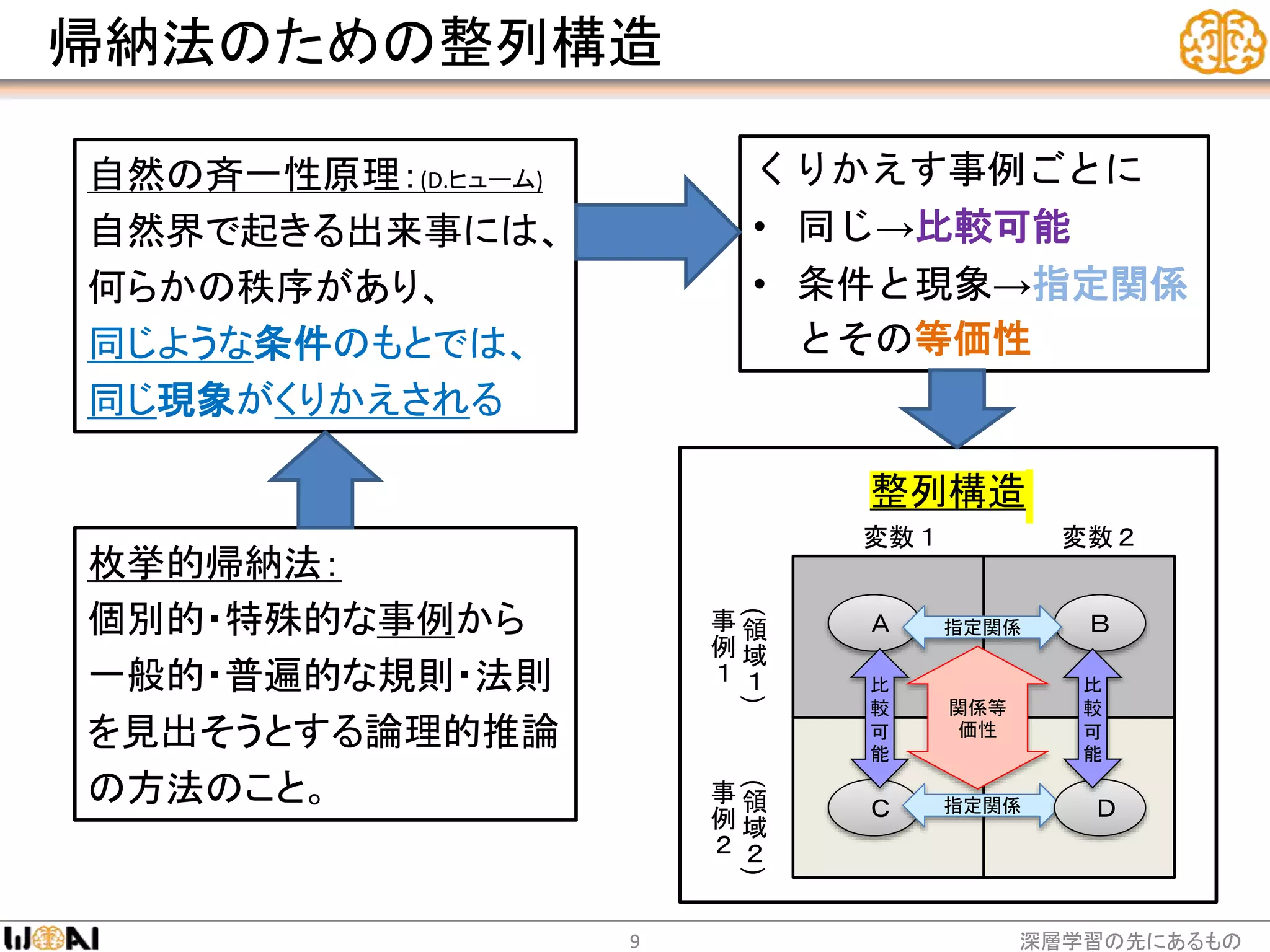

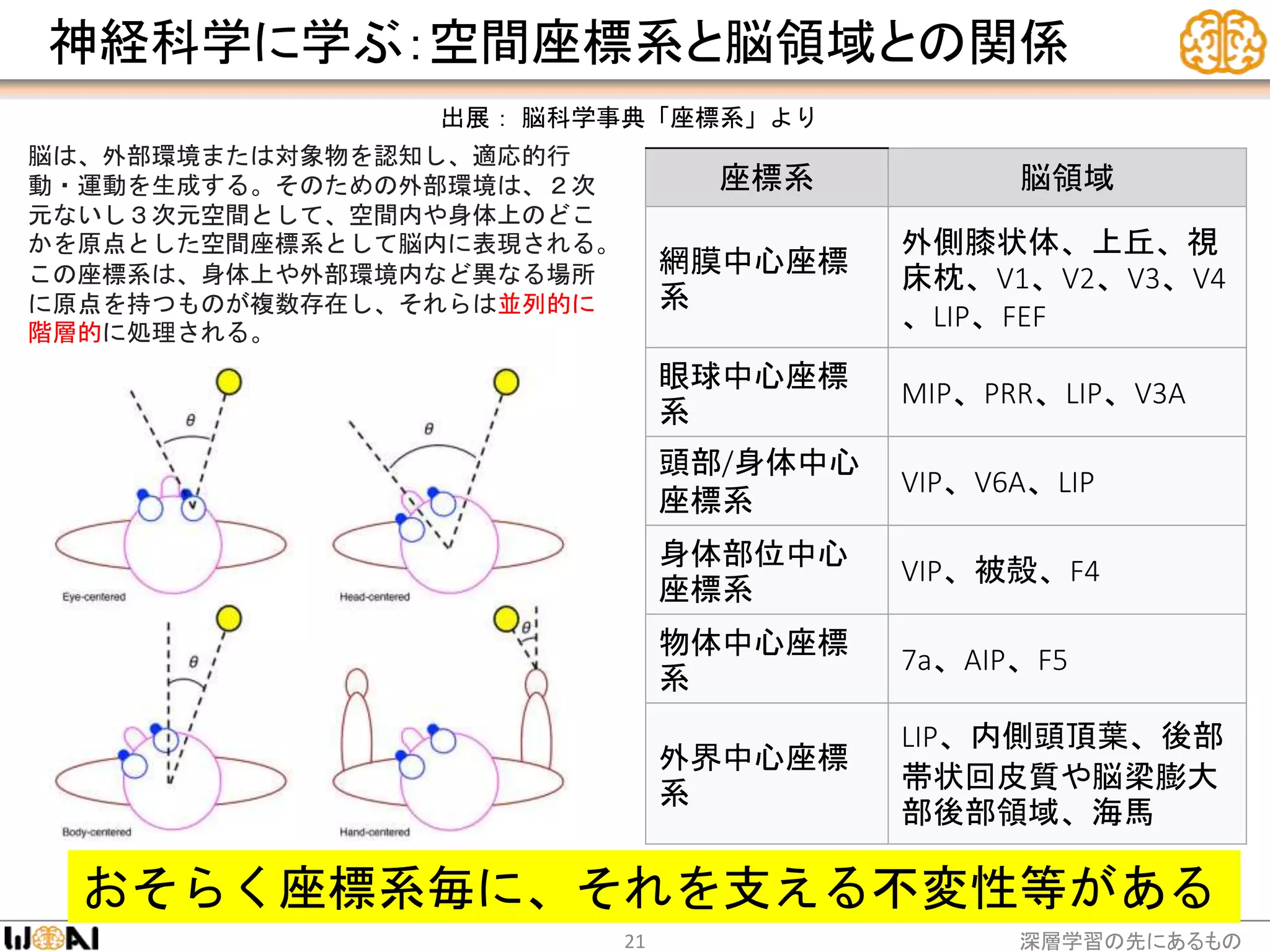

Theoretical foundation of this field will be such as categorical theory, algorithm information theory, ontology. Research will be advance by referring cognitive science / neuroscience etc.