2015年1月28にCTCソリューションセンタで開催された、PoC/HVDC WG Engineering Workshop での発表資料になります。

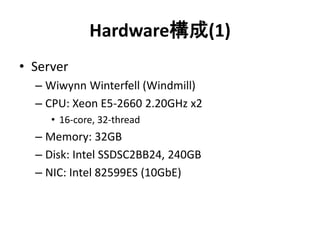

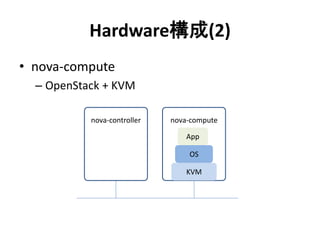

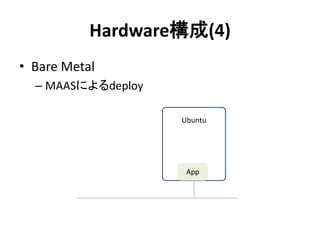

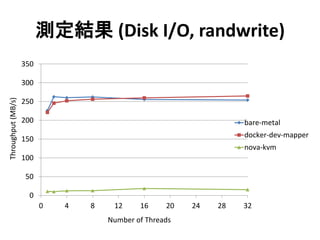

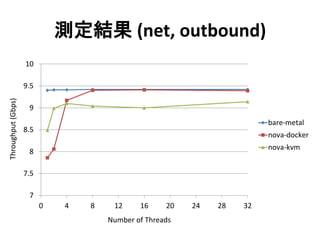

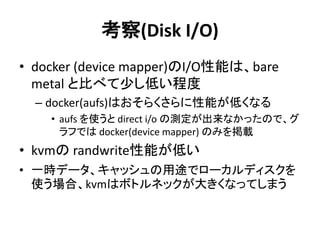

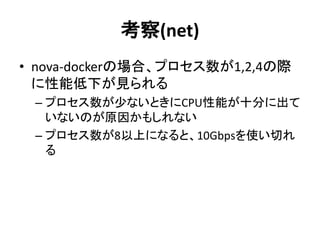

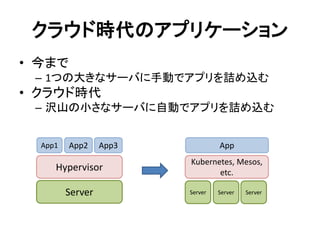

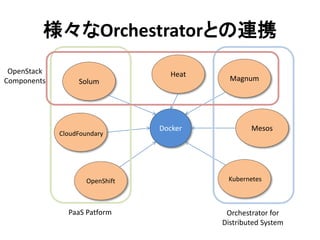

お題目としては、OCPサーバを用いてPrivate CloudやPublic Cloudを構築するために使えるBare Metal Provisioning Toolとして MAAS のご説明と、OCPサーバを用いたOpenStack + Docker 環境で benchmark を行ない性能・消費電力の観点でどのようにメリットを引き出せるのかを考察した結果についてご紹介しました。