機械学習の勉強会の資料

MCMCについて

中途半端なので上げ直すかも

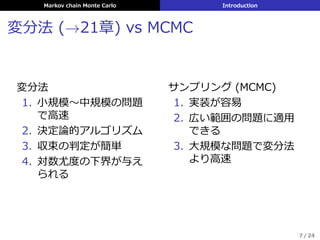

1. イントロダクション

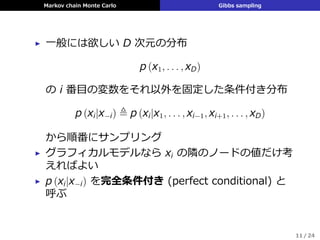

2. ギブスサンプリング

3. メトロポリス・ヘイスティングス法

(ここから下は作ってません)

4. MCMCの収束速度と精度

5. 補助変数法

6. アニーリング (やきなまし法)

7. 周辺尤度の近似

教科書: Murphy, Kevin P. "Machine learning: a probabilistic perspective (adaptive computation and machine learning series)." Mit Press. ISBN 621485037 (2012): 15.

![Markov chain Monte Carlo Gibbs sampling

例: イジングモデル

イジング模型の完全条件付き分布

p

(

xt = +1|x−t, θ

)

=

∏

s∈nbr(t) ψst (xt = +1, xs)

∏

s∈nbr(t) ψst (xt = +1, xs) +

∏

s∈nbr(t) ψst (xt = −1, xs)

=

exp

[

J

∑

s∈nbr(t) xs

]

exp

[

J

∑

s∈nbr(t) xs

]

+ exp

[

−J

∑

s∈nbr(t) xs

]

=

exp [Jηt]

exp [Jηt] + exp [−Jηt]

= sigm (2Jηt)

▶ ψ (xs, xt) = exp (Jxsst): edge potential

▶ ηt ≜

∑

s∈nbr(t) xs =

xt

(

#同じ向きの隣接点 − #逆向きの隣接点

)

13 / 24](https://image.slidesharecdn.com/mlappch24-151117125218-lva1-app6892/85/MLaPP-24-MCMC-13-320.jpg)

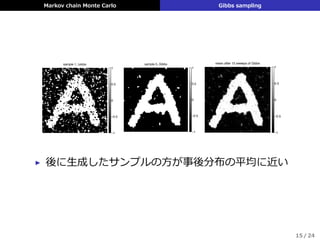

![Markov chain Monte Carlo Gibbs sampling

2次元イジング模型による画像復元

p (xt = +1|x−t, y, θ) =

exp [Jηt] ψt (+1)

exp [Jηt] ψt (+1) + exp [−Jηt] ψt (−1)

= sigm

(

2J − log

ψt (+1)

ψt (−1)

)

▶ y: 観測された画像

▶ 観測にガウシアンノイズ

ψt (xt) = N

(

yt|xt, σ2

)

が含まれる

14 / 24](https://image.slidesharecdn.com/mlappch24-151117125218-lva1-app6892/85/MLaPP-24-MCMC-14-320.jpg)