Recommended

PDF

PDF

PDF

Semantic_Matching_AAAI16_論文紹介

PDF

KEY

LS for Reinforcement Learning

PDF

PDF

(DL hacks輪読) Variational Dropout and the Local Reparameterization Trick

PDF

PDF

AGenT Zero: Zero-shot Automatic Multiple-Choice Question Generation for Skill...

PPTX

PDF

PDF

PDF

子どもの言語獲得のモデル化とNN Language ModelsNN

PDF

PDF

TensorFlow math ja 05 word2vec

PDF

Seeing Unseens with Machine Learning --

見えていないものを見出す機械学習

PPTX

Variational Template Machine for Data-to-Text Generation

PDF

Deep learning勉強会20121214ochi

PPTX

[DL輪読会]Experience Grounds Language

PDF

PPTX

Approximate Scalable Bounded Space Sketch for Large Data NLP

PDF

PDF

CluBERT: A Cluster-Based Approach for Learning Sense Distributions in Multipl...

PPTX

[DL輪読会]It's not just size that maters small language models are also few sho...

PDF

PPTX

dont_count_predict_in_acl2014

PPTX

Learning Cooperative Visual Dialog with Deep Reinforcement Learning(関東CV勉強会 I...

PDF

深層生成モデルと世界モデル,�深層生成モデルライブラリPixyzについて

PPTX

Reading Wikipedia to Answer Open-Domain Questions (ACL2017) and more...

PPTX

KB + Text => Great KB な論文を多読してみた

More Related Content

PDF

PDF

PDF

Semantic_Matching_AAAI16_論文紹介

PDF

KEY

LS for Reinforcement Learning

PDF

PDF

(DL hacks輪読) Variational Dropout and the Local Reparameterization Trick

PDF

Similar to Language Models as Representations for Weakly-Supervised NLP Tasks (CoNLL2011)

PDF

AGenT Zero: Zero-shot Automatic Multiple-Choice Question Generation for Skill...

PPTX

PDF

PDF

PDF

子どもの言語獲得のモデル化とNN Language ModelsNN

PDF

PDF

TensorFlow math ja 05 word2vec

PDF

Seeing Unseens with Machine Learning --

見えていないものを見出す機械学習

PPTX

Variational Template Machine for Data-to-Text Generation

PDF

Deep learning勉強会20121214ochi

PPTX

[DL輪読会]Experience Grounds Language

PDF

PPTX

Approximate Scalable Bounded Space Sketch for Large Data NLP

PDF

PDF

CluBERT: A Cluster-Based Approach for Learning Sense Distributions in Multipl...

PPTX

[DL輪読会]It's not just size that maters small language models are also few sho...

PDF

PPTX

dont_count_predict_in_acl2014

PPTX

Learning Cooperative Visual Dialog with Deep Reinforcement Learning(関東CV勉強会 I...

PDF

深層生成モデルと世界モデル,�深層生成モデルライブラリPixyzについて

More from Koji Matsuda

PPTX

Reading Wikipedia to Answer Open-Domain Questions (ACL2017) and more...

PPTX

KB + Text => Great KB な論文を多読してみた

PPTX

Large-Scale Information Extraction from Textual Definitions �through Deep Syn...

PPTX

PDF

「今日から使い切る」�ための GNU Parallel�による並列処理入門

PDF

PPTX

Entity linking meets Word Sense Disambiguation: a unified approach(TACL 2014)の紹介

PDF

いまさら聞けない “モデル” の話 @DSIRNLP#5

PDF

Practical recommendations for gradient-based training of deep architectures

PDF

Align, Disambiguate and Walk : A Unified Approach forMeasuring Semantic Simil...

PDF

Joint Modeling of a Matrix with Associated Text via Latent Binary Features

PPTX

Vanishing Component Analysis

PDF

A Machine Learning Framework for Programming by Example

PDF

Information-Theoretic Metric Learning

PDF

Unified Expectation Maximization

PDF

PDF

PDF

Word Sense Induction & Disambiguaon Using Hierarchical Random Graphs (EMNLP2010)

Language Models as Representations for Weakly-Supervised NLP Tasks (CoNLL2011) 1. Language

Models

as

Representa1ons

for

Weakly-‐Supervised

NLP

Tasks

Fei

Huang,

Alexander

Yates,

Arun

Ahuja

and

Doug

Downey

CoNLL2011

紹介者

:

松田

2011/12/13

1

2. Introduc1on

• NLPのタスクの多くは分類問題に帰着できる

• 分類に用いる素性ベクトルの作り方に性能が大

きく依存する

– 人手で注意深くつくられた素性が強い

• しかし、(特にDomain

Adapta1onのような状況に

おいて)次のような問題が性能を制限している

–

スパース性

• 訓練データに出てきていない語に対応する能力

– 多義性

• ドメインに依存して語義の分布がかわる(POSの分布もかわ

る)ような語に対応する能力

2011/12/13

2

3. Introduc1on

• この問題に対処するために、素性表現に着目

– unseen

exampleに対する汎化性能を上げるような素性表現

– distribu1onal

hypothesis

:

意味の似た語はコンテキストも似て

いる

• 研究のゴール

– コンテキストを考慮した確率的言語モデルに基づく素性表現を

開発

– 素性表現:語(token

/

type)から実数値ベクトルへのマッピング

• 言語モデルから生成

→

コンテキストを考慮したベクトルを生成できる

• コンテキストから生成

→

多義性やスパース性に対して頑健になる

2011/12/13

3

4. Previous

Work

• 素性表現についての研究は主に四つに分類される

1. 文書レベルでの共起指標に基づくVector

Space

Model

2. Vector

Space

Modelに対する次元削減

3. 分布類似度に基づくクラスタリング

4. 言語モデルに基づく素性表現

• PL-‐MRFという新しいrepresenta1onを提案し、 POS

Taggerにお

いてstate-‐of-‐the-‐artな性能を達成したところがcontribu1on

• Domain

Adapta1onの研究としては

– targetドメインのラベルつきデータがある設定

– targetドメインのラベルつきデータが無い設定

– 本研究は後者

2011/12/13

4

5. Representa1ons

• A

representa1on

is

a

set

of

features

that

describe

instances

for

a

classifier

• 形式的な定義

– 事例集合から素性空間への写像を行う関数

– R(x)

:

Yという素性空間(

such

as

Rd

)

の中の一つの

ベクトル

2011/12/13

5

6. Representa1ons(具体例)

伝統的な素性表現

trigram言語モデル

グラフィカルモデル

クラスタリングに

基づく表現

提案手法

*-‐TOKEN-‐R

:

ある語の”特定の”出現事例に対する素性表現(Viterbi等でデコードした値)

*-‐TYPE-‐R

:

語それ自体に対する素性表現(コーパス中で一定)

2011/12/13

6

7. フレームワーク

解くtaskの

labeled

data

素性

2.

素性ベクトル作成

ベクトル

1.学習

大量の

unlabeled

data

Representa1on

3.

学習

解くtaskの

分類器

2011/12/13

7

8. Unsupervised

HMMs

(本当は有向)

• それぞれの語が

K

状態のうちのいずれかの状態を持つ、というモデル

• EMアルゴリズムによってパラメータ P(xi|yi),

P(yi|yi-‐1) の推定が可能

• Viterbiアルゴリズムによって状態のデコードが可能

• 高村さんの本に書いてあるHMMは

Supervised-‐HMMs

なので注意

2011/12/13

8

9. 10. I-‐HMMの問題点

•

それぞれのHMMが独立に訓練されており、

文の別の側面を(異なるレイヤで)捉えるとい

うモデルになっていない

• それぞれのレイヤーが語の異なる側面をとら

えるようにしたい

– POS,

gender,

number,

格(case),

人称,

テンス,

etc..

• レイヤー間のインタラクションの導入

2011/12/13

10

11. 12. La`ce

Structured

MRF

極大クリークを因子とした対数線形モデルで表現(PRML

8.3に類似例あり)

P(x)

=

パラメータとしては、例えば・・・

となりあった二つのノードに関する遷移パラメタ

観測された語に関するパラメタ

となりあった二つのレイヤに関するパラメタ

ただし、O(2M)個のパラメータがあるのでExactな推論/学習はほぼ不可能

2011/12/13

12

13. Par1al

La`ce

MRF

odd

even

M

odd

いくつかのエッジを削除する。文の前半では(odd

–

even),

文の後半では

(even

–

odd)

の間

(あまり納得できるような正当化はなされていない)

2011/12/13

13

14. Par1al

La`ce

MRF

• エッジを削除することで効率的計算が可能にな

る

– 動的計画法,

メッセージパッシング

– tree-‐width(木幅:グラフがどれだけ木に近いかを表す

指標)が

2

• 木幅が

1

であれば木、低いほど効率的な計算が可能

– O(K4MN)

• K

:

ノードの状態数,

M:レイヤー数,

N

:

文長

• (論文には書いていないが)モデルの柔軟さをで

きるだけ損なわずに木幅を低くして計算しやすく

するためのエッジ削除法なのではないか

2011/12/13

14

15. Contras1ve

Es1ma1on

• (Smith

and

Eisner,

2005)

• 対数線形モデルをUnlabeled

Dataから学習す

る一般的な枠組み

– Contras1ve

Divergence学習,

擬似負例からの学

習

N(x)

:

Neighborhood

func1on(本論文では、隣接する二単語を入れ替えたもの)

2011/12/13

15

16. ?

?

?

?

?

?

p red

leaves

don t

hide

blue

jays

?

?

?

?

?

?

red

leaves

don t

hide

blue

jays

?

?

?

?

?

?

leaves

red

don t

hide

blue

jays

?

?

?

?

?

?

red

don t

leaves

hide

blue

jays

p ?

?

?

?

?

?

red

leaves

hide

don t

blue

jays

?

?

?

?

?

?

red

leaves

don t

blue

hide

jays

?

?

?

?

?

?

red

leaves

don t

hide

jays

blue

2011/12/13

16

Smith

and

Eisner,

ACL2005発表スライドより引用

17. その他学習における工夫

• 目的関数はnon-‐convexなので勾配法で局所

解を求めることになる

• For

tractability:一層づつ順番に訓練する

– 層 i

に「関係する」パラメータを θi,

その他を θ¬i

– まず

θ¬0

をすべてゼロに固定し、

θ0

を最適化

– 収束したら固定して、次の層にとりかかる

– 一層あたり100iter以下で収束するらしい

2011/12/13

17

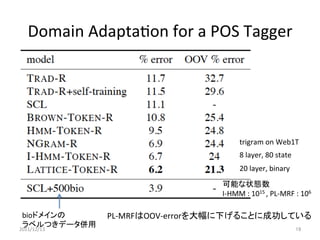

18. Domain

Adapta1on

for

a

POS

Tagger

Newspaper

Domain(WSJ)

=>

Biomedical

Domain(MEDLINE)

へのドメイン適応

Penn

Treebank

Penn

Treebank

+MEDLINE

MEDLINE

71306

sentence

561

sentence

labeled

training

data

unlabeled

training

data

labeled

test

data

for

POS

Tagger

for

train

LMs

2011/12/13

POS

Taggerの学習モデルはCRF

18

19. Domain

Adapta1on

for

a

POS

Tagger

trigram

on

Web1T

8

layer,

80

state

20

layer,

binary

可能な状態数

I-‐HMM

:

1015

,

PL-‐MRF

:

106

bioドメインの

PL-‐MRFはOOV-‐errorを大幅に下げることに成功している

ラベルつきデータ併用

2011/12/13

19

20. Domain

Adapta1on

for

a

POS

Tagger

多義語の判定は

人手で行った。

unlabeledデータ

中に5回以下しか

出現しない語を

sparse語、

50回以上出現

する語を

non-‐sparse語

として調査。

多義語においては、グラフィカルモデルに基づく言語モデルの効果が大きい

おそらくViterbiデコードを行うときにコンテキストを考慮に入れることができるため

スパースな語においてもグラフィカルモデルの効果は(そうでない語と比較して)大きい。

2011/12/13

20

21. Informa1on

Extrac1on

• set-‐expansion

task

– 種語が幾つか与えられた状況で、コーパス中に

出現する同じ意味カテゴリの語を獲得するタスク

– distribu1onal

hypothesisに基づいた手法

• 同じ意味カテゴリに属する語はそのコンテキストにあら

われる語の分布も似ているだろう、という仮定

– 正例の一部だけが与えられているという意味で

“weakly-‐supervised”

である

2011/12/13

21

22. Informa1on

Extrac1on

• 手法

1. コーパス、シードの集合が与えられている

2. それぞれの意味カテゴリCに対して

• すべての候補フレーズP

が、カテゴリCに属する尤もらしさで

降順に並べる

– 各カテゴリに対して、シードとして語を幾つか与えて

その平均値ベクトルをCのprototype

vectorとする

– それぞれのフレーズPに対して、prototype

vectorとの

距離をはかり、近い順にカテゴリCに属すると判定

• 距離

:

KL,

JS疑距離,

cosine,

ユークリッド,

L1の単純平均

– チューニングしても効果はなかったらしい

2011/12/13

22

23. Informa1on

Extrac1on

• 実験データ

– Webから集めた10万文

– Lexアルゴリズム(Downey

et

al.,

2007)を用いて複数

語からなる固有名詞は一語として認識できるように結

合

– Wikipediaの

“listOf”

ページから正解データを得た(16

カテゴリ、432事例)

• 実験設定

– seed事例を5個づつ、という実験をseedをランダムに

変えながら5回

– 評価はAUC

metric.

• Recall-‐Precision

曲線の下側の面積(大きいほど良い)

2011/12/13

23

24. 25. IEで性能が振るわない理由

• 分類する「対象」の違いが疑わしい

– POSタギング:

“token”(インスタンス)の分類

– IE

:

“type”(語そのもの)

の分類

• Representa1onのモデル

– PL-‐MRFはHMMに比べてtransi1onのパラメータに依存が

大きいのではないか

– 訓練に用いているContras1ve

Es1ma1onもtransi1onパラ

メータに対する依存を強くする効果がありそうだ

• 語が与えられた状態でのモデルの事後分布

– エントロピー :

PL-‐MRF

:

9.95

bits,

HMM

:

2.74bits

– PL-‐MRFは語が決まってもモデルの曖昧性が高い

• 結論

:

よく分からないので更なる実験が必要

2011/12/13

25

26. Conclusion

• まとめ

– 多義性やスパースな状況に対応できるような素性表現

– 本論文で提案したグラフィカルモデルに基づくrepresenta1onは

POS

TaggerのDomain

Adapta1onで

state-‐of-‐the-‐art.

– IEにおける多義性の扱い等は今後の課題

• 以下、個人的感想

– (PL-‐)MRFで層ごとに”異なる側面”が学習されるメカニズムが理

解できなかった

– そもそも

IE

は問題設定としてどうなのだ

• というかこれは

IE

なのだろうか,

多義性を考慮するtype分類とは

– Token-‐based

tasks(POS

Tagger)と

Type-‐based

tasks(IE)で異なっ

た素性表現が有効であるというのは割と納得できる

– Contras1ve

Es1ma1onについては、本論文ではさらっとしか触

れていないが、応用範囲はかなり広いようだ

2011/12/13

26